步骤 #3:数据集创建(从互联网下载)

如果您希望在 Base Command 中使用的数据集在本地系统中尚不可用,或者从互联网上的其他位置下载比从您自己的个人工作站传输更快,那么在作业中从互联网下载数据集,将数据保存到结果目录,并将结果目录转换为数据集是一个很好的选择。

首先,在已通过身份验证可以使用目标环境的系统上,运行此批处理作业 - 它使用此特定 ACE 中最小的可用实例来 wget 目标数据(在本例中为 linux 内核源代码),解压数据,并删除源 tar.xz 文件。请记住,数据集是只读的 - 因此,以您希望它在未来使用的确切形式获取数据,并删除您不想保留的任何数据非常重要。

$ ngc batch run --name "download-the-linux-kernel-to-result-dir" --preempt RUNONCE --min-timeslice 1s --total-runtime 0s --instance dgxa100.80g.1.norm --commandline "cd /results; wget https://cdn.kernel.org/pub/linux/kernel/v5.x/linux-5.17.3.tar.xz; tar -xvf linux-5.17.3.tar.xz; rm -rf linux-5.17.3.tar.xz" --result /results --image "nvidia/pytorch:22.04-py3"

--------------------------------------------------

Job Information

Id: 2818455

Name: download-the-linux-kernel-to-result-dir

Number of Replicas: 1

Job Type: BATCH

Submitted By: Joseph Handzik

Job Container Information

Docker Image URL: nvidia/pytorch:22.04-py3

Job Commands

Command: cd /results; wget https://cdn.kernel.org/pub/linux/kernel/v5.x/linux-5.17.3.tar.xz; tar -xvf linux-5.17.3.tar.xz; rm -rf linux-5.17.3.tar.xz

Dockerfile Image Entrypoint: False

Datasets, Workspaces and Results

Result Mount Point: /results

Job Resources

Instance Type: dgxa100.80g.1.norm

Instance Details: 1 GPU, 30 CPU, 244 GB System Memory

ACE: nv-launchpad-bc-sjc-ace

Team: nvbc-tme

Job Status

Created at: 2022-04-18 19:13:54 UTC

Status: STARTING

Status Type: OK

Preempt Class: RUNONCE

Minimum Timeslice: 01S

--------------------------------------------------

要从命令行检查作业的状态,请运行 ngc batch info <job id> - 在上面输出的 作业信息 部分下,Id 值为 2818455

$ ngc batch info 2818455

--------------------------------------------------

Job Information

Id: 2818455

Name: download-the-linux-kernel-to-result-dir

Number of Replicas: 1

Job Type: BATCH

Submitted By: Joseph Handzik

Job Container Information

Docker Image URL: nvidia/pytorch:22.04-py3

Container name: 0367882ff645d349a97f9fcf56e33b25bbf473907878d2797e575a0560fc7665

Job Commands

Command: cd /results; wget https://cdn.kernel.org/pub/linux/kernel/v5.x/linux-5.17.3.tar.xz; tar -xvf linux-5.17.3.tar.xz; rm -rf linux-5.17.3.tar.xz

Dockerfile Image Entrypoint: False

Datasets, Workspaces and Results

Result Mount Point: /results

Job Resources

Instance Type: dgxa100.80g.1.norm

Instance Details: 1 GPU, 30 CPU, 244 GB System Memory

ACE: nv-launchpad-bc-sjc-ace

Team: nvbc-tme

Job Status

Created at: 2022-04-18 19:13:54 UTC

Started at: 2022-04-18 19:14:07 UTC

Ended at: 2022-04-18 19:15:53 UTC

Duration: 01M46S

Status: FINISHED_SUCCESS

Status Type: OK

Preempt Class: RUNONCE

Minimum Timeslice: 01S

--------------------------------------------------

当状态为 FINISHED_SUCCESS 时,我们可以使用 ngc dataset convert 命令将 /results 目录的内容转换为数据集,该命令依赖于相同的作业 id 值。

$ ngc dataset convert --from-result 2818455 linux-kernel-from-cli

Dataset with ID: '99164' created in ACE: 'nv-launchpad-bc-sjc-ace'.

我们现在可以列出您的帐户拥有的数据集,其中将包括从先前作业结果创建的新数据集(查找 linux-kernel-from-cli)。

$ ngc dataset list –-owned

+-------------------+------------+---------------+-------------+------------------+--------+----------+-----------+--------------+-------+---------+

| Id | Integer Id | Name | Description | ACE | Shared | Size | Status | Created Date | Owned | Pre-pop |

+-------------------+------------+---------------+-------------+------------------+--------+----------+-----------+--------------+-------+---------+

| cHCMiESgRVeduwq8v | 99164 | linux-kernel- | | nv-launchpad-bc- | No | 1.03 GB | COMPLETED | 2022-04-18 | Yes | No |

| FfIRQ | | from-cli | | sjc-ace | | | | 21:11:38 UTC | | |

+-------------------+------------+---------------+-------------+------------------+--------+----------+-----------+--------------+-------+---------+

要使用 Web UI 创建相同的数据集,请导航到 NGC 导航窗格的 Base Command 部分中的 作业 链接。

单击 作业 页面顶部的 创建作业 按钮。

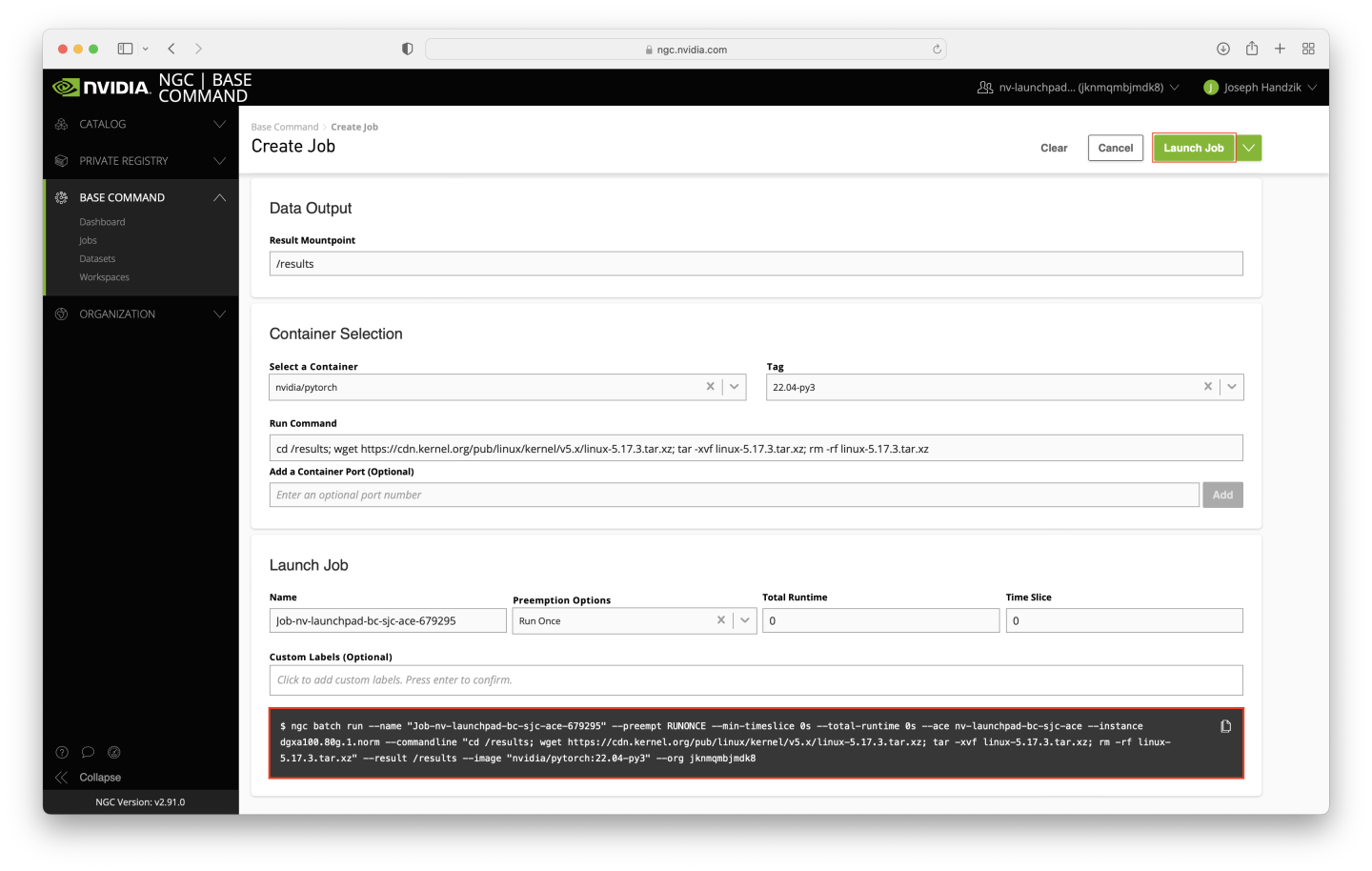

填写 创建作业 Web 表单,使用以下值(对于任何跳过的条目,保留默认值)

从列表中选择您的 ACE。

在 INSTANCE 表中选择 dgxa100.80g.1.norm。

现在忽略数据集和工作区输入表。

为数据输出字段输入

/results。选择

nvidia/pytorch容器。选择标签值

22.04-py3。对于命令,复制以下内容

cd /results; wget https://cdn.kernel.org/pub/linux/kernel/v5.x/linux-5.17.3.tar.xz; tar -xvf linux-5.17.3.tar.xz; rm -rf linux-5.17.3.tar.xz

表单的其余部分可以保留默认值。

要验证是否选择了正确的选项,请使用下面屏幕截图中的值检查屏幕上的 ngc batch run 命令(--name 参数将有所不同,并且 --ace 和 --org 参数也可能有所不同)。准备就绪后,单击页面右上角附近的 启动作业 按钮。

要查看工作区,请导航到 Base Command 菜单下的 工作区 链接。

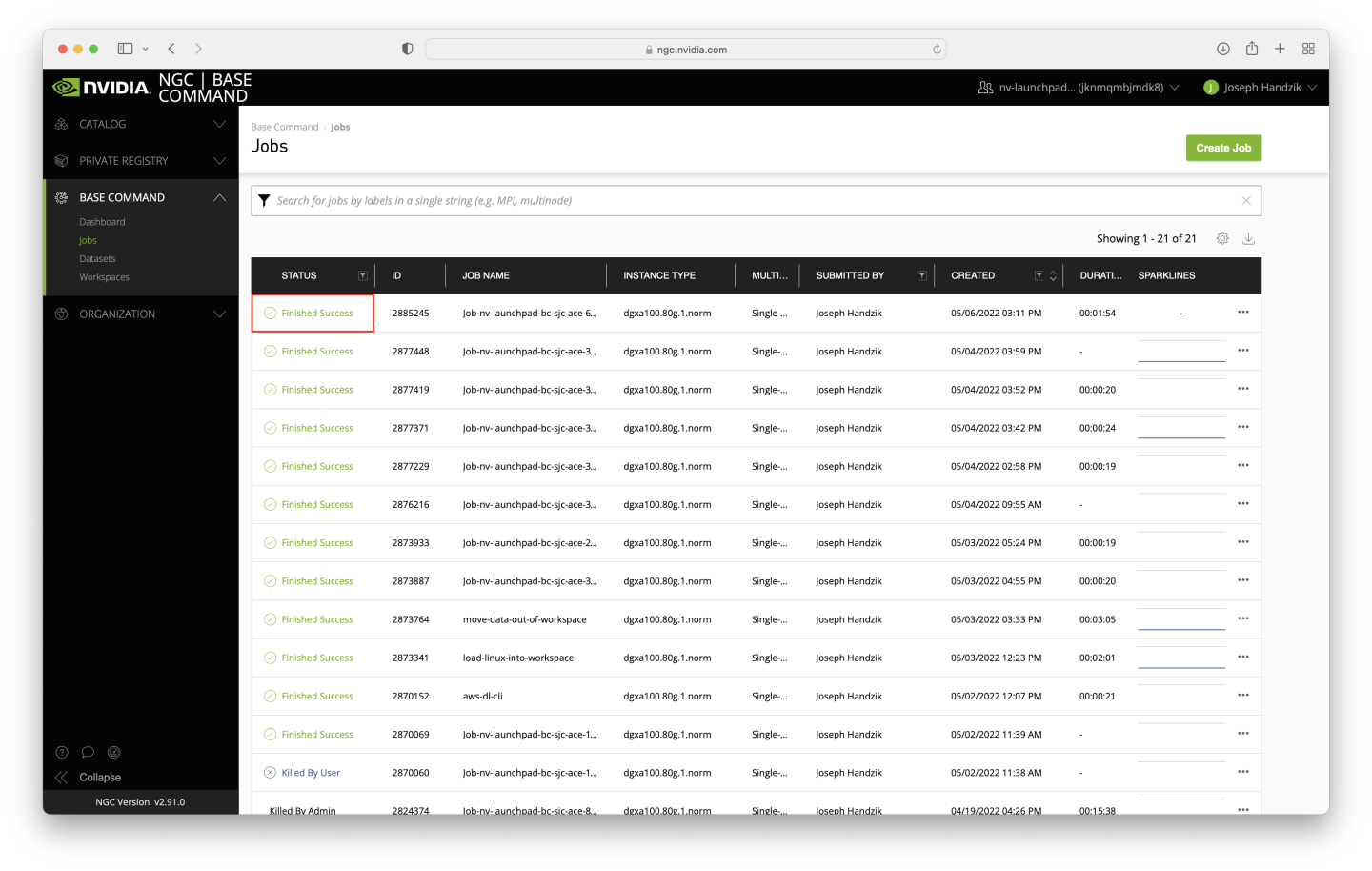

作业不应花费很长时间运行 - 假设 ACE 相对空闲,则大约 5 分钟。您可能需要刷新页面以验证作业状态是否为 Finished Success。

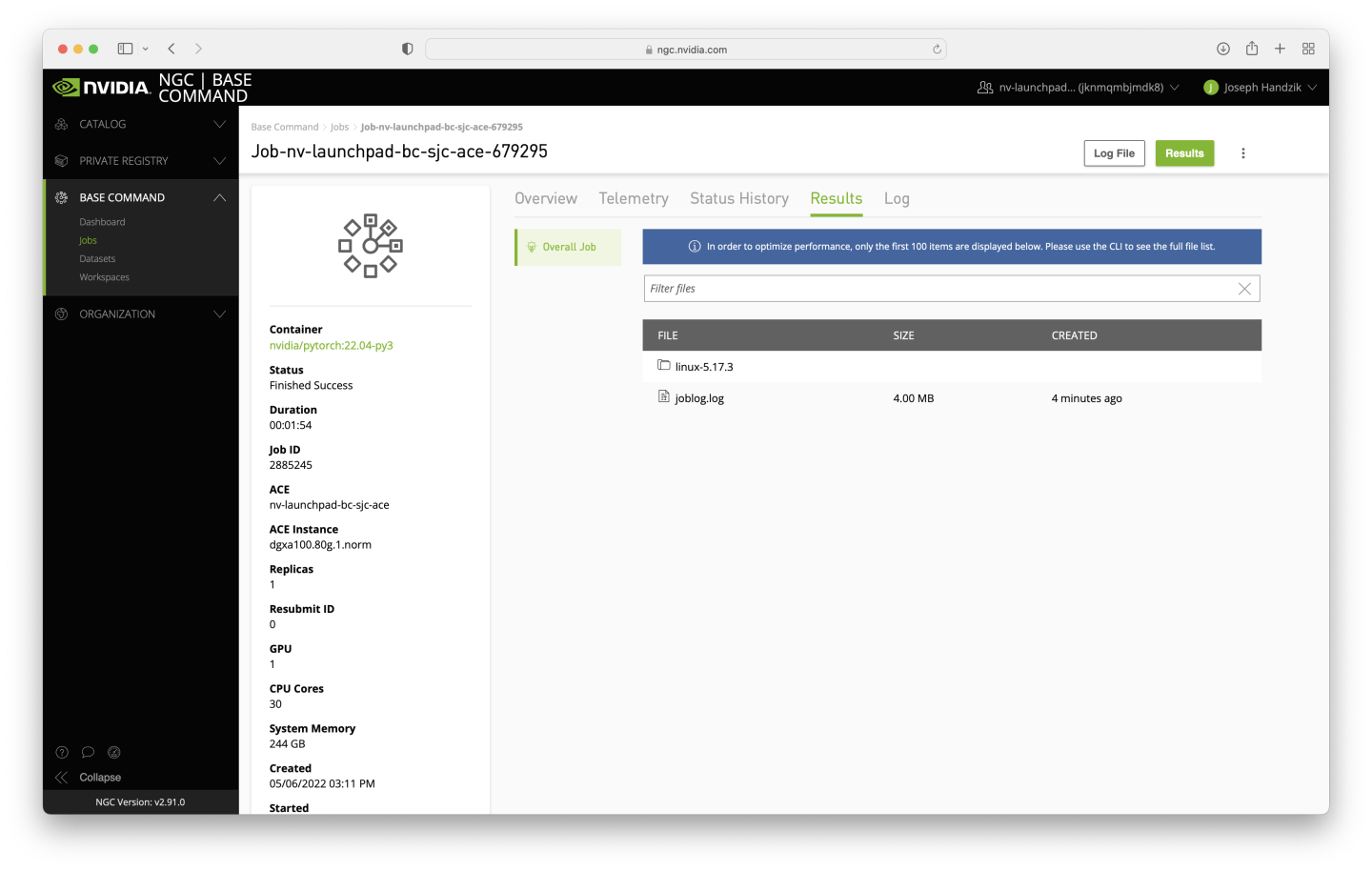

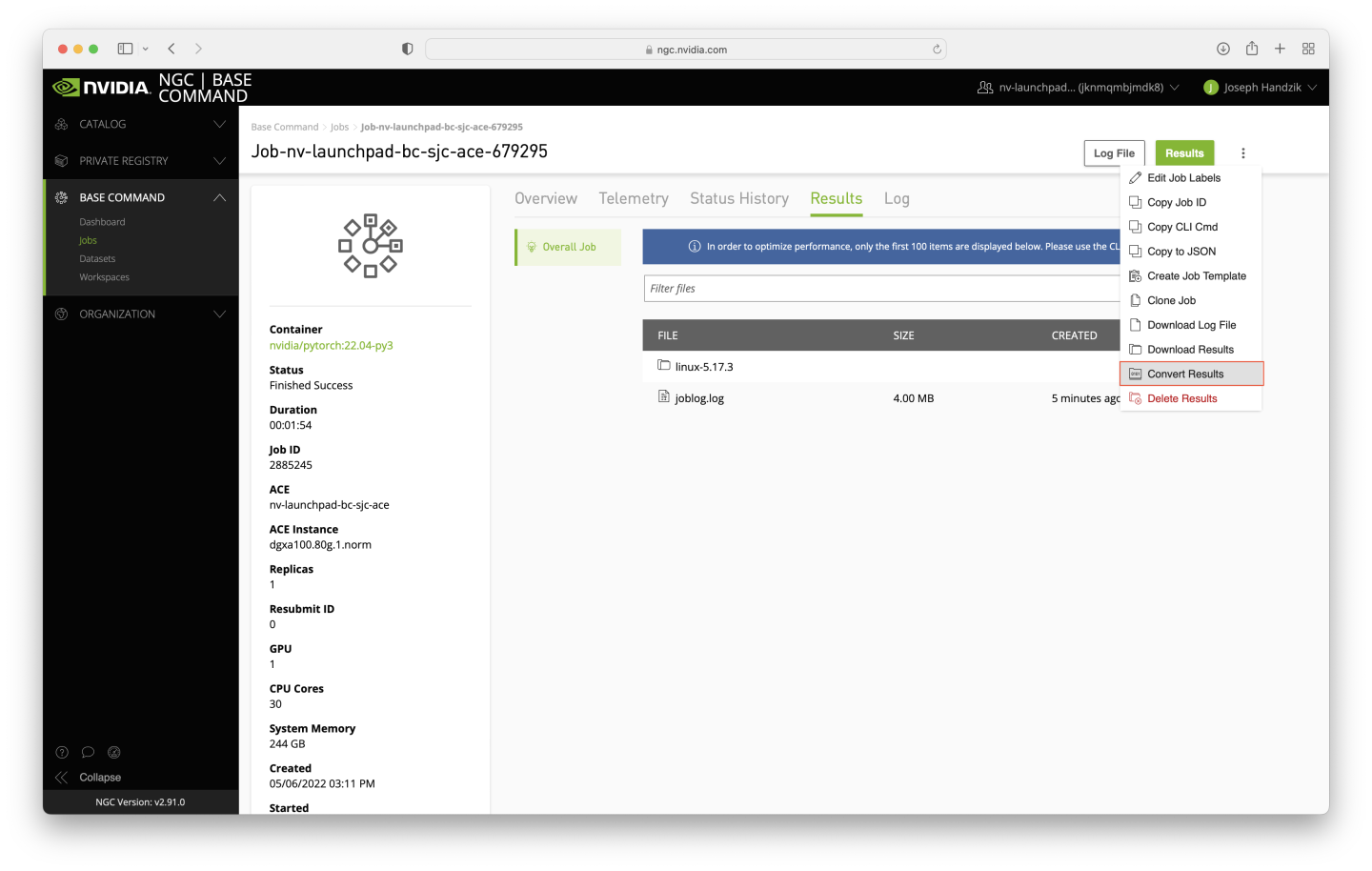

单击新完成的作业,然后导航到 结果 选项卡,以验证下载的数据是否已成功提取。joblog.log 文件的存在是预期的 - 它将成为数据集的一部分,但在重用数据集时可以忽略。

要将结果目录转换为数据集,请单击页面右上角附近的垂直省略号,然后单击 转换结果 按钮。

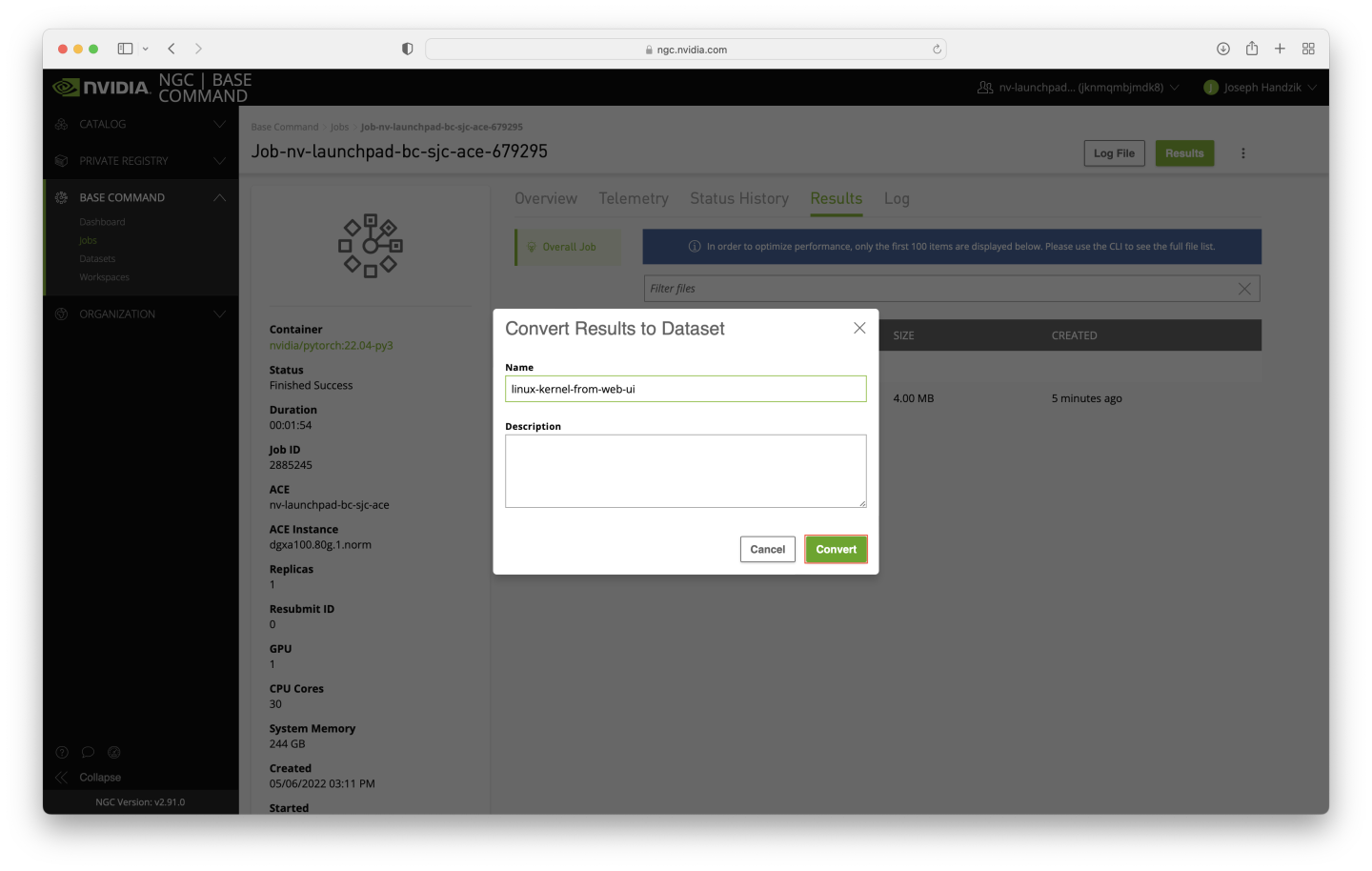

将出现一个对话框 - 在 名称 字段中输入 linux-kernel-from-web-ui,然后单击 转换 按钮。

短暂时间后,用于创建数据集的作业的 Results 目录将变为空,这表示数据集转换已执行。单击导航窗格中的 数据集 链接,就在先前使用过的 作业 链接下方。

新数据集应显示在 数据集 页面顶部数据行中的表格中。