立体视差

概述

立体视差应用程序接收左右立体图像对,并返回它们之间的视差,视差是图像深度的函数。结果将保存为图像文件到磁盘。如果可用,它还将输出相应的置信度图。

说明

命令行参数为

<backend> <left image> <right image>

其中

- backend:可以是 cuda、ofa 或 ofa-pva-vic;它定义了将执行处理的后端。 ofa-pva-vic 和 cuda 允许除了视差之外还输出置信度图。

- left image:校正后的立体图像对的左输入图像,它接受 png、jpeg 以及可能的其他格式。

- right image:立体图像对的右输入图像。

这是一个例子

- C++./vpi_sample_02_stereo_disparity cuda ../assets/chair_stereo_left.png ../assets/chair_stereo_right.png

- Pythonpython3 main.py cuda ../assets/chair_stereo_left.png ../assets/chair_stereo_right.png

这是使用 CUDA 后端和提供的示例图像。您可以尝试使用其他立体图像对,但要遵守算法施加的约束。

此示例的 Python 版本还允许设置各种附加参数,以及附加的输入图像扩展名和打开详细模式。以下命令行参数可以传递给 Python 示例

- Python其中附加的可选参数为python3 main.py <backend> <left image> <right image> --width W --height H --downscale D --window_size WIN--skip_confidence --conf_threshold T --conf_type absolute/relative -p1 P1 -p2 P2 --p2_alpha P2alpha--uniqueness U --skip_diagonal --num_passes N --min_disparity MIN --max_disparity MAX --output_mode 0/1/2-v/--verbose

- width:当传递 ".raw" 输入图像时,设置宽度 W

- height:当传递 ".raw" 输入图像时,设置高度 H

- downscale:设置输出的缩小比例因子为 D

- window_size:设置中值滤波器窗口大小为 WIN

- skip_confidence:避免计算置信度并将其用作掩码

- conf_threshold:设置置信度阈值为 T

- conf_type:设置置信度类型为 absolute 或 relative

- p1:设置 p1 惩罚为 P1

- p2:设置 p2 惩罚为 P2

- p2_alpha:设置 p2Alpha 自适应惩罚为 P2alpha

- uniqueness:设置唯一性为 U

- skip_diagonal:避免在 CUDA 或 OFA 后端中使用对角路径

- num_passes:在 OFA 后端中设置通过次数 N

- min_disparity:在 CUDA 后端中设置最小视差 MIN

- max_disparity:在后端中设置最大视差 MAX

- output_mode:0 表示彩色输出,1 表示灰度输出,2 表示原始二进制输出

- verbose:打开详细模式。要详细了解与立体视差算法相关的每个附加参数,请阅读相应的文档。

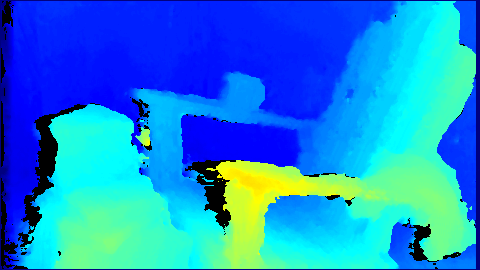

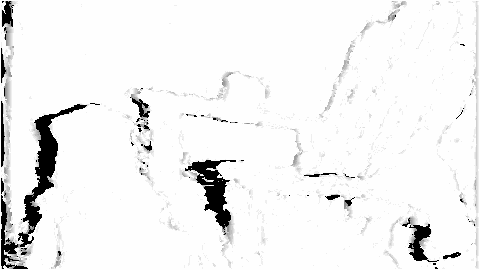

结果

| 左输入图像 | 右输入图像 |

|---|---|

|  |

| 立体视差 | 置信度图 |

|  |

源代码

为了方便起见,这里是代码,它也安装在 samples 目录中。

语言 65 parser.add_argument('--skip_confidence', default=False, action='store_true', help='Do not calculate confidence')

67 parser.add_argument('--conf_type', default='best', choices=['best', 'absolute', 'relative', 'inference'],

68 help='Computation type to produce the confidence output. Default will pick best option given backend.')

73 parser.add_argument('--skip_diagonal', default=False, action='store_true', help='Do not use diagonal paths')

77 parser.add_argument('--output_mode', default=0, type=int, help='0: color; 1: grayscale; 2: raw binary')

99 conftype = vpi.ConfidenceType.INFERENCE if args.backend == 'ofa-pva-vic' else vpi.ConfidenceType.ABSOLUTE

144 pil_right = read_raw_file(args.right, resize_to=[args.height, args.width], verbose=args.verbose)

202 CHECK_STATUS(vpiCreateStereoDisparityEstimator(backends, stereoWidth, stereoHeight, stereoFormat, &createParams,

215 CHECK_STATUS(vpiImageCreate(outputWidth, outputHeight, VPI_IMAGE_FORMAT_U16, 0, &confidenceMap));

254 CHECK_STATUS(vpiSubmitConvertImageFormat(stream, VPI_BACKEND_CUDA, inLeft, tmpLeft, &convParams));

255 CHECK_STATUS(vpiSubmitConvertImageFormat(stream, VPI_BACKEND_CUDA, inRight, tmpRight, &convParams));

259 vpiSubmitRescale(stream, VPI_BACKEND_VIC, tmpLeft, stereoLeft, VPI_INTERP_LINEAR, VPI_BORDER_CLAMP, 0));

260 CHECK_STATUS(vpiSubmitRescale(stream, VPI_BACKEND_VIC, tmpRight, stereoRight, VPI_INTERP_LINEAR,

266 CHECK_STATUS(vpiSubmitConvertImageFormat(stream, VPI_BACKEND_CUDA, inLeft, stereoLeft, &convParams));

267 CHECK_STATUS(vpiSubmitConvertImageFormat(stream, VPI_BACKEND_CUDA, inRight, stereoRight, &convParams));

274 CHECK_STATUS(vpiSubmitStereoDisparityEstimator(stream, backends, stereo, stereoLeft, stereoRight, disparity,

284 CHECK_STATUS(vpiImageLockData(disparity, VPI_LOCK_READ, VPI_IMAGE_BUFFER_HOST_PITCH_LINEAR, &data));

308 CHECK_STATUS(vpiImageLockData(confidenceMap, VPI_LOCK_READ, VPI_IMAGE_BUFFER_HOST_PITCH_LINEAR, &data));

声明处理图像格式转换的函数。

#define VPI_IMAGE_FORMAT_Y8_ER

单平面,带有一个 pitch-linear 8 位无符号整数通道,具有全范围亮度(灰度)...

Definition: ImageFormat.h:159

用于处理 VPI 图像的函数和结构。

用于处理 VPI 的 OpenCV 互操作性的函数。

声明实现 Rescale 算法的函数。

VPI 状态代码处理函数的声明。

声明实现立体视差估计算法的函数。

声明处理 VPI 流的函数。

VPIStatus vpiInitConvertImageFormatParams(VPIConvertImageFormatParams *params)

使用默认值初始化 VPIConvertImageFormatParams。

VPIStatus vpiSubmitConvertImageFormat(VPIStream stream, uint64_t backend, VPIImage input, VPIImage output, const VPIConvertImageFormatParams *params)

将图像内容转换为所需的格式,可选择缩放和偏移。

VPIStatus vpiImageLockData(VPIImage img, VPILockMode mode, VPIImageBufferType bufType, VPIImageData *data)

获取图像对象的锁并返回图像内容。

VPIStatus vpiImageCreate(int32_t width, int32_t height, VPIImageFormat fmt, uint64_t flags, VPIImage *img)

使用指定的标志创建空的图像实例。

VPIStatus vpiImageCreateWrapperOpenCVMat(const cv::Mat &mat, VPIImageFormat fmt, uint64_t flags, VPIImage *img)

使用给定的图像格式将 cv::Mat 封装到 VPIImage 中。

Definition: OpenCVInterop.hpp:117

VPIStatus vpiImageDataExportOpenCVMat(const VPIImageData &imgData, cv::Mat *mat)

使用来自锁定 VPIImage 的 VPIImageData 数据填充现有的 cv::Mat。

Definition: OpenCVInterop.hpp:346

VPIStatus vpiSubmitRescale(VPIStream stream, uint64_t backend, VPIImage input, VPIImage output, VPIInterpolationType interpolationType, VPIBorderExtension border, uint64_t flags)

更改 2D 图像的大小和比例。

VPIStatus vpiInitStereoDisparityEstimatorCreationParams(VPIStereoDisparityEstimatorCreationParams *params)

使用默认值初始化 VPIStereoDisparityEstimatorCreationParams。

VPIStatus vpiCreateStereoDisparityEstimator(uint64_t backends, int32_t imageWidth, int32_t imageHeight, VPIImageFormat inputFormat, const VPIStereoDisparityEstimatorCreationParams *params, VPIPayload *payload)

为 vpiSubmitStereoDisparityEstimator 创建有效负载。

VPIStatus vpiInitStereoDisparityEstimatorParams(VPIStereoDisparityEstimatorParams *params)

使用默认值初始化 VPIStereoDisparityEstimatorParams。

VPIStatus vpiSubmitStereoDisparityEstimator(VPIStream stream, uint64_t backend, VPIPayload payload, VPIImage left, VPIImage right, VPIImage disparity, VPIImage confidenceMap, const VPIStereoDisparityEstimatorParams *params)

在一对图像上运行立体处理并输出视差图。

@ VPI_STEREO_CONFIDENCE_INFERENCE

像素的置信度值在 0:UINT16_MAX 范围内,从 0% 映射到 100%。

Definition: StereoDisparity.h:213

定义 vpiCreateStereoDisparityEstimator 参数的结构体。

Definition: StereoDisparity.h:83

定义 vpiSubmitStereoDisparityEstimator 参数的结构体。

Definition: StereoDisparity.h:221