企业级 AI 软件平台#

NVIDIA 企业级 AI 软件平台#

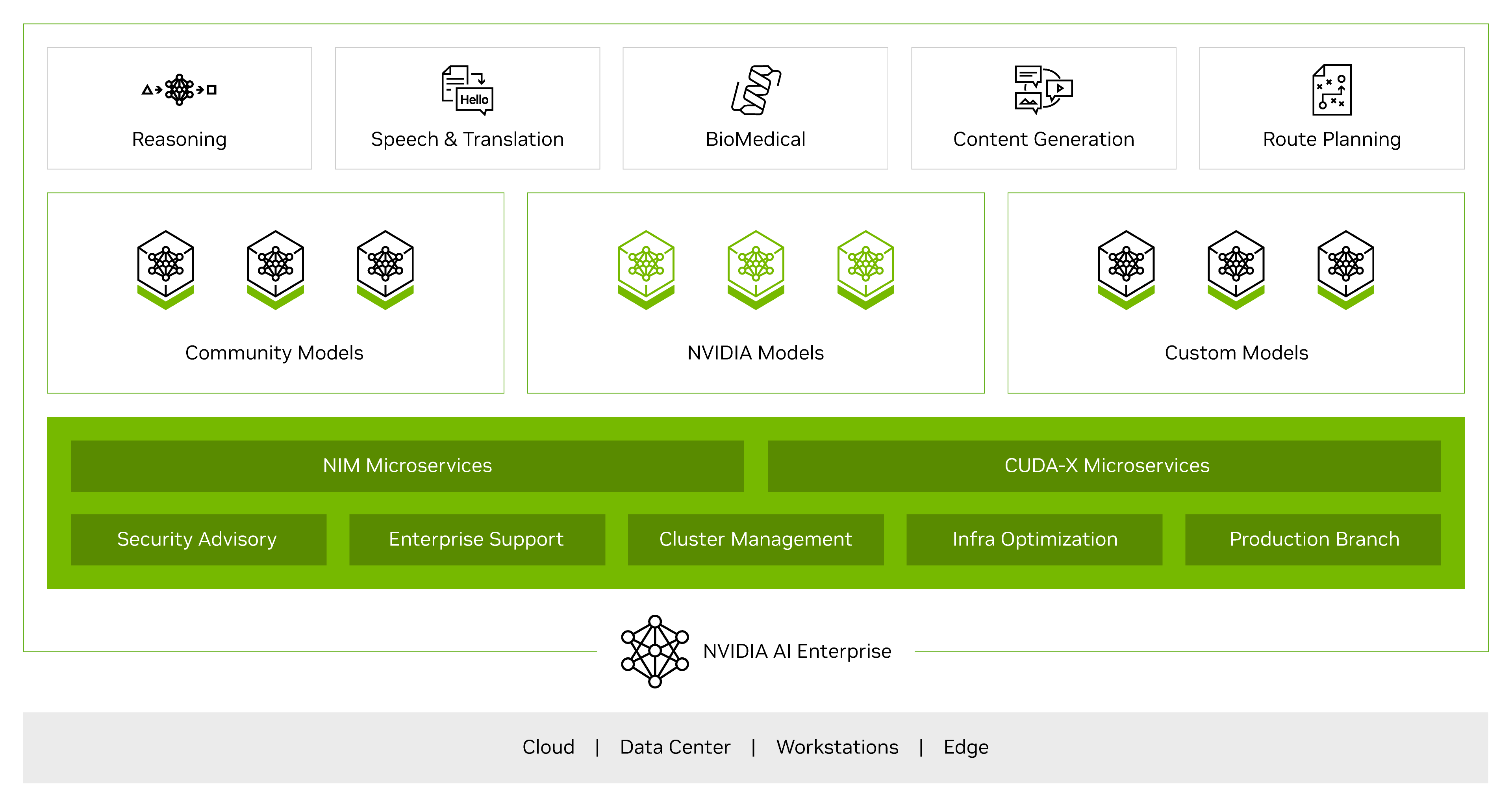

NVIDIA AI Enterprise 是一个端到端的云原生软件平台,可加速数据科学管道,并简化生产级副驾驶和其他生成式 AI 应用程序的开发和部署。易于使用的微服务提供优化的模型性能,并具有企业级安全性、支持和稳定性,以确保在企业在其 AI 业务上运行时,从原型到生产的平稳过渡。

NVIDIA AI Enterprise 与加速平台紧密集成,通过软件优化加速 AI 工作负载。这不仅提高了效率和性能,还减少了能源、占用空间和数据中心的投资,从而有助于更可持续的计算并节省上市时间成本。

- 企业级安全性、稳定性、可管理性和支持

随着 AI 的快速发展和扩展,软件堆栈及其依赖项的复杂性也在增加。NVIDIA AI Enterprise 专为运行业务关键型 AI 而设计,通过定期发布针对关键和常见漏洞及风险 (CVE) 的安全补丁、用于 API 稳定性的生产分支、端到端管理软件以及具有服务级别协议 (SLA) 的企业支持。

- 云原生且经过认证可在任何地方运行

NVIDIA AI Enterprise 经过优化和认证,可确保在公有云、虚拟化数据中心或 DGX 平台上可靠地运行 AI。这提供了灵活的一次开发应用程序并在任何地方部署的能力,从而降低了由于环境之间基础设施和架构差异而导致的从试点到生产的风险。

NVIDIA AI 支持的软件#

NVIDIA AI 应用程序框架、NVIDIA 预训练模型以及 NGC 上提供的所有其他 NVIDIA AI 软件均受 NVIDIA AI Enterprise 许可支持。凭借 100 多个 AI 框架和预训练模型,包括 NeMo、Maxine、cuOpt 以及更多即将添加的模型,请在 NGC 上查找“NVIDIA AI Enterprise 支持”标签。

组织通过使用开放、免费提供的 NGC 库和框架开始他们的 AI 之旅,以进行实验和试点。现在,当他们准备好从试点转向生产时,企业可以轻松过渡到完全托管且安全的 AI 平台,并订阅 NVIDIA AI Enterprise。这为部署业务关键型 AI 的企业提供了业务连续性的保证,以及 NVIDIA 企业级支持和 NVIDIA AI 专家的访问权限。

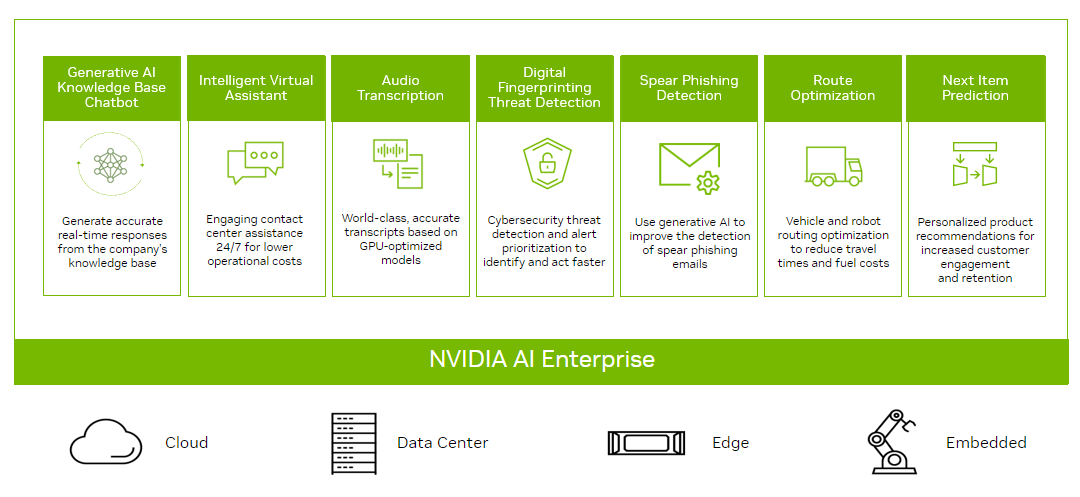

NVIDIA AI 工作流程#

NVIDIA AI Enterprise 包括用于构建 AI 应用程序的新 AI 解决方案工作流程,包括联络中心智能虚拟助手、音频转录和网络安全数字指纹识别以检测异常。这些打包的 AI 工作流程示例包括 NVIDIA AI 框架和预训练模型,以及 Helm Charts、Jupyter Notebooks 和文档等资源,以帮助客户更轻松地开始构建基于 AI 的解决方案。NVIDIA 的云原生 AI 工作流程作为微服务运行,可以单独部署在 Kubernetes 上,也可以与其他微服务一起部署以创建可用于生产的应用程序。

主要优势

缩短开发时间,降低成本

提高准确性和性能

通过利用 NVIDIA 专业知识,对结果充满信心

可用于生产的预训练模型#

预训练 AI 模型使高性能 AI 开发变得容易、快速且易于访问,无需从头开始构建模型。NVIDIA AI Enterprise 包括未加密的预训练模型,用于医疗保健和视觉 AI 任务,例如人员检测、车辆检测、联邦学习模型、图像配准等。通过访问这些预训练模型,开发人员可以查看模型的权重和偏差,这有助于模型的可解释性并了解模型偏差。此外,未加密的模型更易于调试和集成到自定义 AI 应用程序中。

NVIDIA NIM#

NVIDIA NIM 是 NVIDIA AI Enterprise 的一部分,是一组易于使用的微服务,旨在加速在企业中部署生成式 AI。这种通用的运行时支持广泛的 AI 模型——从开源社区模型到 NVIDIA AI 基础模型,以及自定义 AI 模型。借助行业标准 API,开发人员只需几行代码即可快速构建企业级 AI 应用程序。NIM 构建在包括 Triton Inference Server、TensorRT、TensorRT-LLM 和 PyTorch 等推理引擎的强大基础上,旨在促进大规模无缝 AI 推理,确保您可以放心地在任何地方部署 AI 应用程序。无论是在本地还是在云端,NIM 都是实现加速生成式 AI 大规模推理的最快方式。

访问 NVIDIA NIM 文档中心 以获取更多信息。

支持的硬件和软件#

NVIDIA AI Enterprise 经过认证可在公有云、数据中心、工作站、DGX 平台到边缘运行。支持配置的完整列表在 NVIDIA AI Enterprise 产品支持矩阵 中列出。

NVIDIA 企业级支持和服务指南 提供了有关使用 NVIDIA 企业级支持和服务的信息。本文档适用于 NVIDIA 的潜在和现有企业客户。本用户指南是非约束性文档,应用于获取有关 NVIDIA 企业品牌支持和服务的信息。

使用 NPN 合作伙伴查找器 查找合作伙伴和 OEM(原始设备制造商)支持。

使用 消费者支持 网页查找 NVIDIA 消费者支持。