概述

Azure Stack HCI 是一种强大的超融合基础设施解决方案,它将本地基础设施与云服务相结合,为部署虚拟化工作负载提供全面而灵活的环境。本指南探讨了 NVIDIA 虚拟 GPU (vGPU) 软件在 Azure Stack HCI 中的集成,使多台虚拟机 (VM) 能够同时直接访问单个物理 GPU。这种能力对于增强图形性能、确保应用程序兼容性以及优化需要 GPU 加速的环境中的成本效益至关重要。

本章介绍了 NVIDIA vGPU 解决方案如何从根本上改变桌面虚拟化和 GPU 加速服务器的格局。NVIDIA vGPU 使户能够使用各种复杂度级别和图形要求的工作负载来执行这些解决方案。本章还介绍了 NVIDIA vGPU 架构、NVIDIA 推荐用于虚拟化的 GPU、用于桌面虚拟化的 NVIDIA vGPU 软件许可产品,以及 NVIDIA 虚拟 GPU 技术支持的关键标准。

桌面和数据中心虚拟化的前景在于其灵活性和可管理性。最初由对灵活性和安全性的需求驱动,由于技术的普及,桌面和数据中心虚拟化变得更容易访问,这大大降低了成本。这扩大了市场可及性并推动了增长,NVIDIA 作为推动者发挥了关键作用。存储和多核处理器的进步进一步增强了关于总拥有成本的竞争优势。

桌面虚拟化中最大的挑战之一是提供经济高效且丰富的用户体验。

NVIDIA 虚拟 GPU (vGPU) 软件通过为各种工作负载(从图形密集型虚拟工作站到数据科学和 AI)实现强大的 GPU 性能来应对这一挑战。这使 IT 能够利用虚拟化的管理和安全优势,以及现代工作负载所需的 NVIDIA GPU 的性能。NVIDIA vGPU 软件安装在云或企业数据中心服务器中的物理 GPU 上,创建可以跨多个虚拟机共享并可从任何设备在任何位置访问的虚拟 GPU。

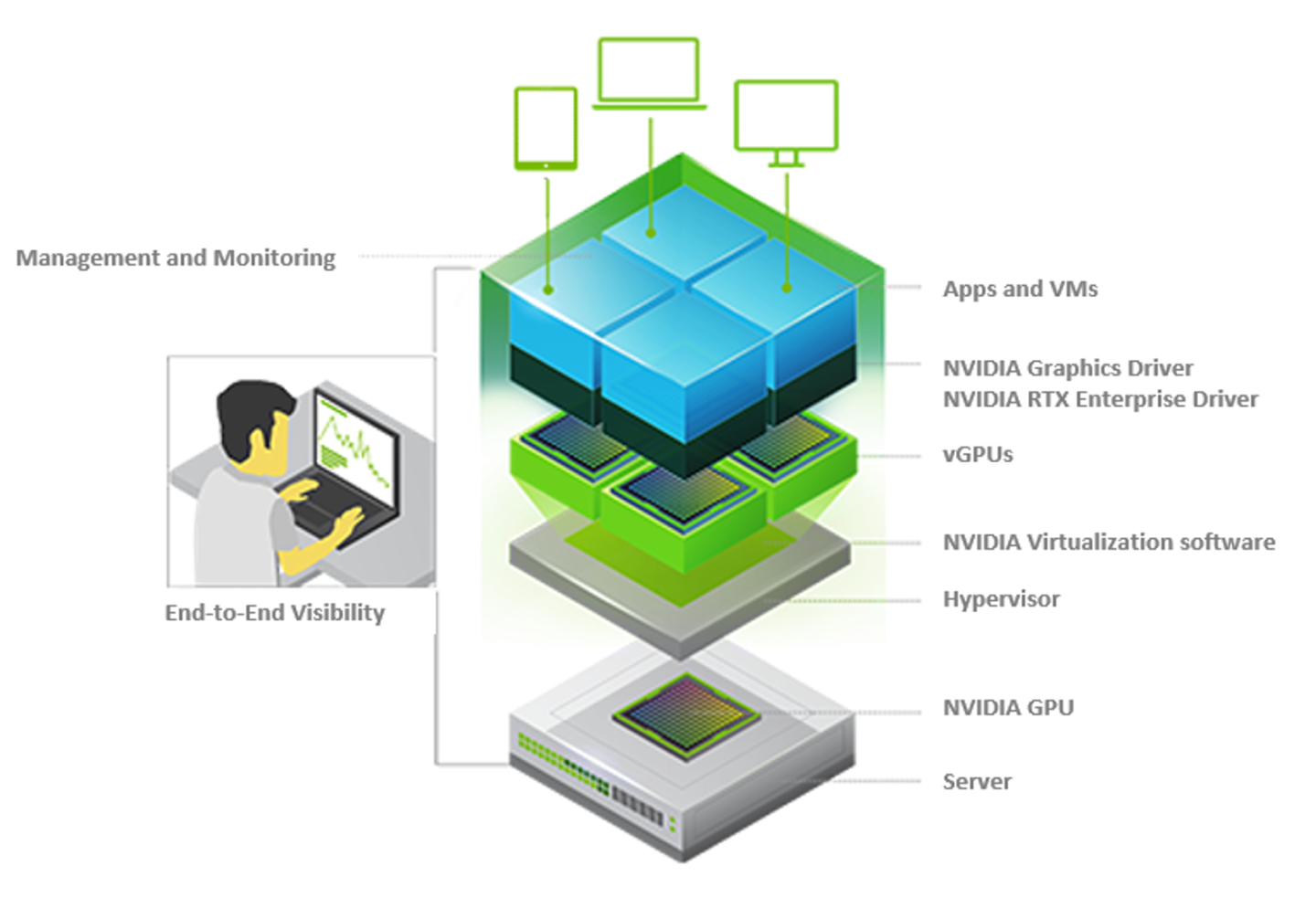

图 1.1 显示了启用 NVIDIA 虚拟 GPU 的 VDI 环境的高级架构。该软件使多个虚拟机能够共享单个 GPU,并且如果服务器中有多个 GPU,则可以启用单个虚拟机来访问多个 GPU。这种启用 GPU 的环境提供了前所未有的性能,并支持服务器上更多的用户。通常由 CPU 完成的工作,例如 GPU 就绪的工作负载或图形和编码器任务,现在可以卸载到 GPU。物理 NVIDIA GPU 可以支持多个虚拟 GPU (vGPU),并在 hypervisor 中运行的 NVIDIA 虚拟 GPU 管理器的控制下直接分配给客户虚拟机。

客户虚拟机使用 NVIDIA GPU 的方式与 hypervisor 传递的物理 GPU 相同,并且 NVIDIA GPU 驱动程序直接安装在客户虚拟机中。

图 1.1 - NVIDIA vGPU 架构

NVIDIA vGPU 与传统 GPU 相当,因为它们具有固定数量的 GPU 内存,但它们具有虚拟显示器而不是物理端口。vGPU 内存由安装在 hypervisor 中的 NVIDIA vGPU 管理器管理,在创建 vGPU 时从物理 GPU 帧缓冲区中分配。vGPU 保留对该 GPU 内存的独占使用权,直到它被销毁。

这些是虚拟显示器,这意味着 GPU 上没有用于外部物理显示器的物理连接点。

驻留在物理 GPU 上的所有 vGPU 共享 GPU 引擎,包括图形 (3D) 和视频解码和编码引擎。图 1.1 的右侧显示了 vGPU 内部架构。虚拟机的客户操作系统利用对 GPU 的直接访问来实现性能和快速关键路径。非关键性能管理操作使用准虚拟化接口连接到 NVIDIA 虚拟 GPU 管理器。