AWS 虚拟机上的 NGC

NVIDIA 在 Amazon Web Services (AWS) 平台上提供了三种不同的 VMI,在 AWS 生态系统中称为 Amazon Machine Image (AMI)。这些是针对配备 NVIDIA V100(EC2 P3 实例)、NVIDIA T4 GPU(EC2 G4 实例)、NVIDIA A100 GPU(EC2 P4d)的 AWS 实例的 GPU 优化 AMI。此外,NVIDIA AMI 还支持 ARM64 (EC2 G5g) 实例。

对于熟悉 AWS 平台的用户来说,启动实例的过程非常简单,只需登录,选择所需的 NVIDIA GPU 优化镜像,根据需要配置设置,然后启动 VM。启动 VM 后,您可以 SSH 进入 VM,并通过利用 NGC 目录中提供的各种 GPU 加速容器、预训练模型和资源,开始构建大量深度学习、机器学习和数据科学领域的 AI 应用程序。

本文档提供了完成此操作的分步说明,包括如何使用 AWS CLI。

先决条件

-

您拥有一个 AWS 账户 - https://aws.amazon.com

- 浏览 NGC 网站 并确定要在虚拟机实例 (VMI) 上运行的可用 NGC 容器和标签。

-

Windows 用户:CLI 代码片段适用于 Linux 或 Mac OS X 上的 bash。如果您使用的是 Windows 并且想要按原样使用这些片段,则可以使用 Windows Subsystem for Linux 并使用 bash shell(您将在 Ubuntu Linux 中)。

1.1. 安全最佳实践

云安全始于您的 CSP 账户的安全策略。请参考以下链接,了解如何为您的 CSP 配置安全策略

用户必须遵循其 CSP 的安全指南和最佳实践,以保护其 VM 和账户的安全。

1.2. 开始之前

执行以下初步设置任务,以简化启动 NVIDIA 深度学习 AMI 的过程。

1.2.1. 设置您的 AWS 密钥对

如果您尚未定义密钥对,则需要设置您的 AWS 密钥对,并将其放在您将使用 AWS CLI 的计算机上,或者您将从中 SSH 连接到实例的计算机上。在示例中,密钥对名为“my-key-pair”。

下载密钥对后,请确保它们只能由您读取,并且(Linux 或 OSX)将它们移动到您的~/.ssh/目录。

chmod 400 my-key-pair*

mv my-key-pair* ~/.ssh/

1.2.2. 为 EC2 实例设置安全组

安全组定义了您对虚拟机实例施加的网络连接限制。为了连接到正在运行的实例,您需要一个允许(至少)SSH 访问的安全组。

- 登录 AWS 控制台 (https://aws.amazon.com),然后单击“所有服务”下拉菜单中“控制台”部分下的 EC2。

- 进入“安全组”屏幕,该屏幕位于左侧“网络和安全”下的“安全组”中。

- 单击 创建安全组。

- 为安全组命名(例如,“my-sg”)、描述,然后单击 添加规则

- 在“入站”部分下,单击 添加规则,并使用以下参数启用 SSH:

- 类型: SSH

- 协议: TCP

- 端口范围: 22

- 来源: 我的 IP

如果您没有固定的 IP 地址,或者想从多个位置(例如工作场所和家庭)访问实例,则可能需要扩大生成的 IP 过滤器。

以下显示了使用示例命名的已填写的“创建安全组”表单。

- (可选)添加其他规则。

根据您使用的深度学习框架,您可能需要为 HTTP、HTTPS 或其他自定义 TCP 端口添加其他规则。

通过单击 添加规则 继续添加其他规则,然后根据需要创建规则。

示例

-

对于 DIGITS4

- 类型: 自定义 TCP 规则

- 协议: TCP

- 端口范围: 3448

- 来源: 我的 IP

-

对于 HTTPS 安全 Web 框架

- 类型: HTTPS

- 协议: TCP

- 端口范围: 443

- 来源: 我的 IP

安全警告

在授予访问权限或通过互联网共享您的 AMI 之前,务必采取适当的预防措施和安全措施。默认情况下,与 AMI 实例的互联网连接被阻止。您全权负责启用和保护对 AMI 的访问。请参阅 AWS 指南以了解如何管理安全组。

-

- 单击创建安全组 以完成在右下角创建安全组。

创建后,组 ID 将在安全组表中列出。

1.3. 使用 AWS 控制台创建 NGC 认证虚拟机

1.3.1. 登录并选择 AWS 区域

- 登录 AWS 控制台 (https://aws.amazon.com),然后在“计算”部分下,单击 EC2 。

- 从顶部菜单的右上角选择 AWS 区域。

为了在 AWS 中使用 NVIDIA Volta 和 Turing GPU,您必须选择一个提供 Amazon EC2 P3 或 G4 实例的区域。本指南中的示例使用美国西部(俄勒冈)- us-west-2 中的实例。请咨询 AWS 以了解其他区域的 Amazom EC2 P3 或 G4 实例可用性。

1.3.2. 创建 VM 并选择 NVIDIA GPU 优化 AMI

NVIDIA 发布并维护多种 GPU 优化 AMI 版本,其中包含从 NGC 中提取和运行内容所需的所有软件。这些 AMI 应用于启动您的 GPU 实例。

- 单击 启动实例。

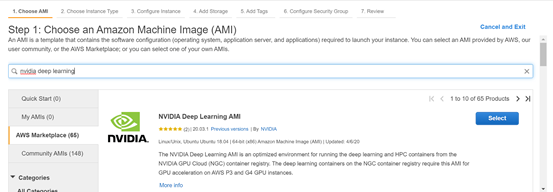

- 选择 NVIDIA 深度学习 AMI。

- 在流程的步骤 1 中选择 AWS Marketplace。

- 通过在搜索栏中简单地键入“nvidia”来搜索并选择最适合您目的的 NVIDIA GPU 优化 AMI。

- 在详细信息页面上单击 继续。

1.3.3. 选择具有 GPU 的实例类型并配置实例设置

- 根据您的 GPU、CPU 和内存要求,选择 Amazon EC2 P3 或 G4 实例类型之一。

- 单击 查看和启动 以查看默认配置设置,或继续阅读下一节中的说明以逐步配置每个设置

- 选择实例类型后,单击 下一步:配置实例详细信息。

无需配置任何实例详细信息,因此您可以继续下一步。

- 添加存储。

单击 下一步:添加存储。

虽然可以更改根卷的默认 32 GiB,但用户不应使用根卷来存储数据集,因为根卷会在实例终止时销毁。

- 添加标签。

命名实例有助于组织多个实例。

- 单击 下一步:添加标签。

- 单击 添加标签,然后填写以下信息

键:“名称”

值:<实例名称,例如“我的 GPU”>

- 配置安全组

- 单击 下一步:配置安全组。

- 单击 选择现有安全组,然后选择您在开始之前期间创建的安全组。

1.3.4. 启动您的 VM 实例

1.3.5. 连接到您的 VM 实例

- 启动实例后,单击 查看实例,从列表中找到您的实例,然后等待其状态变为“正在运行”。

- 当其处于运行状态时,从列表中选择它,然后单击 连接。

- 按照弹出窗口中的说明建立与实例的 SSH 连接。

请务必使用“ubuntu”作为用户名。

如果 SSH 登录说明不起作用,请参阅 AWS 连接到您的 Linux 实例 文档以获取更多信息。

1.3.6. 启动/停止/终止您的 VM 实例

完成实例操作后,您可以停止(稍后重新启动)或终止(删除)它。有关更多信息,请参阅 AWS 文档中的 实例生命周期。

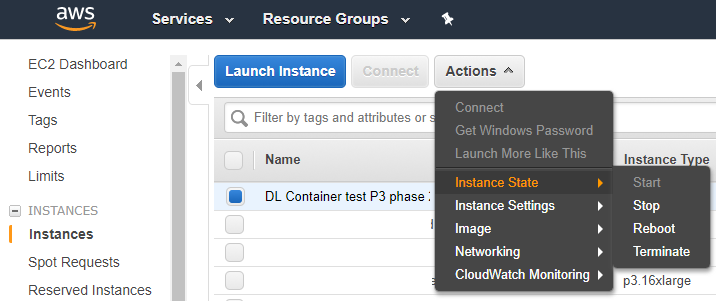

可以使用“操作”->“实例状态”菜单从“实例”页面控制实例,以停止、启动或终止实例。

1.4. 通过 AWS CLI 创建 NGC 认证虚拟机

如果您计划使用 AWS CLI,则必须安装(Windows 用户:在 Windows Subsystem for Linux 内部)、更新到最新版本并配置 CLI。

这些说明中的一些 AWS CLI 代码片段使用了 jq,应将其安装在您将运行 AWS CLI 的计算机上。您可以将这些代码片段粘贴到您自己的 bash 脚本中,或在命令行中键入它们。

1.4.1. 设置环境变量

设置以下环境变量,这些变量可用于启动 VM 实例的命令中

安全组

安全组 ID 用作实例创建过程的一部分。创建后,可以在 AWS 控制台中查找组 ID,或者使用以下代码片段按名称检索组 ID,并将其存储在 $NVAWS_SG_ID 环境变量中。

NVAWS_SG_NAME='my-sg'

NVAWS_SG_ID=$(aws ec2 describe-security-groups --group-name "$NVAWS_SG_NAME" | jq .SecurityGroups[0].GroupId | sed 's/\"//g') && echo NVAWS_SG_ID=$NVAWS_SG_ID

镜像 ID

以下代码片段将列出当前的“NVIDIA 深度学习 AMI”镜像 ID,并将其存储在 $NVAWS_IMAGE_ID 环境变量中。

NVAWS_IMAGE_NAME='NVIDIA Deep Learning AMI'

NVAWS_IMAGE_ID=$(aws ec2 describe-images --filters "Name=name,Values=$NVAWS_IMAGE_NAME" | jq .Images[0].ImageId | sed 's/\"//g') && echo NVAWS_IMAGE_ID=$NVAWS_IMAGE_ID

其他环境变量

按照以下方式设置其他环境变量,使用您的信息

NVAWS_KEYNAME=my-key-pair

NVAWS_KEYPATH=~/.ssh/

NVAWS_REGION=us-west-2

NVAWS_INSTANCE_TYPE=p3.2xlarge

NVAWS_EBS_GB=32

NVAWS_NAME_TAG='My GPU'

请务必为您启动的每个实例设置唯一的 NVAWS_NAME_TAG。

1.4.2. 启动您的 VM 实例

启动实例并捕获生成的 JSON

NVAWS_LAUNCH_JSON=$(aws ec2 run-instances --image-id $NVAWS_IMAGE_ID \

--instance-type $NVAWS_INSTANCE_TYPE \

--region $NVAWS_REGION \

--key-name $NVAWS_KEYNAME \

--security-group-ids $NVAWS_SG_ID \

--block-device-mapping

"[{\"DeviceName\":\"/dev/sda1\",\"Ebs\":{\"VolumeSize\":$NVAWS_EBS_GB}}]" \

--tag-specifications

"ResourceType=instance,Tags=[{Key=Name,Value=$NVAWS_NAME_TAG}]")

NVAWS_INSTANCE_ID=$(echo $NVAWS_LAUNCH_JSON | jq .Instances[0].InstanceId | sed 's/\"//g') && echo NVAWS_INSTANCE_ID=$NVAWS_INSTANCE_ID

生成的实例 ID 存储在 NVAWS_INSTANCE_ID 环境变量中。

一旦机器可用,启动过程可能需要几分钟,并且可以在 AWS 控制台实例页面中或使用 CLI 监控启动过程,方法是使用

aws ec2 describe-instance-status --instance-id $NVAWS_INSTANCE_ID | jq '.InstanceStatuses[0].InstanceState.Name + " " + .InstanceStatuses[0].SystemStatus.Status'

一旦实例“正在运行并初始化”,您将能够使用以下命令获取公有 DNS 名称

NVAWS_DNS=$(aws ec2 describe-instances --instance-id $NVAWS_INSTANCE_ID | jq '.Reservations[0].Instances[0].PublicDnsName' | sed 's/\"//g') && \ echo NVAWS_DNS=$NVAWS_DNS

1.4.3. 连接到您的 VM 实例

在实例达到“正在运行正常”状态后不久,SSH 应该就可以工作了。

如果使用上面的 CLI 代码片段和环境变量启动,则 SSH 连接到您的实例的命令是

ssh -i $NVAWS_KEYPATH/$NVAWS_KEYNAME.pem ubuntu@$NVAWS_DNS

否则,请使用您的 .pem 密钥文件名和 AWS 控制台中的公有 DNS 名称进行连接

ssh -i my-key-pair.pem ubuntu@public-dns-name

如果这些 SSH 登录说明不起作用,请参阅 AWS 连接到您的 Linux 实例 文档以获取更多信息。

1.4.4. 启动/停止/终止您的 VM 实例

完成实例操作后,您可以停止(稍后重新启动)或终止(删除)它。有关更多信息,请参阅 AWS 文档中的 实例生命周期。

停止

aws ec2 stop-instances --instance-ids $NVAWS_INSTANCE_ID

启动

aws ec2 start-instances --instance-ids $NVAWS_INSTANCE_ID

终止

aws ec2 terminate-instances --instance-ids $NVAWS_INSTANCE_ID

1.5. AWS 虚拟机的持久数据存储

您可以从 AWS 控制台创建弹性块存储 (EBS)。EBS 用于持久数据存储,但是,EBS 不能在多个 VM 之间共享。要共享持久数据存储,您需要使用 EFS。

这些说明设置了通用型 SSD 卷类型。但是,您可以指定预配置 IOPS SSD 以获得更高的吞吐量,或者使用 mdadm 设置软件 RAID,以创建包含多个 EBS 卷的卷。

有关如何在本地磁盘上设置软件 RAID 的说明,请参阅 Amazon 文档 Linux 上的 RAID 配置。

EBS 在大多数提供 Amazon EC2 P3 或 G4 实例的区域都可用。

1.5.1. 创建 EBS

- 打开 EBS 卷控制台。

转到主 AWS 控制台,单击 EC2,然后根据需要从侧边菜单展开“弹性块存储”,并单击 卷。

- 单击 创建卷。

- 在“创建卷”页面上进行选择。

- 为卷类型选择 通用型 SSD (GP2)。

如果需要更高的吞吐量,请选择 预配置 IOPS SSD (IO1)。

- 指定卷大小和可用区。

- (可选)添加标签。

- 如果您正在处理公共数据集,则不需要加密。

- 不需要快照 ID。

- 为卷类型选择 通用型 SSD (GP2)。

- 查看选项,然后单击 创建卷。

1.5.2. 将 EBS 卷附加到 EC2 实例

- 创建 EBS 卷后,选择卷,然后选择“操作”->附加卷。

- 指定您的 EC2 实例 ID 以及设备名称的驱动器盘符(例如,sdf),然后单击 附加。

这将在您的 EC2 实例上创建一个

/dev/xvdf(或您选择的驱动器盘符)虚拟磁盘。您可以通过运行

lsblk命令来查看卷。~$ lsblk NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT xvda 202:0 0 128G 0 disk └─xvda1 202:1 0 128G 0 part / xvdf 202:16 0 250G 0 disk

- 在 EBS 卷上创建文件系统。

~# mkfs.ext4 /dev/xvdf mke2fs 1.42.13 (17-May-2015) Creating filesystem with 65536000 4k blocks and 16384000 inodes Filesystem UUID: b0e3dee3-bf86-4e69-9488-cf4d4b57b367 Superblock backups stored on blocks: 32768, 98304, 163840, 229376, 294912, 819200, 884736, 1605632, 2654208, 4096000, 7962624, 11239424, 20480000, 23887872 Allocating group tables: done Writing inode tables: done Creating journal (32768 blocks): done Writing superblocks and filesystem accounting information: done

- 将卷挂载到挂载目录。

~# mount /dev/xvdf /data

要使卷在每次实例停止并重新启动时自动挂载,请向

/etc/fstab添加一个条目。请参阅 Amazon 文档 使卷可供使用

1.5.3. 删除 EBS 卷

请注意,一旦删除 EBS,就无法撤消删除。

- 打开 EBS 卷控制台。

转到主 AWS 控制台,单击 EC2,然后根据需要从侧边菜单展开“弹性块存储”,并单击 卷。

- 选择您的 EBS。

- 从 EC2 实例分离卷。

选择“操作”->分离卷,然后在确认对话框中单击 是,分离。

- 删除存储卷。

选择“操作”->删除卷,然后在确认对话框中单击 是,删除。

1.5.4. 向 EBS 卷添加数据集

1.5.4.1. 将数据集上传到 EBS 卷

- 将 EBS 卷挂载到

/data。发出以下命令以执行一次性挂载。

sudo mkdir /data sudo mount /dev/xvdf /data sudo chmod 777 /data

- 将数据集复制到

/data中的 EBS 卷上。scp -i <.pem> -r local_dataset_dir/ ubuntu@<ec2-instance>:/data

1.5.4.2. 从 EFS 复制现有数据集

- 使用 EFS 存储 DNS 名称将 EFS 存储挂载到

/data。发出以下命令以执行一次性挂载。

sudo mkdir /efs sudo mount -t nfs4 -o \ nfsvers=4.1,rsize=1048576,wsize=1048576,hard,timeo=600,retrans=2 \ EFS-DNS-NAME:/ /efs sudo chmod 777 /efs sudo cp -r /efs/<dataset> to /data

- 将数据集从 EFS 复制到 EBS 卷。

sudo cp -r /efs/<dataset> to /data

1.5.5. 使用 AWS CLI 管理 EBS 卷

建议您使用 AWS 控制台进行 EBS 管理。如果您需要使用 CLI 管理 EBS 文件系统,NVIDIA 在 GitHub 上创建了可用的脚本,网址为 https://github.com/nvidia/ngc-examples。

这些脚本将允许您执行基本的 EBS 管理,并可以作为进一步自动化的基础。

NVIDIA 在 Amazon Web Service (AWS) 平台上提供了一个定制的 Amazon Machine Instance (AMI),该 AMI 针对最新一代 NVIDIA GPU(NVIDIA Volta™ GPU 和 NVIDIA Turing GPU)进行了优化。在配备 NVIDIA Volta 或 NVIDIA Turing GPU 的 AWS 实例上运行 NVIDIA® GPU Cloud 容器,可为深度学习、机器学习和 HPC 工作负载提供最佳的 NGC 容器性能。

有关设置和使用 AMI 的说明,包括有关使用以下功能的说明,请参阅 NGC AWS 设置指南:

-

自动登录到 NGC 容器注册表。

-

弹性块存储 (EBS) 挂载。

NVIDIA AI Enterprise AMI

信息

NVIDIA AI Enterprise 是一个安全、端到端、云原生的 AI 软件套件,使组织能够解决新的挑战,同时提高运营效率。它加速了数据科学管道,并简化了预测 AI 模型的开发、部署和管理,以自动化基本流程并从数据中快速获得洞察。它拥有广泛的全栈软件库,包括 AI 解决方案工作流程、框架、预训练模型和基础设施优化。全球企业支持和定期安全审查确保业务连续性,并确保 AI 项目成功并保持在正轨上。

借助 NVIDIA AI Enterprise,客户可以获得以下支持和访问权限

- NVIDIA AI 工作流程,预先打包的参考应用程序,包括 Helm Charts、Jupyter Notebooks 和文档,可快速实现联络中心智能虚拟助手、音频转录和网络安全数字指纹识别以检测异常的生产时间。仅当订阅 NVIDIA AI Enterprise 时可用。

- 用于 AI 可解释性的未加密预训练模型、理解模型权重和偏差,以及更快的调试和自定义。仅当订阅 NVIDIA AI Enterprise 时可用。

- 加速 AI 开发的框架和工具(PyTorch、TensorFlow、NVIDIA RAPIDS、TAO Toolkit、TensorRT 和 Triton Inference Server)。

- 特定于医疗保健的框架和应用程序,包括 NVIDIA Clara MONAI 和 NVIDIA Clara Parabricks。

- NVIDIA AI Enterprise 包括对 NGC 公共目录上发布的标记为“NVIDIA AI Enterprise Supported”的所有 NVIDIA AI 软件的支持。超过 50 个预训练模型、框架和开发工具。

- NVIDIA AI Enterprise Marketplace 产品还包括一个 AMI,该 AMI 为轻松访问上述 NVIDIA AI Enterprise 软件提供了标准、优化的运行时,并确保了云和本地基础设施之间的开发兼容性。一次开发,随处运行。

要了解有关 AWS 上的 NVIDIA AI Enterprise 的更多信息并获取私人定价,请填写 此处 的表格联系 NVIDIA。

要开始使用,请参阅 AWS Marketplace 上的 NVIDIA AI Enterprise 快速入门指南。

发行说明

版本 24.12.1-NVAIE 5.2

- Ubuntu Server 22.04 LTS (x86)

- NVIDIA vGPU 驱动程序 550.127.05

- Docker CE 27.4.0

- NVIDIA Container Toolkit 1.17.3-1

- AWS CLI(最新版本)

- Miniconda

- JupyterLab(最新版本)和核心 Jupyter 包

- NGC CLI 3.56.0

- Git、Python3 和 pip

版本 24.11.2-NVAIE 5.2

- Ubuntu Server 22.04 LTS (x86)

- NVIDIA vGPU 驱动程序 550.127.05

- Docker CE 27.3.1

- NVIDIA Container Toolkit 1.17.1-1

- AWS CLI(最新版本)

- Miniconda

- JupyterLab(最新版本)和核心 Jupyter 包

- NGC CLI 3.54.0

- Git、Python3 和 pip

版本 24.10.1-NVAIE 5.1

- Ubuntu Server 22.04 LTS (x86)

- NVIDIA vGPU 驱动程序 550.90.07

- Docker CE 27.3.1

- NVIDIA Container Toolkit 1.16.2-1

- AWS CLI(最新版本)

- Miniconda

- JupyterLab(最新版本)和核心 Jupyter 包

- NGC CLI 3.51.0

- Git、Python3 和 pip

版本 24.07.3-NVAIE 5.1

- Ubuntu Server 22.04 (x86)

- NVIDIA vGPU 驱动程序 550.90.07

- Docker-CE 26.1.4

- NVIDIA Container Toolkit 1.15.0-1

- 最新 AWS CLI

- Miniconda

- 最新 JupyterLab 和其他 Jupyter 核心包

- NGC CLI 3.43.0

- Git、Python3-PIP

版本 24.03-NVAIE 5.0

- Ubuntu Server 22.04 (x86)

- NVIDIA vGPU 驱动程序 550.54.14

- Docker-CE 26.0.0

- NVIDIA Container Toolkit 1.14.6-1

-

最新 AWS CLI

-

Miniconda

- 最新 JupyterLab 和其他 Jupyter 核心包

- NGC CLI 3.41.1

-

Git、Python3-PIP

版本 24.01-NVAIE 4.2

- Ubuntu Server 22.04 (x86)

- NVIDIA vGPU 驱动程序 535.154.05

- Docker-CE 25.0.3

- NVIDIA Container Toolkit 1.14.5-1

-

最新 AWS CLI

-

Miniconda

- 最新 JupyterLab 和其他 Jupyter 核心包

- NGC CLI 3.38

-

Git、Python3-PIP

版本 23.11-NVAIE 4.1

- Ubuntu Server 22.04 (x86)

- NVIDIA vGPU 驱动程序 535.129.03

- Docker-CE 24.0.7

- NVIDIA Container Toolkit 1.14.3-1

-

最新 AWS CLI

-

Miniconda

- 最新 JupyterLab 和其他 Jupyter 核心包

- NGC CLI 3.22.0

-

Git、Python3-PIP

版本 23.09.2-NVAIE 4.0

- Ubuntu Server 22.04

- NVIDIA AI Enterprise Catalog 访问脚本

- NVIDIA vGPU 驱动程序 535.54.03 (v16.0)

- Docker-CE 24.0.5

- NVIDIA Container Toolkit 1.13.5

-

NGC CLI 3.22.0

-

Miniconda

- JupyterLab(在 miniconda 中)

版本 23.04.0-NVAIE 3.1

- Ubuntu Server 20.04

- NVIDIA AI Enterprise Catalog 访问脚本

- NVIDIA vGPU 驱动程序 525.105.17

- Docker-CE 23.0.3

- NVIDIA Container Toolkit 1.13.0-1

- AWS CLI 2.11.14

- NGC CLI 3.20.0

- Miniconda 23.3.1

- JupyterLab(在 conda base env 中)3.5.3

- Git 2.25.1

NVIDIA Riva AMI

信息

NVIDIA® Riva 是一个 GPU 加速的软件开发工具包 (SDK),用于构建和部署完全可定制的实时多语言语音和翻译 AI 管道,包括自动语音识别 (ASR)、神经机器翻译 (NMT) 和文本转语音 (TTS)。Riva 提供世界一流、开箱即用、准确的转录和翻译以及引人入胜的专业声音。 它可以部署在本地、任何云环境、嵌入式系统和边缘。

借助 NVIDIA Riva,客户可以针对不同的语言、口音、领域、词汇和上下文进行自定义,以针对其用例实现最佳的准确性,以及所需的品牌声音和语调。与现有技术相比,它为数十万个输入流提供一致的体验,并具有更高的推理性能。为了加速构建基于语音 AI 的 AI 解决方案,Riva 为音频转录和智能虚拟助手提供预先打包的 AI 工作流程,其中包括预训练模型和资源,例如 Helm Charts、Jupyter Notebooks 和文档。

Riva 是 NVIDIA AI Enterprise 软件平台的高级版本,对于 NVIDIA A100 等高性能 GPU,每 GPU 小时收费 60 美元。联系 NVIDIA 以获取替代 GPU 选项或私人报价的特别定价。

发行说明

版本 24.05

- Ubuntu Server 22.04 (x86)

- NVIDIA GRID 驱动程序 550.54.14 (vGPU 17.0)

- Docker-ce 26.1.1

- NVIDIA Container Toolkit 1.15.0-1

- 最新 AWS CLI

- 最新 Miniconda 和 JupyterLab

- NGC CLI 3.41.4

版本 2023.06.2-riva

- Ubuntu Server 22.04

- NVIDIA vGPU 驱动程序 525.60.13

- Docker-ce 24.0.2

- NVIDIA Container Toolkit 1.11.0-1

- AWS CLI

- NGC CLI 3.22.0

- Miniconda 23.5.0

- JupyterLab(在 conda base env 中)34.0.2

- Git 2.34.1

NVIDIA GPU 优化 AMI

信息

NVIDIA GPU 优化 AMI 是一个虚拟机镜像,用于加速您的机器学习、深度学习、数据科学和 HPC 工作负载。使用此 AMI,您可以在几分钟内启动一个 GPU 加速的 EC2 VM 实例,其中预装了 Ubuntu 操作系统、GPU 驱动程序、Docker 和 NVIDIA 容器工具包。

此外,此 AMI 还提供了对 NVIDIA NGC Catalog 的轻松访问,NGC Catalog 是一个 GPU 优化软件中心,用于提取和运行性能调整、测试和 NVIDIA 认证的 docker 容器。NGC 提供对容器化的 AI、数据科学和 HPC 应用程序、预训练模型、AI SDK 和其他资源的免费访问,使数据科学家、开发人员和研究人员能够专注于构建解决方案、收集见解和交付业务价值。

此 GPU 优化 AMI 免费提供给开发人员,并提供企业支持选项。有关企业支持的更多信息,请访问 NVIDIA AI Enterprise。

发行说明

版本 24.10.1

- Ubuntu Server 22.04 LTS (x86)

- NVIDIA TRD 驱动程序 550.127.05

- Docker CE 27.3.1

- NVIDIA Container Toolkit 1.16.2-1

- AWS CLI(最新版本)

- Miniconda(最新版本)

- JupyterLab(最新版本)和核心 Jupyter 包

- NGC CLI 3.53.0

- Git、Python3 和 pip

已知问题

- 以

root用户身份登录将阻止 NVIDIA 驱动程序完全安装。作为一种解决方法,请以ubuntu或任何其他非 root 用户身份登录。

版本 24.05

- Ubuntu Server 22.04 (x86)

- NVIDIA TRD 驱动程序 550.54.15

- Docker-ce 26.1.2

- NVIDIA Container Toolkit 1.15.0

- 最新 AWS CLI

- Miniconda

- 最新 JupyterLab 和其他 Jupyter 核心包

- NGC CLI 3.41.4

- Git、Python3-PIP

版本 24.03.4

- Ubuntu Server 22.04 (x86)

- NVIDIA TRD 驱动程序 535.161.07

- Docker-ce 26.0.0

- NVIDIA Container Toolkit 1.14.6

- 最新 AWS CLI

- Miniconda

- 最新 JupyterLab 和其他 Jupyter 核心包

- NGC CLI 3.40.0

- Git、Python3-PIP

版本 23.09.1

- Ubuntu Server 22.04 (x86)

- NVIDIA TRD 驱动程序 535.54.03

- Docker-ce 24.0.6

- NVIDIA Container Toolkit 1.13.5

- 最新 AWS CLI

- Miniconda

- 最新 JupyterLab 和其他 Jupyter 核心包

- NGC CLI 3.22.0

- Git、Python3-PIP

版本 23.03.0

- Ubuntu Server 20.04

- NVIDIA 驱动程序 525.85.12

- Docker-ce 23.0.1

- NVIDIA Container Toolkit 1.21.1-1

- AWS 命令行界面 (CLI)、NGC-CLI 3.16.0

- Miniconda 23.1.0

- JupyterLab 和其他 Jupyter 核心包

- Git、Python3-PIP

主要变更

- 更新 NVIDIA 驱动程序至 525.85.12

- 更新 Docker-ce 至 23.0.1

- 更新 Nvidia Container Toolkit 至版本 1.12.1-1

- 更新 Miniconda、JupyterLab、NGC-CLI、Git、Python3-PIP 至最新版本

版本 22.06.0

- Ubuntu Server 20.04

- NVIDIA 驱动程序 515.48.07

- Docker-ce 20.10.17

- NVIDIA Container Toolkit 1.10.0-1

- NVIDIA Container Runtime 3.10.0-1

- AWS 命令行界面 (CLI)

- Miniconda 4.13.0

- JupyterLab 3.4.3 和其他 Jupyter 核心包

- NGC-CLI 3.0.0

- Git、Python3-PIP

主要变更

- 更新 NVIDIA 驱动程序至 515.48.07

- 更新 Docker-ce 至 20.10.17

- 更新 Nvidia Container Toolkit 至版本 1.10.0-1

- 更新 Nvidia Container Runtime 至版本 3.10.0-1

- 打包了其他工具:Miniconda、JupyterLab、NGC-CLI、Git、Python3-PIP

NVIDIA HPC SDK GPU 优化 AMI

信息

NVIDIA HPC SDK 是一套全面的编译器、库和工具,对于最大限度地提高开发人员的工作效率以及 HPC 应用程序的性能和可移植性至关重要。

NVIDIA HPC SDK C、C++ 和 Fortran 编译器支持使用标准 C++ 和 Fortran、OpenACC 指令和 CUDA 对 HPC 建模和模拟应用程序进行 GPU 加速。GPU 加速的数学库最大限度地提高了常见 HPC 算法的性能,优化的通信库支持基于标准的多 GPU 和可扩展系统编程。性能分析和调试工具简化了 HPC 应用程序的移植和优化,容器化工具使本地或云中的轻松部署成为可能。适用于 Linux 的 NVIDIA HPC SDK 的主要功能包括:

- 支持 NVIDIA Ampere 架构 GPU,包括 FP16、TF32 和 FP64 张量核心

- NVC++ ISO C++17 编译器,在 GPU、OpenACC 和 OpenMP 上具有并行算法加速

- NVFORTRAN ISO Fortran 2003 编译器,在 GPU、CUDA Fortran、OpenACC 和 OpenMP 上具有数组内部函数加速

- NVC ISO C11 编译器,具有 OpenACC 和 OpenMP

- NVCC NVIDIA CUDA C++ 编译器

- NVIDIA 数学库,包括 cuBLAS、cuSOLVER、cuSPARSE、cuFFT、cuTENSOR 和 cuRAND

- Thrust、CUB 和 libcu++ GPU 加速的 C++ 并行算法和数据结构库

- NCCL、NVSHMEM 和 Open MPI 库,用于快速多 GPU/多节点通信

- NVIDIA Nsight Systems/Compute,用于交互式 HPC 应用程序性能分析器

发行说明

版本 23.11

- Ubuntu Server 22.04 (x86)

- NVIDIA 驱动程序 535.129.03

- Docker-ce 24.0.7

- NVIDIA Container Toolkit 版本:1.14.3-1

-

最新 AWS CLI

- 最新 Miniconda

- 最新 JupyterLab 和其他 Jupyter 核心包

-

NGC-CLI 3.35.0

- Git

- 更新 HPC SDK 23.11

版本 23.03.0

- Ubuntu Server 20.04

- NVIDIA 驱动程序 525.85.12

- Docker-ce 23.0.1

- NVIDIA Container Toolkit 版本:1.12.1-1

- AWS CLI、NGC-CLI 3.16.0

- 最新 Miniconda

- JupyterLab 和其他 Jupyter 核心包

- Git、Python3-PIP

- HPC SDK 23.1

- NVIDIA Peer Memory:1.3

- MOFED:5.8-1.0.1.1

主要变更

- 更新 NVIDIA 驱动程序至 525.85.12

- 更新 Docker-ce 至 23.0.1

- 更新 Nvidia Container Toolkit 至版本 1.12.1-1

- 更新 Nvidia Container Runtime 至版本 3.12.0-1

- 更新 NGC-CLI 至 3.16.0

- 更新 HPC SDK 至 23.1

版本 22.08.0

- Ubuntu Server 20.04

- NVIDIA 驱动程序 515.65.01

- Docker-ce 20.10.17

- NVIDIA Container Toolkit 版本:1.10.1-1

- NVIDIA Container Runtime 版本:3.10.0-1

- AWS 命令行界面 (CLI)

主要变更

- 更新 NVIDIA 驱动程序至 515.48.07

- 更新 Docker-ce 至 20.10.17

- 更新 NVIDIA Container Toolkit 至版本 1.10.0-1

- 更新 NVIDIA Container Runtime 至版本 3.10.0-1

已知问题

- 与 HPC SDK 22.7 捆绑在一起的 Nsight Systems 版本在某些实例类型上失败,并显示错误“Agent launcher failed”。该问题已在 Nsight Systems 版本 2022.3.4 及更高版本中修复,可以从 Nsight Systems 下载页面单独安装。有关更多信息,请参阅 Nsight Systems 文档。

版本 22.01.0

- Ubuntu Server 20.04

- NVIDIA 驱动程序 470.103.01

- Docker-ce 20.10.11

- NVIDIA Container Toolkit 1.7.0-1

- NVIDIA Container Runtime 3.7.0-1

- MOFED 版本:5.4-1.0.3.0

- NVIDIA Peer Memory 版本:1.2

- NVIDIA HPC SDK 版本:22.1

NVIDIA GPU 优化 AMI (ARM64)

信息

NVIDIA GPU 优化 AMI (ARM64) 是一个优化的环境,用于运行 NVIDIA NGC Catalog 中提供的深度学习、数据科学和 HPC 容器。NGC Catalog 上提供的 Docker 容器经过 NVIDIA 的调整、测试和认证,可以充分利用配备 ARM CPU 实例的 NVIDIA GPU。NGC Catalog 中的深度学习、数据科学和 HPC 容器需要此 AMI 才能在 AWS ARM64 GPU 实例上实现最佳 GPU 加速。

发行说明

版本 22.06.0

- Ubuntu Server 20.04

- NVIDIA 驱动程序 515.48.07

- Docker-ce 20.10.17

- NVIDIA Container Toolkit 1.10.0-1

- NVIDIA Container Runtime 3.10.0-1

- AWS 命令行界面 (CLI)

- Miniconda 4.13.0

- JupyterLab 3.4.3 和其他 Jupyter 核心包

- NGC CLI 3.0.0

- Git、Python3-PIP

主要变更

- 更新 NVIDIA 驱动程序至 515.48.07

- 更新 Docker-ce 至 20.10.17

- 更新 NVIDIA Container Toolkit 至版本 1.10.0-1

- 更新 NVIDIA Container Runtime 至版本 3.10.0-1

- 打包了其他工具:Miniconda、JupyterLab、NGC CLI、Git、Python3-PIP

版本 21.11.0

- Ubuntu Server 20.04

- NVIDIA 驱动程序 460.73.01

- Docker-ce 20.10.6

- NVIDIA Container Toolkit 1.5.0-1

- NVIDIA Container Runtime 3.5.0-1

NVIDIA Omniverse GPU 优化 AMI

信息

NVIDIA Omniverse 是一个用于构建自定义 3D 管道和运营大规模虚拟世界的平台。NVIDIA Omniverse GPU 优化 AMI 是一个虚拟机镜像,经过优化,可以运行 NVIDIA Omniverse 3D 图形和模拟工作负载,包括

- Omniverse Farm,用于在云实例中扩展 3D 和模拟计算

- Omniverse Replicator,用于 3D 合成数据生成

- NVIDIA Isaac Sim,用于训练和模拟自主机器

使用此 AMI,您可以在几分钟内启动一个 GPU 加速的 EC2 实例,其中预装了 Ubuntu 操作系统、GPU 驱动程序、X11、Docker 和 NVIDIA 容器工具包。

此 AMI 经过优化,可用于提取和运行性能调整、测试和 Omniverse docker 容器。NGC 目录提供对容器化的 AI、数据科学、模拟和 HPC 应用程序、预训练模型、AI SDK 和其他资源的免费访问,使数据科学家、开发人员、机器人专家和研究人员能够专注于构建和部署解决方案。

发行说明

版本 1.3.4

- Ubuntu Server 操作系统:20.04.5 LTS

- NVIDIA 驱动程序:470.141.03

- Docker CE:20.10.18

- NVIDIA Container Toolkit:2.11.0-1

- X11:1:7.7+19ubuntu14

NVIDIA Cloud Native Stack AMI

信息

NVIDIA Cloud Native Stack AMI 是一个 GPU 加速的 AMI,预装了 Cloud Native Stack,Cloud Native Stack 是一个参考架构,包括上游 Kubernetes 和 NVIDIA GPU 和网络 Operator。NVIDIA Cloud Native Stack AMI 允许开发人员构建、测试和运行由 Kubernetes 编排的 GPU 加速容器化应用程序。

发行说明

版本 6.2

- Ubuntu Server 20.04

- Containerd 1.6.5

- Kubernetes 1.23.8

- Helm 3.8.2

- GPU Operator 1.11.0

- NVIDIA 驱动程序 515.65.01

NVIDIA cuQuantum Appliance AMI

信息

NVIDIA cuQuantum Appliance 是一个高性能多 GPU 多节点解决方案,用于量子电路模拟。它包含 NVIDIA cuStateVec 和 cuTensorNet 库,这些库分别优化状态向量和张量网络模拟。cuTensorNet 库功能可通过 Python 用于张量网络操作。NVIDIA 通过 cuStateVec 库提供以下模拟器

- IBM Qiskit Aer 前端,通过 cusvaer,NVIDIA 分布式状态向量后端求解器。

- 多 GPU 优化 Google Cirq 前端,通过 qsim,Google 状态向量模拟器。

发行说明

版本 23.03

- Ubuntu Server 22.04

- NVIDIA 驱动程序 525.105.17

- NVIDIA cuQuantum Appliance Docker 容器 23.03

- Docker-ce 24.0.1

- NVIDIA Container Toolkit 1.13.0-1

- AWS CLI、NGC CLI

- Miniconda、JupyterLab(在 conda base env 中)、Git:最新

版本 22.11

- Ubuntu Server 20.04

- NVIDIA 驱动程序 525.85.12

- NVIDIA cuQuantum Appliance Docker 容器 22.11

- Docker-ce 23.0.1

- NVIDIA Container Toolkit 1.12.0-1

- AWS CLI、NGC CLI

- Miniconda、JupyterLab(在 conda base env 中)、Git:最新

已知问题

- Azure 上的一些实例(特别是 ND40rs v2)可能会在登录时发出“不支持的实例类型”警告。这是一个已知问题,将在下一个版本中解决。

NVIDIA GPU 优化 AMI 默认包含 conda,以便使用 jupyter-lab notebook。内部 Python 依赖项可能会在新版本的 Python 中进行修补,但 conda 必须使用 AMI 中的特定版本。除非 conda 本身存在漏洞,否则这些漏洞不会被直接利用。攻击者需要获得对运行 conda 的虚拟机的访问权限,因此必须保护虚拟机访问。请参阅安全最佳实践部分。

以下版本受漏洞影响

- NVIDIA GPU-Optimized AMI 22.06

- NVIDIA GPU-Optimized AMI (ARM64) 22.06

漏洞列表如下

- GHSA-3gh2-xw74-jmcw:高危;Django 2.1;SQL 注入

- GHSA-6r97-cj55-9hrq:严重;Django 2.1;SQL 注入

- GHSA-c4qh-4vgv-qc6g:高危;Django 2.1;不受控制的资源消耗

- GHSA-h5jv-4p7w-64jg:高危;Django 2.1;不受控制的资源消耗

- GHSA-hmr4-m2h5-33qx:严重;Django 2.1;SQL 注入

- GHSA-v6rh-hp5x-86rv:高危;Django 2.1;访问控制绕过

- GHSA-v9qg-3j8p-r63v:高危;Django 2.1;不受控制的递归

- GHSA-vfq6-hq5r-27r6:严重;Django 2.1;通过密码重置表单劫持帐户

- GHSA-wh4h-v3f2-r2pp:高危;Django 2.1;不受控制的内存消耗

- GHSA-32gv-6cf3-wcmq:严重;Twisted 18.7.0;HTTP/2 DoS 攻击

- GHSA-65rm-h285-5cc5:高危;Twisted 18.7.0;不正确的证书验证

- GHSA-92x2-jw7w-xvvx:高危;Twisted 18.7.0;Cookie 和标头泄露

- GHSA-c2jg-hw38-jrqq:高危;Twisted 18.7.0;HTTP 请求走私

- GHSA-h96w-mmrf-2h6v:严重;Twisted 18.7.0;不正确的输入验证

- GHSA-p5xh-vx83-mxcj:严重;Twisted 18.7.0;HTTP 请求走私

- GHSA-5545-2q6w-2gh6:高危;numpy 1.15.1;NULL 指针解引用

- CVE-2019-6446:严重;numpy 1.15.1;反序列化不受信任的数据

- GHSA-h4m5-qpfp-3mpv:高危;Babel 2.6.0;任意代码执行

- GHSA-ffqj-6fqr-9h24:高危;PyJWT 1.6.4;通过非黑名单公钥格式造成的密钥混淆

- GHSA-h7wm-ph43-c39p:高危;Scrapy 1.5.1;不受控制的内存消耗

- CVE-2022-39286:高危;jupyter_core 4.11.2;任意代码执行

- GHSA-55x5-fj6c-h6m8:高危;lxml 4.2.4;允许通过 lxml HTML 清理器的恶意代码

- GHSA-wrxv-2j5q-m38w:高危;lxml 4.2.4;NULL 指针解引用

- GHSA-gpvv-69j7-gwj8:高危;pip 8.1.2;路径遍历

- GHSA-hj5v-574p-mj7c:高危;py 1.6.0;正则表达式 DoS

- GHSA-x84v-xcm2-53pg:高危;requests 2.19.1;受保护凭据不足

- GHSA-mh33-7rrq-662w:高危;urllib3 1.23;不正确的证书验证

- CVE-2021-33503:高危;urllib3 1.23;拒绝服务攻击

- GHSA-2m34-jcjv-45xf:中危;Django 2.1;Django 中的 XSS

- GHSA-337x-4q8g-prc5:中危;Django 2.1;不正确的输入验证

- GHSA-68w8-qjq3-2gfm:中危;Django 2.1;路径遍历

- GHSA-6c7v-2f49-8h26:中危;Django 2.1;敏感信息的明文传输

- GHSA-6mx3-3vqg-hpp2:中危;Django 2.1;Django 允许非特权用户读取任意帐户的密码哈希值

- GHSA-7rp2-fm2h-wchj:中危;Django 2.1;Django 中的 XSS

- GHSA-hvmf-r92r-27hr:中危;Django 2.1;Django 允许意外的模型编辑

- GHSA-wpjr-j57x-wxfw:中危;Django 2.1;Django 中由于缓存键冲突导致的数据泄露

- GHSA-9x8m-2xpf-crp3:中危;Scrapy 1.5.1;使用 HTTP 代理时泄露凭据

- GHSA-cjvr-mfj7-j4j8:中危;Scrapy 1.5.1;不正确的授权和信息泄露

- GHSA-jwqp-28gf-p498:中危;Scrapy 1.5.1;凭据泄露

- GHSA-mfjm-vh54-3f96:中危;Scrapy 1.5.1;Cookie 设置未受限制

- GHSA-6cc5-2vg4-cc7m:中危;Twisted 18.7.0;在 URI/方法中注入无效字符

- GHSA-8r99-h8j2-rw64:中危;Twisted 18.7.0;HTTP 请求走私

- GHSA-vg46-2rrj-3647:中危;Twisted 18.7.0;NameVirtualHost 主机头注入

- GHSA-39hc-v87j-747x:中危;cryptography 37.0.2;cryptography wheels 中包含易受攻击的 OpenSSL

- GHSA-hggm-jpg3-v476:中危;cryptography 2.3.1;RSA 解密易受 Bleichenbacher timing 漏洞攻击

- GHSA-jq4v-f5q6-mjqq:中危;lxml 4.2.4;XSS

- GHSA-pgww-xf46-h92r:中危;lxml 4.2.4;XSS

- GHSA-xp26-p53h-6h2p:中危;lxml 4.2.4;LXML 中网页生成期间输入未正确中和

- GHSA-6p56-wp2h-9hxr:中危;numpy 1.15.1;NumPy 缓冲区溢出,极不可能被非特权用户利用

- GHSA-f7c7-j99h-c22f:中危;numpy 1.15.1;NumPy 中未检查输入大小的缓冲区复制

- GHSA-fpfv-jqm9-f5jm:中危;numpy 1.15.1;NumPy 中不正确的比较

- GHSA-5xp3-jfq3-5q8x:中危;pip 8.1.2;pip 中不正确的输入验证

- GHSA-w596-4wvx-j9j6:中危;py 1.6.0;与 subversion 一起使用时 py 库中的 ReDoS

- GHSA-hwfp-hg2m-9vr2:中危;pywin32 223;pywin32 中的整数溢出

- GHSA-r64q-w8jr-g9qp:中危;urllib3 1.23;CRLF 序列未正确中和

- GHSA-wqvq-5m8c-6g24:中危;urllib3 1.23;CRLF 注入

声明

本指南中的信息以及本指南中引用的 NVIDIA 文档中的所有其他信息均按“原样”提供。NVIDIA 对产品信息不作任何明示、暗示、法定或其他方面的保证,并且明确否认所有关于不侵权、适销性和特定用途适用性的暗示保证。尽管客户可能因任何原因遭受任何损失,但 NVIDIA 对本指南中描述的产品的累计总责任应根据 NVIDIA 产品销售条款和条件的规定进行限制。

本指南中描述的 NVIDIA 产品并非容错产品,并非设计、制造或旨在用于与任何系统的设计、建造、维护和/或操作相关的用途,在这些系统中,此类系统的使用或故障可能会导致威胁人类生命安全或严重人身伤害或财产损失的情况(包括但不限于在任何核设施、航空电子设备、生命支持或其他生命攸关的应用中使用)。NVIDIA 明确否认对此类高风险用途的任何明示或暗示的适用性保证。对于因任何此类高风险用途而引起的索赔或损害,NVIDIA 不对客户或任何第三方承担全部或部分责任。

NVIDIA 不保证或声明本指南中描述的产品在未经进一步测试或修改的情况下适用于任何特定用途。NVIDIA 不一定会对每种产品的全部参数进行测试。客户全权负责确保产品适合并适用于客户计划的应用,并为该应用进行必要的测试,以避免应用或产品出现故障。客户产品设计的缺陷可能会影响 NVIDIA 产品的质量和可靠性,并可能导致超出本指南中包含的附加或不同的条件和/或要求。对于因以下原因引起或归因于以下原因的任何故障、损坏、成本或问题,NVIDIA 不承担任何责任:(i)以任何违反本指南的方式使用 NVIDIA 产品,或(ii)客户产品设计。

除客户有权将本指南中的信息用于产品外,NVIDIA 在本指南下未授予任何其他明示或暗示的许可。仅当复制获得 NVIDIA 书面批准、未经改动地复制并附带所有相关的条件、限制和声明时,才允许复制本指南中的信息。

商标

NVIDIA 和 NVIDIA 徽标是 NVIDIA Corporation 在美国和其他国家/地区的商标和/或注册商标。其他公司和产品名称可能是与其相关的各自公司的商标。

版权

© 2025 NVIDIA CORPORATION 及附属公司。保留所有权利。