运行客户流失基准测试

使用左侧菜单链接连接到系统控制台。

连接到 sparkrunner pod。

kubectl exec --stdin --tty sparkrunner-0 -- /bin/bash

cd 到 /home/spark/spark-scripts 并在系统控制台中执行

/home/spark/spark-scripts/lp-runjupyter-etl-gpu.sh或/home/spark/spark-scripts/lp-runjupyter-etl-cpu.sh。在左侧菜单中打开 Desktop 链接,然后单击 VNC 连接按钮。

在 Linux 桌面中打开 Web 浏览器。

浏览到 172.16.0.10:30002。

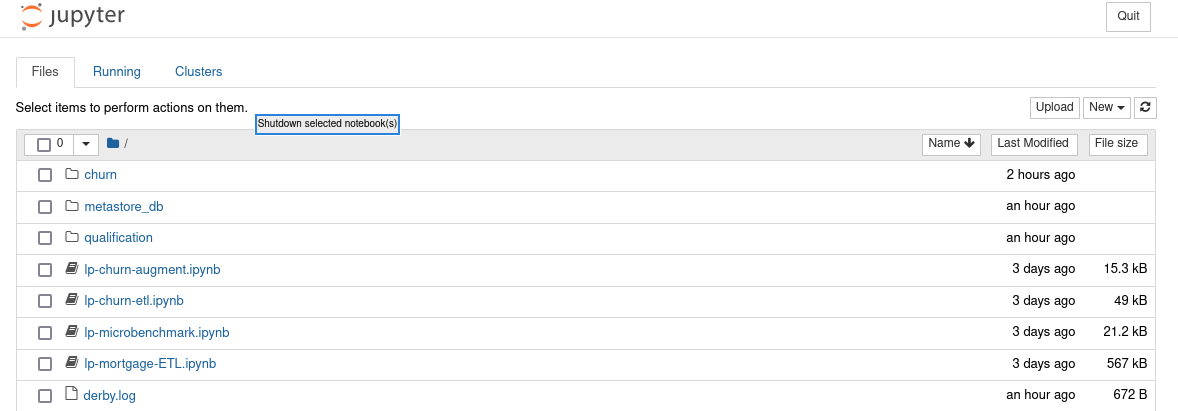

您应该看到上面的列表。

创建数据集以用于 ETL 作业。

打开另一个系统控制台并运行以下命令。

cd `mount | awk -F ':' '/spark-rapids-claim/ {print $2}'|grep var | awk '{print $1}'` mkdir -p churn/input mkdir -p churn/output chmod 777 churn/*

在正在运行的容器中打开一个 bash 会话。

kubectl exec --stdin --tty sparkrunner-0 -- /bin/bash

复制种子文件。

cp /home/spark/WA_Fn-UseC_-Telco-Customer-Churn-.csv /data/churn/input exit

单击

lp-churn-augment.ipynb链接以启动 Jupyter notebook。 注意

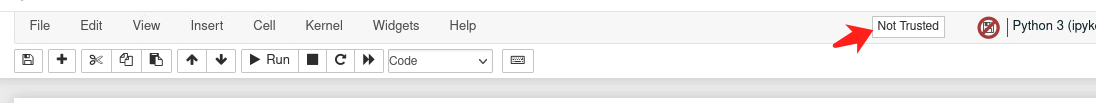

注意请在运行 notebook 之前“信任”它。

使用以下命令验证客户流失基准测试 pod 的创建

打开另一个系统控制台。

kubectl get pods | grep app-name

输出应与此类似。

app-name-79d837808b2d2ba5-exec-1 1/1 Running 0 31m app-name-79d837808b2d2ba5-exec-2 1/1 Running 0 31m app-name-79d837808b2d2ba5-exec-3 1/1 Running 0 31m

如果您看到您的 pod 处于 PENDING 状态,则表示之前的 pod 未正确关闭。您可以使用以下命令删除这些 pod

kubectl delete pod app-name-XXXX

通过单击 Cell -> Run All 运行 notebook。

确认客户流失数据集的创建。

查看 notebook 的输出。

在系统控制台中运行(应看到大约 21G 的数据)。

du -h --max-depth=1

单击

lp-churn-etl.ipynb链接以启动 Jupyter notebook。通过单击 Cell -> Run All 运行 notebook

记下基准测试的计时,以便您可以与 CPU 运行时间进行比较。

通过在启动 notebook 的系统控制台窗口中按 ctrl-c 来停止您在步骤 1 中启动的 notebook。当询问您是否要“关闭此 notebook 服务器?”时,回答 Y。

仅使用 CPU 运行相同的客户流失基准测试。

执行

lp-runjupyter-etl-cpu.sh脚本。

比较两个输出之间的差异。

您必须关闭 notebook 选项卡,然后关闭 notebook 才能开始另一个会话。如果未完成此操作,您将无法启动另一个 Spark 会话。