NVIDIA 认证系统配置指南

本 PCIe 服务器系统配置指南为集成 Ampere GPU 架构的 NVIDIA® PCIe 外形规格图形处理器 (GPU) 的服务器设计提供服务器拓扑和系统配置建议。(NVIDIA HGX™ 系统配置在 NVIDIA HGX 专用资料中介绍。)

最佳 PCIe 服务器配置取决于该服务器的目标工作负载(或应用程序)。虽然在某些情况下,服务器设计可以针对特定用例或目标工作负载进行优化,但一般来说,GPU 服务器可以配置为执行以下类型的应用程序或目标工作负载:

- 大型语言模型 (LLM)

- 自然语言识别 (NLR)

- Omniverse 应用

- 推理和智能视频分析 (IVA)

- 深度学习 (DL) 训练 / AI

- 高性能计算 (HPC)

- 空中边缘 AI 和 5G vRAN

- 云游戏

- 渲染和虚拟工作站

- 虚拟桌面基础设施 (VDI)

- 虚拟工作站 (vWS)

- 转码

本系统配置指南为推理、IVA、DL 训练、转码、虚拟桌面/工作站和 HPC 应用提供系统设计建议。本章列出的其他目标工作负载将在单独的文档中讨论。

1.1. NVIDIA 认证系统

符合本设计指南中建议的服务器应提交进行测试,作为 NVIDIA 认证系统™。NVIDIA 认证涵盖单节点和多节点配置。有关该计划的更多详细信息,请查阅 NVIDIA 认证系统文档。

1.2. 参考资料

以下公共 GPU 文档可供最终客户使用

1.3. 初步讨论要点

这些讨论要点概述了销售和最终客户之间解决方案的架构考虑因素。它们不是 NVIDIA 认证系统认证测试所必需的,而是作为特定配置和深入设计探讨的对话启动器。

1.3.1. 应用考虑因素

1.3.1.1. 工作负载类型

通常,您可以配置 GPU 服务器以执行许多不同的工作负载。一些示例包括

- 人工智能

- 推理

- NVIDIA TensorRT-LLM(大型语言模型)

- NVIDIA Triton

- DeepStream 智能视频分析 (IVA)

-

自然语言识别 (NLR)

- 训练

- 大型语言模型训练 (LLM)

- 自然语言处理 (NLP)

- 推荐系统训练

- 深度学习 (DL) 训练 / AI

- 计算机视觉训练

- 高性能计算 (HPC)

- RAPIDS

- TensorFlow

- ResNet

- HPC-SDK

- Spark

- 推理

- Omniverse 和可视化

- Blender

- V-Ray

- Octane

- Redshift

- OGL

- 渲染

- 模拟

- 3D 设计协作

- 虚拟桌面基础设施

许多工作负载可以利用 NVIDIA NeMo™,这是一个端到端的云原生企业框架,供开发人员构建、定制和部署具有数十亿参数的生成式 AI 模型。有关更多信息,请参阅 Nemo 生成式 AI 框架 - 入门 | NVIDIA 开发者。

1.3.1.2. 工作负载规模

您的应用程序工作负载、数据集、模型和特定用例的大小将影响您的硬件选择和部署考虑因素。本指南仅提供选项概述作为起点。《NVIDIA AI Enterprise 规模指南》中提供了其他集群规模概述。请与您的提供商讨论具体要求,以确保您的解决方案满足您的业务需求。

1.3.2. GPU 可扩展性考虑因素

1.3.2.1. 单 GPU

应用程序或工作负载可以访问整个 GPU。

1.3.2.2. 多实例 GPU 分区

某些 GPU 可以作为单个单元运行,也可以分区为多个虚拟 GPU 以支持多个并行线程。最直接的示例是在虚拟桌面基础设施部署期间,单个服务器可以使用单个 GPU 运行多个虚拟化工作站。如果需要,其他工作负载也可以利用这一点,只要考虑到性能方面的权衡即可。

1.3.2.3. 多 GPU

在单个服务器中拥有多个 GPU 可以实现更大范围的硬件加速。根据您的需求,这些 GPU 可以是支持 MIG 的,在多个工作负载之间共享,或者专用于该服务器中的高性能计算工作负载。应用程序或工作负载可以访问整个 GPU。

1.3.2.4. 单节点工作负载

单节点工作负载是一种部署模式,旨在能够在单个服务器或工作站中分配资源。这可能意味着在单个服务器上进行训练或推理,使用整个系统,或者对 GPU 进行分区以在同一节点内运行多个应用程序。可能有升级资源的选项,例如在该服务器中添加额外的 GPU、CPU 或内存,但这些解决方案通常无法扩展到集群级别。单节点部署不需要高速网络来连接多个节点以进行 AI 工作负载。

1.3.2.5. 集群工作负载

工作负载集群是一种应用程序部署模式,旨在能够在多个服务器之间分配额外的资源。这意味着多个节点通过高速网络(InfiniBand 或 RoCE)或通过 NVLink 和 NVSwitch 连接,以允许工作负载在集群中的多个节点之间扩展资源。与您的应用程序工作负载如何在单个 GPU、MIG 分区或单个服务器上的多个 GPU 上处理线程的考虑因素类似,您的工作负载也可以跨多个服务器、多个位置的多个 GPU 进行处理,以运行最复杂的高性能工作负载。

本系统配置指南提供高级设计建议。其他目标工作负载将在单独的文档中讨论。您的个人需求和约束可能需要额外考虑。

1.3.3. 部署考虑因素

AI 工作负载可以部署在多个位置,具体取决于应用程序和用例的需求。您的用例的具体要求将有助于指导您的硬件需求。以下部分描述了示例位置。

1.3.3.1. 数据中心

数据中心 (DC) 包含标准 IT 基础设施位置。这些通常包括部署到机架中的服务器,以及连接行内多个机架的架顶交换机 (TOR)。行采用冷热通道布局,为硬件提供服务。

1.3.3.2. 边缘

边缘是一个非常广泛的术语,但您可以将其视为任何非标准数据中心的位置。它可以位于零售场所的后台、手机信号塔或制造现场。您甚至可以拥有基于边缘的数据中心。一般来说,边缘指的是未连接到您组织骨干网络基础设施的位置。边缘系统有两种类型,每种类型都有其独特的特征

- 企业边缘

- 工业边缘

以下部分将对此进行讨论。

1.3.3.3. 企业边缘

企业边缘位置涵盖非标准数据中心位置,并包括数据中心中发现的远程管理功能。通常,相同的服务器可以在标准数据中心或边缘位置找到。这些系统通常基于传统的企业服务器,并已针对边缘应用进行了调整。它们通常旨在用于温度受控的环境。

1.3.3.4. 工业边缘

工业边缘位置将涵盖传统上不存在非标准 DC 管理功能的应用,例如工厂车间或手机信号塔。部署到工业位置的系统往往具有更严格的热和冲击与振动测试,以处理 DC 中的标准服务器无法承受的一系列应用。这些系统是加固型工业 PC 或部署在现场或车辆上的其他专用设备。它们是专门为部署环境而设计的。

1.3.3.5. 工作站

工作站是您典型的台式机和笔记本电脑。

1.3.3.6. 台式工作站

这些是塔式系统,设计为仅移动几次。

1.3.3.7. 移动工作站

这些通常是基于笔记本电脑的系统,围绕移动性而设计。

1.3.4. 安全考虑因素

当您的加速工作负载扩展到传统数据中心之外时,安全性变得至关重要。具体的安全建议超出了本指南的范围,但以下功能已作为认证过程的一部分进行了验证。

1.3.4.1. 可信平台模块

NVIDIA 认证系统针对 TPM 2.0 模块进行了测试。TPM 是一项国际安全标准,允许平台完整性、磁盘加密以及系统识别和证明。

1.3.4.2. 统一可扩展固件接口

UEFI 是一项公共规范,取代了传统的基本输入/输出系统 (BIOS) 启动固件。NVIDIA 认证系统针对 UEFI 引导加载程序兼容性进行了测试。

1.3.5. 散热考虑因素

NVIDIA 认证系统经过认证和测试,可在 OEM 制造商的温度和气流规格范围内运行工作负载。

工业认证系统在 OEM 的最大支持温度下进行测试。

组件温度会影响工作负载性能,而工作负载性能又会受到环境、气流和硬件选择的影响。在构建解决方案以确保最佳性能时,请考虑这些变量。

有关特定模型阈值的更多信息,请查看“设计讨论”下的“GPU 散热”部分。

2.1. 推理系统配置

使用 NVIDIA GPU 可以极大地加速推理应用程序性能,其中包括以下工作负载:

- 大型语言模型推理

- 自然语言识别 (NLR)

-

Omniverse 应用

- DeepStream – GPU 加速智能视频分析 (IVA)

- NVIDIA® TensorRT™、Triton – 具有 GPU 加速的推理软件

专为执行推理工作负载而设计的 GPU 服务器可以部署在边缘或数据中心。每个服务器位置都有自己的一套环境和合规性要求。例如,边缘服务器可能需要符合 NEBS 标准,并具有更严格的散热和机械要求。

表 1 提供了使用 NVIDIA GPU 的推理服务器的系统配置要求。大型语言模型应以更高端的规格为目标。Omniverse 和可视化应用程序使用将需要 L40S/L40。| 参数 | 推理服务器配置 |

|---|---|

| GPU | L40S L40 L4 H100 H100 HGX |

| GPU 配置 | 每个服务器 2x / 4x / 8x GPU 建议使用 4x,以消除对 PCIe 交换机的需求。 GPU 应在 CPU 插槽和根端口之间保持平衡。 |

| CPU | 建议使用支持 x86 PCIe Gen5 的 CPU,例如 Intel Xeon 可扩展处理器(Sapphire Rapids)或 AMD Genoa。 |

| CPU 插槽 | 最少 2 个 CPU 插槽 |

| CPU 速度 | 最低 2.1 GHz 基本时钟 |

| CPU 核心 | 每个 GPU 6 个物理 CPU 核心 |

| 系统内存 | 最小为 GPU 总内存的 1.5 倍 / 建议为 2.0 倍。 均匀分布在所有 CPU 插槽和内存通道上。 |

| DPU | 每个服务器一个 Bluefield®-3 DPU |

| PCI Express | 建议每个 Gen5 GPU 至少一个 Gen5 x16 链路。 建议每个 Gen4 GPU 至少一个 Gen4 x16 链路。 对于 PCIe 交换机配置,建议每 2 个 GPU 至少一个 Gen5 x16 链路。 |

| PCIe 拓扑 | 为了实现平衡的 PCIe 架构,GPU 应均匀分布在 CPU 插槽和 PCIe 根端口之间。NIC 和 NVMe 驱动器应放置在与 GPU 相同的 PCIe 交换机或根联合体中。重要的是要注意,PCIe 交换机对于经济高效的推理服务器可能是可选的。 |

| PCIe 交换机 | 首选直接 CPU 连接。 根据需要使用 ConnectX®-7 Gen5 PCIE 交换机。 |

| 网络适配器 (NIC) | ConnectX®-7(高达 400 Gbps) NIC 模式下的 BlueField®-3 DPU(高达 400 Gbps)。 有关详细信息,请参阅“网络”部分。 |

| NIC 速度 | 每个 GPU 高达 400 Gbps 单节点推理的每个 GPU 至少 50 Gbps 多节点推理的至少 200 Gbps |

| 存储 | 每个 CPU 插槽一个 NVMe |

| 远程系统管理 | Redfish 1.0(或更高版本)兼容 |

| 安全 | TPM 2.0 模块(安全启动) |

2.2. 深度学习训练系统配置

深度学习 (DL) 训练应用程序性能通过使用 NVIDIA GPU 得到极大加速,其中包括以下工作负载

- NVIDIA TensorRT-LLM(大型语言模型训练)

- 推荐系统训练

- 自然语言处理训练

- 计算机视觉训练

针对训练工作负载优化的 GPU 服务器通常位于数据中心。每个数据中心或云服务提供商 (CSP) 可能有自己的环境和合规性标准,但这些标准往往不如 NEBS 或边缘服务器的要求严格。

表 2 提供了使用 NVIDIA GPU 的 DL 训练服务器的系统配置要求。| 参数 | 深度学习服务器配置 |

|---|---|

| NVIDIA GPU | L40S L40 H100 H100 NVL |

| GPU 配置 | 每个服务器 2x / 4x / 8x GPU GPU 在 CPU 插槽和根端口之间保持平衡。 有关详细信息,请参阅拓扑图。 |

| CPU | 建议使用 Gen5 CPU。 |

| CPU 插槽 | 最少 2 个 CPU 插槽 |

| CPU 速度 | 最低 2.1 GHz 基本时钟 |

| CPU 核心 | 每个 GPU 6 个物理 CPU 核心(最低) |

| 系统内存 | 最小为 GPU 总内存的 1.5 倍 / 建议为 2.0 倍。 均匀分布在所有 CPU 插槽和内存通道上。 |

| DPU | 每个服务器一个 BlueField-3 DPU |

| PCI Express | 每个最多两个 GPU 一个 Gen5 x16 链路; 建议每个 GPU 一个 Gen5 x16 链路 |

| PCIe 拓扑 | 平衡的 PCIe 拓扑,GPU 均匀分布在 CPU 插槽和 PCIe 根端口之间。NIC 和 NVMe 驱动器应与 GPU 位于同一 PCIe 交换机或 PCIe 根联合体下。有关详细信息,请参阅拓扑图。 |

| PCIe 交换机 | 根据需要使用 ConnectX®-7 Gen5 PCIE 交换机。 |

| 网络适配器 (NIC) | ConnectX®-7(高达 400 Gbps) 建议使用 NIC 模式下的 BlueField® -3 DPU(包括 400 Gbps NIC 和 PCIe 交换机)。 有关详细信息,请参阅“网络”部分。 |

| NIC 速度 | 高达 400 Gbps |

| 存储 | 每个 CPU 插槽一个 NVMe 驱动器 |

| 远程系统管理 | Redfish 1.0(或更高版本)兼容 |

| 安全 | TPM 2.0 模块(安全启动) |

2.3. 虚拟桌面基础设施系统配置

虚拟桌面基础设施 (VDI) 提供从数据中心机器提供的真正工作站体验。借助 VDI,IT 人员可以使最终用户在办公室、家庭或其他地方之间无缝切换。

NVIDIA L4 与 NVIDIA Virtual PC(或 vPC)软件配合使用,可实现面向未来的灵活工作环境。IT 人员可以提供与物理 PC 几乎没有区别的用户体验,即使是视频会议等富媒体应用程序也是如此。此外,IT 人员可以在几分钟内通过配置新的虚拟桌面来快速支持新用户。

每个用户的 VDI 工作负载可能会因应用程序的数量和类型、文件大小、监视器数量及其分辨率等因素而异。NVIDIA 建议测试特定的工作负载,以确定最适合您需求的 NVIDIA 虚拟 GPU (vGPU) 解决方案。最成功的客户部署始于概念验证 (POC),并在整个生命周期中不断优化。

针对 VDI 优化的 GPU 服务器通常位于数据中心。每个数据中心或云服务提供商 (CSP) 可能有自己的环境和合规性标准,但这些标准通常不如 NEBS 或边缘服务器的要求严格。

表 3 提供了使用 NVIDIA L4 PCIe 服务器卡的 VDI 服务器的系统配置要求。| 参数 | VDI 服务器配置 |

|---|---|

| NVIDIA GPU | A16 |

| GPU 配置 | 每个服务器 1x / 2x / 3x / 4x GPU GPU 在 CPU 插槽和根端口之间保持平衡。 有关详细信息,请参阅拓扑图。 |

| CPU | 建议使用 Gen5 CPU。 Gen4 CPU 是可以接受的 |

| CPU 插槽 | 1P / 2P |

| CPU 速度 | 最低 2.1 GHz 基本时钟 |

| CPU 核心 | 每个用户 2-4 个虚拟 CPU 核心(预期超额订阅) |

| 系统内存 | 每个用户 16 GB RAM |

| PCI Express | Gen4 / Gen5 |

| PCIe 拓扑 | 首选平衡的 PCIe 拓扑,GPU 均匀分布在 CPU 插槽和 PCIe 根端口之间。 |

| 驱动程序 | Virtual GPU 13.0 或更高版本(NVIDIA Virtual PC 许可证) |

| PCIe 交换机 | Broadcom PEX88000 Gen4 和 Microsemi PM40100 Gen4 PCIe 交换机 |

| 网络适配器 (NIC) | ConnectX-7 BlueField-3 ConnectX-6 LX ConnectX-6 ConnectX-4 LX 有关详细信息,请参阅“网络”部分。 |

| NIC 速度 | 高达 400 Gbps |

| 存储 | 每个用户 35 GB |

| 远程系统管理 | Redfish 1.0(或更高版本)兼容 |

| 安全 | TPM 2.0 模块(安全启动) |

2.4. 虚拟工作站系统配置

NVIDIA RTX™ 虚拟工作站 (vWS) 是专门的 NVIDIA 软件,使设计师和工程师能够更快地完成最苛刻的工作。借助 vWS,IT 部门可以虚拟化任何数据中心应用程序,从而获得与物理工作站几乎没有区别的体验。此功能使任何设备都能实现工作站性能。

vWS 用户分为“轻度使用”、“中度使用”和“重度使用”类别。轻度用户需要的图形内容较少,通常处理较小的模型尺寸。在入门级 vWS 情况下,IT 部门必须主要支持虚拟 PC 用户。但是,NVIDIA A16 也可以成为少量轻度虚拟工作站用户的经济实惠的解决方案。

对于需要高达最高性能并处理最大模型和数据集的中度到重度虚拟工作站用户,NVIDIA 建议使用 NVIDIA A40 PCIe 卡。

针对 vWS 服务优化的 GPU 服务器通常位于数据中心。每个数据中心或云服务提供商 (CSP) 可能有自己的环境和合规性标准,但与 NEBS 或边缘服务器的要求相比,这些标准通常不太严格。

表 4 提供了使用 NVIDIA A16 PCIe 服务器卡的 vWS 服务器的系统配置要求。| 参数 | 入门级 vWS 服务器配置 |

|---|---|

| NVIDIA GPU 产品 | A16 |

| GPU 配置 | 每个服务器 1x / 2x / 3x / 4x A16 卡 每个 CPU 插槽最多建议使用两张 L4 卡 有关详细信息,请参阅拓扑图 |

| CPU | 建议使用 Gen5 CPU。 Gen4 CPU 是可以接受的 |

| CPU 插槽 | 1P / 2P |

| CPU 速度 | 最低 2.8 GHz |

| CPU 核心 | 每个用户 4-6 个虚拟 CPU 核心(预期超额订阅) |

| 系统内存 | 每个用户 16 GB RAM |

| PCI Express | Gen4 / Gen5 |

| PCIe 拓扑 | 首选平衡的 PCIe 拓扑,GPU 均匀分布在 CPU 插槽和 PCIe 根端口之间。 |

| 驱动程序 | Virtual GPU 13.0 或更高版本(NVIDIA RTX vWS 许可证) |

| PCIe 交换机 | Broadcom PEX88000 Gen4 和 Microsemi PM40100 Gen4 PCIe 交换机 |

| 网络适配器 (NIC) | ConnectX-7 BlueField-3 ConnectX-6 LX ConnectX-6 ConnectX-4 LX 有关详细信息,请参阅“网络”部分。 |

| NIC 速度 | 高达 400 Gbps |

| 存储 | 每个用户 40 GB |

| 远程系统管理 | Redfish 1.0(或更高版本)兼容 |

| 安全 | TPM 2.0 模块(安全启动) |

2.5. 转码系统配置

分发给观看者的视频内容通常被转码为多种自适应比特率 (ABR) 配置文件以进行交付。制作中的内容可能以多种 CODEC 格式到达,必须将其转码为另一种格式以进行分发或存档。建议的系统配置用于压缩视频格式。

高质量视频应用程序的处理需求已推动广播和电信网络的限制。随着消费者从观看点播视频转向观看直播,直播 将推动蜂窝和 Wi-Fi 的整体视频数据流量增长。

NVIDIA GPU 原生包含一个片上硬件编码器和解码器单元(通常称为 NVENC 和 NVDEC)。NVENC 和 NVDEC 与 NVIDIA® CUDA® 核心分离,执行编码或解码工作负载,而不会同时减慢图形或 CUDA 工作负载的执行速度。

专为转码而设计的 GPU 服务器通常部署在数据中心。每个数据中心或云服务提供商 (CSP) 可能有自己的环境和合规性要求。但是,这些要求通常不如 NEBS 或边缘服务器要求严格。

表 5 提供了使用 NVIDIA A16 PCIe 服务器卡的转码服务器的系统配置要求。| 参数 | 转码服务器配置 |

|---|---|

| NVIDIA GPU 产品 | A16 |

| GPU 配置 | 每个服务器 1x / 2x / 3x / 4x A16 卡 每个 CPU 插槽最多建议使用两张 L4 卡 有关详细信息,请参阅拓扑图 |

| CPU | 建议使用 Gen5 CPU。 Gen4 CPU 是可以接受的 |

| CPU 插槽 | 1P / 2P |

| CPU 速度 | 最低 2.1 GHz |

| CPU 核心 | 每个 L4 PCIe 卡 4 个 CPU 核心 |

| 系统内存 | GPU 内存的 1.5 倍至 2 倍 |

| PCI Express | Gen4 / Gen5 |

| PCIe 拓扑 | 首选平衡的 PCIe 拓扑,GPU 均匀分布在 CPU 插槽和 PCIe 根端口之间。 |

| 驱动程序 | R470 TRD1 或更高版本 |

| PCIe 交换机 | Broadcom PEX88000 Gen4 和 Microsemi PM40100 Gen4 PCIe 交换机 |

| 网络适配器 (NIC) | ConnectX-7 BlueField-3 ConnectX-6 LX ConnectX-6 ConnectX-4 LX 有关详细信息,请参阅“网络”部分。 |

| NIC 速度 | 高达 400 Gbps |

| 存储 | 每个插槽一个 NVMe |

| 远程系统管理 | Redfish 1.0(或更高版本)兼容 |

| 安全 | TPM 2.0 模块(安全启动) |

2.6. 推理和深度学习训练拓扑图

本章显示了与表 1 和 表 2 中概述的推理和 DL 训练服务器相对应的系统配置,从最简单的配置到最复杂的配置。

请注意,某些服务器配置可能不需要 PCIe 交换机。例如,根据 CPU 可用的 PCIe 通道数量,每个插槽一个或两个 GPU 的服务器可能不需要 PCIe 交换机。

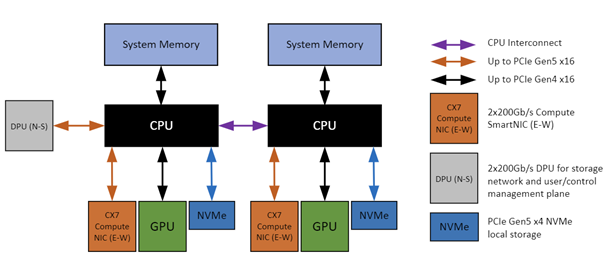

图 1. 具有两个 GPU 的 2P 服务器

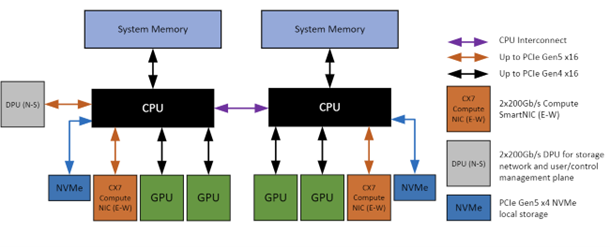

图 2. 具有四个 GPU 的 2P 服务器

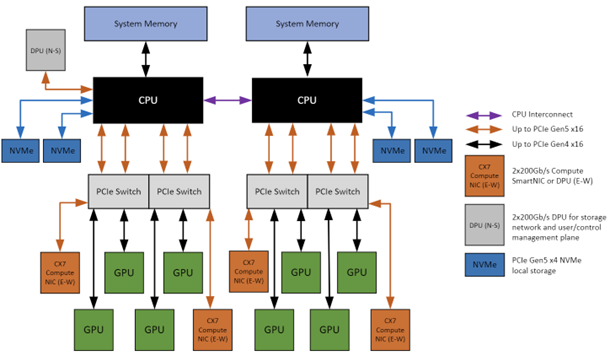

图 3. 具有八个 GPU 和 PCIe 交换机的 2P 服务器

本章讨论本设计指南中确定的 NVIDIA GPU 服务器卡的设计注意事项。在考虑 NVIDIA A16 PCIe 卡时,以下各节中的术语“GPU”是指一张 NVIDIA A16 PCIe 卡。

3.1. GPU

GPU 最好以 2 的幂(1、2、4 或 8 个 GPU)部署在服务器中,GPU 均匀分布在 CPU 插槽和根端口之间。平衡的 GPU 配置可实现最佳 GPU 应用程序性能,并避免 PCIe 和系统内存等关键接口中的性能瓶颈。

3.2. GPU 功耗

GPU 功耗要求取决于具体型号。有关更多信息和型号特定详细信息的链接,请参阅下表。确保您有适当的功率有助于确保 GPU 的最佳性能。请与您的供应商合作,根据 GPU 型号和系统中的任何其他组件正确调整 PSU 的大小。

3.3. GPU 散热

GPU 散热工作温度因型号而异。有关更多信息,请参阅下表。请注意,GPU 性能可能会受到温度的影响。气流受限或环境散热问题可能会影响您的工作负载。请与您的供应商合作,根据您的整个系统要求和设计进行适当的散热考虑。

| GPU | 典型工作负载 | 最大功耗 |

|---|---|---|

| L40S | 推理/训练 | 350 瓦 |

| L40 | 推理/训练 | 300 瓦 |

| L4 | 推理 | 72 瓦 |

| H100 HGX | 训练 | 每个 gpu 350 瓦 |

| H100 | 推理/训练 | 310-350 瓦1 |

- 功率瓦数可用性将因 OEM 布线实施而异。有关系统特定的详细信息,请咨询您的供应商。

3.4. CPU

允许单插槽 (1P) 或双插槽 (2P) 配置。CPU 的主要设计约束是选择每个 GPU 具有足够 CPU 核心的配置。建议每个 GPU 至少六个物理 CPU 核心。

CPU 配置(1P 或 2P)取决于服务器中使用的 GPU 数量以及 AMD 或 Intel 企业级 CPU 中可用的核心数量。1P 服务器设计通常用于边缘服务器应用。

如果您有兴趣设计具有 NVIDIA GPU 的 4P 服务器,可以联系 NVIDIA 寻求进一步帮助。

3.4.1. AMD PCIe 端口映射

如果服务器配置中未使用正确的 PCIe 端口,则使用 AMD CPU 的服务器可能会遇到 IO 性能问题。

使用 AMD Genoa CPU 时,获得最佳 IO 性能和设备到主机带宽的一般设计指南是

- 1P 中的 4 个 GPU – 使用端口 P0/P1/P2/P3

- 带有 PCIe 交换机的 2P 中的 4 个 GPU(具有 4G 链路的 4xGMI)– 使用端口 P0/P2

- 2P 中的 4 个 GPU(具有 4G 链路的 4xGMI)– 使用端口 P0/P2 或 P1/P3

- 2P 中的 4 个 GPU(具有 2G+2P 链路的 4xGMI – 使用端口 P0/P2 或 G1/G3

- 具有内联 GPU 的 2P 中的 8 个 GPU – 使用端口 P0/P1/P2/P3

- 带有 PCIE 交换机的 2P 中的 8 个 GPU(8 个根端口)– 使用端口 P0/P1 和 P2/P3

- 带有 PCIE 交换机的 2P 中的 8 个 GPU(具有 4G 链路的 4xGMI)– 使用端口 P0/P2 或 P1/P3

- 带有 PCIE 交换机的 2P 中的 8 个 GPU(具有 2G+2P 链路的 4xGMI)– 使用端口 P0/P2 或 G1/G3

早期 AMD CPU 代的端口映射是不同的。使用 AMD Rome 和 Milan CPU 时,获得最佳 IO 性能和设备到主机带宽的一般设计指南是

- 1P 中的 2 个 GPU – 使用 P0/P3 或 P1/P2

- 1P 中的 4 个 GPU – 使用端口 P0/P1/P2/P3

- 2P 中的 4 个 GPU – 在两个插槽上使用 P0/P3 或 P1/P2

- 2P 中的 8 个 GPU – 使用端口 P0/P1/P2/P3

3.5. 系统内存

系统内存总量应至少为 GPU 帧缓冲区内存总量的 1.5 倍。为了获得最佳 GPU 应用程序性能,最好至少为 2.0 倍。

例如,在具有四个 NVIDIA A100 80 GB GPU 的服务器中 – 每个 GPU 具有 80 GB 的帧缓冲区内存 – GPU 总内存为 320 GB。因此,系统内存总量应至少为 480 GB,最好为 640 GB。

系统内存应均匀分布在所有 CPU 插槽和内存通道上,以获得最佳性能。

3.5.1. 系统内存 ECC

请注意以下有关系统内存 ECC 的要求和指南

- 为了获得 NVIDIA 认证,所有数据中心和企业边缘系统都必须在系统内存上具有 ECC 功能。

- 对于 NVIDIA 认证目的,工业边缘系统的系统内存 ECC 功能是可选的。

- 在所有能够支持系统内存 ECC 的系统上,在 NVIDIA 认证测试期间必须启用系统内存 ECC。为了获得最佳用户体验,建议但不要求“启用系统内存 ECC”作为 NVIDIA 认证系统的默认配置。

3.6. PCIe 接口

本节详细介绍了 PCIe 接口,包括速度和通道宽度、拓扑和端口映射。

3.6.1. PCIe 速度和通道宽度

建议每个 GPU 使用 PCIe Gen5 x16 以获得最大吞吐量。

- 不同的 CPU 型号将支持不同的 PCIe 代数。根据您的 CPU 选择,每个 GPU 的 Gen4 或 Gen3 x16 连接是可以接受的。

- 也支持到 GPU 的 PCIe Gen5 或 Gen4 x8 链路。但是,对于某些应用程序,GPU 性能可能会受到影响。

| 版本 | 推出时间 | 每通道传输速率 | 吞吐量 | |

|---|---|---|---|---|

| x8 | x16 | |||

| 3.0 | 2010 | 2.0 | 5 GT/s | 3.938 GB/s |

| 4.0 | 2017 | 7.877 GB/s | 3.938 GB/s | 3.0 |

| 5.0 | 2019 | 8.0 GT/s | 3.0 | 7.877 GB/s |

15.754 GB/s

4.0

16.0 GT/s

- 15.754 GB/s

- 31.508 GB/s

- 5.0

32.0 GT/s

31.508 GB/s

63.015 GB/s

来源:维基百科| 3.6.2. PCIe 拓扑 | 对于安装了一个或两个 GPU 的服务器,可能不需要 PCIe 交换机来将 PCIe 设备(GPU、NIC 和 NVMe 驱动器)连接到主机 PCIe 根端口。对于 AMD Rome 和 Milan CPU 以及即将推出的 Intel Ice Lake CPU 尤其如此,它们都为设备连接提供了足够的 PCIe Gen4 通道。 |

|---|---|

| 一般来说,强烈建议将 GPU 分布在 CPU 插槽和根端口之间,以实现平衡配置。强烈建议每个 GPU 使用一个 Gen5 或 Gen4 x16 链路,以获得最佳性能。 | 随着 GPU 和其他 PCIe 设备数量的增加,对于更大、更高性能的服务器,可能需要 PCIe 交换机来提供足够的连接性。在这种情况下,PCIe 交换机层数应限制为一层或两层,以最大限度地减少 PCIe 延迟。 |

| 如果使用 PCIe 交换机,则最多两个 GPU 应共享一个上游 PCIe Gen 5 或 Gen4 x16 链路,以获得最佳性能。 | 3.6.3. AMD PCIe 端口映射 |

| 有关使用 AMD CPU 上的 PCIe 端口的具体建议,请参阅“AMD PCIe 端口映射”部分。 | 3.7. BIOS 设置和 ECC 应在您的系统上启用以下 BIOS 设置,以确保认证测试的最佳性能。在使用虚拟机 (VM) 的环境中,可能需要 CPU 虚拟化。 |

| 描述 | 3.6.3. AMD PCIe 端口映射 |

| 设置 | ECC 内存(对于具有 ECC 内存的系统) 已启用 |

| ACS | 随着 GPU 和其他 PCIe 设备数量的增加,对于更大、更高性能的服务器,可能需要 PCIe 交换机来提供足够的连接性。在这种情况下,PCIe 交换机层数应限制为一层或两层,以最大限度地减少 PCIe 延迟。 |

| 已禁用 | 随着 GPU 和其他 PCIe 设备数量的增加,对于更大、更高性能的服务器,可能需要 PCIe 交换机来提供足够的连接性。在这种情况下,PCIe 交换机层数应限制为一层或两层,以最大限度地减少 PCIe 延迟。 |

IOMMU

已禁用1

- ConnectX-7

- [1] Intel Sapphire Rapids 需要启用 IOMMU

- ConnectX-6

- CPU 虚拟化

- BlueField-3

PCIe ACS 启用(访问控制服务)

- 已启用1

[1] NVIDIA GPUDirect 需要禁用 ACS

- PCIe 十位标签支持

- PCIe 宽松排序 (RO)

3.9. 网络

NVIDIA 建议使用最低 200Gb/s InfiniBand 和以太网 CX7 和 BlueField-3 数据处理单元 (DPU)。NVIDIA 认证系统测试过程需要使用以下 NVIDIA 产品之一的标准化测试环境

ConnectX-7 Dx

ConnectX-6 Dx

| 东西向网络 | NVIDIA 建议使用 ConnectX-7 (CX7) 智能网络适配器将 GPU 连接到东西向 (E-W) 网络,从而在 AI 集群中的 GPU 之间提供低延迟和高带宽通信。 | CX7 适配器还集成了 NVIDIA® GPUDirect® RDMA,它进一步优化了数据移动,并允许 GPU 之间的直接内存访问 (DMA),绕过 CPU 并提高整体系统性能。 | ||

|---|---|---|---|---|

| 每个 GPU 建议的计算网络带宽 | 200 GBps | 南北向网络 | ||

| BlueField-3 | 本节介绍了南北向 (N-S) 网络的推荐 BlueField-3 型号。 | NVIDIA BlueField-3 数据处理单元 (DPU) 是基于网络的 инфраструктура 计算平台,使组织能够在大规模 AI 云数据中心安全地部署和运营支持 NVIDIA GPU 的服务器。BlueField-3 在支持 NVIDIA GPU 的服务器中提供了多项基本功能和优势。有关更多信息,请参阅 BlueField 数据处理单元 (DPU) | NVIDIA。 | NVIDIA BlueField-3 数据处理单元 (DPU) 是基于网络的 инфраструктура 计算平台,使组织能够在大规模 AI 云数据中心安全地部署和运营支持 NVIDIA GPU 的服务器。BlueField-3 在支持 NVIDIA GPU 的服务器中提供了多项基本功能和优势。有关更多信息,请参阅 BlueField 数据处理单元 (DPU) | NVIDIA。 | NVIDIA BlueField-3 数据处理单元 (DPU) 是基于网络的 инфраструктура 计算平台,使组织能够在大规模 AI 云数据中心安全地部署和运营支持 NVIDIA GPU 的服务器。BlueField-3 在支持 NVIDIA GPU 的服务器中提供了多项基本功能和优势。有关更多信息,请参阅 BlueField 数据处理单元 (DPU) | NVIDIA。 |

| ConnectX-7 | 本节介绍了南北向 (N-S) 网络的推荐 BlueField-3 型号。 | NVIDIA BlueField-3 数据处理单元 (DPU) 是基于网络的 инфраструктура 计算平台,使组织能够在大规模 AI 云数据中心安全地部署和运营支持 NVIDIA GPU 的服务器。BlueField-3 在支持 NVIDIA GPU 的服务器中提供了多项基本功能和优势。有关更多信息,请参阅 BlueField 数据处理单元 (DPU) | NVIDIA。 | NVIDIA BlueField-3 数据处理单元 (DPU) 是基于网络的 инфраструктура 计算平台,使组织能够在大规模 AI 云数据中心安全地部署和运营支持 NVIDIA GPU 的服务器。BlueField-3 在支持 NVIDIA GPU 的服务器中提供了多项基本功能和优势。有关更多信息,请参阅 BlueField 数据处理单元 (DPU) | NVIDIA。 | NVIDIA BlueField-3 数据处理单元 (DPU) 是基于网络的 инфраструктура 计算平台,使组织能够在大规模 AI 云数据中心安全地部署和运营支持 NVIDIA GPU 的服务器。BlueField-3 在支持 NVIDIA GPU 的服务器中提供了多项基本功能和优势。有关更多信息,请参阅 BlueField 数据处理单元 (DPU) | NVIDIA。 |

| ConnectX-6 | 本节介绍了南北向 (N-S) 网络的推荐 BlueField-3 型号。 | 下表列出了 NVIDIA 网络卡卸载的支持的网络和安全协议。 | 下表列出了 NVIDIA 网络卡卸载的支持的网络和安全协议。 | NVIDIA BlueField-3 数据处理单元 (DPU) 是基于网络的 инфраструктура 计算平台,使组织能够在大规模 AI 云数据中心安全地部署和运营支持 NVIDIA GPU 的服务器。BlueField-3 在支持 NVIDIA GPU 的服务器中提供了多项基本功能和优势。有关更多信息,请参阅 BlueField 数据处理单元 (DPU) | NVIDIA。 |

| CPU 虚拟化 | SmartNIC/DPU | NVIDIA BlueField-3 数据处理单元 (DPU) 是基于网络的 инфраструктура 计算平台,使组织能够在大规模 AI 云数据中心安全地部署和运营支持 NVIDIA GPU 的服务器。BlueField-3 在支持 NVIDIA GPU 的服务器中提供了多项基本功能和优势。有关更多信息,请参阅 BlueField 数据处理单元 (DPU) | NVIDIA。 | NVIDIA BlueField-3 数据处理单元 (DPU) 是基于网络的 инфраструктура 计算平台,使组织能够在大规模 AI 云数据中心安全地部署和运营支持 NVIDIA GPU 的服务器。BlueField-3 在支持 NVIDIA GPU 的服务器中提供了多项基本功能和优势。有关更多信息,请参阅 BlueField 数据处理单元 (DPU) | NVIDIA。 | NVIDIA BlueField-3 数据处理单元 (DPU) 是基于网络的 инфраструктура 计算平台,使组织能够在大规模 AI 云数据中心安全地部署和运营支持 NVIDIA GPU 的服务器。BlueField-3 在支持 NVIDIA GPU 的服务器中提供了多项基本功能和优势。有关更多信息,请参阅 BlueField 数据处理单元 (DPU) | NVIDIA。 |

网络协议

安全卸载引擎

- IPsec

- TLS

- 每个 100 Gbps 网卡需要 Gen4 x8 或 Gen3 x16

3.10. 存储

应用程序和底层数据集的大小和规模将决定您的存储需求。与网络类似,这些需求对于每个解决方案的性能和约束都是独一无二的。

3.10.1. 认证要求

NVIDIA 认证系统测试使用内部 NVME 驱动器进行。

3.10.2. 内部存储

存储设备应位于与 GPU 和网卡设备相同的 PCIE 根联合体下,以获得最佳的非统一内存访问 (NUMA) 性能。

在使用 PCIe 交换机的服务器配置中,NVMe 驱动器应位于与 GPU 和网卡相同的 PCIe 交换机下,以获得最佳的 NVIDIA® GPUDirect® Storage (GDS) 性能。

3.10.3. 外部存储

生产部署支持外部存储解决方案,但在解决方案设计期间需要额外考虑。适用于集群 GPU 解决方案的 PCIe 吞吐量、网卡和交换机的相同考虑因素也适用于外部/共享存储集成。请咨询您的服务器和存储解决方案合作伙伴,以确保您的工作负载在您的环境中按预期执行。认证测试不需要外部存储。

3.10.4. GPU Direct Storage

GDS 支持位于与 GPU 相同的服务器或外部存储服务器中的 NVMe 驱动器。如果服务器中存在内部 NVMe 驱动器,则它们必须位于同一 PCIe 交换机或根联合体上才能与 GDS 一起使用。

有关 GPUDirect Storage 的更多详细信息,请参阅 NVIDIA GPUDirect Storage 文档。

3.11. 远程管理

虽然远程管理不是任何特定 AI 应用程序工作负载的要求,但在某些情况下,远程系统管理功能非常受欢迎。

3.11.1. 带内

带内管理解决方案指的是在操作系统内部发生的事情。这些通常围绕面向 GPU 的遥测和性能,其中操作系统可以通过 GPU 驱动程序访问 GPU。

3.11.1.1. NVIDIA 系统管理界面

NVIDIA 系统管理界面 (nvidia-smi) 是一个命令行实用程序,基于 NVIDIA 管理库 (NVML),旨在帮助管理和监控 NVIDIA GPU 设备。

此实用程序允许管理员查询 GPU 设备状态,并允许管理员使用适当的权限修改 GPU 设备状态。它针对 Tesla™、GRID™、Quadro™ 和 Titan X 产品,尽管在其他 NVIDIA GPU 上也提供有限的支持。

有关更多详细信息,请参阅 nvidia-smi 文档。

3.11.1.2. NVIDIA 数据中心 GPU 管理器

NVIDIA 数据中心 GPU 管理器 (DCGM) 是一套用于在集群环境中管理和监控 NVIDIA 数据中心 GPU 的工具。该套件包括主动健康监控、综合诊断、系统警报和治理策略,包括电源和时钟管理。基础设施团队可以将其用作独立工具,或轻松地将其与集群管理工具、资源调度和 NVIDIA 合作伙伴的监控产品集成。

3.11.2. 带外

基板管理控制器 (BMC) 提供了一个外部接口,用于通过所谓的带外通道从中央位置管理服务器。BMC 软件独立于操作系统运行。特定 BMC 功能因 OEM 而异,但您通常可以期望硬件级管理(电源开/关、LAN 上的串行和遥测功能可用。虽然操作系统可能通过互联网进行外部访问,但您的 BMC 管理端口通常不会暴露,因为这会带来重大的安全风险。BMC 通过 I2C 或 SMBUS 接口,通过 IPMI 或 Redfish 与底层服务器硬件通信。

NVIDIA 认证系统针对 IPMI 和 Redfish 管理功能进行了测试。

3.11.2.1. 智能平台管理接口

智能平台管理接口 (IPMI) 是一种用于远程系统管理的标准协议。这通常被认为是远程硬件管理的传统方法。

3.11.2.2. Redfish

Redfish 标准是由 DMTF 组织开发的一套规范,它提供了一个行业标准协议,为现代服务器、存储、网络和融合基础设施的带外管理提供了一个 RESTful 接口。

NVIDIA 作为 DMTF 组织内的领导合作伙伴参与 Redfish 的开发,帮助推动整个行业的 GPU 建模和管理标准。

注意

本文档仅供参考,不应被视为对产品特定功能、状况或质量的保证。NVIDIA 公司(“NVIDIA”)对本文档中信息的准确性或完整性不作任何明示或暗示的陈述或保证,并且对本文档中包含的任何错误不承担任何责任。NVIDIA 对因使用此类信息而造成的后果或使用,或因使用此类信息而可能导致的侵犯专利或第三方其他权利的行为不承担任何责任。本文档不承诺开发、发布或交付任何材料(如下定义)、代码或功能。

NVIDIA 保留随时对本文档进行更正、修改、增强、改进和任何其他更改的权利,恕不另行通知。

客户在下订单前应获取最新的相关信息,并应验证此类信息是否为最新且完整。

NVIDIA 产品的销售受订单确认时提供的 NVIDIA 标准销售条款和条件约束,除非 NVIDIA 和客户的授权代表签署的个别销售协议(“销售条款”)另有约定。NVIDIA 在此明确反对将任何客户通用条款和条件应用于购买本文档中引用的 NVIDIA 产品。本文档未直接或间接形成任何合同义务。

NVIDIA 产品并非设计、授权或保证适用于医疗、军事、飞机、航天或生命维持设备,也不适用于 NVIDIA 产品的故障或 malfunction 可以合理预期会导致人身伤害、死亡或财产或环境损害的应用。NVIDIA 对在此类设备或应用中包含和/或使用 NVIDIA 产品不承担任何责任,因此,此类包含和/或使用由客户自行承担风险。

NVIDIA 不保证基于本文档的产品适用于任何特定用途。NVIDIA 不一定对每个产品的所有参数进行测试。客户全权负责评估和确定本文档中任何信息的适用性,确保产品适合并适用于客户计划的应用,并为该应用执行必要的测试,以避免应用或产品的默认设置。客户产品设计中的缺陷可能会影响 NVIDIA 产品的质量和可靠性,并可能导致超出本文档中包含的额外或不同的条件和/或要求。NVIDIA 对任何可能基于或归因于以下原因的默认设置、损坏、成本或问题不承担任何责任:(i) 以任何违反本文档的方式使用 NVIDIA 产品或 (ii) 客户产品设计。

本文档未授予 NVIDIA 专利权、版权或其他 NVIDIA 知识产权下的任何明示或暗示的许可。NVIDIA 发布的有关第三方产品或服务的信息不构成 NVIDIA 授予使用此类产品或服务的许可,也不构成对其的保证或认可。使用此类信息可能需要获得第三方的专利或其他知识产权下的第三方许可,或者获得 NVIDIA 的专利或其他知识产权下的 NVIDIA 许可。

仅当事先获得 NVIDIA 书面批准、未经修改地复制并完全遵守所有适用的出口法律和法规,并附带所有相关的条件、限制和通知时,才允许复制本文档中的信息。

本文档以及所有 NVIDIA 设计规范、参考板、文件、图纸、诊断程序、列表和其他文档(统称为“材料”,单独或共同)均“按原样”提供。NVIDIA 对材料不作任何明示、暗示、法定或其他形式的保证,并明确否认所有关于不侵权、适销性和特定用途适用性的暗示保证。在法律未禁止的范围内,在任何情况下,NVIDIA 均不对因使用本文档而引起的任何损害(包括但不限于任何直接、间接、特殊、偶然、惩罚性或后果性损害,无论如何引起,也无论责任理论如何)承担责任,即使 NVIDIA 已被告知可能发生此类损害。尽管客户可能因任何原因遭受任何损害,NVIDIA 对客户就本文所述产品承担的总体和累积责任应根据产品的销售条款进行限制。

商标

NVIDIA、NVIDIA 徽标、BlueField、ConnectX、CUDA、GPUDirect、NVIDIA-Certified Systems、NVIDIA HGX、NVIDIA RTX 和 TensorRT 是 NVIDIA 公司在美国和其他国家/地区的商标和/或注册商标。其他公司和产品名称可能是与其相关的各自公司的商标。

Arm

Arm、AMBA 和 Arm Powered 是 Arm Limited 的注册商标。Cortex、MPCore 和 Mali 是 Arm Limited 的商标。所有其他品牌或产品名称均为其各自所有者的财产。“Arm”用于代表 Arm Holdings plc;其运营公司 Arm Limited;以及区域子公司 Arm Inc.;Arm KK;Arm Korea Limited.;Arm Taiwan Limited;Arm France SAS;Arm Consulting (Shanghai) Co. Ltd.;Arm Germany GmbH;Arm Embedded Technologies Pvt. Ltd.;Arm Norway, AS 和 Arm Sweden AB。

版权

© 2025 NVIDIA 公司及关联公司。保留所有权利。