虚拟 GPU 软件用户指南

NVIDIA vGPU 软件是一个图形虚拟化平台,使虚拟机 (VM) 能够访问 NVIDIA GPU 技术。

1.1. NVIDIA vGPU 软件的使用方式

1.1.1. NVIDIA vGPU

NVIDIA 虚拟 GPU (vGPU) 使多个虚拟机 (VM) 能够同时直接访问单个物理 GPU,使用与部署在非虚拟化操作系统上相同的 NVIDIA 图形驱动程序。通过这样做,NVIDIA vGPU 为虚拟机提供了无与伦比的图形性能、计算性能和应用程序兼容性,以及在多个工作负载之间共享 GPU 所带来的成本效益和可扩展性。

有关详细信息,请参阅安装和配置 NVIDIA Virtual GPU 管理器。

1.1.2. GPU 直通

在 GPU 直通模式下,整个物理 GPU 直接分配给一个虚拟机,绕过 NVIDIA Virtual GPU 管理器。在这种操作模式下,GPU 由虚拟机中运行的 NVIDIA 驱动程序独占访问。GPU 不在虚拟机之间共享。

有关详细信息,请参阅使用 GPU 直通。

1.1.3. 裸机部署

在裸机部署中,您可以将 NVIDIA vGPU 软件图形驱动程序与 vWS 和 vApps 许可证结合使用,以交付远程虚拟桌面和应用程序。如果您打算为此目的在没有虚拟机监控程序的情况下使用 Tesla 板卡,请使用 NVIDIA vGPU 软件图形驱动程序,而不是其他 NVIDIA 驱动程序。

要在裸机部署中使用 NVIDIA vGPU 软件驱动程序,请完成以下任务

-

在物理主机上安装驱动程序。

有关说明,请参阅安装 NVIDIA vGPU 软件图形驱动程序。

-

许可您正在使用的任何 NVIDIA vGPU 软件。

有关说明,请参阅虚拟 GPU 客户端许可用户指南。

-

配置平台以进行远程访问。

要将图形功能与 Tesla GPU 结合使用,您必须使用受支持的远程解决方案,例如 RemoteFX、Citrix Virtual Apps and Desktops、VNC 或类似技术。

-

使用主机操作系统的显示设置功能将 Tesla GPU 配置为主显示器。

NVIDIA Tesla 通常在裸机平台上作为辅助设备运行。

-

如果系统有多个显示适配器,请禁用通过非 NVIDIA 适配器连接的显示设备。

您可以使用主机操作系统的显示设置功能或远程解决方案来实现此目的。在包括 Tesla GPU 在内的 NVIDIA GPU 上,默认情况下会启用显示设备。

用户只有在启用由 NVIDIA 适配器驱动的显示器后,才能启动需要 NVIDIA GPU 技术的应用程序以获得增强的用户体验。

1.2. NVIDIA vGPU 软件部署的主显示适配器要求

设置为主显示适配器的 GPU 不能用于 NVIDIA vGPU 部署或 GPU 直通部署。主显示器是虚拟机监控程序主机的启动显示器,它显示 SBIOS 控制台消息,然后启动操作系统或虚拟机监控程序。

任何用于 NVIDIA vGPU 部署或 GPU 直通部署的 GPU 都必须设置为辅助显示适配器。

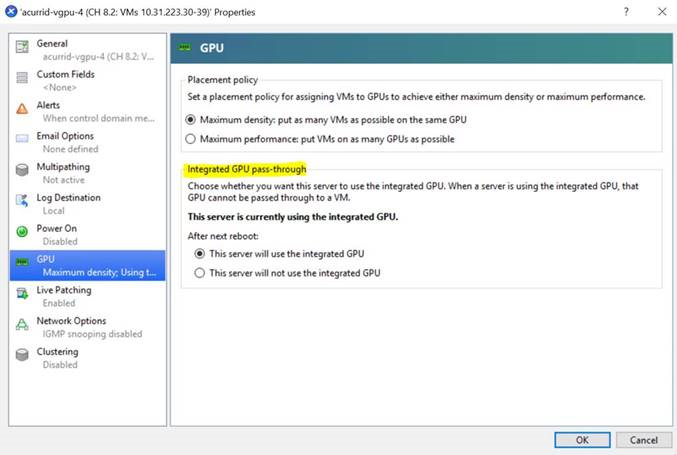

XenServer 提供了一个特定设置,允许主显示适配器用于 GPU 直通部署。

只有以下 GPU 支持作为主显示适配器

- Tesla M6

- Quadro RTX 6000

- Quadro RTX 8000

所有其他支持 NVIDIA vGPU 软件的 GPU 都不能用作主显示适配器,因为它们是 3D 控制器,而不是 VGA 设备。

如果虚拟机监控程序主机没有额外的图形适配器,请考虑安装一个低端显示适配器用作主显示适配器。如有必要,请确保在虚拟机监控程序主机的 BIOS 选项中正确设置主显示适配器。

1.3. NVIDIA vGPU 软件功能

NVIDIA vGPU 软件包括 vWS、vPC 和 vApps。

1.3.1. NVIDIA vGPU 上的 API 支持

NVIDIA vGPU 包括对以下 API 的支持

- 开放计算语言 (OpenCL™ 软件) 3.0

- OpenGL® 4.6

- Vulkan® 1.3

- DirectX 11

- DirectX 12 (Windows 10)

- Direct2D

- DirectX 视频加速 (DXVA)

- NVIDIA® CUDA® 12.4

- NVIDIA vGPU 软件 SDK(远程图形加速)

- NVIDIA RTX(基于 NVIDIA Volta 图形架构和更高架构的 GPU)

这些 API 向后兼容。也支持旧版本的 API。

1.3.2. NVIDIA vGPU 软件上对 NVIDIA CUDA 工具包和 OpenCL 的支持

仅在部分 vGPU 类型和受支持的 GPU 上,NVIDIA vGPU 支持 NVIDIA CUDA 工具包和 OpenCL。

有关 NVIDIA CUDA 工具包的更多信息,请参阅CUDA 工具包文档 12.4。

如果您在 Linux 上将 NVIDIA vGPU 软件与 CUDA 结合使用,请通过从独立于发行版的 runfile 软件包安装 CUDA 来避免安装方法冲突。请勿从特定于发行版的 RPM 或 Deb 软件包安装 CUDA。

为确保在安装 CUDA 时 NVIDIA vGPU 软件图形驱动程序不被覆盖,请在选择要安装的 CUDA 组件时取消选择 CUDA 驱动程序。

有关详细信息,请参阅NVIDIA CUDA Linux 安装指南。

OpenCL 和 CUDA 应用程序支持

以下 NVIDIA vGPU 类型支持 OpenCL 和 CUDA 应用程序

- Tesla M10 GPU 上的 8Q vGPU 类型

- 以下 GPU 上的所有 Q 系列 vGPU 类型

- NVIDIA L2

- NVIDIA L4

- NVIDIA L20

- NVIDIA L40

- NVIDIA L40S

- NVIDIA RTX 5000 Ada

- NVIDIA RTX 6000 Ada

- NVIDIA A2

- NVIDIA A10

- NVIDIA A16

- NVIDIA A40

- NVIDIA RTX A5000

- NVIDIA RTX A5500

- NVIDIA RTX A6000

- Tesla V100 SXM2

- Tesla V100 SXM2 32GB

- Tesla V100 PCIe

- Tesla V100 PCIe 32GB

- Tesla V100S PCIe 32GB

- Tesla V100 FHHL

- Tesla T4

- Quadro RTX 6000

- Quadro RTX 6000 passive

- Quadro RTX 8000

- Quadro RTX 8000 passive

NVIDIA CUDA 工具包开发工具支持

在某些 GPU 上,NVIDIA vGPU 支持以下 NVIDIA CUDA 工具包开发工具

- 调试器

- CUDA-GDB

- Compute Sanitizer

- 分析器

- CUDA 分析工具接口 (CUPTI) 的 Activity、Callback 和 Profiling API

不支持其他 CUPTI API,例如 Event 和 Metric API。

- NVIDIA Nsight™ Compute

- NVIDIA Nsight Systems

- NVIDIA Nsight 插件

- NVIDIA Nsight Visual Studio 插件

不支持其他 CUDA 分析器,例如 nvprof 和 NVIDIA Visual Profiler。

- CUDA 分析工具接口 (CUPTI) 的 Activity、Callback 和 Profiling API

这些工具仅在 Linux 客户虚拟机中受支持。

支持 NVIDIA CUDA 工具包分析器,并且可以在启用统一内存的虚拟机上启用它们。

默认情况下,NVIDIA CUDA 工具包开发工具在 NVIDIA vGPU 上处于禁用状态。如果使用,您必须通过设置 vGPU 插件参数,为每个需要它们的虚拟机单独启用 NVIDIA CUDA 工具包开发工具。有关说明,请参阅为 NVIDIA vGPU 启用 NVIDIA CUDA 工具包开发工具。

下表列出了 NVIDIA vGPU 支持这些调试器和分析器的 GPU。

| GPU | vGPU 模式 | 调试器 | 分析器 |

|---|---|---|---|

| NVIDIA L2 | 时间切片 | ✓ | ✓ |

| NVIDIA L4 | 时间切片 | ✓ | ✓ |

| NVIDIA L20 | 时间切片 | ✓ | ✓ |

| NVIDIA L40 | 时间切片 | ✓ | ✓ |

| NVIDIA L40S | 时间切片 | ✓ | ✓ |

| NVIDIA RTX 5000 Ada | 时间切片 | ✓ | ✓ |

| NVIDIA RTX 6000 Ada | 时间切片 | ✓ | ✓ |

| NVIDIA A2 | 时间切片 | ✓ | ✓ |

| NVIDIA A10 | 时间切片 | ✓ | ✓ |

| NVIDIA A16 | 时间切片 | ✓ | ✓ |

| NVIDIA A40 | 时间切片 | ✓ | ✓ |

| NVIDIA RTX A5000 | 时间切片 | ✓ | ✓ |

| NVIDIA RTX A5500 | 时间切片 | ✓ | ✓ |

| NVIDIA RTX A6000 | 时间切片 | ✓ | ✓ |

| Tesla T4 | 时间切片 | ✓ | ✓ |

| Quadro RTX 6000 | 时间切片 | ✓ | ✓ |

| Quadro RTX 6000 passive | 时间切片 | ✓ | ✓ |

| Quadro RTX 8000 | 时间切片 | ✓ | ✓ |

| Quadro RTX 8000 passive | 时间切片 | ✓ | ✓ |

| Tesla V100 SXM2 | 时间切片 | ✓ | ✓ |

| Tesla V100 SXM2 32GB | 时间切片 | ✓ | ✓ |

| Tesla V100 PCIe | 时间切片 | ✓ | ✓ |

| Tesla V100 PCIe 32GB | 时间切片 | ✓ | ✓ |

| Tesla V100S PCIe 32GB | 时间切片 | ✓ | ✓ |

| Tesla V100 FHHL | 时间切片 | ✓ | ✓ |

✓ 功能受支持

- 功能不受支持

受支持的 NVIDIA CUDA 工具包功能

如果 vGPU 类型、物理 GPU 和虚拟机监控程序软件版本支持该功能,则 NVIDIA vGPU 支持以下 NVIDIA CUDA 工具包功能

- 纠错码 (ECC) 内存

- 通过 NVLink 的对等 CUDA 传输注意

要确定主机中物理 GPU 或分配给虚拟机的 vGPU 之间的 NVLink 拓扑,请从主机或虚拟机运行以下命令

$ nvidia-smi topo -m

- 统一内存注意

默认情况下,统一内存处于禁用状态。如果使用,您必须通过设置 vGPU 插件参数,为每个需要它的 vGPU 单独启用统一内存。有关说明,请参阅为 vGPU 启用统一内存。

- NVIDIA Nsight Systems GPU 上下文切换跟踪

动态页面停用功能在支持 ECC 内存的物理 GPU 上的所有 vGPU 类型中均受支持,即使 ECC 内存在物理 GPU 上被禁用也是如此。

NVIDIA vGPU 不支持的 NVIDIA CUDA 工具包功能

NVIDIA vGPU 不支持 NVIDIA CUDA 工具包的 NVIDIA Nsight Graphics 功能。

NVIDIA Nsight Graphics 功能在 GPU 直通模式和裸机部署中受支持。

1.3.3. 其他 vWS 功能

除了 vPC 和 vApps 的功能外,vWS 还提供以下功能

- 工作站特定的图形功能和加速

- 针对专业应用程序的认证驱动程序

- 用于工作站或专业 3D 图形的 GPU 直通

在直通模式下,vWS 支持分辨率高达 8K 的多个虚拟显示头,以及基于可用像素数量的灵活虚拟显示分辨率。有关详细信息,请参阅物理 GPU 的显示分辨率。

- 面向 Windows 用户的 10 位颜色。(Linux 上当前不支持 HDR/10 位颜色,支持 NvFBC 捕获,但已弃用。)

1.3.4. NVIDIA vGPU 软件上对 NVIDIA GPU Cloud (NGC) 容器的支持

NVIDIA vGPU 软件在所有受支持的虚拟机监控程序上的 NVIDIA vGPU 和 GPU 直通部署中都支持 NGC 容器。

在 NVIDIA vGPU 部署中,仅在基于 Maxwell 架构之后的 NVIDIA GPU 架构的 GPU 上支持 Q 系列 vGPU 类型。

在 GPU 直通部署中,支持 NVIDIA vGPU 软件的基于 NVIDIA Maxwell™ 架构之后的所有 NVIDIA GPU 架构的 GPU 均受支持。

NVIDIA vGPU 软件在受支持的平台 - NVIDIA 容器工具包中列出的,且 NVIDIA vGPU 软件也支持的任何客户操作系统上都支持 NGC 容器。

有关设置 NVIDIA vGPU 软件以与 NGC 容器结合使用的更多信息,请参阅将 NGC 与 NVIDIA Virtual GPU 软件结合使用设置指南。

1.3.5. NVIDIA GPU Operator 支持

NVIDIA GPU Operator 简化了在由 Kubernetes 容器编排引擎管理的软件容器平台上部署 NVIDIA vGPU 软件的过程。它自动化了在配置了 NVIDIA vGPU 的客户虚拟机中运行的容器平台的 NVIDIA vGPU 软件图形驱动程序的安装和更新。

NVIDIA GPU Operator 要安装的任何驱动程序都必须从 NVIDIA 许可门户下载到本地计算机。不支持 NVIDIA GPU Operator 自动访问 NVIDIA 许可门户。

NVIDIA GPU Operator 支持 NVIDIA vGPU 软件的自动配置,并通过在客户虚拟机中运行的 DCGM Exporter 提供遥测支持。

仅在虚拟机监控程序软件版本、容器平台、vGPU 类型和客户操作系统版本的特定组合中支持 NVIDIA GPU Operator。要确定您的配置是否支持 NVIDIA GPU Operator 与 NVIDIA vGPU 部署,请查阅您选择的虚拟机监控程序的发行说明,网址为 NVIDIA Virtual GPU 软件文档。

有关详细信息,请参阅 NVIDIA 文档门户上的NVIDIA GPU Operator 概述。

1.4. 本指南的组织结构

虚拟 GPU 软件用户指南的组织结构如下

- 本章介绍了 NVIDIA vGPU 软件的功能和特性。

- 安装和配置 NVIDIA Virtual GPU 管理器提供了在受支持的虚拟机监控程序上安装和配置 vGPU 的分步指南。

- 使用 GPU 直通介绍了如何在受支持的虚拟机监控程序上配置 GPU 以进行直通。

- 安装 NVIDIA vGPU 软件图形驱动程序 解释了如何在 Windows 和 Linux 操作系统上安装 NVIDIA vGPU 软件图形驱动程序。

- 许可 NVIDIA vGPU 解释了如何在 Windows 和 Linux 操作系统上许可 NVIDIA vGPU 许可产品。

- 修改虚拟机的 NVIDIA vGPU 配置 解释了如何删除虚拟机的 vGPU 配置以及如何修改启用 vGPU 的虚拟机的 GPU 分配。

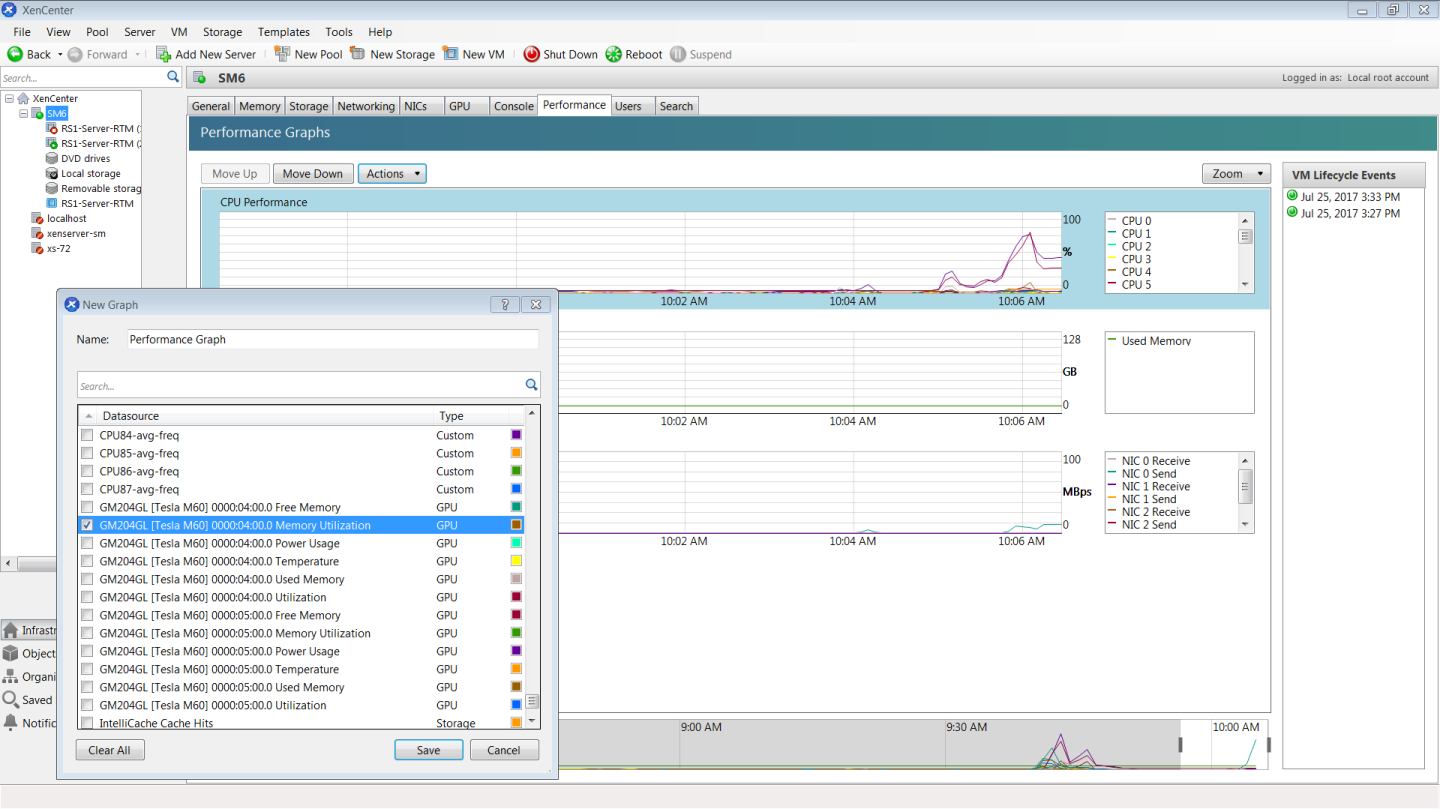

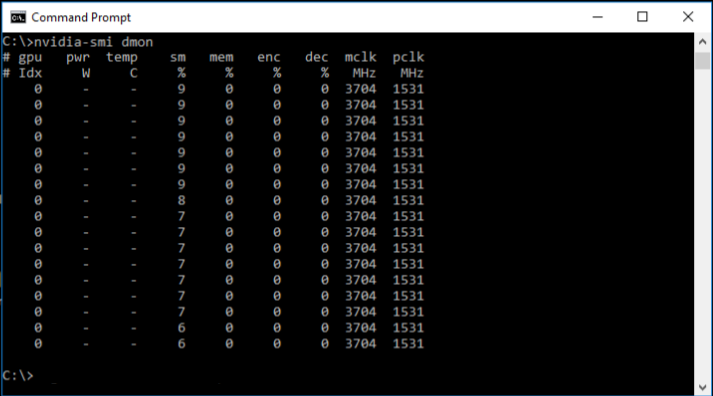

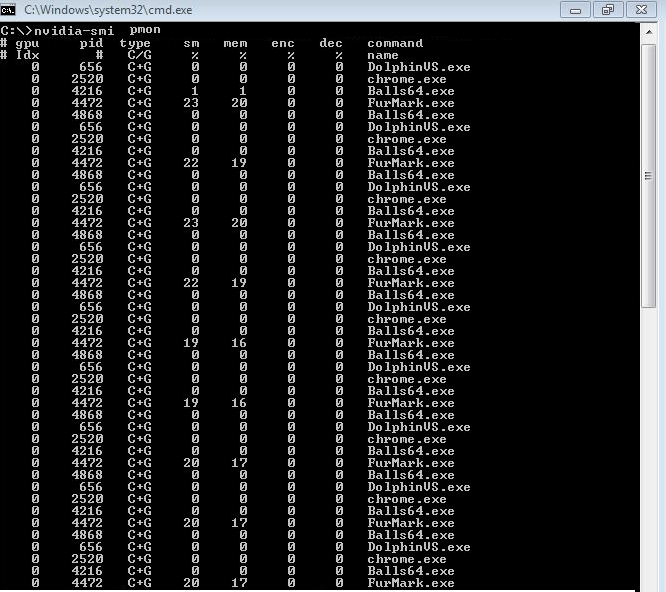

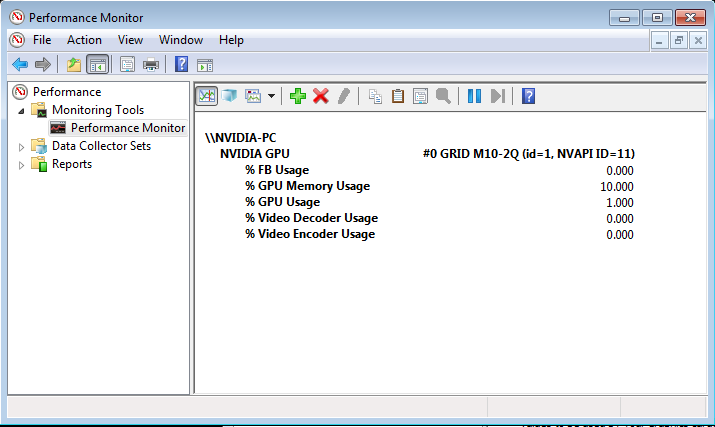

- 监控 GPU 性能 涵盖了从 hypervisor 和各个客户虚拟机内部监控物理 GPU 和虚拟 GPU 的性能。

- 更改分时 vGPU 的调度行为 描述了 NVIDIA vGPU 的调度行为以及如何更改它。

- 故障排除 提供了关于故障排除的指南。

- 虚拟 GPU 类型参考 提供了每个受支持的 GPU 中可用的每个 vGPU 的详细信息,并提供了 B 系列和 Q 系列 vGPU 的混合虚拟显示配置示例。

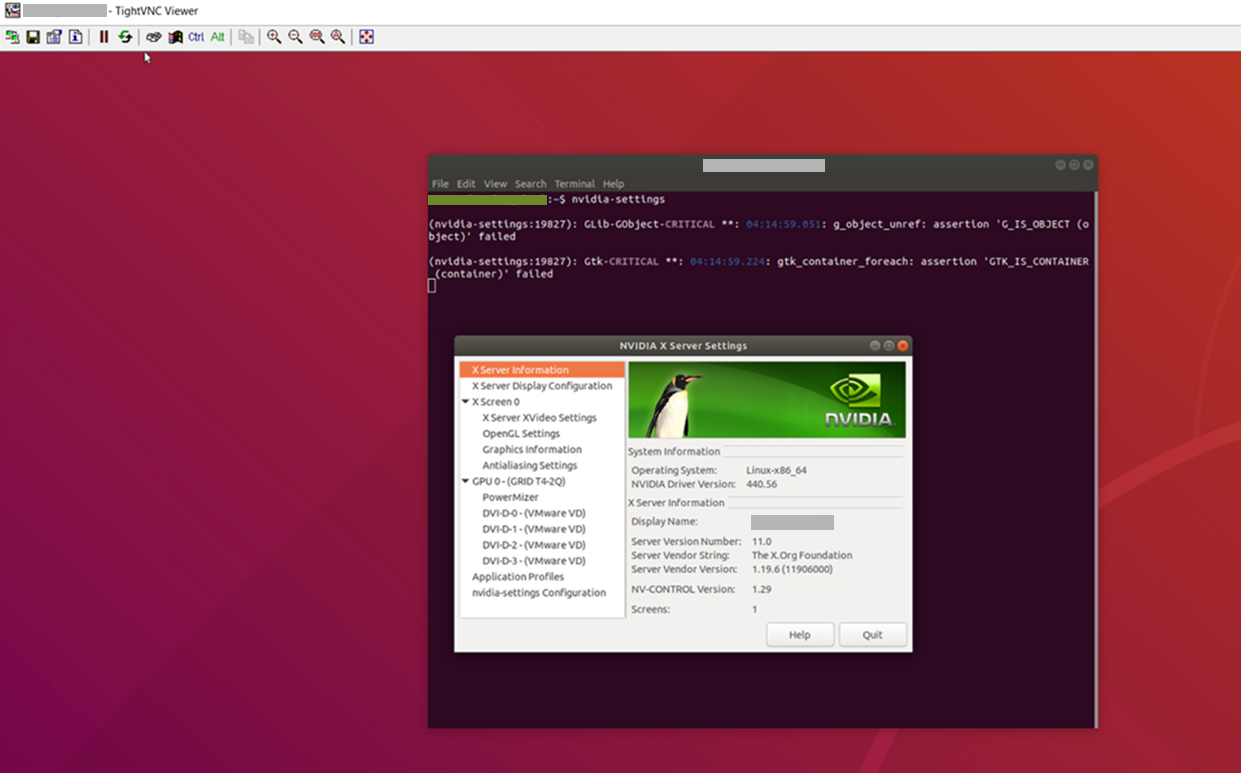

- 配置 x11vnc 以检查 Linux 服务器中的 GPU 解释了如何使用 x11vnc 来确认未直接连接显示设备的 Linux 服务器中的 NVIDIA GPU 是否按预期工作。

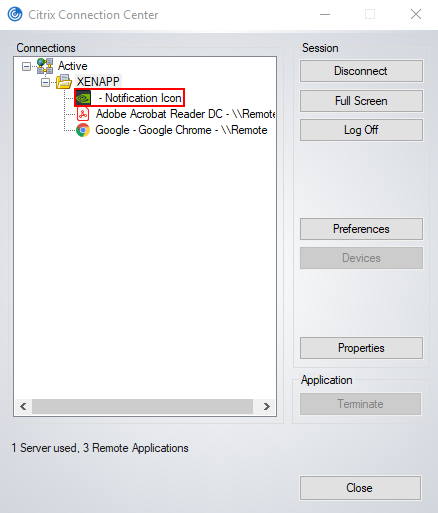

- 禁用 Citrix Published Application 用户会话的 NVIDIA 通知图标 解释了如何确保 NVIDIA 通知图标应用程序不会阻止 Citrix Published Application 用户会话注销,即使在用户退出所有其他应用程序后也是如此。

- XenServer 基础知识 解释了如何在 XenServer 上执行基本操作,以安装和配置 NVIDIA vGPU 软件并优化 XenServer 与 vGPU 的操作。

- XenServer vGPU 管理 涵盖了 XenServer 上的 vGPU 管理。

- XenServer 性能调优 涵盖了 XenServer 上的 vGPU 性能优化。

安装和配置 NVIDIA 虚拟 GPU 管理器的过程取决于您使用的 hypervisor。完成此过程后,您可以安装客户操作系统的显示驱动程序,并许可您正在使用的任何 NVIDIA vGPU 软件许可产品。

2.1. 关于 NVIDIA 虚拟 GPU

2.1.1. NVIDIA vGPU 架构

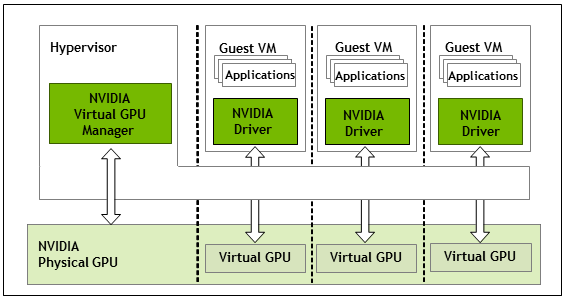

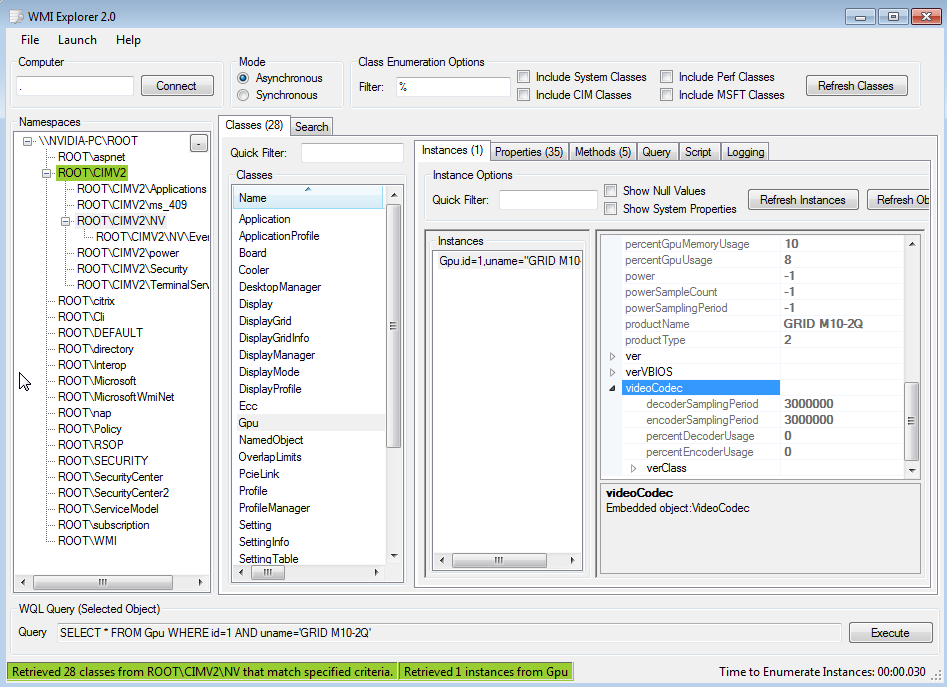

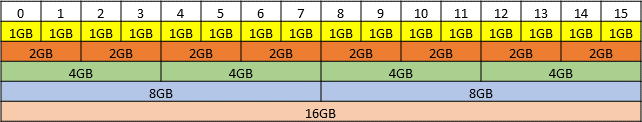

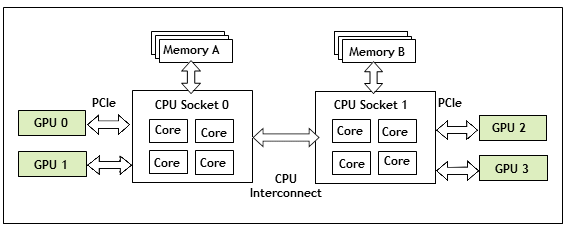

图 1 说明了 NVIDIA vGPU 的高级架构。在 hypervisor 下运行的 NVIDIA 虚拟 GPU 管理器的控制下,NVIDIA 物理 GPU 能够支持多个虚拟 GPU 设备 (vGPU),这些设备可以直接分配给客户虚拟机。

客户虚拟机以与 hypervisor 直通的物理 GPU 相同的方式使用 NVIDIA vGPU:加载在客户虚拟机中的 NVIDIA 驱动程序提供对 GPU 的直接访问,用于性能关键的快速路径,而 NVIDIA 虚拟 GPU 管理器的半虚拟化接口用于非性能管理操作。

图 1. NVIDIA vGPU 系统架构

每个 NVIDIA vGPU 都类似于传统的 GPU,具有固定数量的 GPU 帧缓冲区以及一个或多个虚拟显示输出或“头”。vGPU 的帧缓冲区是在创建 vGPU 时从物理 GPU 的帧缓冲区中分配的,并且 vGPU 保留对该帧缓冲区的独占使用权,直到它被销毁。根据物理 GPU 和 GPU 虚拟化软件,NVIDIA 虚拟 GPU 管理器在物理 GPU 上支持不同类型的 vGPU

- 在所有支持 NVIDIA vGPU 软件的 GPU 上,都可以创建分时 vGPU。

- 此外,在支持多实例 GPU (MIG) 功能和 NVIDIA AI Enterprise 的 GPU 上,支持基于 MIG 的 vGPU。MIG 功能是在基于 NVIDIA Ampere GPU 架构的 GPU 上引入的。注意

尽管早期版本的 NVIDIA vGPU 软件支持支持 MIG 功能的 GPU,但在此版本的 NVIDIA vGPU 软件中不支持此类 GPU。支持 MIG 功能的 GPU 仅在 NVIDIA AI Enterprise 上受支持。

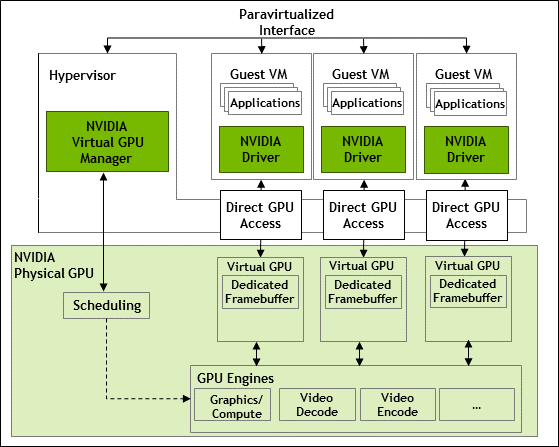

2.1.1.1. 分时 NVIDIA vGPU 内部架构

分时 vGPU 是驻留在未分区为多个 GPU 实例的物理 GPU 上的 vGPU。驻留在 GPU 上的所有分时 vGPU 共享对 GPU 引擎的访问权限,包括图形 (3D)、视频解码和视频编码引擎。

在分时 vGPU 中,在 vGPU 上运行的进程被调度为串行运行。每个 vGPU 在其他进程在其他 vGPU 上运行时等待。当进程在 vGPU 上运行时,vGPU 独占使用 GPU 的引擎。您可以更改默认调度行为,如更改分时 vGPU 的调度行为中所述。

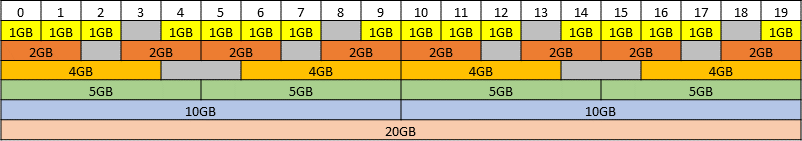

图 2. 分时 NVIDIA vGPU 内部架构

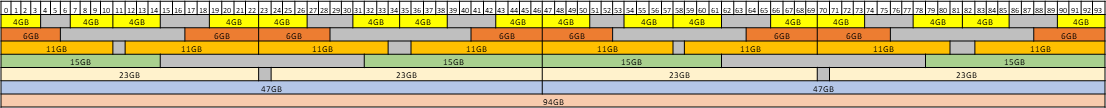

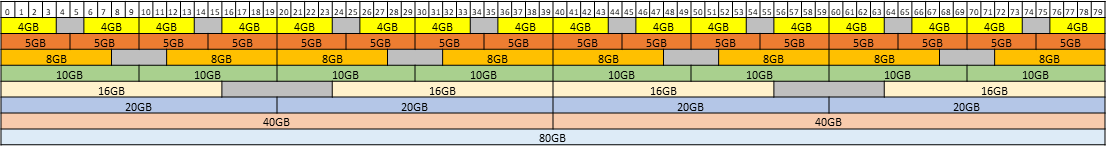

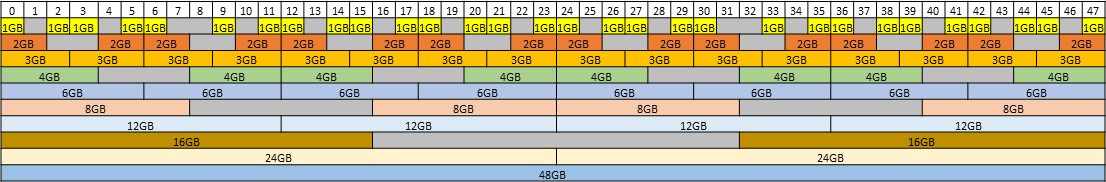

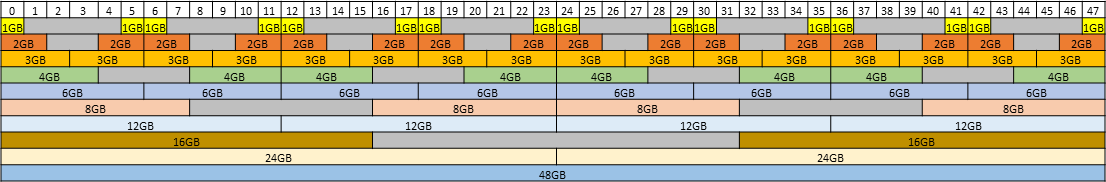

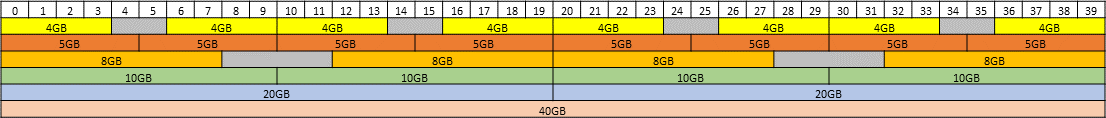

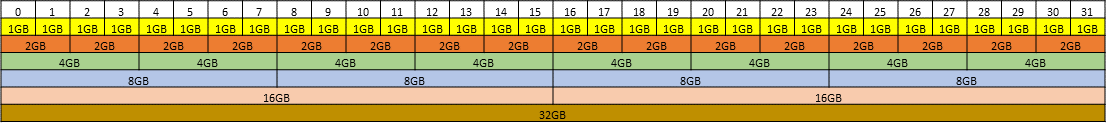

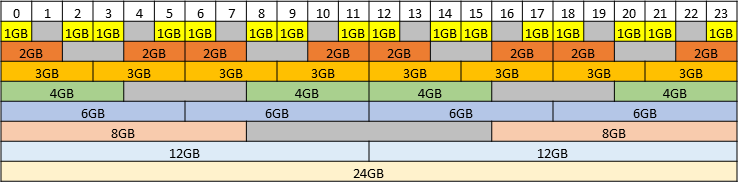

2.1.2. 关于虚拟 GPU 类型

板卡拥有的物理 GPU 数量取决于板卡。每个物理 GPU 可以支持几种不同类型的虚拟 GPU (vGPU)。vGPU 类型具有固定数量的帧缓冲区、支持的显示头数和最大分辨率1。它们根据为其优化的不同类别的工作负载分组为不同的系列。每个系列都由 vGPU 类型名称的最后一个字母标识。

| 系列 | 最佳工作负载 |

|---|---|

| Q 系列 | 适用于需要 Quadro 技术的性能和功能的创意和技术专业人士的虚拟工作站 |

| B 系列 | 适用于业务专业人士和知识工作者的虚拟桌面 |

| A 系列 | 适用于虚拟应用程序用户的应用程序流式传输或基于会话的解决方案4 |

vGPU 类型名称中板卡类型后的数字表示分配给该类型 vGPU 的帧缓冲区量。例如,类型为 A16-4Q 的 vGPU 在 NVIDIA A16 板卡上分配了 4096 Mbytes 的帧缓冲区。

由于其不同的资源要求,可以在物理 GPU 上同时创建的最大 vGPU 数量因 vGPU 类型而异。例如,NVDIA A16 板卡在其两个物理 GPU 中的每个 GPU 上最多可以支持 4 个 A16-4Q vGPU,总共 16 个 vGPU,但仅支持 2 个 A16-8Q vGPU,总共 8 个 vGPU。启用后,帧速率限制器 (FRL) 将 vGPU 的最大帧速率限制为每秒帧数 (FPS),如下所示

- 对于 B 系列 vGPU,最大帧速率为 45 FPS。

- 对于 Q 系列和 A 系列 vGPU,最大帧速率为 60 FPS。

默认情况下,所有 GPU 都启用 FRL。当 vGPU 调度行为从支持替代 vGPU 调度器的 GPU 上的默认尽力而为调度器更改时,FRL 将被禁用。有关详细信息,请参阅更改分时 vGPU 的调度行为。在使用尽力而为调度器的 vGPU 上,可以禁用 FRL,如NVIDIA 虚拟 GPU 软件文档中您选择的 hypervisor 的发行说明中所述。

NVIDIA vGPU 在所有受支持的 GPU 板卡上都是许可产品。需要软件许可证才能启用客户虚拟机中的所有 vGPU 功能。所需的许可证类型取决于 vGPU 类型。

- Q 系列 vGPU 类型需要 vWS 许可证。

- B 系列 vGPU 类型需要 vPC 许可证,但也可以与 vWS 许可证一起使用。

- A 系列 vGPU 类型需要 vApps 许可证。

有关每种受支持的 GPU 中可用的虚拟 GPU 类型的详细信息,请参阅受支持的 GPU 的虚拟 GPU 类型。

2.1.3. Q 系列和 B 系列 vGPU 的虚拟显示分辨率

Q 系列和 B 系列 vGPU 不支持每个显示器的固定最大分辨率,而是支持基于可用像素数量的最大组合分辨率,这由其帧缓冲区大小决定。您可以选择使用少量高分辨率显示器或大量低分辨率显示器与这些 vGPU。

您可以使用的虚拟显示器数量取决于以下因素的组合

- 虚拟 GPU 系列

- GPU 架构

- vGPU 帧缓冲区大小

- 显示分辨率

即使显示器的组合分辨率小于 vGPU 的可用像素数,您也不能使用超过 vGPU 支持的最大显示器数量。例如,由于 -0Q 和 -0B vGPU 最多仅支持两个显示器,因此即使显示器的组合分辨率 (6220800) 小于这些 vGPU 的可用像素数 (8192000),您也不能将四个 1280×1024 显示器与这些 vGPU 一起使用。

各种因素会影响 GPU 帧缓冲区的消耗,这可能会影响用户体验。这些因素包括但不限于显示器数量、显示分辨率、工作负载和已部署的应用程序、远程解决方案以及客户操作系统。vGPU 驱动特定显示器组合的能力并不能保证有足够的帧缓冲区可用于运行所有应用程序。如果应用程序耗尽帧缓冲区,请考虑通过以下方式之一更改您的设置

- 切换到具有更多帧缓冲区的 vGPU 类型

- 使用更少的显示器

- 使用更低分辨率的显示器

受支持的 GPU 的虚拟 GPU 类型中列出的每个 vGPU 的最大显示器数量基于所有显示器都具有相同分辨率的配置。有关具有混合显示分辨率的配置示例,请参阅B 系列和 Q 系列 vGPU 的混合显示配置。

2.1.4. 单个 GPU 上的有效分时虚拟 GPU 配置

NVIDIA vGPU 软件支持在同一物理 GPU 上混合使用不同类型的分时 vGPU。具有任何帧缓冲区大小的 A 系列、B 系列和 Q 系列 vGPU 的任何组合都可以同时驻留在同一物理 GPU 上。分配给物理 GPU 上 vGPU 的帧缓冲区总量不得超过物理 GPU 拥有的帧缓冲区量。

例如,以下 vGPU 组合可以同时驻留在同一物理 GPU 上

- A40-2B 和 A40-2Q

- A40-2Q 和 A40-4Q

- A40-2B 和 A40-4Q

默认情况下,GPU 仅支持具有相同帧缓冲区大小的 vGPU,因此处于等大小模式。为了支持具有不同帧缓冲区大小的 vGPU,必须将 GPU 置于混合大小模式。当 GPU 处于混合大小模式时,GPU 上允许的某些类型的 vGPU 的最大数量小于 GPU 处于等大小模式时的最大数量。有关更多信息,请参阅以下主题

并非所有 hypervisor 和 GPU 都支持在同一物理 GPU 上混合使用不同类型的分时 vGPU。要确定您选择的 hypervisor 是否支持您选择的 GPU 的此功能,请查阅NVIDIA 虚拟 GPU 软件文档中您的 hypervisor 的发行说明。

2.1.5. 客户虚拟机支持

NVIDIA vGPU 支持 Windows 和 Linux 客户虚拟机操作系统。支持的 vGPU 类型取决于客户虚拟机操作系统。

有关受支持的 Windows 和 Linux 版本以及有关受支持配置的更多信息,请参阅NVIDIA 虚拟 GPU 软件文档中您的 hypervisor 的驱动程序发行说明。

2.1.5.1. Windows 客户虚拟机支持

所有 NVIDIA vGPU 类型都支持 Windows 客户虚拟机,即:Q 系列、B 系列和 A 系列 NVIDIA vGPU 类型。

2.1.5.2. Linux 客户虚拟机支持

所有 NVIDIA vGPU 类型都支持 Linux 客户虚拟机,即:Q 系列、B 系列和 A 系列 NVIDIA vGPU 类型。

2.2. 使用 NVIDIA vGPU 的先决条件

在继续操作之前,请确保满足以下先决条件

- 您拥有一个服务器平台,该平台能够托管您选择的 hypervisor 和支持 NVIDIA vGPU 软件的 NVIDIA GPU。

- 您的服务器平台中安装了一个或多个支持 NVIDIA vGPU 软件的 NVIDIA GPU。

-

如果您使用的是基于 NVIDIA Ampere 架构或更高架构的 GPU,则在您的服务器平台上启用以下 BIOS 设置

- VT-D/IOMMU

- SR-IOV

- 备用路由 ID 解释 (ARI)

- 您已下载了适用于您选择的 hypervisor 的 NVIDIA vGPU 软件包,其中包含以下软件

- 适用于您的 hypervisor 的 NVIDIA 虚拟 GPU 管理器

- 适用于受支持的客户操作系统的 NVIDIA vGPU 软件图形驱动程序

- 以下软件已按照软件供应商文档中的说明安装

- 您选择的 hypervisor,例如 XenServer、Red Hat Enterprise Linux KVM 或 VMware vSphere Hypervisor (ESXi)

- 用于管理您选择的 hypervisor 的软件,例如 Citrix XenCenter 管理 GUI 或 VMware vCenter Server

- 您将与运行 NVIDIA 虚拟 GPU 的虚拟机 (VM) 一起使用的虚拟桌面软件,例如 Citrix Virtual Apps and Desktops 或 Omnissa Horizon

注意如果您使用的是 VMware vSphere Hypervisor (ESXi),请确保您将在其上配置具有 NVIDIA vGPU 的虚拟机的 ESXi 主机不是完全自动化的 VMware Distributed Resource Scheduler (DRS) 集群的成员。有关更多信息,请参阅安装和配置适用于 VMware vSphere 的 NVIDIA 虚拟 GPU 管理器。

- 已创建要启用一个或多个虚拟 GPU 的虚拟机。注意

如果虚拟机使用 UEFI 启动并且您计划在虚拟机中安装 Linux 客户操作系统,请确保安全启动已禁用。

- 您选择的客户操作系统已安装在虚拟机中。

有关受支持的硬件和软件以及此版本 NVIDIA vGPU 软件的任何已知问题的信息,请参阅您选择的 hypervisor 的发行说明

- XenServer 版虚拟 GPU 软件发行说明

- Microsoft Azure Local 版虚拟 GPU 软件发行说明

- Red Hat Enterprise Linux with KVM 版虚拟 GPU 软件发行说明

- Ubuntu 版虚拟 GPU 软件发行说明

- 用于 VMware vSphere 的虚拟 GPU 软件发行说明

2.3. 切换支持多种显示模式的 GPU 的模式

一些 GPU 支持关闭显示和启用显示模式,但在 NVIDIA vGPU 软件部署中必须以关闭显示模式使用。

下表列出的 GPU 支持多种显示模式。如表所示,一些 GPU 在出厂时以关闭显示模式供应,但其他 GPU 以启用显示模式供应。

| GPU | 出厂供应模式 |

|---|---|

| NVIDIA A40 | 关闭显示 |

| NVIDIA L40 | 关闭显示 |

| NVIDIA L40S | 关闭显示 |

| NVIDIA L20 | 关闭显示 |

| NVIDIA L20 液冷 | 关闭显示 |

| NVIDIA RTX 5000 Ada | 启用显示 |

| NVIDIA RTX 6000 Ada | 启用显示 |

| NVIDIA RTX A5000 | 启用显示 |

| NVIDIA RTX A5500 | 启用显示 |

| NVIDIA RTX A6000 | 启用显示 |

出厂时以关闭显示模式供应的 GPU,例如 NVIDIA A40 GPU,如果其模式先前已更改,则可能处于启用显示模式。

要更改支持多种显示模式的 GPU 的模式,请使用 displaymodeselector 工具,您可以从 NVIDIA 开发者网站上的 NVIDIA Display Mode Selector Tool 页面请求该工具。

只有表中列出的 GPU 支持 displaymodeselector 工具。其他支持 NVIDIA vGPU 软件的 GPU 不支持 displaymodeselector 工具,除非另有说明,否则不需要显示模式切换。

2.4. 安装和配置用于 XenServer 的 NVIDIA 虚拟 GPU 管理器

以下主题将逐步指导您完成设置单个 XenServer VM 以使用 NVIDIA vGPU 的过程。完成此过程后,您可以为您的客户机操作系统安装图形驱动程序,并许可您正在使用的任何 NVIDIA vGPU 软件许可产品。

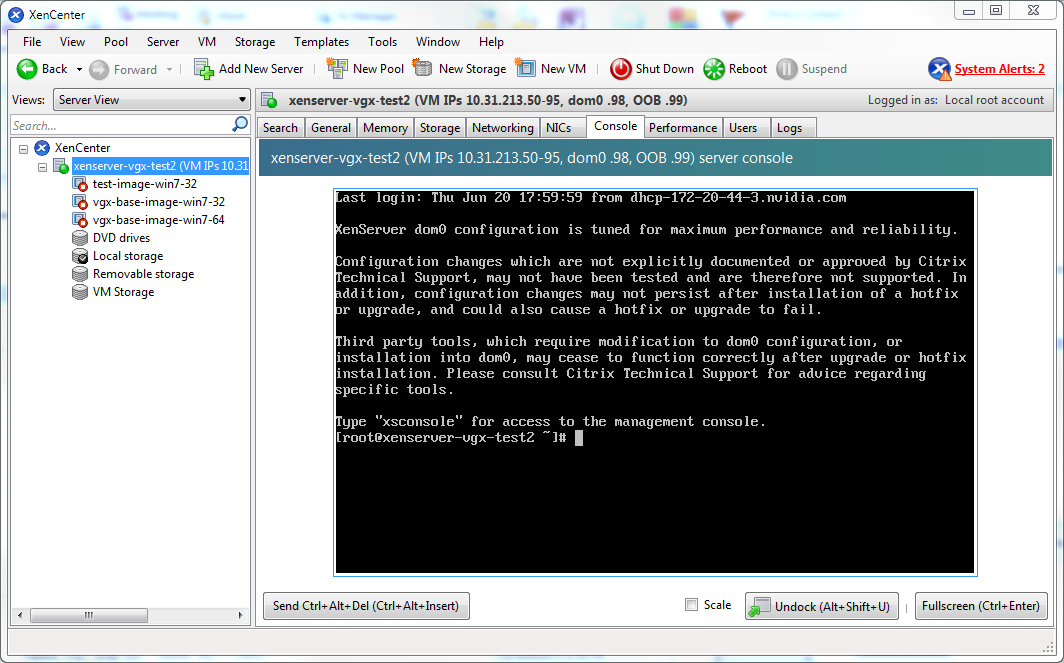

这些设置步骤假定您熟悉 XenServer 基础知识 中介绍的 XenServer 技能。

2.4.1. 安装和更新用于 XenServer 的 NVIDIA 虚拟 GPU 管理器

NVIDIA 虚拟 GPU 管理器在 XenServer dom0 域中运行。用于 XenServer 的 NVIDIA 虚拟 GPU 管理器以 RPM 文件和 Supplemental Pack 的形式提供。

NVIDIA 虚拟 GPU 管理器和客户机 VM 驱动程序必须兼容。如果您将 vGPU 管理器更新到与客户机 VM 驱动程序不兼容的版本,客户机 VM 将在禁用 vGPU 的情况下启动,直到其客户机 vGPU 驱动程序更新到兼容版本。有关更多详细信息,请参阅 用于 XenServer 的虚拟 GPU 软件发行说明。

2.4.1.1. 安装用于 XenServer 的 RPM 软件包

RPM 文件必须在安装前复制到 XenServer dom0 域(请参阅 将文件复制到 dom0)。

- 使用 rpm 命令安装软件包

[root@xenserver ~]# rpm -iv NVIDIA-vGPU-NVIDIA-vGPU-CitrixHypervisor-8.2-550.144.02.x86_64.rpm Preparing packages for installation... NVIDIA-vGPU-NVIDIA-vGPU-CitrixHypervisor-8.2-550.144.02 [root@xenserver ~]#

- 重启 XenServer 平台

[root@xenserver ~]# shutdown –r now Broadcast message from root (pts/1) (Fri Jan 17 14:24:11 2025): The system is going down for reboot NOW! [root@xenserver ~]#

2.4.1.2. 更新用于 XenServer 的 RPM 软件包

如果系统上已安装现有的 NVIDIA 虚拟 GPU 管理器,并且您想要升级,请按照以下步骤操作

- 关闭任何正在使用 NVIDIA vGPU 的 VM。

- 使用 rpm 命令的 –U 选项安装新软件包,以从先前安装的软件包升级

[root@xenserver ~]# rpm -Uv NVIDIA-vGPU-NVIDIA-vGPU-CitrixHypervisor-8.2-550.144.02.x86_64.rpm Preparing packages for installation... NVIDIA-vGPU-NVIDIA-vGPU-CitrixHypervisor-8.2-550.144.02 [root@xenserver ~]#

注意您可以使用 rpm –q 命令查询当前 NVIDIA 虚拟 GPU 管理器软件包的版本

[root@xenserver ~]# rpm –q NVIDIA-vGPU-NVIDIA-vGPU-CitrixHypervisor-8.2-550.144.02 [root@xenserver ~]# If an existing NVIDIA GRID package is already installed and you don’t select the upgrade (-U) option when installing a newer GRID package, the rpm command will return many conflict errors. Preparing packages for installation... file /usr/bin/nvidia-smi from install of NVIDIA-vGPU-NVIDIA-vGPU-CitrixHypervisor-8.2-550.144.02.x86_64 conflicts with file from package NVIDIA-vGPU-xenserver-8.2-550.127.06.x86_64 file /usr/lib/libnvidia-ml.so from install of NVIDIA-vGPU-NVIDIA-vGPU-CitrixHypervisor-8.2-550.144.02.x86_64 conflicts with file from package NVIDIA-vGPU-xenserver-8.2-550.127.06.x86_64 ...

- 重启 XenServer 平台

[root@xenserver ~]# shutdown –r now Broadcast message from root (pts/1) (Fri Jan 17 14:24:11 2025): The system is going down for reboot NOW! [root@xenserver ~]#

2.4.1.3. 安装或更新用于 XenServer 的 Supplemental Pack

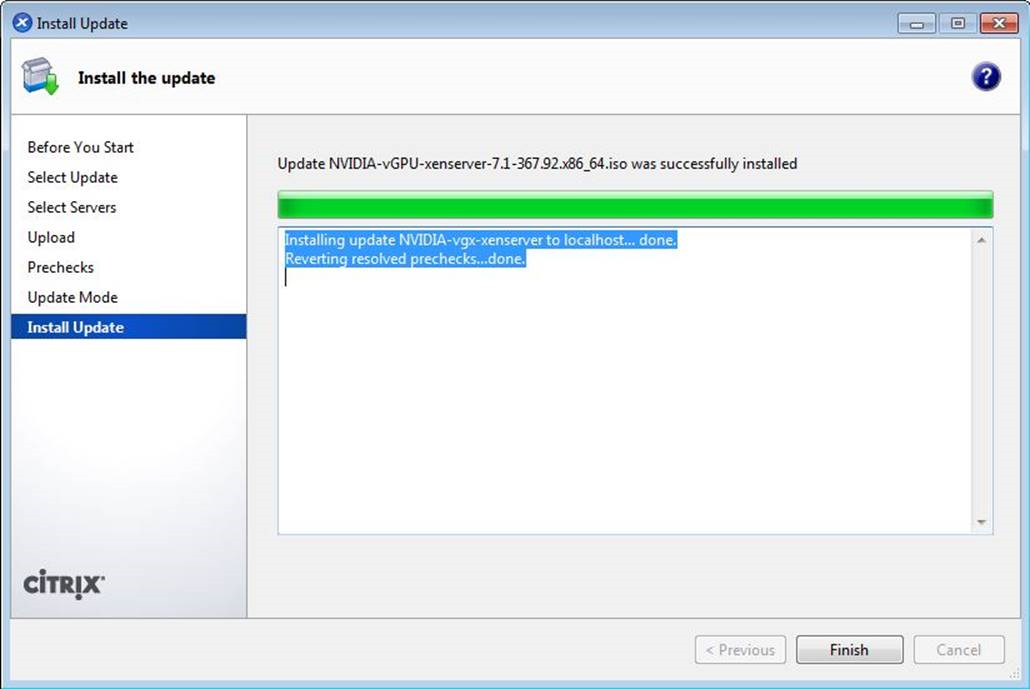

XenCenter 可用于在 XenServer 主机上安装或更新 Supplemental Pack。NVIDIA 虚拟 GPU 管理器 supplemental pack 以 ISO 形式提供。

- 从工具菜单中选择安装更新。

- 在浏览开始之前部分上的说明后,单击下一步。

- 在选择更新部分,单击从磁盘选择更新或 Supplemental Pack,然后打开 NVIDIA 的 XenServer Supplemental Pack ISO。

图 3. 在 XenCenter 中选择的 NVIDIA vGPU 管理器 supplemental pack

- 在选择更新部分,单击下一步。

- 在选择服务器部分,选择应在其上安装 Supplemental Pack 的所有 XenServer 主机,然后单击下一步。

- 在 Supplemental Pack 上传到所有 XenServer 主机后,在上传部分单击下一步。

- 在预检部分单击下一步。

- 在更新模式部分单击安装更新。

- 在安装更新部分单击完成。

图 4. NVIDIA vGPU 管理器 supplemental pack 成功安装

2.4.1.4. 验证用于 XenServer 软件包的 NVIDIA vGPU 软件的安装

XenServer 平台重启后,验证用于 XenServer 的 NVIDIA vGPU 软件包的安装。

- 通过检查内核加载模块列表中是否存在 NVIDIA 内核驱动程序,验证 NVIDIA vGPU 软件包是否已安装并正确加载。

[root@xenserver ~]# lsmod | grep nvidia nvidia 9522927 0 i2c_core 20294 2 nvidia,i2c_i801 [root@xenserver ~]#

- 通过运行 nvidia-smi 命令,验证 NVIDIA 内核驱动程序是否可以与系统中的 NVIDIA 物理 GPU 成功通信。nvidia-smi 命令在 NVIDIA 系统管理界面 nvidia-smi 中进行了更详细的描述。

运行 nvidia-smi 命令应生成平台中 GPU 的列表。

[root@xenserver ~]# nvidia-smi

Fri Jan 17 18:46:50 2025

+------------------------------------------------------+

| NVIDIA-SMI 550.144.02 Driver Version: 550.144.02 |

|-------------------------------+----------------------+----------------------+

| GPU Name Persistence-M| Bus-Id Disp.A | Volatile Uncorr. ECC |

| Fan Temp Perf Pwr:Usage/Cap| Memory-Usage | GPU-Util Compute M. |

|===============================+======================+======================|

| 0 Tesla M60 On | 00000000:05:00.0 Off | Off |

| N/A 25C P8 24W / 150W | 13MiB / 8191MiB | 0% Default |

+-------------------------------+----------------------+----------------------+

| 1 Tesla M60 On | 00000000:06:00.0 Off | Off |

| N/A 24C P8 24W / 150W | 13MiB / 8191MiB | 0% Default |

+-------------------------------+----------------------+----------------------+

| 2 Tesla M60 On | 00000000:86:00.0 Off | Off |

| N/A 25C P8 25W / 150W | 13MiB / 8191MiB | 0% Default |

+-------------------------------+----------------------+----------------------+

| 3 Tesla M60 On | 00000000:87:00.0 Off | Off |

| N/A 28C P8 24W / 150W | 13MiB / 8191MiB | 0% Default |

+-------------------------------+----------------------+----------------------+

+-----------------------------------------------------------------------------+

| Processes: GPU Memory |

| GPU PID Type Process name Usage |

|=============================================================================|

| No running processes found |

+-----------------------------------------------------------------------------+

[root@xenserver ~]#

如果 nvidia-smi 无法运行或未为系统中的所有 NVIDIA GPU 生成预期输出,请参阅 故障排除,以获取故障排除步骤。

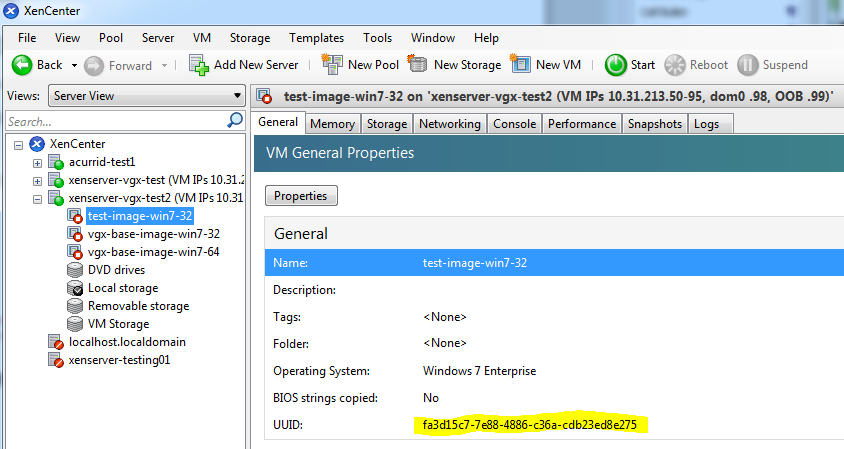

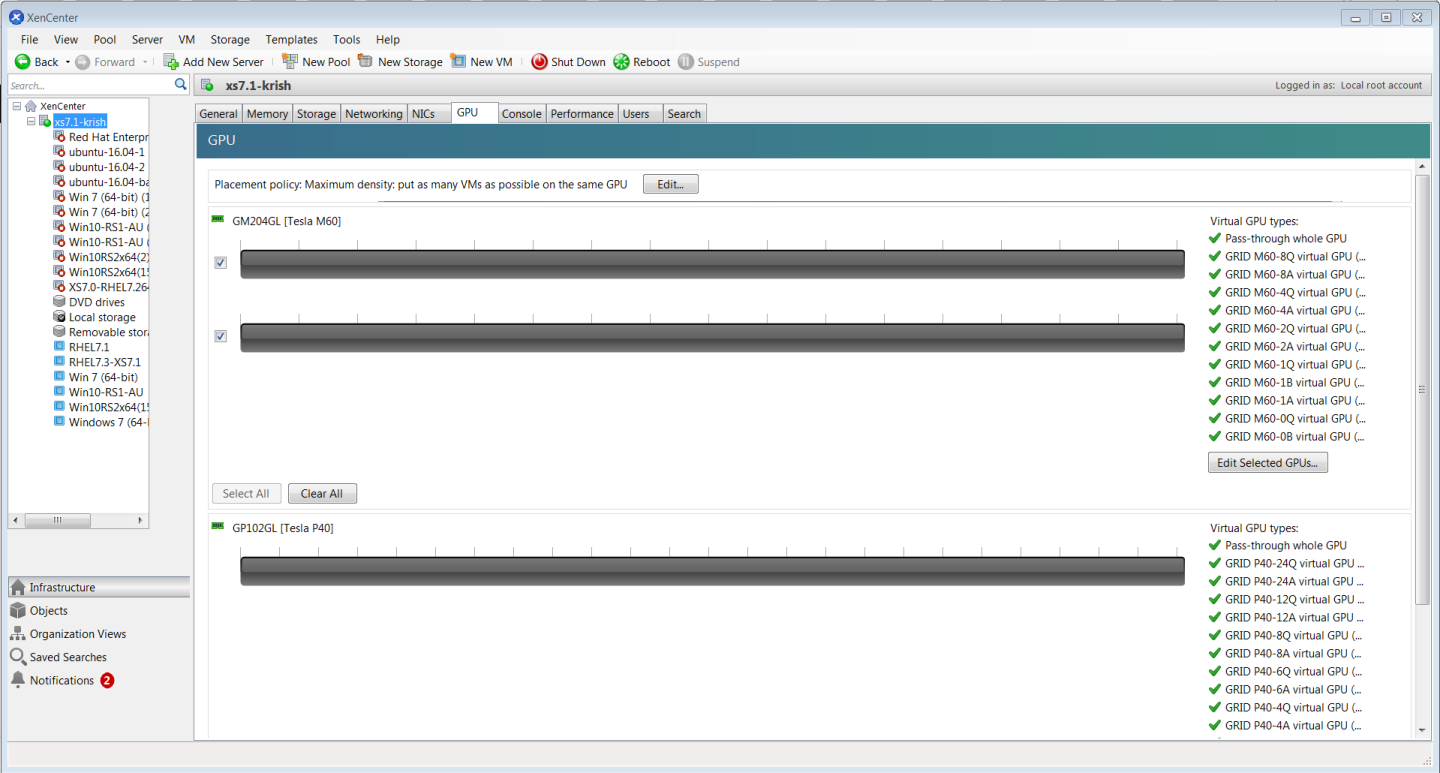

2.4.2. 使用虚拟 GPU 配置 XenServer VM

为了支持计算或图形密集型应用程序和工作负载,您可以向单个 VM 添加多个 vGPU。

有关哪些 XenServer 版本和 NVIDIA vGPU 支持将多个 vGPU 分配给 VM 的详细信息,请参阅 用于 XenServer 的虚拟 GPU 软件发行说明。

XenServer 支持使用 XenCenter 或在 XenServer dom0 shell 中运行的 xe 命令行工具配置和管理虚拟 GPU。以下部分介绍了使用 XenCenter 进行的基本配置。使用 xe 进行命令行管理在 XenServer vGPU 管理 中进行了描述。

如果您使用的是 Citrix Hypervisor 8.1 或更高版本,并且需要分配插件配置参数,请使用 xe 命令创建 vGPU,如 使用 xe 创建 vGPU 中所述。

- 确保 VM 已关闭电源。

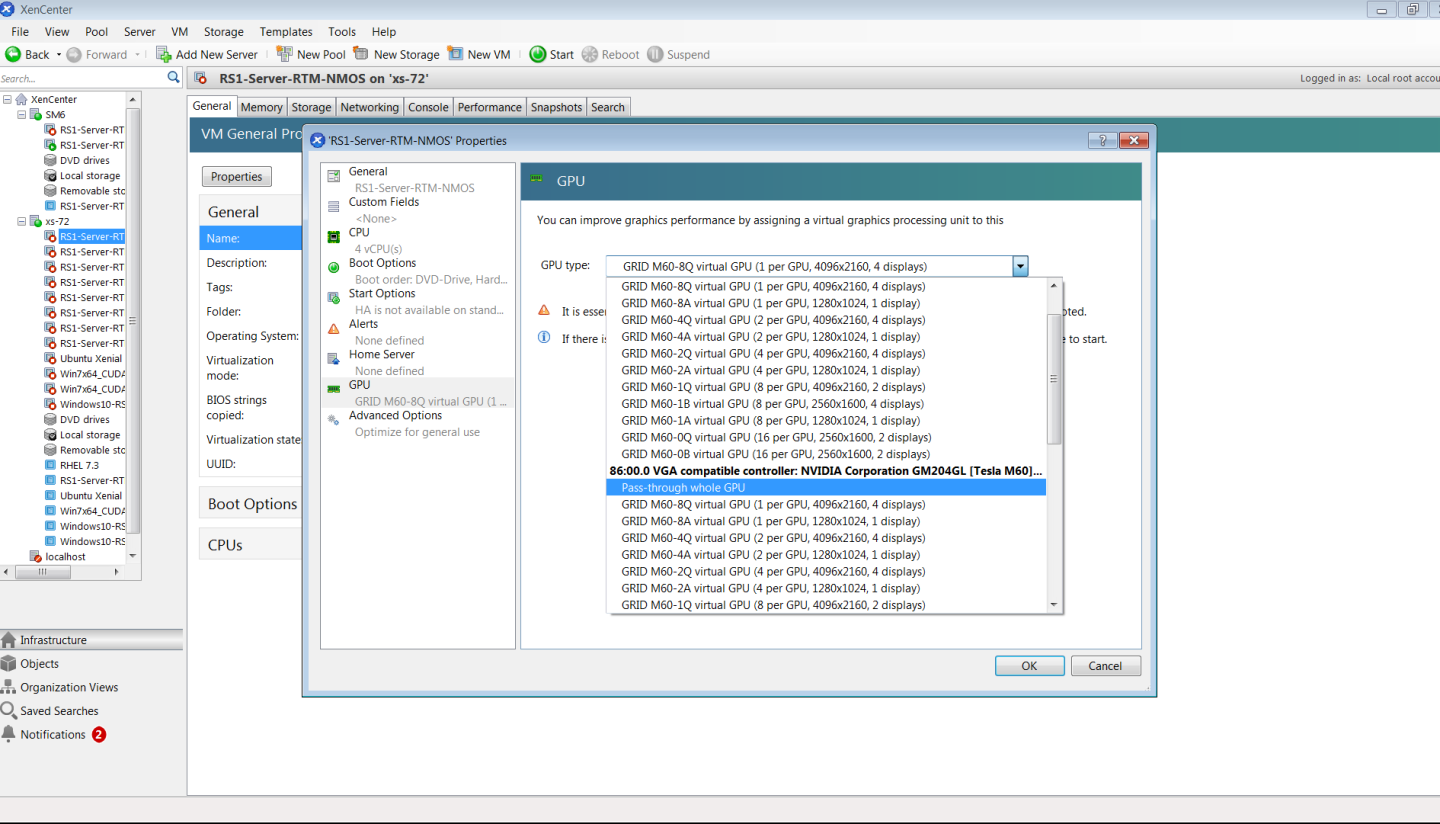

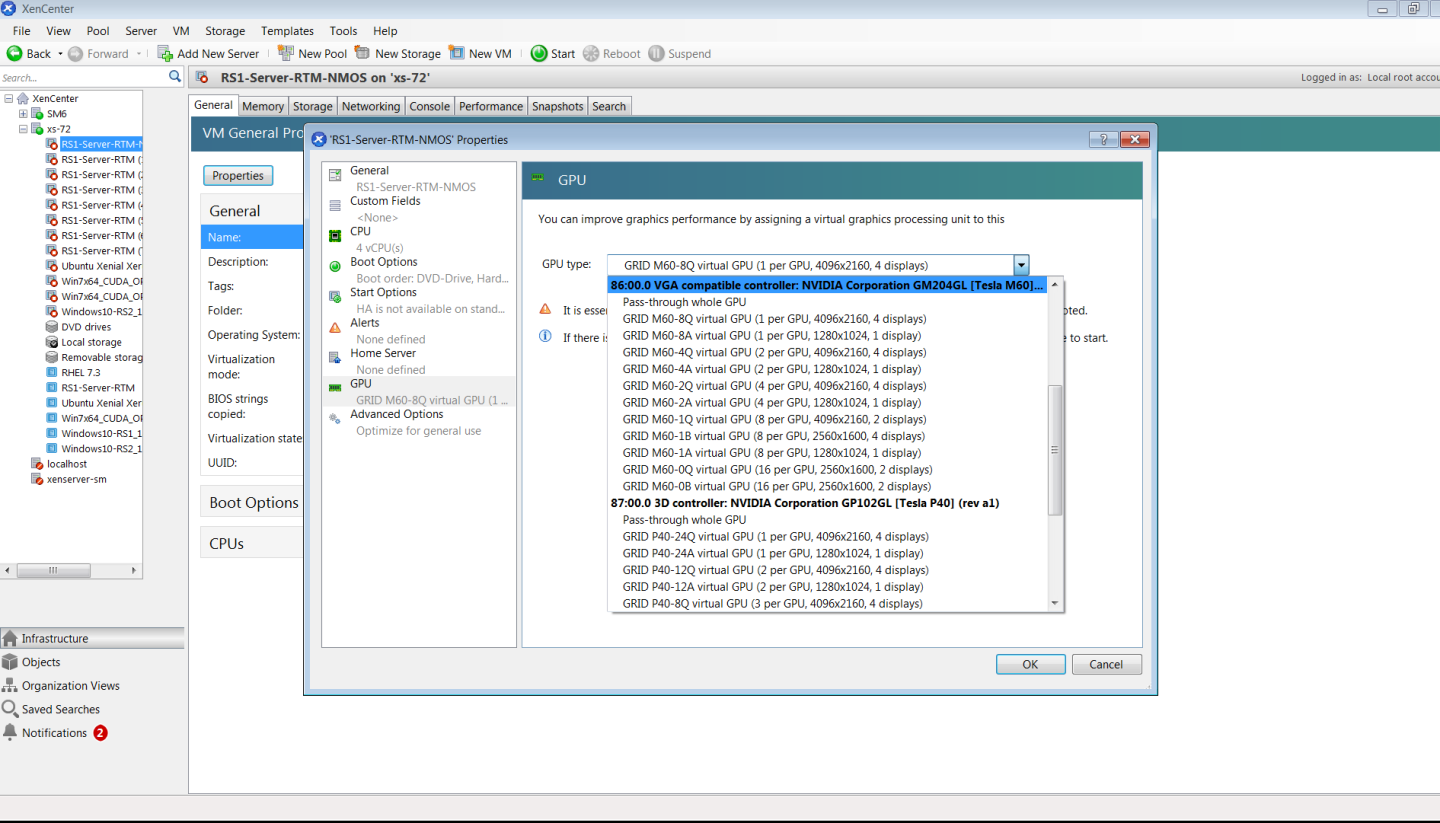

- 在 XenCenter 中右键单击 VM,选择属性以打开 VM 的属性,然后选择 GPU 属性。可用 GPU 类型在 GPU 类型下拉列表中列出:

图 5. 使用 Citrix XenCenter 配置带有 vGPU 的 VM

配置带有 vGPU 的 XenServer VM 后,从 XenCenter 或通过在 dom0 shell 中使用 xe vm-start 启动 VM。您可以在 XenCenter 中查看 VM 的控制台。

VM 启动后,安装 NVIDIA vGPU 软件图形驱动程序,如 安装 NVIDIA vGPU 软件图形驱动程序 中所述。

2.4.3. 在 XenServer 上设置 vGPU 插件参数

vGPU 的插件参数控制 vGPU 的行为,例如每秒帧数 (FPS) 的帧率限制器 (FRL) 配置,或者是否启用 vGPU 的控制台虚拟网络计算 (VNC)。分配了 vGPU 的 VM 将使用这些参数启动。如果为分配给同一 VM 的多个 vGPU 设置了参数,则 VM 将使用分配给每个 vGPU 的参数启动。

对于要设置插件参数的每个 vGPU,在 XenServer dom0 域的命令 shell 中执行此任务。

- 获取 hypervisor 主机上所有 VM 的 UUID,并使用该命令的输出标识分配了 vGPU 的 VM。

[root@xenserver ~] xe vm-list ... uuid ( RO) : 7f6c855d-5635-2d57-9fbc-b1200172162f name-label ( RW): RHEL8.3 power-state ( RO): running ...

- 获取 hypervisor 主机上所有 vGPU 的 UUID,并从分配了 vGPU 的 VM 的 UUID 中,确定 vGPU 的 UUID。

[root@xenserver ~] xe vgpu-list ... uuid ( RO) : d15083f8-5c59-7474-d0cb-fbc3f7284f1b vm-uuid ( RO): 7f6c855d-5635-2d57-9fbc-b1200172162f device ( RO): 0 gpu-group-uuid ( RO): 3a2fbc36-827d-a078-0b2f-9e869ae6fd93 ...

- 使用 xe 命令设置要设置的每个 vGPU 插件参数。

[root@xenserver ~] xe vgpu-param-set uuid=vgpu-uuid extra_args='parameter=value'

- vgpu-uuid

- vGPU 的 UUID,您在上一步中获得。

- parameter

- 要设置的 vGPU 插件参数的名称。

- value

- 要将 vGPU 插件参数设置到的值。

此示例将 UUID 为

d15083f8-5c59-7474-d0cb-fbc3f7284f1b的 vGPU 的 enable_uvm vGPU 插件参数设置为 1。此参数设置启用 vGPU 的统一内存。[root@xenserver ~] xe vgpu-param-set uuid=d15083f8-5c59-7474-d0cb-fbc3f7284f1b extra_args='enable_uvm=1'

2.5. 安装用于 Linux KVM 的虚拟 GPU 管理器软件包

用于基于 Linux 内核的虚拟机 (KVM) (Linux KVM) 的 NVIDIA vGPU 软件仅适用于受支持版本的 Linux KVM hypervisor。有关支持哪些 Linux KVM hypervisor 版本的详细信息,请参阅 用于通用 Linux 与 KVM 的虚拟 GPU 软件发行说明。

如果您使用的是 Red Hat Enterprise Linux KVM,请按照 安装和配置用于 Red Hat Enterprise Linux KVM 的 NVIDIA 虚拟 GPU 管理器 中的说明进行操作。

在安装用于 Linux KVM 的虚拟 GPU 管理器软件包之前,请确保满足以下先决条件

-

以下软件包已安装在 Linux KVM 服务器上

- GNU 编译器集合 (GCC) 的

x86_64版本 - Linux 内核头文件

- GNU 编译器集合 (GCC) 的

-

软件包文件已复制到 Linux KVM 服务器文件系统中的目录中。

如果存在用于 NVIDIA 显卡的 Nouveau 驱动程序,请在安装软件包之前禁用它。

- 更改为 Linux KVM 服务器上包含软件包文件的目录。

# cd package-file-directory

- package-file-directory

- 包含软件包文件的目录的路径。

- 使软件包文件可执行。

# chmod +x package-file-name

- package-file-name

- 包含用于 Linux KVM 的虚拟 GPU 管理器软件包的文件名,例如 NVIDIA-Linux-x86_64-390.42-vgpu-kvm.run。

- 以 root 用户身份运行软件包文件。

# sudo sh./package-file-name

- 接受许可协议以继续安装。

- 安装完成后,选择确定退出安装程序。

- 重启 Linux KVM 服务器。

# systemctl reboot

2.6. 安装和配置用于 Microsoft Azure Local 的 NVIDIA 虚拟 GPU 管理器

在开始之前,请确保满足 使用 NVIDIA vGPU 的先决条件 中的先决条件,并且 Microsoft Azure Local 主机按如下方式配置

- Microsoft Azure Local OS 已安装,如 Microsoft 文档站点上的 部署 Azure Stack HCI 操作系统 中所述。

- 已启用以下 BIOS 设置

- 虚拟化支持,例如,Intel 虚拟化技术 (VT-D) 或 AMD 虚拟化 (AMD-V)

- SR-IOV

- Above 4G Decoding

- 对于 Supermicro 服务器:ASPM 支持

- 对于具有 AMD CPU 的服务器

- 备用路由 ID 解释 (ARI)

- 访问控制服务 (ACS)

- 高级错误报告 (AER)

按照以下说明顺序设置单个 Microsoft Azure Local VM 以使用 NVIDIA vGPU。

- 安装用于 Microsoft Azure Local 的 NVIDIA 虚拟 GPU 管理器

- 设置 GPU 上允许的 vGPU 系列

- 向 Microsoft Azure Local VM 添加 vGPU

这些说明假定您熟悉 Microsoft 文档站点上的 使用 Windows PowerShell 在 Azure Local 上管理 VM 中介绍的 Microsoft Windows PowerShell 命令。

完成设置后,您可以为您的客户机操作系统安装图形驱动程序,并许可您正在使用的任何 NVIDIA vGPU 软件许可产品。

2.6.1. 安装用于 Microsoft Azure Local 的 NVIDIA 虚拟 GPU 管理器

用于虚拟 GPU 管理器的驱动程序软件包以存档文件形式分发。您必须解压缩此存档文件的内容,以便能够从安装信息文件将软件包添加到驱动程序存储。

在 Windows PowerShell 窗口中以管理员用户身份执行此任务。

- 下载分发虚拟 GPU 管理器驱动程序软件包的存档文件。

- 将存档文件的内容解压缩到可从 Microsoft Azure Local 主机访问的目录中。

- 更改为从存档文件中解压缩的 GridSW-Azure-Local 目录。注意

对于 NVIDIA vGPU 软件版本 17.0-17.4,更改为 GridSW-Azure-Stack-HCI 目录。

- 使用 PnPUtil 工具从 nvgridswhci.inf 安装信息文件将虚拟 GPU 管理器的驱动程序软件包添加到驱动程序存储。在用于添加驱动程序软件包的命令中,同时设置选项以遍历子目录查找驱动程序软件包,并在必要时重启 Microsoft Azure Local 主机以完成操作。

PS C:> pnputil /add-driver nvgridswhci.inf /subdirs /install /reboot

- 主机重启后,验证 NVIDIA 虚拟 GPU 管理器是否可以与系统中的 NVIDIA 物理 GPU 成功通信。为此目的,运行不带参数的 nvidia-smi 命令。运行 nvidia-smi 命令应生成平台中 GPU 的列表。

- 确认 Microsoft Azure Local 主机具有可以通过列出支持 GPU-P 的 GPU 来分区的 GPU 适配器。

PS C:> Get-VMHostPartitionableGpu

- 对于每个 GPU,将 GPU 应支持的分区数设置为可以添加到 GPU 的最大 vGPU 数。

PS C:> Set-VMHostPartitionableGpu -Name "gpu-name" -PartitionCount partitions

- gpu-name

- 在上一步中获得的用于引用 GPU 的唯一名称。

- partitions

- 可以添加到 GPU 的最大 vGPU 数。此数字取决于虚拟 GPU 类型。例如,可以添加到 NVIDIA A16 GPU 的每种类型的 vGPU 的最大数量如下

虚拟 GPU 类型 每个 GPU 的最大 vGPU 数 A16-16Q

A16-16A

1 A16-8Q

A16-8A

2 A16-4Q

A16-4A

4 A16-2Q

A16-2B

A16-2A

8 A16-1Q

A16-1B

A16-1A

16

2.6.2. 设置 GPU 上允许的 vGPU 系列

虚拟 GPU 管理器允许仅从一个 vGPU 系列在 GPU 上创建虚拟 GPU (vGPU)。默认情况下,只能在 GPU 上创建 Q 系列 vGPU。您可以通过在 Windows 注册表中设置 GPU 的 GridGpupProfileType 值来更改 GPU 上允许的 vGPU 系列。

此任务需要管理员用户权限。

- 使用 Windows PowerShell 获取要在其上设置允许的 vGPU 系列的 GPU 的驱动程序密钥。在下一步中,您将需要此信息来识别 Windows 注册表项,其中存储了有关 GPU 的信息。

- 获取要在其上设置允许的 vGPU 系列的 GPU 的

InstanceID属性。PS C:\> Get-PnpDevice -PresentOnly | >> Where-Object {$_.InstanceId -like "PCI\VEN_10DE*" } | >> Select-Object -Property FriendlyName,InstanceId | >> Format-List FriendlyName : NVIDIA A100 InstanceId : PCI\VEN_10DE&DEV_2236&SUBSYS_148210DE&REV_A1\6&17F903&0&00400000

- 从您在上一步中获得的

InstanceID属性中,获取 GPU 的DEVPKEY_Device_Driver属性。PS C:\> Get-PnpDeviceProperty -InstanceId "instance-id" | >> where {$_.KeyName -eq "DEVPKEY_Device_Driver"} | >> Select-Object -Property Data Data ---- {4d36e968-e325-11ce-bfc1-08002be10318}\0001

- instance-id

- 您在上一步中获得的 GPU 的

InstanceID属性,例如,PCI\VEN_10DE&DEV_2236&SUBSYS_148210DE&REV_A1\6&17F903&0&00400000。

- 获取要在其上设置允许的 vGPU 系列的 GPU 的

- 在 Windows 注册表项

HKEY_LOCAL_MACHINE\SYSTEM\ControlSet001\Control\Class\<i>driver-key</i>中设置GridGpupProfileTypeDWord (REG_DWORD) 注册表值。- driver-key

- 您在上一步中获得的 GPU 的驱动程序密钥,例如,

{4d36e968-e325-11ce-bfc1-08002be10318}\0001。

要设置的值取决于您希望在 GPU 上允许的 vGPU 系列。

vGPU 系列 值 Q 系列 1 A 系列 2 B 系列 3

2.6.3. 向 Microsoft Azure Local VM 添加 vGPU

您可以通过向 VM 添加 GPU-P 适配器来向 Microsoft Azure Local VM 添加 vGPU。

在 Windows PowerShell 窗口中以管理员用户身份执行此任务。

- 将变量

$vm设置为您要向其添加 vGPU 的虚拟机的名称。PS C:> $vm = "vm-name"

- vm-name

- 您要向其添加 vGPU 的虚拟机的名称。

- 允许 VM 控制 MMIO 访问的缓存类型。

PS C:> Set-VM -GuestControlledCacheTypes $true -VMName $vm

- 将较低的 MMIO 空间设置为 1 GB,以便允许映射足够的 MMIO 空间。

PS C:> Set-VM -LowMemoryMappedIoSpace 1Gb -VMName $vm

此数量是设备必须允许对齐的数量的两倍。较低的 MMIO 空间是 4 GB 以下的地址空间,对于任何具有 32 位 BAR 内存的设备都是必需的。

- 将较高的 MMIO 空间设置为 32 GB,以便允许映射足够的 MMIO 空间。

PS C:> Set-VM –HighMemoryMappedIoSpace 32GB –VMName $vm

此数量是设备必须允许对齐的数量的两倍。较高的 MMIO 空间是大约 64 GB 以上的地址空间。

- 确认 Microsoft Azure Local 主机具有支持您要创建的 GPU-P 适配器的 GPU。

PS C:> get-VMHostPartitionableGpu

- 向 VM 添加 GPU-P 适配器。

PS C:> Add-VMGpuPartitionAdapter –VMName $vm ` –MinPartitionVRAM min-ram ` -MaxPartitionVRAM max-ram ` -OptimalPartitionVRAM opt-ram ` -MinPartitionEncode min-enc ` -MaxPartitionEncode max-enc ` -OptimalPartitionEncode opt-enc ` -MinPartitionDecode min-dec ` -MaxPartitionDecode max-dec ` -OptimalPartitionDecode opt-dec ` -MinPartitionCompute min-compute ` -MaxPartitionCompute max-compute ` -OptimalPartitionCompute opt-compute

注意由于分区仅在 VM 启动时解析,因此此命令无法验证 Microsoft Azure Local 主机是否具有支持您要创建的 GPU-P 适配器的 GPU。您指定的值必须在在上一步中列出的最大值和最小值范围内。

- 列出分配给 VM 的适配器,以确认 GPU-P 适配器已添加到 VM。

PS C:> Get-VMGpuPartitionAdapter –VMName $vm

此命令还返回用于重新配置或删除 GPU 分区的适配器 ID。

- 连接并启动 VM。

2.6.4. 卸载用于 Microsoft Azure Local 的 NVIDIA 虚拟 GPU 管理器

如果您不再需要在 Microsoft Azure Local 服务器上使用虚拟 GPU 管理器,您可以卸载虚拟 GPU 管理器的驱动程序软件包。

在 Windows PowerShell 窗口中以管理员用户身份执行此任务。

- 通过枚举驱动程序存储中的所有第三方驱动程序软件包,确定虚拟 GPU 管理器的驱动程序软件包的已发布名称。

PS C:> pnputil /enum-drivers

Microsoft PnP Utility ... Published name : oem5.inf Driver package provider : NVIDIA Class : Display adapters Driver date and version : 01/01/2023 31.0.15.2807 Signer name : Microsoft Windows Hardware Compatibility Publisher ...

- 删除并卸载虚拟 GPU 管理器的驱动程序软件包。

PS C:> pnputil /delete-driver vgpu-manager-package-published-name /uninstall /reboot

- vgpu-manager-package-published-name

- 您在上一步中获得的虚拟 GPU 管理器的驱动程序软件包的已发布名称,例如,oem5.inf。

此示例删除并卸载已发布名称为 oem5.inf 的驱动程序软件包。

PS C:> pnputil.exe /delete-driver oem5.inf /uninstall /reboot Microsoft PnP Utility Driver package uninstalled. Driver package deleted successfully.

如有必要,将重启 Microsoft Azure Local 服务器。

2.7. 安装和配置用于 Red Hat Enterprise Linux KVM 的 NVIDIA 虚拟 GPU 管理器

以下主题将逐步指导您完成设置单个 Red Hat Enterprise Linux 基于内核的虚拟机 (KVM) VM 以使用 NVIDIA vGPU 的过程。

VM 控制台的输出对于正在运行 vGPU 的 VM 不可用。在配置 vGPU 之前,请确保您已安装访问 VM 的替代方法(例如 VNC 服务器)。

按照以下说明顺序操作

- 安装用于 Red Hat Enterprise Linux KVM 的虚拟 GPU 管理器软件包

- 验证用于 Red Hat Enterprise Linux KVM 的 NVIDIA vGPU 软件的安装

- 仅支持 SR-IOV 的 vGPU:在具有 KVM Hypervisor 的 Linux 上为支持 SR-IOV 的 NVIDIA vGPU 准备虚拟功能

- 可选:将 GPU 置于混合大小模式

- 在具有 KVM Hypervisor 的 Linux 上获取 GPU 的 BDF 和域

- 在具有 KVM Hypervisor 的 Linux 上创建 NVIDIA vGPU

- 向具有 KVM Hypervisor 的 Linux VM 添加一个或多个 vGPU

- 可选:在具有 KVM Hypervisor 的 Linux 上将 vGPU 放置在混合大小模式的物理 GPU 上

- 在具有 KVM Hypervisor 的 Linux 上设置 vGPU 插件参数

完成此过程后,您可以为您的客户机操作系统安装图形驱动程序,并许可您正在使用的任何 NVIDIA vGPU 软件许可产品。

如果您使用的是通用 Linux KVM hypervisor,请按照 安装用于 Linux KVM 的虚拟 GPU 管理器软件包 中的说明进行操作。

2.7.1. 安装用于 Red Hat Enterprise Linux KVM 的虚拟 GPU 管理器软件包

用于 Red Hat Enterprise Linux KVM 的 NVIDIA 虚拟 GPU 管理器以 .rpm 文件的形式提供。

NVIDIA 虚拟 GPU 管理器和客户机 VM 驱动程序必须兼容。如果您将 vGPU 管理器更新到与客户机 VM 驱动程序不兼容的版本,客户机 VM 将在禁用 vGPU 的情况下启动,直到其客户机 vGPU 驱动程序更新到兼容版本。有关更多详细信息,请参阅 用于 Red Hat Enterprise Linux 与 KVM 的虚拟 GPU 软件发行说明。

在安装用于 Red Hat Enterprise Linux KVM 的 RPM 软件包之前,请确保 Red Hat Enterprise Linux KVM 服务器上的 sshd 服务配置为允许 root 登录。如果存在用于 NVIDIA 显卡的 Nouveau 驱动程序,请在安装软件包之前禁用它。有关说明,请参阅 如何在 RHEL 7 中禁用 Nouveau 驱动程序并安装 Nvidia 驱动程序(需要 Red Hat 订阅)。

某些版本的 Red Hat Enterprise Linux KVM 具有 z-stream 更新,这些更新会破坏内核应用程序二进制接口 (kABI) 与先前内核或 GA 内核的兼容性。对于这些版本的 Red Hat Enterprise Linux KVM,提供以下虚拟 GPU 管理器 RPM 软件包

- 用于 GA Linux KVM 内核的软件包

- 用于更新的 z-stream 内核的软件包

为了区分这些软件包,每个 RPM 软件包的名称都包含内核版本。确保您安装的 RPM 软件包与您的 Linux KVM 内核版本兼容。

- 将 RPM 文件从您下载该文件的系统安全地复制到 Red Hat Enterprise Linux KVM 服务器。

- 从 Windows 系统,使用安全复制客户端,例如 WinSCP。

- 从 Linux 系统,使用 scp 命令。

- 使用安全 shell (SSH) 以 root 身份登录到 Red Hat Enterprise Linux KVM 服务器。

# ssh root@kvm-server

- kvm-server

- Red Hat Enterprise Linux KVM 服务器的主机名或 IP 地址。

- 更改为 Red Hat Enterprise Linux KVM 服务器上您复制 RPM 文件的目录。

# cd rpm-file-directory

- rpm-file-directory

- 您复制 RPM 文件的目录的路径。

- 使用 rpm 命令安装软件包。

# rpm -iv NVIDIA-vGPU-rhel-8.9-550.144.02.x86_64.rpm Preparing packages for installation... NVIDIA-vGPU-rhel-8.9-550.144.02 #

- 重启 Red Hat Enterprise Linux KVM 服务器。

# systemctl reboot

2.7.2. 验证用于 Red Hat Enterprise Linux KVM 的 NVIDIA vGPU 软件的安装

Red Hat Enterprise Linux KVM 服务器重启后,验证用于 Red Hat Enterprise Linux KVM 的 NVIDIA vGPU 软件包的安装。

- 通过检查内核加载模块列表中是否存在 VFIO 驱动程序,验证 NVIDIA vGPU 软件包是否已安装并正确加载。

# lsmod | grep vfio nvidia_vgpu_vfio 27099 0 nvidia 12316924 1 nvidia_vgpu_vfio vfio_mdev 12841 0 mdev 20414 2 vfio_mdev,nvidia_vgpu_vfio vfio_iommu_type1 22342 0 vfio 32331 3 vfio_mdev,nvidia_vgpu_vfio,vfio_iommu_type1 #

- 验证 libvirtd 服务是否处于活动状态并正在运行。

# service libvirtd status

- 通过运行 nvidia-smi 命令,验证 NVIDIA 内核驱动程序是否可以与系统中的 NVIDIA 物理 GPU 成功通信。nvidia-smi 命令在 NVIDIA 系统管理界面 nvidia-smi 中进行了更详细的描述。

运行 nvidia-smi 命令应生成平台中 GPU 的列表。

# nvidia-smi

Fri Jan 17 18:46:50 2025

+------------------------------------------------------+

| NVIDIA-SMI 550.144.02 Driver Version: 550.144.02 |

|-------------------------------+----------------------+----------------------+

| GPU Name Persistence-M| Bus-Id Disp.A | Volatile Uncorr. ECC |

| Fan Temp Perf Pwr:Usage/Cap| Memory-Usage | GPU-Util Compute M. |

|===============================+======================+======================|

| 0 Tesla M60 On | 0000:85:00.0 Off | Off |

| N/A 23C P8 23W / 150W | 13MiB / 8191MiB | 0% Default |

+-------------------------------+----------------------+----------------------+

| 1 Tesla M60 On | 0000:86:00.0 Off | Off |

| N/A 29C P8 23W / 150W | 13MiB / 8191MiB | 0% Default |

+-------------------------------+----------------------+----------------------+

| 2 Tesla P40 On | 0000:87:00.0 Off | Off |

| N/A 21C P8 18W / 250W | 53MiB / 24575MiB | 0% Default |

+-------------------------------+----------------------+----------------------+

+-----------------------------------------------------------------------------+

| Processes: GPU Memory |

| GPU PID Type Process name Usage |

|=============================================================================|

| No running processes found |

+-----------------------------------------------------------------------------+

#

如果 nvidia-smi 无法运行或未为系统中的所有 NVIDIA GPU 生成预期输出,请参阅 故障排除,以获取故障排除步骤。

2.8. 安装和配置用于 Ubuntu 的 NVIDIA 虚拟 GPU 管理器

按照以下说明顺序设置单个 Ubuntu VM 以使用 NVIDIA vGPU。

- 安装用于 Ubuntu 的 NVIDIA 虚拟 GPU 管理器

- 在具有 KVM Hypervisor 的 Linux 上获取 GPU 的 BDF 和域

- 仅支持 SR-IOV 的 vGPU:在具有 KVM Hypervisor 的 Linux 上为支持 SR-IOV 的 NVIDIA vGPU 准备虚拟功能

- 可选:将 GPU 置于混合大小模式

- 在具有 KVM Hypervisor 的 Linux 上创建 NVIDIA vGPU

- 向具有 KVM Hypervisor 的 Linux VM 添加一个或多个 vGPU

- 可选:在具有 KVM Hypervisor 的 Linux 上将 vGPU 放置在混合大小模式的物理 GPU 上

- 在具有 KVM Hypervisor 的 Linux 上设置 vGPU 插件参数

VM 控制台的输出对于正在运行 vGPU 的 VM 不可用。在配置 vGPU 之前,请确保您已安装访问 VM 的替代方法(例如 VNC 服务器)。

完成此过程后,您可以为您的客户机操作系统安装图形驱动程序,并许可您正在使用的任何 NVIDIA vGPU 软件许可产品。

2.8.1. 安装用于 Ubuntu 的 NVIDIA 虚拟 GPU 管理器

用于 Ubuntu 的 NVIDIA 虚拟 GPU 管理器以 Debian 软件包 (.deb) 文件的形式提供。

NVIDIA 虚拟 GPU 管理器和客户机 VM 驱动程序必须兼容。如果您将 vGPU 管理器更新到与客户机 VM 驱动程序不兼容的版本,客户机 VM 将在禁用 vGPU 的情况下启动,直到其客户机 vGPU 驱动程序更新到兼容版本。有关更多详细信息,请参阅 用于 Ubuntu 的虚拟 GPU 软件发行说明。

2.8.1.1. 安装用于 Ubuntu 的虚拟 GPU 管理器软件包

在安装用于 Ubuntu 的 Debian 软件包之前,请确保 Ubuntu 服务器上的 sshd 服务配置为允许 root 登录。如果存在用于 NVIDIA 显卡的 Nouveau 驱动程序,请在安装软件包之前禁用它。

- 将 Debian 软件包文件从您下载该文件的系统安全地复制到 Ubuntu 服务器。

- 从 Windows 系统,使用安全复制客户端,例如 WinSCP。

- 从 Linux 系统,使用 scp 命令。

- 使用安全 shell (SSH) 以 root 身份登录到 Ubuntu 服务器。

# ssh root@ubuntu-server

- ubuntu-server

- Ubuntu 服务器的主机名或 IP 地址。

- 更改为 Ubuntu 服务器上您复制 Debian 软件包文件的目录。

# cd deb-file-directory

- deb-file-directory

- 您复制 Debian 软件包文件的目录的路径。

- 使用 apt 命令安装软件包。

# apt install ./nvidia-vgpu-ubuntu-550.144.02_amd64.deb

- 重启 Ubuntu 服务器。

# systemctl reboot

2.8.1.2. 验证用于 Ubuntu 的 NVIDIA vGPU 软件的安装

Ubuntu 服务器重启后,验证用于 Ubuntu 的 NVIDIA vGPU 软件包的安装。

- 通过检查内核加载模块列表中是否存在 VFIO 驱动程序,验证 NVIDIA vGPU 软件包是否已安装并正确加载。

# lsmod | grep vfio nvidia_vgpu_vfio 27099 0 nvidia 12316924 1 nvidia_vgpu_vfio vfio_mdev 12841 0 mdev 20414 2 vfio_mdev,nvidia_vgpu_vfio vfio_iommu_type1 22342 0 vfio 32331 3 vfio_mdev,nvidia_vgpu_vfio,vfio_iommu_type1 #

- 验证 libvirtd 服务是否处于活动状态并正在运行。

# service libvirtd status

- 通过运行 nvidia-smi 命令,验证 NVIDIA 内核驱动程序是否可以与系统中的 NVIDIA 物理 GPU 成功通信。nvidia-smi 命令在 NVIDIA 系统管理界面 nvidia-smi 中进行了更详细的描述。

运行 nvidia-smi 命令应生成平台中 GPU 的列表。

# nvidia-smi

Fri Jan 17 18:46:50 2025

+------------------------------------------------------+

| NVIDIA-SMI 550.144.02 Driver Version: 550.144.02 |

|-------------------------------+----------------------+----------------------+

| GPU Name Persistence-M| Bus-Id Disp.A | Volatile Uncorr. ECC |

| Fan Temp Perf Pwr:Usage/Cap| Memory-Usage | GPU-Util Compute M. |

|===============================+======================+======================|

| 0 Tesla M60 On | 0000:85:00.0 Off | Off |

| N/A 23C P8 23W / 150W | 13MiB / 8191MiB | 0% Default |

+-------------------------------+----------------------+----------------------+

| 1 Tesla M60 On | 0000:86:00.0 Off | Off |

| N/A 29C P8 23W / 150W | 13MiB / 8191MiB | 0% Default |

+-------------------------------+----------------------+----------------------+

| 2 Tesla P40 On | 0000:87:00.0 Off | Off |

| N/A 21C P8 18W / 250W | 53MiB / 24575MiB | 0% Default |

+-------------------------------+----------------------+----------------------+

+-----------------------------------------------------------------------------+

| Processes: GPU Memory |

| GPU PID Type Process name Usage |

|=============================================================================|

| No running processes found |

+-----------------------------------------------------------------------------+

#

如果 nvidia-smi 无法运行或未为系统中的所有 NVIDIA GPU 生成预期输出,请参阅 故障排除,以获取故障排除步骤。

2.9. 安装和配置用于 VMware vSphere 的 NVIDIA 虚拟 GPU 管理器

您可以使用用于 VMware vSphere 的 NVIDIA 虚拟 GPU 管理器来设置 VMware vSphere VM 以使用 NVIDIA vGPU。

某些服务器(例如 Dell R740)如果服务器上禁用了 SR-IOV SBIOS 设置,则不会配置 SR-IOV 功能。如果您在服务器上将 Tesla T4 GPU 与 VMware vSphere 一起使用,则必须确保服务器上启用了 SR-IOV SBIOS 设置。

但是,对于任何服务器硬件,请勿在 VMware vCenter Server 中为 Tesla T4 GPU 启用 SR-IOV。如果在 VMware vCenter Server 中为 T4 启用了 SR-IOV,则 VMware vCenter Server 会将 GPU 的状态列为需要重启。您可以忽略此状态消息。

NVIDIA vGPU 说明

Xorg 服务对于 NVIDIA vGPU 模式下的图形设备不是必需的。有关更多信息,请参阅 安装和更新用于 VMware vSphere 的 NVIDIA 虚拟 GPU 管理器。

要设置 VMware vSphere VM 以使用 NVIDIA vGPU,请按照以下说明顺序操作

- 安装和更新用于 VMware vSphere 的 NVIDIA 虚拟 GPU 管理器

- 为 VMware vSphere 配置带有 vGPU 的 VMware vMotion

- 在 VMware vSphere 中更改默认图形类型

- 使用 NVIDIA vGPU 配置 vSphere VM

- 可选:在 VMware vSphere 上设置 vGPU 插件参数

配置 vSphere VM 以使用 NVIDIA vGPU 后,您可以为您的客户机操作系统安装 NVIDIA vGPU 软件图形驱动程序,并许可您正在使用的任何 NVIDIA vGPU 软件许可产品。

在 DRS 群集中配置 NVIDIA vGPU 的要求

您可以在 VMware Distributed Resource Scheduler (DRS) 群集中的 ESXi 主机上配置带有 NVIDIA vGPU 的 VM。但是,为了确保群集的自动化级别支持配置了 NVIDIA vGPU 的 VM,您必须将自动化级别设置为部分自动化或手动。

有关这些设置的更多信息,请参阅 VMware 文档中的 编辑群集设置。

2.9.1. 安装和更新用于 VMware vSphere 的 NVIDIA 虚拟 GPU 管理器

NVIDIA 虚拟 GPU 管理器在 ESXi 主机上运行。它以 ZIP 存档中的多个软件组件的形式分发。

NVIDIA 虚拟 GPU 管理器软件组件如下

- 用于 NVIDIA vGPU hypervisor 主机驱动程序的软件组件

- 用于 NVIDIA GPU 管理守护程序的软件组件

您可以通过以下方式之一安装这些软件组件

- 通过将软件组件复制到 ESXi 主机,然后按照在 VMware vSphere 上安装 NVIDIA Virtual GPU Manager中的说明进行安装

- 通过手动导入软件组件,具体步骤请参考 VMware vSphere 文档中的手动导入补丁

NVIDIA Virtual GPU Manager 和 Guest VM 驱动程序必须兼容。如果您将 vGPU Manager 更新到与 Guest VM 驱动程序不兼容的版本,Guest VM 将在禁用 vGPU 的情况下启动,直到其 Guest vGPU 驱动程序更新到兼容版本。有关更多详细信息,请参阅VMware vSphere 虚拟 GPU 软件发行说明。

2.9.1.1. 在 VMware vSphere 上安装 NVIDIA Virtual GPU Manager

要安装 NVIDIA Virtual GPU Manager,您需要通过 ESXi Shell 或 SSH 访问 ESXi 主机。请参阅 VMware 文档,了解如何为 ESXi 主机启用 ESXi Shell 或 SSH。

在开始之前,请确保满足以下先决条件

- 包含 NVIDIA vGPU 软件的 ZIP 存档已从 NVIDIA 许可门户下载。

- NVIDIA Virtual GPU Manager 的软件组件已从下载的 ZIP 存档中提取。

- 将 NVIDIA Virtual GPU Manager 组件文件复制到 ESXi 主机。

- 将 ESXi 主机置于维护模式。

$ esxcli system maintenanceMode set –-enable true

- 从其软件组件文件安装 NVIDIA vGPU 虚拟机监控程序主机驱动程序和 NVIDIA GPU 管理守护程序。

- 运行 esxcli 命令以从其软件组件文件安装 NVIDIA vGPU 虚拟机监控程序主机驱动程序。

$ esxcli software vib install -d /vmfs/volumes/datastore/host-driver-component.zip

- 运行 esxcli 命令以从其软件组件文件安装 NVIDIA GPU 管理守护程序。

$ esxcli software vib install -d /vmfs/volumes/datastore/gpu-management-daemon-component.zip

- datastore

- 您将软件组件复制到的 VMFS 数据存储的名称。

- host-driver-component

- 包含 NVIDIA vGPU 虚拟机监控程序主机驱动程序的文件名,以软件组件的形式。确保您指定从下载的 ZIP 存档中提取的文件。例如,对于 VMware vSphere 7.0.2,host-driver-component 是 NVD-VMware-x86_64-550.144.02-1OEM.702.0.0.17630552-bundle-build-number。

- gpu-management-daemon-component

- 包含 NVIDIA GPU 管理守护程序的文件名,以软件组件的形式。确保您指定从下载的 ZIP 存档中提取的文件。例如,对于 VMware vSphere 7.0.2,gpu-management-daemon-component 是 VMW-esx-7.0.2-nvd-gpu-mgmt-daemon-1.0-0.0.0001。

- 运行 esxcli 命令以从其软件组件文件安装 NVIDIA vGPU 虚拟机监控程序主机驱动程序。

- 退出维护模式。

$ esxcli system maintenanceMode set –-enable false

- 重启 ESXi 主机。

$ reboot

2.9.1.2. 更新 VMware vSphere 的 NVIDIA Virtual GPU Manager

如果您想在已安装现有版本的系统上安装新版本的 NVIDIA Virtual GPU Manager,请更新 NVIDIA Virtual GPU Manager。

要更新 vGPU Manager VIB,您需要通过 ESXi Shell 或 SSH 访问 ESXi 主机。请参阅 VMware 文档,了解如何为 ESXi 主机启用 ESXi Shell 或 SSH。

在继续 vGPU Manager 更新之前,请确保所有 VM 都已关闭电源,并且 ESXi 主机已置于维护模式。请参阅 VMware 文档,了解如何将 ESXi 主机置于维护模式

- 停止 NVIDIA GPU 管理守护程序。

$ /etc/init.d/nvdGpuMgmtDaemon stop

- 更新 NVIDIA vGPU 虚拟机监控程序主机驱动程序和 NVIDIA GPU 管理守护程序。

- 运行 esxcli 命令以从其软件组件文件更新 NVIDIA vGPU 虚拟机监控程序主机驱动程序。

$ esxcli software vib update -d /vmfs/volumes/datastore/host-driver-component.zip

- 运行 esxcli 命令以从其软件组件文件更新 NVIDIA GPU 管理守护程序。

$ esxcli software vib update -d /vmfs/volumes/datastore/gpu-management-daemon-component.zip

- datastore

- 您将软件组件复制到的 VMFS 数据存储的名称。

- host-driver-component

- 包含 NVIDIA vGPU 虚拟机监控程序主机驱动程序的文件名,以软件组件的形式。确保您指定从下载的 ZIP 存档中提取的文件。例如,对于 VMware vSphere 7.0.2,host-driver-component 是 NVD-VMware-x86_64-550.144.02-1OEM.702.0.0.17630552-bundle-build-number。

- gpu-management-daemon-component

- 包含 NVIDIA GPU 管理守护程序的文件名,以软件组件的形式。确保您指定从下载的 ZIP 存档中提取的文件。例如,对于 VMware vSphere 7.0.2,gpu-management-daemon-component 是 VMW-esx-7.0.2-nvd-gpu-mgmt-daemon-1.0-0.0.0001。

- 运行 esxcli 命令以从其软件组件文件更新 NVIDIA vGPU 虚拟机监控程序主机驱动程序。

- 重启 ESXi 主机并将其从维护模式中移除。

2.9.1.3. 验证 vSphere 的 NVIDIA vGPU 软件包的安装

ESXi 主机重启后,验证 vSphere 的 NVIDIA vGPU 软件包的安装。

- 通过检查内核加载模块列表中是否存在 NVIDIA 内核驱动程序,验证 NVIDIA vGPU 软件包是否已正确安装和加载。

[root@esxi:~] vmkload_mod -l | grep nvidia nvidia 5 8420

- 如果输出中未列出 NVIDIA 驱动程序,请检查 dmesg 中驱动程序报告的任何加载时错误。

- 验证 NVIDIA GPU 管理守护程序是否已启动。

$ /etc/init.d/nvdGpuMgmtDaemon status

- 通过运行 nvidia-smi 命令,验证 NVIDIA 内核驱动程序是否可以与系统中的 NVIDIA 物理 GPU 成功通信。nvidia-smi 命令在 NVIDIA 系统管理界面 nvidia-smi 中进行了更详细的描述。

运行 nvidia-smi 命令应生成平台中 GPU 的列表。

[root@esxi:~] nvidia-smi

Fri Jan 17 17:56:22 2025

+------------------------------------------------------+

| NVIDIA-SMI 550.144.02 Driver Version: 550.144.02 |

|-------------------------------+----------------------+----------------------+

| GPU Name Persistence-M| Bus-Id Disp.A | Volatile Uncorr. ECC |

| Fan Temp Perf Pwr:Usage/Cap| Memory-Usage | GPU-Util Compute M. |

|===============================+======================+======================|

| 0 Tesla M60 On | 00000000:05:00.0 Off | Off |

| N/A 25C P8 24W / 150W | 13MiB / 8191MiB | 0% Default |

+-------------------------------+----------------------+----------------------+

| 1 Tesla M60 On | 00000000:06:00.0 Off | Off |

| N/A 24C P8 24W / 150W | 13MiB / 8191MiB | 0% Default |

+-------------------------------+----------------------+----------------------+

| 2 Tesla M60 On | 00000000:86:00.0 Off | Off |

| N/A 25C P8 25W / 150W | 13MiB / 8191MiB | 0% Default |

+-------------------------------+----------------------+----------------------+

| 3 Tesla M60 On | 00000000:87:00.0 Off | Off |

| N/A 28C P8 24W / 150W | 13MiB / 8191MiB | 0% Default |

+-------------------------------+----------------------+----------------------+

+-----------------------------------------------------------------------------+

| Processes: GPU Memory |

| GPU PID Type Process name Usage |

|=============================================================================|

| No running processes found |

+-----------------------------------------------------------------------------+

如果 nvidia-smi 未能报告系统中所有 NVIDIA GPU 的预期输出,请参阅故障排除,了解故障排除步骤。

2.9.1.4. 管理 VMware vSphere 的 NVIDIA GPU 管理守护程序

VMware vSphere 的 NVIDIA GPU 管理守护程序是一项服务,通过 /etc/init.d 目录中的脚本进行控制。您可以使用这些脚本来启动守护程序、停止守护程序并获取其状态。

- 要启动 NVIDIA GPU 管理守护程序,请输入以下命令

$ /etc/init.d/nvdGpuMgmtDaemon start

- 要停止 NVIDIA GPU 管理守护程序,请输入以下命令

$ /etc/init.d/nvdGpuMgmtDaemon stop

- 要获取 NVIDIA GPU 管理守护程序的状态,请输入以下命令

$ /etc/init.d/nvdGpuMgmtDaemon status

2.9.2. 配置 VMware vMotion 与 vGPU for VMware vSphere

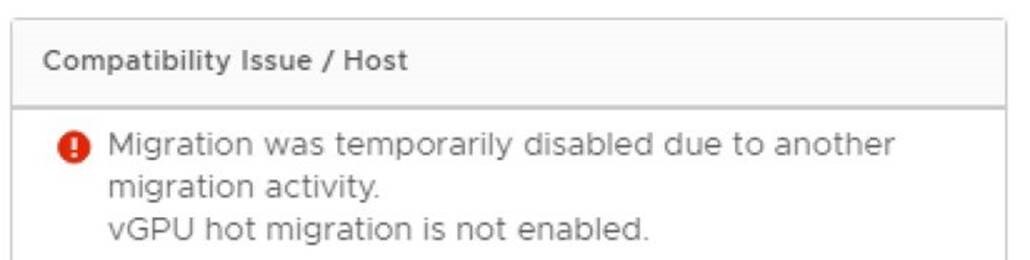

NVIDIA vGPU 软件支持 vGPU 迁移,其中包括 VMware vMotion 和挂起-恢复,适用于配置了 vGPU 的 VM。要启用 VMware vMotion 与 vGPU,必须启用高级 vCenter Server 设置。但是,默认情况下启用配置了 vGPU 的 VM 的挂起-恢复。

有关哪些 VMware vSphere 版本、NVIDIA GPU 和 Guest OS 版本支持 vGPU 迁移的详细信息,请参阅VMware vSphere 虚拟 GPU 软件发行说明。

在为 ESXi 主机配置 VMware vMotion 与 vGPU 之前,请确保主机上已安装当前的 VMware vSphere NVIDIA Virtual GPU Manager 软件包。

- 使用 vSphere Web Client 登录到 vCenter Server。

- 在“主机和集群”视图中,选择 vCenter Server 实例。注意

请确保选择 vCenter Server 实例,而不是 vCenter Server VM。

- 单击配置选项卡。

- 在设置部分中,选择高级设置,然后单击编辑。

- 在打开的“编辑高级 vCenter Server 设置”窗口中,在搜索字段中键入 vGPU。

- 当 vgpu.hotmigrate.enabled 设置出现时,设置已启用选项,然后单击确定。

2.9.3. 在 VMware vSphere 中更改默认图形类型

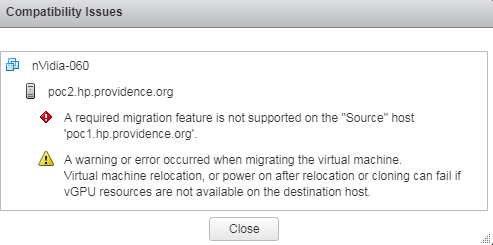

安装 VMware vSphere VIB 的 vGPU Manager VIB 后,默认图形类型为“共享”。要在 VMware vSphere 中为 VM 启用 vGPU 支持,您必须将默认图形类型更改为“共享直通”。

如果您不更改默认图形类型,分配了 vGPU 的 VM 将无法启动,并显示以下错误消息

The amount of graphics resource available in the parent resource pool is insufficient for the operation.

在配置 vGPU 之前更改默认图形类型。对于运行 vGPU 的 VM,VMware vSphere Web Client 中 VM 控制台的输出不可用。

在更改默认图形类型之前,请确保 ESXi 主机正在运行,并且主机上的所有 VM 都已关闭电源。

- 使用 vSphere Web Client 登录到 vCenter Server。

- 在导航树中,选择您的 ESXi 主机,然后单击配置选项卡。

- 从菜单中,选择图形,然后单击主机图形选项卡。

- 在主机图形选项卡上,单击编辑。

图 6. 共享默认图形类型

- 在打开的“编辑主机图形设置”对话框中,选择共享直通,然后单击确定。

图 7. vGPU 的主机图形设置

注意

注意在此对话框中,您还可以更改启用 vGPU 的 VM 的分配方案。有关更多信息,请参阅在 VMware vSphere 上修改 GPU 分配策略。

单击“确定”后,默认图形类型将更改为“共享直通”。

- 单击图形设备选项卡,以验证您要配置 vGPU 的每个物理 GPU 的配置类型。每个物理 GPU 的配置类型必须为“共享直通”。对于配置类型为“共享”的任何物理 GPU,请按如下方式更改配置类型

- 在图形设备选项卡上,选择物理 GPU,然后单击编辑图标。

图 8. 共享图形类型

- 在打开的编辑图形设备设置对话框中,选择共享直通,然后单击确定。

图 9. 物理 GPU 的图形设备设置

- 在图形设备选项卡上,选择物理 GPU,然后单击编辑图标。

- 重启 ESXi 主机或根据需要停止并重启 ESXi 主机上的 Xorg 服务和 nv-hostengine。

要停止并重启 Xorg 服务和 nv-hostengine,请执行以下步骤

- 仅限 VMware vSphere 7.0 Update 1 之前的版本:停止 Xorg 服务。

NVIDIA vGPU 模式下的图形设备不需要 Xorg 服务。

- 停止 nv-hostengine。

[root@esxi:~] nv-hostengine -t

- 等待 1 秒钟以允许 nv-hostengine 停止。

- 启动 nv-hostengine。

[root@esxi:~] nv-hostengine -d

- 仅限 VMware vSphere 7.0 Update 1 之前的版本:启动 Xorg 服务。

NVIDIA vGPU 模式下的图形设备不需要 Xorg 服务。

[root@esxi:~] /etc/init.d/xorg start

- 仅限 VMware vSphere 7.0 Update 1 之前的版本:停止 Xorg 服务。

- 在 VMware vCenter Web UI 的图形设备选项卡中,确认每个物理 GPU 的活动类型和配置类型均为“共享直通”。

图 10. 共享直通图形类型

更改默认图形类型后,按照配置带有 NVIDIA vGPU 的 vSphere VM中的说明配置 vGPU。

另请参阅 VMware vSphere 文档中的以下主题

2.9.4. 配置带有 NVIDIA vGPU 的 vSphere VM

为了支持计算或图形密集型应用程序和工作负载,您可以向单个 VM 添加多个 vGPU。

有关哪些 VMware vSphere 版本和 NVIDIA vGPU 支持为 VM 分配多个 vGPU 的详细信息,请参阅VMware vSphere 虚拟 GPU 软件发行说明。

对于运行 vGPU 的 VM,VMware vSphere Web Client 中 VM 控制台的输出不可用。在配置 vGPU 之前,请确保您已安装访问 VM 的其他方法(例如 Omnissa Horizon 或 VNC 服务器)。

从 VM 配置中移除 vGPU 参数后,vSphere Web Client 中的 VM 控制台将再次变为活动状态。

如何配置带有 vGPU 的 vSphere VM 取决于您的 VMware vSphere 版本,如下列主题所述

配置带有 vGPU 的 vSphere VM 后,启动 VM。此 vGPU 版本不支持 vSphere Web Client 中的 VM 控制台。因此,请使用 Omnissa Horizon 或 VNC 访问 VM 的桌面。

VM 启动后,安装 NVIDIA vGPU 软件图形驱动程序,如 安装 NVIDIA vGPU 软件图形驱动程序 中所述。

2.9.4.1. 配置带有 NVIDIA vGPU 的 vSphere 8 VM

- 打开 vCenter Web UI。

- 在 vCenter Web UI 中,右键单击 VM,然后选择编辑设置。

- 在打开的“编辑设置”窗口中,配置要添加到 VM 的 vGPU。按如下方式添加要添加到 VM 的每个 vGPU

- 返回“编辑设置”窗口,单击确定。

2.9.4.2. 配置带有 NVIDIA vGPU 的 vSphere 7 VM

如果您要向单个 VM 添加多个 vGPU,请为要添加到 VM 的每个 vGPU 执行此任务。

- 打开 vCenter Web UI。

- 在 vCenter Web UI 中,右键单击 VM,然后选择编辑设置。

- 单击虚拟硬件选项卡。

- 在新设备列表中,选择共享 PCI 设备,然后单击添加。PCI 设备字段应自动填充 NVIDIA GRID vGPU。

图 13. vGPU 的 VM 设置

- 从GPU 配置文件下拉菜单中,选择您要配置的 vGPU 类型,然后单击确定。注意

NVIDIA vGPU 软件不支持 VMware vSphere 上的 vCS。因此,C 系列 vGPU 类型在GPU 配置文件下拉菜单中不可用。

- 确保运行 vGPU 的 VM 已预留所有内存

- 从 vCenter Web UI 中选择编辑虚拟机设置。

- 展开内存部分,然后单击预留所有客户机内存(全部锁定)。

2.9.5. 在 VMware vSphere 上设置 vGPU 插件参数

vGPU 的插件参数控制 vGPU 的行为,例如每秒帧数 (FPS) 的帧率限制器 (FRL) 配置,或者是否启用 vGPU 的控制台虚拟网络计算 (VNC)。分配了 vGPU 的 VM 将使用这些参数启动。如果为分配给同一 VM 的多个 vGPU 设置了参数,则 VM 将使用分配给每个 vGPU 的参数启动。

确保分配了 vGPU 的 VM 已关闭电源。

对于要设置插件参数的每个 vGPU,请在 vSphere Client 中执行此任务。vGPU 插件参数是高级 VM 属性中的 PCI 直通配置参数。

- 在 vSphere Client 中,浏览到分配了 vGPU 的 VM。

- 右键单击 VM,然后选择编辑设置。

- 在“编辑设置”窗口中,单击VM 选项选项卡。

- 从高级下拉列表中,选择编辑配置。

- 在“配置参数”对话框中,单击添加行。

- 在名称字段中,键入参数名称 pciPassthruvgpu-id.cfg.parameter,在值字段中键入参数值,然后单击确定。

- vgpu-id

- 一个正整数,用于标识分配给 VM 的 vGPU。对于分配给 VM 的第一个 vGPU,vgpu-id 为 0。例如,如果为 VM 分配了两个 vGPU,并且您要为这两个 vGPU 设置插件参数,请设置以下参数

- pciPassthru0.cfg.parameter

- pciPassthru1.cfg.parameter

- parameter

- 您要设置的 vGPU 插件参数的名称。例如,用于启用统一内存的 vGPU 插件参数的名称为 enable_uvm。

要为分配给 VM 的两个 vGPU 启用统一内存,请将 pciPassthru0.cfg.enable_uvm 和 pciPassthru1.cfg.enable_uvm 设置为 1。

2.10. 为具有 KVM Hypervisor 的 Linux 配置 vGPU Manager

NVIDIA vGPU 软件支持以下具有 KVM hypervisor 的 Linux:Red Hat Enterprise Linux with KVM 和 Ubuntu。

如果您要配置需要 UEFI VM 上大型 BAR 地址空间的 NVIDIA vGPU,请参阅基于 KVM 的 hypervsiors 上的 NVIDIA vGPU 软件图形驱动程序加载失败,了解确保将 BAR 资源映射到 VM 中的解决方法。

此解决方法涉及设置实验性 QEMU 参数。

2.10.1. 在具有 KVM Hypervisor 的 Linux 上获取 GPU 的 BDF 和域

有时,在配置物理 GPU 以与 NVIDIA vGPU 软件一起使用时,您必须找出 sysfs 文件系统中哪个目录代表 GPU。此目录由 GPU 的域、总线、插槽和功能标识。

有关 sysfs 文件系统中代表物理 GPU 的目录的更多信息,请参阅sysfs 文件系统中的 NVIDIA vGPU 信息。

- 获取物理 GPU 的 PCI 设备总线/设备/功能 (BDF)。

# lspci | grep NVIDIA

此示例中列出的 NVIDIA GPU 的 PCI 设备 BDF 为

06:00.0和07:00.0。# lspci | grep NVIDIA 06:00.0 VGA compatible controller: NVIDIA Corporation GM204GL [Tesla M10] (rev a1) 07:00.0 VGA compatible controller: NVIDIA Corporation GM204GL [Tesla M10] (rev a1)

- 从 GPU 的 PCI 设备 BDF 获取 GPU 的完整标识符。

# virsh nodedev-list --cap pci| grep transformed-bdf

- transformed-bdf

- GPU 的 PCI 设备 BDF,其中冒号和句点替换为下划线,例如,

06_00_0。

此示例获取 PCI 设备 BDF 为

06:00.0的 GPU 的完整标识符。# virsh nodedev-list --cap pci| grep 06_00_0 pci_0000_06_00_0

- 从 GPU 的完整标识符中获取 GPU 的域、总线、插槽和功能。

virsh nodedev-dumpxml full-identifier| egrep 'domain|bus|slot|function'

- full-identifier

- 您在上一步中获得的 GPU 的完整标识符,例如,

pci_0000_06_00_0。

此示例获取 PCI 设备 BDF 为

06:00.0的 GPU 的域、总线、插槽和功能。# virsh nodedev-dumpxml pci_0000_06_00_0| egrep 'domain|bus|slot|function' <domain>0x0000</domain> <bus>0x06</bus> <slot>0x00</slot> <function>0x0</function> <address domain='0x0000' bus='0x06' slot='0x00' function='0x0'/>

2.10.2. 为支持 SR-IOV 的 NVIDIA vGPU 准备 Linux KVM Hypervisor 上的虚拟功能

支持 SR-IOV 的 NVIDIA vGPU 驻留在支持 SR-IOV 的物理 GPU 上,例如基于 NVIDIA Ampere 架构的 GPU。在支持 SR-IOV 的 GPU 上创建 NVIDIA vGPU 之前,您必须启用 GPU 的虚拟功能,并获取您要在其上创建 vGPU 的特定虚拟功能的域、总线、插槽和功能。

在执行此任务之前,请确保 GPU 未被任何其他进程使用,例如 CUDA 应用程序、监控应用程序或 nvidia-smi 命令。

- 在 sysfs 文件系统中启用物理 GPU 的虚拟功能。注意

在虚拟机监控程序主机重启后,或者如果驱动程序重新加载或升级,sysfs 文件系统中物理 GPU 的虚拟功能将被禁用。

仅使用 NVIDIA vGPU 软件提供的自定义脚本 sriov-manage 用于此目的。不要尝试通过任何其他方式启用 GPU 的虚拟功能。

# /usr/lib/nvidia/sriov-manage -e domain:bus:slot.function

- domain

- bus

- slot

- function

- GPU 的域、总线、插槽和功能,不带

0x前缀。

注意只能在虚拟功能上创建一个

mdev设备文件。此示例为域

00、总线41、插槽0000和功能0的 GPU 启用虚拟功能。# /usr/lib/nvidia/sriov-manage -e 00:41:0000.0

- 获取 GPU 上可用虚拟功能的域、总线、插槽和功能。

# ls -l /sys/bus/pci/devices/domain\:bus\:slot.function/ | grep virtfn

- domain

- bus

- slot

- function

- GPU 的域、总线、插槽和功能,不带

0x前缀。

此示例显示了插槽

00、总线41、域0000和功能0的物理 GPU 的此命令的输出。# ls -l /sys/bus/pci/devices/0000:41:00.0/ | grep virtfn lrwxrwxrwx. 1 root root 0 Jul 16 04:42 virtfn0 -> ../0000:41:00.4 lrwxrwxrwx. 1 root root 0 Jul 16 04:42 virtfn1 -> ../0000:41:00.5 lrwxrwxrwx. 1 root root 0 Jul 16 04:42 virtfn10 -> ../0000:41:01.6 lrwxrwxrwx. 1 root root 0 Jul 16 04:42 virtfn11 -> ../0000:41:01.7 lrwxrwxrwx. 1 root root 0 Jul 16 04:42 virtfn12 -> ../0000:41:02.0 lrwxrwxrwx. 1 root root 0 Jul 16 04:42 virtfn13 -> ../0000:41:02.1 lrwxrwxrwx. 1 root root 0 Jul 16 04:42 virtfn14 -> ../0000:41:02.2 lrwxrwxrwx. 1 root root 0 Jul 16 04:42 virtfn15 -> ../0000:41:02.3 lrwxrwxrwx. 1 root root 0 Jul 16 04:42 virtfn16 -> ../0000:41:02.4 lrwxrwxrwx. 1 root root 0 Jul 16 04:42 virtfn17 -> ../0000:41:02.5 lrwxrwxrwx. 1 root root 0 Jul 16 04:42 virtfn18 -> ../0000:41:02.6 lrwxrwxrwx. 1 root root 0 Jul 16 04:42 virtfn19 -> ../0000:41:02.7 lrwxrwxrwx. 1 root root 0 Jul 16 04:42 virtfn2 -> ../0000:41:00.6 lrwxrwxrwx. 1 root root 0 Jul 16 04:42 virtfn20 -> ../0000:41:03.0 lrwxrwxrwx. 1 root root 0 Jul 16 04:42 virtfn21 -> ../0000:41:03.1 lrwxrwxrwx. 1 root root 0 Jul 16 04:42 virtfn22 -> ../0000:41:03.2 lrwxrwxrwx. 1 root root 0 Jul 16 04:42 virtfn23 -> ../0000:41:03.3 lrwxrwxrwx. 1 root root 0 Jul 16 04:42 virtfn24 -> ../0000:41:03.4 lrwxrwxrwx. 1 root root 0 Jul 16 04:42 virtfn25 -> ../0000:41:03.5 lrwxrwxrwx. 1 root root 0 Jul 16 04:42 virtfn26 -> ../0000:41:03.6 lrwxrwxrwx. 1 root root 0 Jul 16 04:42 virtfn27 -> ../0000:41:03.7 lrwxrwxrwx. 1 root root 0 Jul 16 04:42 virtfn28 -> ../0000:41:04.0 lrwxrwxrwx. 1 root root 0 Jul 16 04:42 virtfn29 -> ../0000:41:04.1 lrwxrwxrwx. 1 root root 0 Jul 16 04:42 virtfn3 -> ../0000:41:00.7 lrwxrwxrwx. 1 root root 0 Jul 16 04:42 virtfn30 -> ../0000:41:04.2 lrwxrwxrwx. 1 root root 0 Jul 16 04:42 virtfn31 -> ../0000:41:04.3 lrwxrwxrwx. 1 root root 0 Jul 16 04:42 virtfn4 -> ../0000:41:01.0 lrwxrwxrwx. 1 root root 0 Jul 16 04:42 virtfn5 -> ../0000:41:01.1 lrwxrwxrwx. 1 root root 0 Jul 16 04:42 virtfn6 -> ../0000:41:01.2 lrwxrwxrwx. 1 root root 0 Jul 16 04:42 virtfn7 -> ../0000:41:01.3 lrwxrwxrwx. 1 root root 0 Jul 16 04:42 virtfn8 -> ../0000:41:01.4 lrwxrwxrwx. 1 root root 0 Jul 16 04:42 virtfn9 -> ../0000:41:01.5

- 选择您要在其上创建 vGPU 的可用虚拟功能,并记下其域、总线、插槽和功能。

自 17.4 起:在配置了 NVLink 的系统上,sriov-manage 脚本可能无法启用物理 GPU 的虚拟功能,因为 Virtual GPU Manager 的初始化尚未完成。在这种情况下,sriov-manage 脚本会将以下错误消息写入虚拟机监控程序主机上的日志文件

NVRM: Timeout occurred in event processing by vgpu_mgr daemon

如果日志文件中出现此错误消息,请稍后重试运行 sriov-manage 脚本以启用物理 GPU 的虚拟功能。

2.10.3. 在 Linux KVM Hypervisor 上创建 NVIDIA vGPU

对于要创建的每个 vGPU,请在 Linux KVM hypervisor 主机上的 Linux 命令行 shell 中执行此任务。

在开始之前,请确保您拥有要在其上创建 vGPU 的 GPU 的域、总线、插槽和功能。有关说明,请参阅在 Linux KVM Hypervisor 上获取 GPU 的 BDF 和域。

如何在 Linux KVM hypervisor 上创建 NVIDIA vGPU 取决于以下因素

- NVIDIA vGPU 是否支持单根 I/O 虚拟化 (SR-IOV)

- hypervisor 是否对支持 SR-IOV 的 NVIDIA vGPU 使用供应商特定的虚拟功能 I/O (VFIO) 框架注意

使用供应商特定 VFIO 框架的 hypervisor 仅将其用于支持 SR-IOV 的 NVIDIA vGPU。对于旧版 NVIDIA vGPU,hypervisor 仍然使用中介 VFIO

mdev驱动程序框架。供应商特定的 VFIO 框架不支持中介 VFIO

mdev驱动程序框架。

对于支持 SR-IOV 的 GPU,Ubuntu 24.04 版本中引入了供应商特定 VFIO 框架的使用。

要确定要为正在创建的 NVIDIA vGPU 遵循哪些说明,请参阅下表。

| NVIDIA vGPU 类型 | VFIO 框架 | 说明 |

|---|---|---|

| 旧版:不支持 SR-IOV | mdev |

在 Linux KVM Hypervisor 上创建旧版 NVIDIA vGPU |

| 支持 SR-IOV | mdev |

创建支持 SR-IOV 的 Linux KVM Hypervisor 上的 NVIDIA vGPU |

| 支持 SR-IOV | 供应商特定 | 在 Linux KVM Hypervisor 上创建使用供应商特定 VFIO 框架的 NVIDIA vGPU |

自 17.4 起:在配置了 NVLink 的系统上,vGPU 可能无法创建,因为 Virtual GPU Manager 的初始化尚未完成。在这种情况下,以下错误消息将写入虚拟机监控程序主机上的日志文件

NVRM: kvgpumgrCreateRequestVgpu: GPU is not initialized yet

如果日志文件中出现此错误消息,请稍后重试创建 vGPU。

2.10.3.1. 在 Linux KVM Hypervisor 上创建旧版 NVIDIA vGPU

旧版 NVIDIA vGPU 不支持 SR-IOV。

- 更改为物理 GPU 的 mdev_supported_types 目录。

# cd /sys/class/mdev_bus/domain\:bus\:slot.function/mdev_supported_types/

- domain

- bus

- slot

- function

- GPU 的域、总线、插槽和功能,不带

0x前缀。

此示例更改为域

0000和 PCI 设备 BDF06:00.0的 GPU 的 mdev_supported_types 目录。# cd /sys/bus/pci/devices/0000\:06\:00.0/mdev_supported_types/

- 找出 mdev_supported_types 的哪个子目录包含您要创建的 vGPU 类型的注册信息。

# grep -l "vgpu-type" nvidia-*/name

- vgpu-type

- vGPU 类型,例如,

M10-2Q。

此示例显示 M10-2Q vGPU 类型的注册信息包含在 mdev_supported_types 的 nvidia-41 子目录中。

# grep -l "M10-2Q" nvidia-*/name nvidia-41/name

- 确认您可以在物理 GPU 上创建 vGPU 类型的实例。

# cat subdirectory/available_instances

- subdirectory

- 您在上一步中找到的子目录,例如,

nvidia-41。

可用实例数必须至少为 1。如果数字为 0,则物理 GPU 上已存在另一个 vGPU 类型的实例,或者已创建允许的最大实例数。

此示例显示可以在物理 GPU 上创建 M10-2Q vGPU 类型的另外四个实例。

# cat nvidia-41/available_instances 4

- 为 vGPU 生成格式正确的通用唯一标识符 (UUID)。

# uuidgen aa618089-8b16-4d01-a136-25a0f3c73123

- 将您在上一步中获得的 UUID 写入您要创建的 vGPU 类型的注册信息目录中的 create 文件。

# echo "uuid"> subdirectory/create

- uuid

- 您在上一步中生成的 UUID,它将成为您要创建的 vGPU 的 UUID。

- subdirectory

- 您要创建的 vGPU 类型的注册信息目录,例如,

nvidia-41。

此示例创建 UUID 为

aa618089-8b16-4d01-a136-25a0f3c73123的 M10-2Q vGPU 类型的实例。# echo "aa618089-8b16-4d01-a136-25a0f3c73123" > nvidia-41/create

vGPU 的

mdev设备文件已添加到 vGPU 的父物理设备目录中。vGPU 由其 UUID 标识。/sys/bus/mdev/devices/ 目录包含指向

mdev设备文件的符号链接。 - 使您创建的

mdev设备文件保持持久性以表示 vGPU。# mdevctl define --auto --uuid uuid

- uuid

- 您在上一步中为要创建的 vGPU 指定的 UUID。

注意并非所有 Linux KVM hypervisor 版本都包含 mdevctl 命令。如果您的版本不包含 mdevctl 命令,您可以使用操作系统的标准功能来自动重新创建此设备文件,当主机启动时。例如,您可以编写一个自定义脚本,在主机重启时执行。

- 确认 vGPU 已创建。

- 确认 /sys/bus/mdev/devices/ 目录包含 vGPU 的

mdev设备文件。# ls -l /sys/bus/mdev/devices/ total 0 lrwxrwxrwx. 1 root root 0 Nov 24 13:33 aa618089-8b16-4d01-a136-25a0f3c73123 -> ../../../devices/pci0000:00/0000:00:03.0/0000:03:00.0/0000:04:09.0/0000:06:00.0/aa618089-8b16-4d01-a136-25a0f3c73123

- 如果您的版本包含 mdevctl 命令,请列出 hypervisor 主机上的活动中介设备。

# mdevctl list aa618089-8b16-4d01-a136-25a0f3c73123 0000:06:00.0 nvidia-41

- 确认 /sys/bus/mdev/devices/ 目录包含 vGPU 的

2.10.3.2. 创建支持 SR-IOV 的 Linux KVM Hypervisor 上的 NVIDIA vGPU

支持 SR-IOV 的 NVIDIA vGPU 驻留在支持 SR-IOV 的物理 GPU 上,例如基于 NVIDIA Ampere 架构的 GPU。

在执行此任务之前,请确保已按照为支持 SR-IOV 的 NVIDIA vGPU 准备 Linux KVM Hypervisor 上的虚拟功能中的说明准备了要创建 vGPU 的虚拟功能。

如果您要支持具有不同帧缓冲区大小的 vGPU,还要确保 GPU 已置于混合大小模式,如为支持 SR-IOV 的 NVIDIA vGPU 准备 Linux KVM Hypervisor 上的虚拟功能中所述。

- 更改为要在其上创建 vGPU 的虚拟功能的 mdev_supported_types 目录。

# cd /sys/class/mdev_bus/domain\:bus\:vf-slot.v-function/mdev_supported_types/

- domain

- bus

- GPU 的域和总线,不带

0x前缀。 - vf-slot

- v-function

- 您在为支持 SR-IOV 的 NVIDIA vGPU 在带有 KVM 虚拟机监控程序的 Linux 上准备虚拟功能中记录的虚拟功能的插槽和功能。

此示例更改为域为

0000且总线为41的 GPU 的第一个虚拟功能 (virtfn0) 的 mdev_supported_types 目录。第一个虚拟功能 (virtfn0) 的插槽为00,功能为4。# cd /sys/class/mdev_bus/0000\:41\:00.4/mdev_supported_types

- 找出 mdev_supported_types 的哪个子目录包含您要创建的 vGPU 类型的注册信息。

# grep -l "vgpu-type" nvidia-*/name

- vgpu-type

- vGPU 类型,例如

A40-2Q。

此示例显示 A40-2Q vGPU 类型的注册信息包含在 mdev_supported_types 的 nvidia-558 子目录中。

# grep -l "A40-2Q" nvidia-*/name nvidia-558/name

- 确认您可以在虚拟功能上创建 vGPU 类型的实例。

# cat subdirectory/available_instances

- subdirectory

- 您在上一步中找到的子目录,例如

nvidia-558。

可用实例数必须为 1。如果数字为 0,则已在虚拟功能上创建了 vGPU。在虚拟功能上只能创建一个任何 vGPU 类型的实例。

此示例显示可以在虚拟功能上创建 A40-2Q vGPU 类型的实例。

# cat nvidia-558/available_instances 1

- 为 vGPU 生成格式正确的通用唯一标识符 (UUID)。

# uuidgen aa618089-8b16-4d01-a136-25a0f3c73123

- 将您在上一步中获得的 UUID 写入您要创建的 vGPU 类型的注册信息目录中的 create 文件。

# echo "uuid"> subdirectory/create

- uuid

- 您在上一步中生成的 UUID,它将成为您要创建的 vGPU 的 UUID。

- subdirectory

- 您要创建的 vGPU 类型的注册信息目录,例如

nvidia-558。

此示例创建 UUID 为

aa618089-8b16-4d01-a136-25a0f3c73123的 A40-2Q vGPU 类型的实例。# echo "aa618089-8b16-4d01-a136-25a0f3c73123" > nvidia-558/create

vGPU 的

mdev设备文件被添加到 vGPU 的父虚拟功能目录中。vGPU 由其 UUID 标识。 - 仅限分时 vGPU:使您创建的表示 vGPU 的

mdev设备文件持久化。# mdevctl define --auto --uuid uuid

- uuid

- 您在上一步中为要创建的 vGPU 指定的 UUID。

注意- 如果您使用的是支持 SR-IOV 的 GPU,则只有在您按照为支持 SR-IOV 的 NVIDIA vGPU 在带有 KVM 虚拟机监控程序的 Linux 上准备虚拟功能中的说明启用 GPU 的虚拟功能后,

mdev设备文件才会在主机重启后持久存在,然后再重启任何配置了 GPU 上 vGPU 的 VM。 - 您不能使用 mdevctl 命令使 MIG 支持的 vGPU 的

mdev设备文件持久化。MIG 支持的 vGPU 的mdev设备文件在主机重启后不会保留,因为 MIG 实例不再可用。 - 并非所有 Linux KVM hypervisor 版本都包含 mdevctl 命令。如果您的版本不包含 mdevctl 命令,您可以使用操作系统的标准功能来自动重新创建此设备文件,当主机启动时。例如,您可以编写一个自定义脚本,在主机重启时执行。

- 确认 vGPU 已创建。

- 确认 /sys/bus/mdev/devices/ 目录包含指向

mdev设备文件的符号链接。# ls -l /sys/bus/mdev/devices/ total 0 lrwxrwxrwx. 1 root root 0 Jul 16 05:57 aa618089-8b16-4d01-a136-25a0f3c73123 -> ../../../devices/pci0000:40/0000:40:01.1/0000:41:00.4/aa618089-8b16-4d01-a136-25a0f3c73123

- 如果您的版本包含 mdevctl 命令,请列出 hypervisor 主机上的活动中介设备。

# mdevctl list aa618089-8b16-4d01-a136-25a0f3c73123 0000:06:00.0 nvidia-558

- 确认 /sys/bus/mdev/devices/ 目录包含指向

2.10.3.3. 在 Linux 和 KVM 虚拟机监控程序上使用厂商特定的 VFIO 框架创建 NVIDIA vGPU

虚拟机监控程序仅将厂商特定的 VFIO 框架用于支持 SR-IOV 的 NVIDIA vGPU。对于旧版 NVIDIA vGPU,虚拟机监控程序使用标准 VFIO 框架。厂商特定的 VFIO 框架不支持中介 VFIO mdev 驱动程序框架。

对于支持 SR-IOV 的 GPU,Ubuntu 24.04 版本中引入了供应商特定 VFIO 框架的使用。

在执行此任务之前,请确保已按照为支持 SR-IOV 的 NVIDIA vGPU 准备 Linux KVM Hypervisor 上的虚拟功能中的说明准备了要创建 vGPU 的虚拟功能。

如果您要支持具有不同帧缓冲区大小的 vGPU,还要确保 GPU 已置于混合大小模式,如为支持 SR-IOV 的 NVIDIA vGPU 准备 Linux KVM Hypervisor 上的虚拟功能中所述。

- 更改到 sysfs 文件系统中的目录,该目录包含您要在其上创建 vGPU 的虚拟功能上的 vGPU 管理文件。

# cd /sys/bus/pci/devices/domain\:bus\:vf-slot.v-function/nvidia

- domain

- bus

- GPU 的域和总线,不带

0x前缀。 - vf-slot

- v-function

- 您在为支持 SR-IOV 的 NVIDIA vGPU 在带有 KVM 虚拟机监控程序的 Linux 上准备虚拟功能中记录的虚拟功能的插槽和功能。

此示例更改为域为

0000且总线为3d的 GPU 的第一个虚拟功能 (virtfn0) 的 nvidia 目录。第一个虚拟功能 (virtfn0) 的插槽为00,功能为4。# cd /sys/bus/pci/devices/0000\:3d\:00.4/nvidia

- 确认该目录包含虚拟功能上的 vGPU 管理文件,即 creatable_vgpu_types 和 current_vgpu_type。

# ll -r--r--r-- 1 root root 4096 Aug 3 00:39 creatable_vgpu_types -rw-r--r-- 1 root root 4096 Aug 3 00:39 current_vgpu_type ...

- 确认尚未在虚拟功能上创建 vGPU。

# cat current_vgpu_type 0

如果当前 vGPU 类型为 0,则尚未在虚拟功能上创建 vGPU。

注意如果当前 vGPU 类型不为 0,则不能在虚拟功能上创建 vGPU,因为已在其上创建了 vGPU,并且在虚拟功能上只能创建一个 vGPU。

- 确定可以在虚拟功能上创建的 NVIDIA vGPU 类型以及表示 sysfs 文件系统中每种 vGPU 类型的整数 ID。

# cat creatable_vgpu_types NVIDIA A40-1Q 557 NVIDIA A40-2Q 558 NVIDIA A40-3Q 559 NVIDIA A40-4Q 560 NVIDIA A40-6Q 561

- 将表示您要创建的 NVIDIA vGPU 类型的 ID 写入 current_vgpu_type 文件。

# echo vgpu-type-id > current_vgpu_type

- vgpu-type-id

- 表示您要在 sysfs 文件系统中创建的 NVIDIA vGPU 类型的 ID。

注意您必须指定有效的 ID。如果您指定无效的 ID,则写入操作将失败,并且 current vGPU 类型将设置为

0。此示例创建 A40-4Q vGPU 类型的实例。

# echo 560 > current_vgpu_type

- 确认虚拟功能上的当前 vGPU 类型与您在上一步中创建的 vGPU 类型匹配。

# cat current_vgpu_type 560

- 确认 creatable_vgpu_types 文件为空,表示无法在虚拟功能上创建 vGPU。

# cat creatable_vgpu_types

要重新配置虚拟功能上的 vGPU,必须首先删除现有 vGPU,如在 Linux 和 KVM 虚拟机监控程序上使用厂商特定的 VFIO 框架删除 vGPU中所述。

2.10.4. 向带有 KVM 虚拟机监控程序的 Linux VM 添加一个或多个 vGPU

为了支持计算或图形密集型应用程序和工作负载,您可以向单个 VM 添加多个 vGPU。

有关哪些虚拟机监控程序版本和 NVIDIA vGPU 支持将多个 vGPU 分配给 VM 的详细信息,请参阅Red Hat Enterprise Linux with KVM 版虚拟 GPU 软件发行说明和Ubuntu 版虚拟 GPU 软件发行说明。

确保满足以下先决条件

- 您要向其添加 vGPU 的 VM 已关闭。

- 您要添加的 vGPU 已按照在 Linux 和 KVM 虚拟机监控程序上创建 NVIDIA vGPU中的说明创建。

您可以使用以下任何工具向带有 KVM 虚拟机监控程序的 Linux 虚拟机添加 vGPU

- virsh 命令

- QEMU 命令行

向带有 KVM 虚拟机监控程序的 Linux VM 添加 vGPU 后,启动 VM。

# virsh start vm-name

- vm-name

- 您向其添加 vGPU 的 VM 的名称。

VM 启动后,安装 NVIDIA vGPU 软件图形驱动程序,如 安装 NVIDIA vGPU 软件图形驱动程序 中所述。

2.10.4.1. 使用 virsh 向带有 KVM 虚拟机监控程序的 Linux VM 添加一个或多个 vGPU

- 在 virsh 中,打开要向其添加 vGPU 的 VM 的 XML 文件进行编辑。

# virsh edit vm-name

- vm-name

- 您要向其添加 vGPU 的 VM 的名称。

- 对于要添加到 VM 的每个 vGPU,在

source元素内以address元素的形式添加设备条目,以将 vGPU 添加到客户机 VM。设备条目的内容取决于虚拟机监控程序是否将厂商特定的 VFIO 框架用于支持 SR-IOV 的 NVIDIA vGPU。

对于支持 SR-IOV 的 GPU,Ubuntu 24.04 版本中引入了供应商特定 VFIO 框架的使用。

-

对于使用

mdevVFIO 框架的虚拟机监控程序,添加一个设备条目,通过其 UUID 标识 vGPU,如下所示<device> ... <hostdev mode='subsystem' type='mdev' model='vfio-pci'> <source> <address uuid='uuid'/> </source> </hostdev> </device>

- uuid

- 在创建 vGPU 时分配给 vGPU 的 UUID。

此示例添加 UUID 为

a618089-8b16-4d01-a136-25a0f3c73123的 vGPU 的设备条目。<device> ... <hostdev mode='subsystem' type='mdev' model='vfio-pci'> <source> <address uuid='a618089-8b16-4d01-a136-25a0f3c73123'/> </source> </hostdev> </device>

此示例添加了以下 UUID 的两个 vGPU 的设备条目

-

c73f1fa6-489e-4834-9476-d70dabd98c40 -

3b356d38-854e-48be-b376-00c72c7d119c

<device> ... <hostdev mode='subsystem' type='mdev' model='vfio-pci'> <source> <address uuid='c73f1fa6-489e-4834-9476-d70dabd98c40'/> </source> </hostdev> <hostdev mode='subsystem' type='mdev' model='vfio-pci'> <source> <address uuid='3b356d38-854e-48be-b376-00c72c7d119c'/> </source> </hostdev> </device>

-

对于使用厂商特定的 VFIO 框架的虚拟机监控程序,添加一个设备条目,通过在其上创建 vGPU 的虚拟功能来标识 vGPU,如下所示

<hostdev mode='subsystem' type='pci' managed='no'> <source> <address domain='domain' bus='bus' slot='vf-slot' function='v-function'/> </source> </hostdev>

- domain

- bus

- GPU 的域和总线,包括

0x前缀。 - vf-slot

- v-function

- 您在为支持 SR-IOV 的 NVIDIA vGPU 在带有 KVM 虚拟机监控程序的 Linux 上准备虚拟功能中记录的虚拟功能的插槽和功能。

注意仅在非托管

libvirt模式下支持 vGPU。因此,请确保在hostdev元素中,managed属性设置为no。此示例为在虚拟功能

0000:3d:00.4上创建的 vGPU 添加设备条目。<device> ... <hostdev mode='subsystem' type='pci' managed='no'> <source> <address domain='0x0000' bus='0x3d' slot='0x00' function='0x4'/> </source> </hostdev> </device>

此示例为在以下虚拟功能上创建的两个 vGPU 添加设备条目

-

0000:3d:00.4 -

0000:3d:00.5

<device> ... <hostdev mode='subsystem' type='pci' managed='no'> <source> <address domain='0x0000' bus='0x3d' slot='0x00' function='0x4'/> </source> </hostdev> <hostdev mode='subsystem' type='pci' managed='no'> <source> <address domain='0x0000' bus='0x3d' slot='0x00' function='0x5'/> </source> </hostdev> </device>

-

- 可选:添加一个

video元素,其中包含一个model元素,在该元素中,type属性设置为none。<video> <model type='none'/> </video>

添加此

video元素可防止将libvirt添加的默认视频设备加载到 VM 中。如果您不添加此video元素,则必须配置 Xorg 服务器或您的远程解决方案,以仅加载您添加的 vGPU 设备,而不加载默认视频设备。

2.10.4.2. 使用 QEMU 命令行向带有 KVM 虚拟机监控程序的 Linux VM 添加一个或多个 vGPU

此任务涉及向 QEMU 命令行添加选项,以标识您要添加的 vGPU 以及您要向其添加它们的 VM。

- 对于要添加到 VM 的每个 vGPU,添加一个 -device 选项,以标识 vGPU。

每个 -device 选项的格式取决于虚拟机监控程序是否将厂商特定的 VFIO 框架用于支持 SR-IOV 的 NVIDIA vGPU。

对于支持 SR-IOV 的 GPU,Ubuntu 24.04 版本中引入了供应商特定 VFIO 框架的使用。

-

对于使用

mdevVFIO 框架的虚拟机监控程序上的每个 vGPU,添加一个 -device 选项,通过其 UUID 标识 vGPU。-device vfio-pci,sysfsdev=/sys/bus/mdev/devices/vgpu-uuid

- vgpu-uuid

- 在创建 vGPU 时分配给 vGPU 的 UUID。

-

对于使用厂商特定的 VFIO 框架的虚拟机监控程序上的每个 vGPU,添加一个 -device 选项,通过在其上创建 vGPU 的虚拟功能来标识 vGPU。

-device vfio-pci,sysfsdev=/sys/bus/pci/devices/domain\:bus\:vf-slot.v-function/

- domain

- bus

- GPU 的域和总线,不带

0x前缀。 - vf-slot

- v-function

- 您在为支持 SR-IOV 的 NVIDIA vGPU 在带有 KVM 虚拟机监控程序的 Linux 上准备虚拟功能中记录的虚拟功能的插槽和功能。

-

- 添加 -uuid 选项以指定您要向其添加 vGPU 的 VM。

-uuid vm-uuid

- vm-uuid

- 在创建 VM 时分配给 VM 的 UUID。

在使用 mdev VFIO 框架的虚拟机监控程序上的 VM 中添加一个 vGPU

此示例将 UUID 为 aa618089-8b16-4d01-a136-25a0f3c73123 的 vGPU 添加到 UUID 为 ebb10a6e-7ac9-49aa-af92-f56bb8c65893 的 VM。

-device vfio-pci,sysfsdev=/sys/bus/mdev/devices/aa618089-8b16-4d01-a136-25a0f3c73123 \

-uuid ebb10a6e-7ac9-49aa-af92-f56bb8c65893

在使用 mdev VFIO 框架的虚拟机监控程序上的 VM 中添加两个 vGPU

此示例添加了以下 UUID 的两个 vGPU 的设备条目

-

676428a0-2445-499f-9bfd-65cd4a9bd18f -

6c5954b8-5bc1-4769-b820-8099fe50aaba

条目被添加到 UUID 为 ec5e8ee0-657c-4db6-8775-da70e332c67e 的 VM。

-device vfio-pci,sysfsdev=/sys/bus/mdev/devices/676428a0-2445-499f-9bfd-65cd4a9bd18f \

-device vfio-pci,sysfsdev=/sys/bus/mdev/devices/6c5954b8-5bc1-4769-b820-8099fe50aaba \

-uuid ec5e8ee0-657c-4db6-8775-da70e332c67e

在使用厂商特定的 VFIO 框架的虚拟机监控程序上的 VM 中添加一个 vGPU

此示例将虚拟功能 0000:3d:00.4 上创建的 vGPU 添加到 UUID 为 ebb10a6e-7ac9-49aa-af92-f56bb8c65893 的 VM。

-device vfio-pci,sysfsdev=/sys/bus/pci/devices/0000\:3d\:00.4 \

-uuid ebb10a6e-7ac9-49aa-af92-f56bb8c65893

在使用厂商特定的 VFIO 框架的虚拟机监控程序上的 VM 中添加两个 vGPU

此示例为在以下虚拟功能上创建的两个 vGPU 添加设备条目

-

0000:3d:00.4 -

0000:3d:00.5

条目被添加到 UUID 为 ec5e8ee0-657c-4db6-8775-da70e332c67e 的 VM。

-device vfio-pci,sysfsdev=/sys/bus/pci/devices/0000\:3d\:00.4 \

-device vfio-pci,sysfsdev=/sys/bus/pci/devices/0000\:3d\:00.5 \

-uuid ec5e8ee0-657c-4db6-8775-da70e332c67e

2.10.5. 在带有 KVM 虚拟机监控程序的 Linux 上设置 vGPU 插件参数

vGPU 的插件参数控制 vGPU 的行为,例如每秒帧数 (FPS) 的帧率限制器 (FRL) 配置,或者是否启用 vGPU 的控制台虚拟网络计算 (VNC)。分配了 vGPU 的 VM 将使用这些参数启动。如果为分配给同一 VM 的多个 vGPU 设置了参数,则 VM 将使用分配给每个 vGPU 的参数启动。

对于要设置插件参数的每个 vGPU,请在带有 KVM 虚拟机监控程序的主机上的 Linux 命令 shell 中执行此任务。

- 更改到 sysfs 文件系统中的目录,该目录包含您要为其设置 vGPU 插件参数的 vGPU 的 vgpu_params 文件。

目录取决于虚拟机监控程序是否将厂商特定的 VFIO 框架用于支持 SR-IOV 的 NVIDIA vGPU。

对于支持 SR-IOV 的 GPU,Ubuntu 24.04 版本中引入了供应商特定 VFIO 框架的使用。

-

对于使用

mdevVFIO 框架的虚拟机监控程序,更改到表示 vGPU 的mdev设备目录的 nvidia 子目录。# cd /sys/bus/mdev/devices/uuid/nvidia

- uuid

- vGPU 的 UUID,例如

aa618089-8b16-4d01-a136-25a0f3c73123。

-

对于使用厂商特定的 VFIO 框架的虚拟机监控程序,更改到 sysfs 文件系统中的目录,该目录包含在其上创建 vGPU 的虚拟功能上的 vGPU 管理文件。

# cd /sys/bus/pci/devices/domain\:bus\:vf-slot.v-function/nvidia

- domain

- bus

- GPU 的域和总线,不带

0x前缀。 - vf-slot

- v-function

- 您在为支持 SR-IOV 的 NVIDIA vGPU 在带有 KVM 虚拟机监控程序的 Linux 上准备虚拟功能中记录的虚拟功能的插槽和功能。

此示例更改为域为

0000且总线为3d的 GPU 的第一个虚拟功能 (virtfn0) 的 nvidia 目录。第一个虚拟功能 (virtfn0) 的插槽为00,功能为4。# cd /sys/bus/pci/devices/0000\:3d\:00.4/nvidia

-

- 将您要设置的插件参数写入您在上一步中更改到的目录中的 vgpu_params 文件。

# echo "plugin-config-params" > vgpu_params

- plugin-config-params

- 逗号分隔的参数值对列表,其中每对的格式为 parameter-name=value。

此示例禁用 vGPU 的帧速率限制和控制台 VNC。

# echo "frame_rate_limiter=0, disable_vnc=1" > vgpu_params

此示例为 vGPU 启用统一内存。

# echo "enable_uvm=1" > vgpu_params

此示例为 vGPU 启用 NVIDIA CUDA Toolkit 调试器。

# echo "enable_debugging=1" > vgpu_params

此示例为 vGPU 启用 NVIDIA CUDA Toolkit 分析器。

# echo "enable_profiling=1" > vgpu_params

要清除先前设置的任何 vGPU 插件参数,请向 vGPU 的 vgpu_params 文件写入一个空格。

# echo " " > vgpu_params

2.10.6. 在带有 KVM 虚拟机监控程序的 Linux 上删除 vGPU

如何在带有 KVM 虚拟机监控程序的 Linux 上删除 vGPU 取决于虚拟机监控程序是否将厂商特定的 VFIO 框架用于支持 SR-IOV 的 NVIDIA vGPU。

虚拟机监控程序使用厂商特定的 VFIO 框架仅用于支持 SR-IOV 的 NVIDIA vGPU。虚拟机监控程序仍然将中介 VFIO mdev 驱动程序框架用于旧版 NVIDIA vGPU。

对于支持 SR-IOV 的 GPU,Ubuntu 24.04 版本中引入了供应商特定 VFIO 框架的使用。

要确定要删除的 NVIDIA vGPU 应遵循哪些说明,请参阅下表。

| NVIDIA vGPU 类型 | VFIO 框架 | 说明 |

|---|---|---|

| 旧版:不支持 SR-IOV | mdev |

在使用 mdev VFIO 框架的 Linux 和 KVM 虚拟机监控程序上删除 vGPU |

| 支持 SR-IOV | mdev |

|

| 支持 SR-IOV | 供应商特定 | 在使用厂商特定的 VFIO 框架的 Linux 和 KVM 虚拟机监控程序上删除 vGPU |

2.10.6.1. 在使用 mdev VFIO 框架的 Linux 和 KVM 虚拟机监控程序上删除 vGPU

对于要删除的每个 vGPU,请在带有 KVM 虚拟机监控程序的主机上的 Linux 命令 shell 中执行此任务。

在开始之前,请确保满足以下先决条件

- 您拥有要删除的 vGPU 所在的 GPU 的域、总线、插槽和功能。有关说明,请参阅在带有 KVM 虚拟机监控程序的 Linux 上获取 GPU 的 BDF 和域。

- 分配了 vGPU 的 VM 已关闭。

- 更改为物理 GPU 的 mdev_supported_types 目录。

# cd /sys/class/mdev_bus/domain\:bus\:slot.function/mdev_supported_types/

- domain

- bus

- slot

- function

- GPU 的域、总线、插槽和功能,不带

0x前缀。

此示例更改为 PCI 设备 BDF 为

06:00.0的 GPU 的 mdev_supported_types 目录。# cd /sys/bus/pci/devices/0000\:06\:00.0/mdev_supported_types/

- 更改为 mdev_supported_types 的子目录,该子目录包含 vGPU 的注册信息。

# cd `find . -type d -name uuid`

- uuid

- vGPU 的 UUID,例如

aa618089-8b16-4d01-a136-25a0f3c73123。

- 将值

1写入您要删除的 vGPU 的注册信息目录中的 remove 文件。# echo "1" > remove

2.10.6.2. 在使用厂商特定的 VFIO 框架的 Linux 和 KVM 虚拟机监控程序上删除 vGPU

虚拟机监控程序仅将厂商特定的 VFIO 框架用于支持 SR-IOV 的 NVIDIA vGPU。对于旧版 NVIDIA vGPU,虚拟机监控程序使用 mdev VFIO 框架。厂商特定的 VFIO 框架不支持中介 VFIO mdev 驱动程序框架。

对于支持 SR-IOV 的 GPU,Ubuntu 24.04 版本中引入了供应商特定 VFIO 框架的使用。

在开始之前,请确保满足以下先决条件

- 您拥有以下信息

- 您要删除的 vGPU 所在的 GPU 的域和总线。有关说明,请参阅在带有 KVM 虚拟机监控程序的 Linux 上获取 GPU 的 BDF 和域。

- 在其上创建了您要删除的 vGPU 的虚拟功能的插槽和功能。

- 分配了 vGPU 的 VM 已关闭。

- 更改到 sysfs 文件系统中的目录,该目录包含在其上创建 vGPU 的虚拟功能上的 vGPU 管理文件。

# cd /sys/bus/pci/devices/domain\:bus\:vf-slot.v-function/nvidia

- domain

- bus

- GPU 的域和总线,不带

0x前缀。 - vf-slot

- v-function

- 您在为支持 SR-IOV 的 NVIDIA vGPU 在带有 KVM 虚拟机监控程序的 Linux 上准备虚拟功能中记录的虚拟功能的插槽和功能。

此示例更改为域为

0000且总线为3d的 GPU 的第一个虚拟功能 (virtfn0) 的 nvidia 目录。第一个虚拟功能 (virtfn0) 的插槽为00,功能为4。# cd /sys/bus/pci/devices/0000\:3d\:00.4/nvidia

- 确认该目录包含虚拟功能上的 vGPU 管理文件,即 creatable_vgpu_types 和 current_vgpu_type。

# ll -r--r--r-- 1 root root 4096 Aug 3 00:39 creatable_vgpu_types -rw-r--r-- 1 root root 4096 Aug 3 00:39 current_vgpu_type ...

- 确认虚拟功能上的当前 vGPU 类型是表示您要删除的 vGPU 类型的 ID。

# cat current_vgpu_type 560

- 将

0写入 current_vgpu_type 文件。# echo 0 > current_vgpu_type

- 确认虚拟功能上的当前 vGPU 类型为

0,表示 vGPU 已被删除。# cat current_vgpu_type 0

- 确认 creatable_vgpu_types 文件不再为空,表示 vGPU 已被删除,并且可以在虚拟功能上再次创建 vGPU。

# cat creatable_vgpu_types NVIDIA A40-1Q 557 NVIDIA A40-2Q 558 NVIDIA A40-3Q 559 NVIDIA A40-4Q 560 NVIDIA A40-6Q 561

2.10.7. 准备配置为直通的 GPU 以用于 vGPU

物理 GPU 使用的模式决定了 GPU 绑定的 Linux 内核模块。如果要切换 GPU 使用的模式,则必须从其当前内核模块取消绑定 GPU,并将其绑定到新模式的内核模块。将 GPU 绑定到正确的内核模块后,您可以将其配置为 vGPU。

直通到 VM 的物理 GPU 绑定到 vfio-pci 内核模块。绑定到 vfio-pci 内核模块的物理 GPU 只能用于直通。要使 GPU 能够用于 vGPU,必须从 vfio-pci 内核模块取消绑定 GPU,并将其绑定到 nvidia 内核模块。

在开始之前,请确保您拥有要准备用于 vGPU 的 GPU 的域、总线、插槽和功能。有关说明,请参阅在带有 KVM 虚拟机监控程序的 Linux 上获取 GPU 的 BDF 和域。

- 通过在主机上的 NVIDIA GPU 上运行带有 -k 选项的 lspci 命令,确定 GPU 绑定的内核模块。

# lspci -d 10de: -k

Kernel driver in use:字段指示 GPU 绑定的内核模块。以下示例显示 BDF 为

06:00.0的 NVIDIA Tesla M60 GPU 绑定到vfio-pci内核模块,并且正在用于 GPU 直通。06:00.0 VGA compatible controller: NVIDIA Corporation GM204GL [Tesla M60] (rev a1) Subsystem: NVIDIA Corporation Device 115e Kernel driver in use: vfio-pci

- 从

vfio-pci内核模块取消绑定 GPU。- 更改为表示

vfio-pci内核模块的 sysfs 目录。# cd /sys/bus/pci/drivers/vfio-pci

- 将 GPU 的域、总线、插槽和功能写入此目录中的 unbind 文件。

# echo domain:bus:slot.function > unbind

- domain

- bus

- slot

- function

- GPU 的域、总线、插槽和功能,不带

0x前缀。

此示例写入域为

0000且 PCI 设备 BDF 为06:00.0的 GPU 的域、总线、插槽和功能。# echo 0000:06:00.0 > unbind

- 更改为表示

- 将 GPU 绑定到

nvidia内核模块。- 更改为包含物理 GPU 的 PCI 设备信息的 sysfs 目录。

# cd /sys/bus/pci/devices/domain\:bus\:slot.function

- domain

- bus

- slot

- function

- GPU 的域、总线、插槽和功能,不带

0x前缀。

此示例更改为包含域为

0000且 PCI 设备 BDF 为06:00.0的 GPU 的 PCI 设备信息的 sysfs 目录。# cd /sys/bus/pci/devices/0000\:06\:00.0

- 将内核模块名称

nvidia写入此目录中的 driver_override 文件。# echo nvidia > driver_override

- 更改为表示

nvidia内核模块的 sysfs 目录。# cd /sys/bus/pci/drivers/nvidia

- 将 GPU 的域、总线、插槽和功能写入此目录中的 bind 文件。

# echo domain:bus:slot.function > bind

- domain

- bus

- slot

- function

- GPU 的域、总线、插槽和功能,不带

0x前缀。

此示例写入域为

0000且 PCI 设备 BDF 为06:00.0的 GPU 的域、总线、插槽和功能。# echo 0000:06:00.0 > bind

- 更改为包含物理 GPU 的 PCI 设备信息的 sysfs 目录。

您现在可以按照安装和配置 Red Hat Enterprise Linux KVM 版 NVIDIA 虚拟 GPU 管理器中的说明配置带有 vGPU 的 GPU。

2.10.8. sysfs 文件系统中的 NVIDIA vGPU 信息

有关带有 KVM 虚拟机监控程序的主机中每个物理 GPU 支持的 NVIDIA vGPU 类型的信息存储在 sysfs 文件系统中。

NVIDIA vGPU 信息在 sysfs 文件系统中的存储方式取决于虚拟机监控程序是否将厂商特定的 VFIO 框架用于支持 SR-IOV 的 NVIDIA vGPU。

使用厂商特定的 VFIO 框架的虚拟机监控程序用于支持 SR-IOV 的 NVIDIA vGPU,而对于旧版 NVIDIA vGPU,则使用 mdev VFIO 框架。

对于支持 SR-IOV 的 GPU,厂商特定的 VFIO 框架的使用在 Ubuntu 24.04 版本中引入。有关 NVIDIA vGPU 信息如何在 sysfs 文件系统中存储的更多详细信息,请参阅以下主题

- 使用 mdev VFIO 框架的虚拟机监控程序的 sysfs 文件系统中的 NVIDIA vGPU 信息

- 使用厂商特定的 VFIO 框架的虚拟机监控程序的 sysfs 文件系统中的 NVIDIA vGPU 信息

2.10.8.1. NVIDIA vGPU 使用 sysfs 文件系统的虚拟机监控程序的信息,这些虚拟机监控程序使用 mdev VFIO 框架

主机上的所有物理 GPU 都在 mdev 内核模块中注册。有关物理 GPU 以及可以在每个物理 GPU 上创建的 vGPU 类型的信息存储在 /sys/class/mdev_bus/ 目录下的目录和文件中。

每个物理 GPU 的 sysfs 目录位于以下位置

- /sys/bus/pci/devices/

- /sys/class/mdev_bus/

这两个目录都是指向 sysfs 文件系统中 PCI 设备的真实目录的符号链接。

每个物理 GPU 的 sysfs 目录的组织结构如下

/sys/class/mdev_bus/

|-parent-physical-device

|-mdev_supported_types

|-nvidia-vgputype-id

|-available_instances

|-create

|-description

|-device_api

|-devices

|-name

- 父物理设备

-

主机上的每个物理 GPU 都由 /sys/class/mdev_bus/ 目录的子目录表示。

每个子目录的名称如下

域\:总线\:插槽.功能

域、总线、插槽、功能 是 GPU 的域、总线、插槽和功能,例如

0000\:06\:00.0。每个目录都是指向 sysfs 文件系统中 PCI 设备的真实目录的符号链接。例如

# ll /sys/class/mdev_bus/ total 0 lrwxrwxrwx. 1 root root 0 Dec 12 03:20 0000:05:00.0 -> ../../devices/pci0000:00/0000:00:03.0/0000:03:00.0/0000:04:08.0/0000:05:00.0 lrwxrwxrwx. 1 root root 0 Dec 12 03:20 0000:06:00.0 -> ../../devices/pci0000:00/0000:00:03.0/0000:03:00.0/0000:04:09.0/0000:06:00.0 lrwxrwxrwx. 1 root root 0 Dec 12 03:20 0000:07:00.0 -> ../../devices/pci0000:00/0000:00:03.0/0000:03:00.0/0000:04:10.0/0000:07:00.0 lrwxrwxrwx. 1 root root 0 Dec 12 03:20 0000:08:00.0 -> ../../devices/pci0000:00/0000:00:03.0/0000:03:00.0/0000:04:11.0/0000:08:00.0

- mdev_supported_types

- 在将配置 NVIDIA vGPU 的每个物理 GPU 的 sysfs 目录下,都需要一个名为 mdev_supported_types 的目录。为 GPU 创建此目录的方式取决于 GPU 是否支持 SR-IOV。

- 对于不支持 SR-IOV 的 GPU,在主机上安装虚拟 GPU 管理器并重启主机后,会自动创建此目录。

- 对于支持 SR-IOV 的 GPU,例如基于 NVIDIA Ampere 架构的 GPU,您必须通过启用 GPU 的虚拟功能来创建此目录,如在 Linux 和 KVM 虚拟机监控程序上创建 NVIDIA vGPU中所述。mdev_supported_types 目录本身在物理功能上永远不可见。

mdev_supported_types 目录包含物理 GPU 支持的每种 vGPU 类型的子目录。每个子目录的名称为 nvidia-vgputype-id,其中 vgputype-id 是一个无符号整数序列号。例如

# ll mdev_supported_types/ total 0 drwxr-xr-x 3 root root 0 Dec 6 01:37 nvidia-35 drwxr-xr-x 3 root root 0 Dec 5 10:43 nvidia-36 drwxr-xr-x 3 root root 0 Dec 5 10:43 nvidia-37 drwxr-xr-x 3 root root 0 Dec 5 10:43 nvidia-38 drwxr-xr-x 3 root root 0 Dec 5 10:43 nvidia-39 drwxr-xr-x 3 root root 0 Dec 5 10:43 nvidia-40 drwxr-xr-x 3 root root 0 Dec 5 10:43 nvidia-41 drwxr-xr-x 3 root root 0 Dec 5 10:43 nvidia-42 drwxr-xr-x 3 root root 0 Dec 5 10:43 nvidia-43 drwxr-xr-x 3 root root 0 Dec 5 10:43 nvidia-44 drwxr-xr-x 3 root root 0 Dec 5 10:43 nvidia-45

- nvidia-vgputype-id

- 每个目录代表一个单独的 vGPU 类型,并包含以下文件和目录

- available_instances

- 此文件包含仍可创建的此 vGPU 类型实例的数量。每当在此物理 GPU 上创建或删除此类型的 vGPU 时,此文件都会更新。注意

创建分时 vGPU 时,物理 GPU 上所有其他分时 vGPU 类型的 available_instances 的内容都设置为 0。此行为强制要求物理 GPU 上的所有分时 vGPU 都必须是同一类型。但是,此要求不适用于 MIG 支持的 vGPU。因此,当创建 MIG 支持的 vGPU 时,物理 GPU 上所有其他 MIG 支持的 vGPU 类型的 available_instances 不会设置为 0

- create

- 此文件用于创建 vGPU 实例。通过将 vGPU 的 UUID 写入此文件来创建 vGPU 实例。该文件为只写文件。

- description

- 此文件包含 vGPU 类型的以下详细信息

- vGPU 类型支持的最大虚拟显示头数

- 帧速率限制器 (FRL) 配置,以帧/秒为单位

- 帧缓冲区大小,以 Mbytes 为单位

- 每个显示头的最大分辨率

- 每个物理 GPU 的最大 vGPU 实例数

例如

# cat description num_heads=4, frl_config=60, framebuffer=2048M, max_resolution=4096x2160, max_instance=4

- device_api

- 本文档包含字符串