网络结构#

通过 SU 构建系统可提供最有效的设计。但是,如果由于预算限制、数据中心限制或其他需求而需要不同的节点计数,则应将结构设计为支持完整的 SU,包括叶交换机和叶-脊电缆,并使结构中这些节点所在的部分保持未使用状态。这将确保最佳的流量路由,并确保整个结构的性能保持一致。

DGX SuperPOD 配置使用四种网络结构

计算结构

存储结构

带内管理网络

带外管理网络

注意

本节详细介绍每个网络。

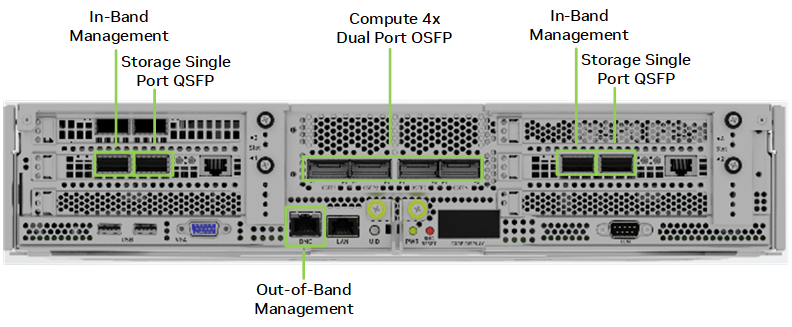

图 4 显示了 DGX B200 CPU 托盘背面的端口以及提供的连接。中间的计算结构端口使用双端口收发器来访问所有八个 GPU。每对带内管理和存储端口都为 DGX B200 系统提供并行路径,以提高性能。OOB 端口用于 BMC 访问。(BMC 端口旁边的 LAN 端口在 DGX SuperPOD 配置中未使用。)

图 4 DGX B200 网络端口#

计算结构#

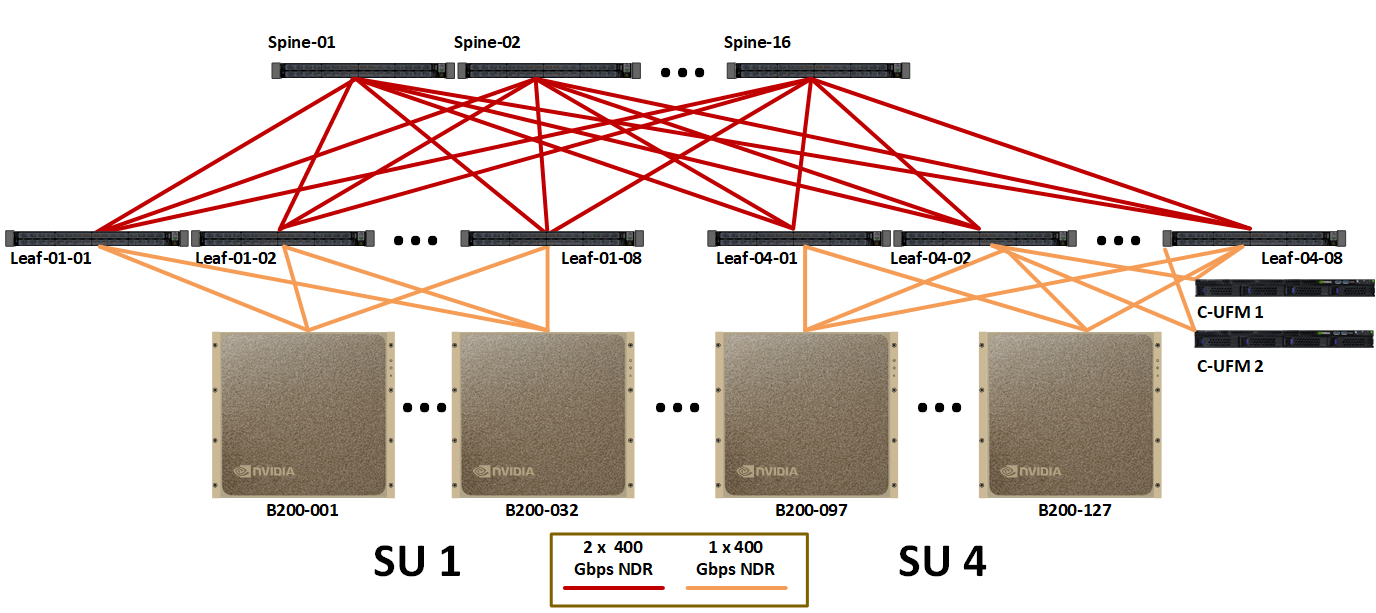

图 5 显示了完整 127 节点 DGX SuperPOD 的计算结构布局。每组 32 个节点都是轨道对齐的。DGX B200 系统的每个轨道流量始终与 SU 中的其他 31 个节点相隔一跳。节点之间或轨道之间的流量会穿过脊柱层。

图 5 完整 127 节点 DGX SuperPOD 的计算结构#

表 4 显示了不同 SU 尺寸的计算结构所需的电缆和交换机数量。

SU 计数 |

节点计数 |

GPU 计数 |

InfiniBand 交换机计数 |

电缆计数 |

||

|---|---|---|---|---|---|---|

叶节点 |

脊柱节点 |

计算和 UFM |

脊柱-叶节点 |

|||

1 |

31¹ |

248 |

8 |

4 |

252 |

256 |

2 |

63 |

504 |

16 |

8 |

508 |

512 |

3 |

95 |

760 |

24 |

16 |

764 |

768 |

4 |

127 |

1016 |

32 |

16 |

1020 |

1024 |

¹. 这是一个每个 SU 32 个节点的设计,但必须移除一个 DGX 系统以适应 UFM 连接。 |

||||||

InfiniBand 存储结构#

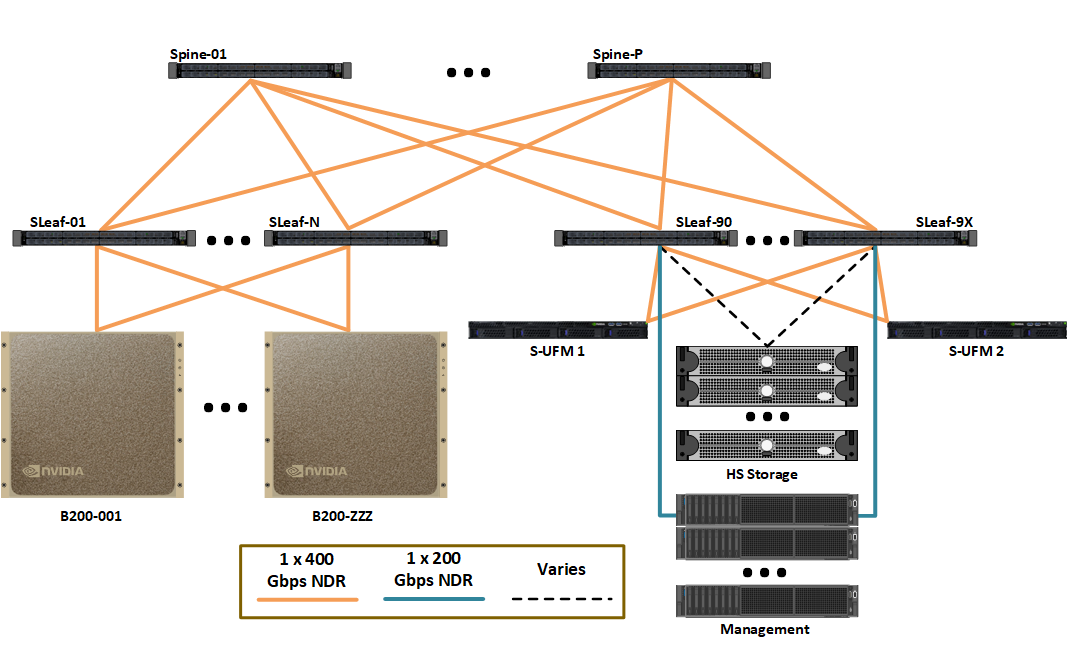

存储结构采用 InfiniBand 网络结构,这对于最大带宽至关重要 (图 6)。这是因为 DGX SuperPOD 的每个节点的 I/O 必须超过 40 GBps。具有高级结构管理功能(如拥塞控制和 AR)的高带宽要求为存储结构提供了显着优势。

图 6 存储结构逻辑设计#

InfiniBand 存储结构使用 MQM9700-NS2F 交换机 (图 7)。高速存储设备以 1:1 的端口到上行链路比率连接。DGX B200 系统连接略微超额订阅,比例接近 4:3,并根据需要进行调整,以实现更高的存储灵活性,兼顾成本和性能。

图 7 MQM9700-NS2F 交换机#

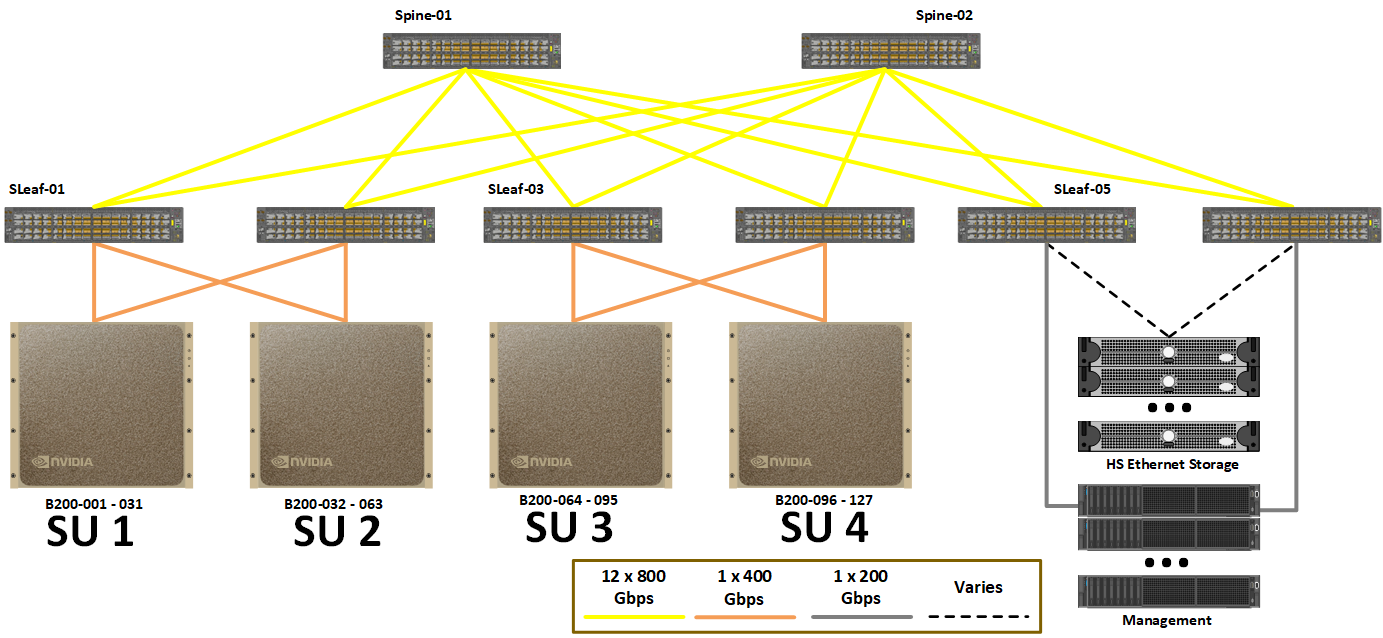

以太网存储结构#

以太网存储结构采用高速以太网网络结构,这对于最大带宽至关重要 (图 8)。这是因为 DGX SuperPOD 的每个节点的 I/O 必须超过 40 GBps。具有高级结构管理功能的高带宽要求为存储结构提供了显着优势。受支持的以太网存储设备利用 RoCE 提供最佳性能并最大限度地减少 CPU 使用率。

图 8 存储结构逻辑设计#

存储结构使用 SN5600 交换机 (numref:sn5600)。高速存储设备以 1:1 的端口到上行链路比率连接。DGX B200 系统连接略微超额订阅,比例接近 4:3,并根据需要进行调整,以实现更高的存储灵活性,兼顾成本和性能。

图 9 NVIDIA Spectrum SN5600 以太网交换机#

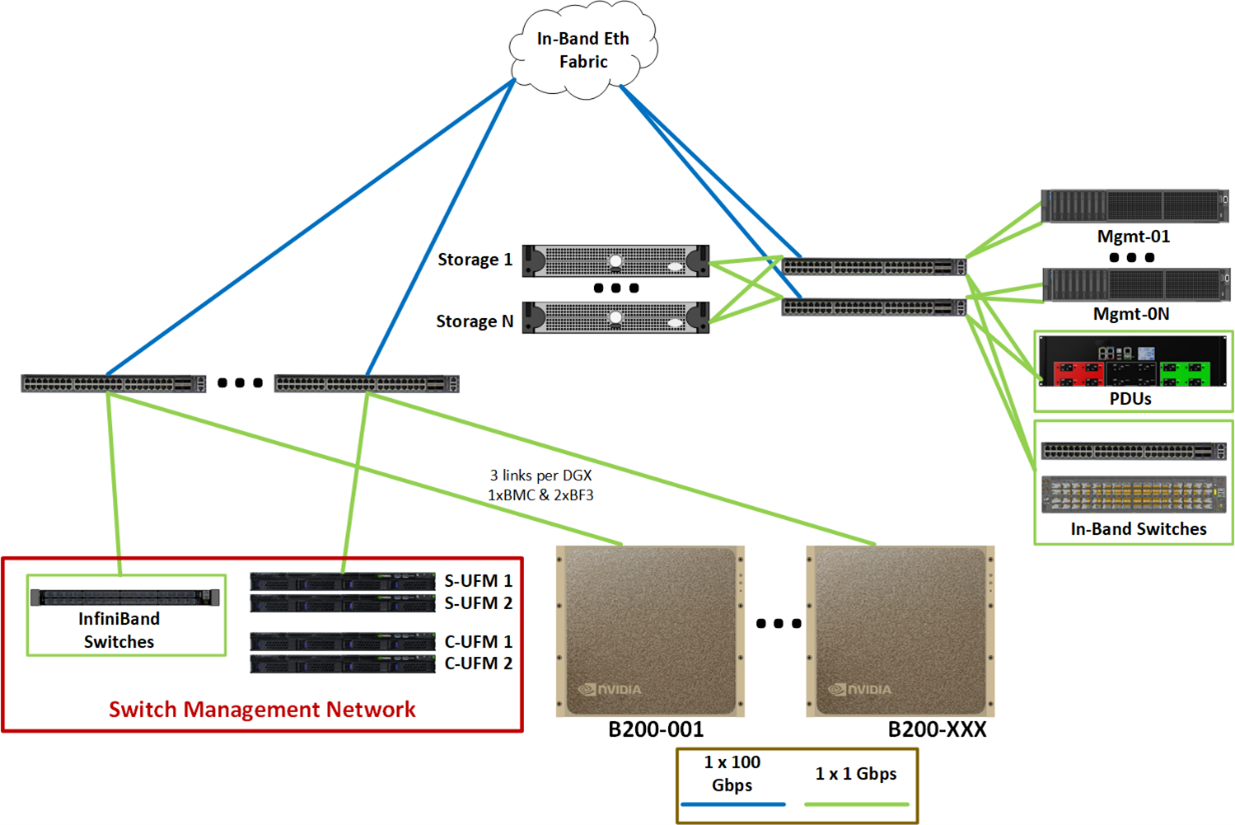

带内管理网络#

带内管理网络提供几个关键功能

连接管理集群的所有服务。

允许访问数据 NFS 层。

为集群内服务(如 Base Command Manager、Slurm、Run:ai)以及集群外服务(如 NGC 注册表、代码存储库和数据源)提供连接。

图 10 显示了带内以太网网络的逻辑布局。带内网络连接计算节点和管理节点。此外,OOB 网络连接到带内网络,以提供来自管理节点的高速接口,以支持对连接到 OOB 存储网络结构(如存储)的设备的并行操作。

OOB 网络结构和带内网络结构在脊柱层上逻辑隔离,以确保这些网络的安全隔离。

图 10 带内以太网网络#

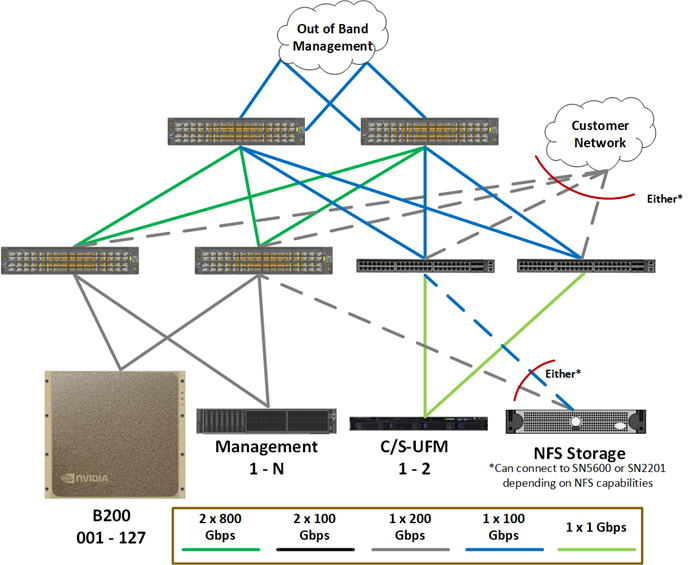

带外管理网络#

图 11 显示了 OOB 以太网网络结构。它连接所有设备的管理端口,包括 DGX 和管理服务器、存储、网络设备、机架 PDU 以及所有其他设备。这些端口被分离到它们自己的网络结构上,因为没有用户需要访问这些端口的用例,并且使用逻辑网络隔离来保护它们。图 11 显示了交换机管理网络是带外网络的子集,提供额外的安全性和弹性。

图 11 逻辑 OOB 管理网络布局#

OOB 管理网络使用 SN2201 交换机 (图 12)。

图 12 SN2201 交换机#