DGX SuperPOD 的关键组件#

DGX SuperPOD 架构旨在最大限度地提高最先进模型训练的性能,扩展至百亿亿次浮点运算的性能,为存储提供最高性能,并为企业、高等教育机构、研究机构和公共部门的所有客户提供支持。它是 NVIDIA 主要研发系统的数字孪生,这意味着公司的软件、应用程序和支持结构首先在相同的架构上进行测试和验证。通过使用 SU,系统部署时间从数月缩短至数周。利用 DGX SuperPOD 设计可缩短下一代模型和应用程序的解决方案交付时间和上市时间。

DGX SuperPOD 是关键 NVIDIA 组件以及经过认证可在 DGX SuperPOD 环境中工作的合作伙伴存储解决方案的集成。

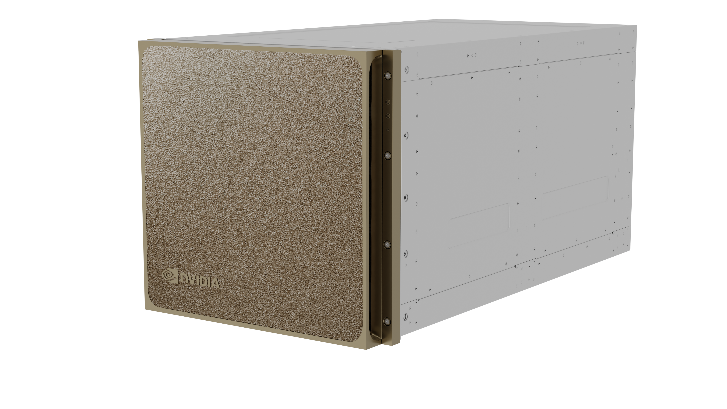

NVIDIA DGX B200 系统#

NVIDIA DGX B200 系统(图 1)是一个 AI 强劲平台,使企业能够扩展业务创新和优化的前沿。DGX B200 系统采用有史以来最强大的芯片,以八个 GPU 配置提供突破性的 AI 性能。NVIDIA Blackwell GPU 架构提供最新的技术,可以将一些最大的 AI/ML 工作负载的计算工作从数月缩短到数天和数小时。

图 1 DGX B200 系统#

与 DGX H200 系统相比,DGX B200 系统的一些主要亮点包括

72 千万亿次浮点运算 FP8 训练和 144 千万亿次浮点运算 FP4 推理

第五代 NVIDIA NVLink。

1,440 GB 聚合 HBM3 内存

NVIDIA InfiniBand 技术#

InfiniBand 是一种高性能、低延迟、支持 RDMA 的网络技术,在最严苛的计算环境中经过 20 多年的验证,可提供最佳的节点间网络性能。InfiniBand 不断发展并引领数据中心网络性能。

NDR 世代 InfiniBand,NDR,具有 400 Gbps 每方向的峰值速度,以及极低的端口到端口延迟,并且向后兼容前几代 InfiniBand 规范。InfiniBand 不仅仅是峰值带宽和低延迟。InfiniBand 提供额外的功能来优化性能,包括自适应路由 (AR)、使用 SHARPTM 的集体通信、使用 SHIELDTM 的动态网络修复,并支持包括 Fat-Tree、Dragonfly 和多维环面在内的多种网络拓扑,以构建最大的结构和计算系统。

运行时和系统管理#

DGX SuperPOD RA 代表了构建高性能数据中心的最佳实践。这些系统如何呈现给客户和用户具有灵活性。NVIDIA Base Command Manager 软件用于管理所有 DGX SuperPOD 部署。

DGX SuperPOD 可以部署在本地,这意味着客户拥有并管理硬件作为传统系统。这可以在客户的数据中心内或商业数据中心托管,但客户拥有硬件。

组件#

DGX SuperPOD 的硬件组件在表 1中进行了描述。软件组件在表 2中显示。

组件 |

NVIDIA 技术 |

描述 |

|---|---|---|

计算节点 |

NVIDIA DGX B200 系统,配备八个 B200 GPU |

世界领先的专用 AI 系统,采用 NVIDIA B200 Tensor Core GPU、第五代 NVIDIA NVLink 和第四代 NVIDIA NVSwitch™ 技术。 |

计算结构 |

NVIDIA Quantum QM9700 NDR 400 Gbps InfiniBand |

轨道优化、非阻塞、全 Fat-Tree 网络,每个系统八个 NDR400 连接 |

InfiniBand 存储结构 |

NVIDIA Quantum QM9700 NDR 400 Gbps InfiniBand |

该结构经过优化,可匹配配置的存储阵列的峰值性能 |

以太网存储结构 |

NVIDIA Spectrum-X SN5600 800 Gbps 以太网 |

用于基于以太网的存储解决方案的可选存储结构 |

计算/存储 InfiniBand 结构管理 |

NVIDIA Unified Fabric Manager Appliance,企业版 |

NVIDIA UFM 结合了增强的实时网络遥测技术与 AI 驱动的网络智能和分析,以管理横向扩展的 InfiniBand 数据中心 |

带内管理网络 |

NVIDIA SN5600 交换机 |

64 端口 800 Gbps 和高达 256 端口 200 Gbps 以太网交换机,提供高端口密度和高性能 |

带内和带外 (OOB) 管理网络 |

NVIDIA SN2201 交换机 |

48 端口 1 Gbps 以太网和 4 个 100 Gbps 交换机,利用铜缆端口最大限度地降低复杂性 |

组件 |

描述 |

|---|---|

用于 AI 集群的全面 AI 基础设施管理。它可以自动执行配置和管理,并支持数千个节点的集群规模。 |

|

NVIDIA AI Enterprise |

NVIDIA AI Enterprise 是一个端到端、云原生软件平台,可加速数据科学管道,并简化生产级副驾驶和其他生成式 AI 应用程序的开发和部署。 |

Magnum IO |

提高 AI 和 HPC 的性能 |

NVIDIA NGC |

NGC 目录提供了一系列针对 AI 和 HPC 优化的 GPU 加速容器 |

Slurm |

一种经典的工作负载管理器,用于管理多节点、批处理式计算环境中的复杂工作负载 |

Run:ai |

云原生 AI 工作负载和 GPU 编排平台,为整个企业 AI 生命周期(包括交互式开发环境、训练和推理)实现部分、完整和多节点支持 |

注意

DGX SuperPOD 仅支持带有 Slurm 或 Run:ai 的 NVIDIA Base Command Manager。

设计要求#

DGX SuperPOD 的设计旨在最大限度地减少紧密耦合配置中的系统瓶颈,以提供最佳性能和应用程序可扩展性。每个子系统都经过周全设计,以实现此目标。此外,整体设计保持灵活性,以便可以定制数据中心要求,以更好地集成到现有数据中心中。

系统设计#

DGX SuperPOD 针对客户特定的多节点 AI 和 HPC 应用程序工作负载进行了优化

基于每个包含 32 个 DGX B200 系统的 SU 的模块化架构。

经过全面测试的系统可扩展至四个 SU,但可以根据客户要求构建更大的部署。

单个机架可以支持每个机架两个 DGX B200 系统,以便可以修改机架布局以适应不同的数据中心要求。

经过认证可在 DGX SuperPOD 环境中工作的存储合作伙伴设备。

全面的系统支持(包括计算、存储、网络和软件)由 NVIDIA Enterprise Experience (NVEX) 提供。

计算结构#

计算结构是轨道优化、平衡、全 Fat-Tree 拓扑

整个设计中使用托管 NDR 交换机,以提供更好的结构管理。

该结构旨在支持最新的 SHaRP 功能。

存储结构(高速存储)#

存储结构为共享存储提供高带宽。它还具有以下特点

它独立于计算结构,以最大限度地提高存储和应用程序性能。

为每个 DGX B200 系统提供至少 40 GBps 的单节点带宽。

存储通过 InfiniBand 或基于融合以太网的 RDMA 提供,以提供最大性能并最大限度地减少 CPU 开销。

它具有灵活性,可以扩展以满足特定的容量和带宽要求。

连接到管理节点是必需的,以提供独立于计算节点的存储访问。

带内管理网络#

带内管理网络结构基于以太网,用于节点配置、数据移动、互联网访问以及用户必须可访问的其他服务。

计算节点和管理节点的带内管理网络连接以 200 Gbps 的速度运行,并绑定以实现弹性。

带外管理网络#

OOB 管理网络连接所有基本管理控制器 (BMC) 端口,以及应与用户物理隔离的其他设备。交换机管理网络是带外网络的子集,可提供额外的安全性和弹性。

存储要求#

DGX SuperPOD 计算架构必须与高性能、平衡的存储系统配对,以最大限度地提高整体系统性能。DGX SuperPOD 旨在使用两个独立的存储系统:高性能存储 (HPS) 和用户存储,针对吞吐量、并行 I/O 以及更高的 IOPS 和元数据工作负载的关键操作进行了优化。

高性能存储#

高性能存储通过来自 DGX SuperPOD 认证存储合作伙伴的 InfiniBand 连接存储提供,并在设计和测试时考虑了以下属性

高性能、弹性、类 POSIX 文件系统,针对跨多个节点的多线程读写操作进行了优化。

InfiniBand 或以太网上的 RDMA 支持

本地系统 RAM 用于数据的透明缓存。

透明地利用本地闪存设备进行读写缓存。

特定的存储结构拓扑、容量和组件由 DGX SuperPOD 认证存储合作伙伴在 DGX SuperPOD 设计过程中确定。

用户存储#

用户存储与高性能存储的不同之处在于,它在带内管理结构上公开了一个 NFS 共享,用于多种用途。它通常用于“主目录”类型的使用(尤其是在使用 Slurm 部署的集群中)、管理临时空间以及 DGX SuperPOD 组件在高可用性配置(例如,Base Command Manager)和日志文件中所需的共享存储。

考虑到这一点,用户存储具有以下要求

需要 100 Gb/s 的连接。

专为高元数据性能、IOPS 和关键企业功能(如检查点)而设计。这与 HPS 不同,后者针对并行 I/O 和大容量进行了优化。

通过以太网使用 NFS 进行通信。

DGX SuperPOD 中的用户存储通常可以通过已部署的现有 NFS 服务器来满足,从而创建一个新的导出并使其可供 DGX SuperPOD 的带内管理网络访问。因此,本 DGX SuperPOD 参考架构中未详细描述用户存储。但是,我们要求用户存储的最低带宽为 100 Gb/s。