NVIDIA 优化框架

NVIDIA 优化框架

深度学习 (DL) 框架通过高级编程接口为设计、训练和验证深度神经网络提供构建模块。广泛使用的 DL 框架,例如 PyTorch、TensorFlow、PyTorch Geometric、DGL 等,依赖于 GPU 加速库(例如 cuDNN、NCCL 和 DALI)来提供高性能、多 GPU 加速的训练。

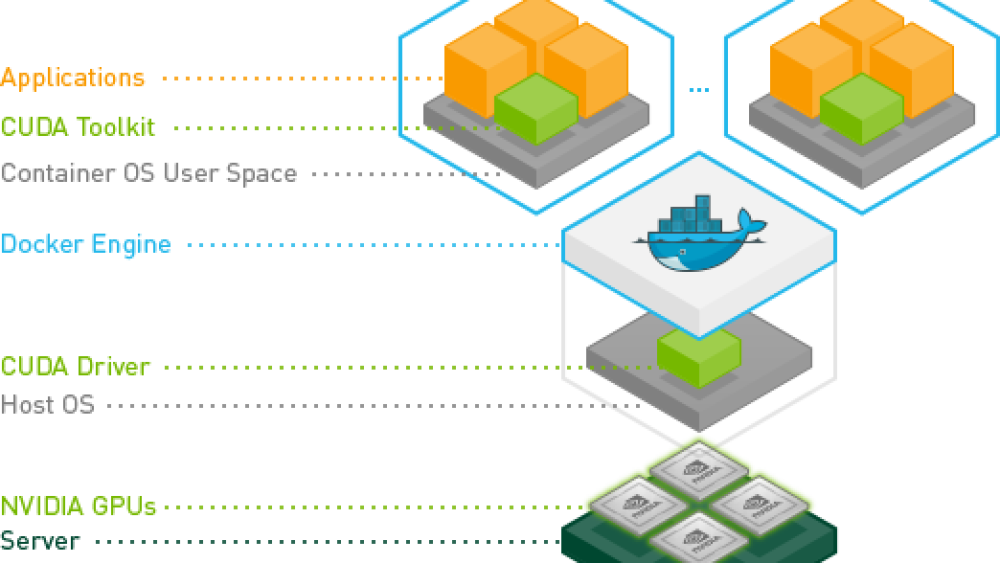

开发人员、研究人员和数据科学家可以轻松访问 NVIDIA AI 优化的 DL 框架容器,其中包含针对 NVIDIA GPU 性能调整和测试的 DL 示例。这消除了管理软件包和依赖项或从源代码构建 DL 框架的需求。容器化的 DL 框架包含所有依赖项,为开始开发常见应用程序(例如对话式 AI、自然语言理解 (NLU)、推荐系统和计算机视觉)提供了一个简单的起点。访问 NVIDIA NGC™ 目录了解更多信息。

这些文档提供有关当前 NVIDIA 优化框架版本的信息。

快速入门

本指南提供在 DGX 系统上准备使用 Docker 容器的初步说明。您必须先设置 DGX 系统,然后才能访问 NVIDIA GPU Cloud (NGC) 容器注册表以拉取容器。

本指南详细概述了容器,并提供了有关拉取和运行容器以及自定义和扩展容器的分步说明。

支持矩阵

此支持矩阵适用于 NVIDIA 优化框架。该矩阵提供了基于容器映像的框架随附的受支持软件和特定版本的单一视图。

更多内容

优化框架发行说明

这些发行说明描述了主要功能、软件增强和改进、已知问题以及如何运行此容器。Kaldi 语音识别框架是一个有用的框架,可以将口语音频转换为基于声学和语言模型的文本。Kaldi 容器每月发布一次,为您提供最新的 NVIDIA 深度学习软件库和已发送或将要发送到上游的 GitHub 代码贡献。这些库和贡献都经过了测试、调整和优化。

这些发行说明描述了主要功能、软件增强和改进、已知问题以及如何运行此容器。Apache MXNet 框架提供高卷积神经网络性能和多 GPU 训练,提供自动微分和优化的预定义层。对于那些需要其模型推理在任何地方运行的人来说,它是一个有用的框架。例如,数据科学家可以使用 Python 编写模型,在配备 Volta 的 DGX-1™ 系统上训练模型,而数据工程师可以使用与公司现有基础设施相关的 Scala API 部署训练后的模型。优化的深度学习框架容器每月发布一次,为您提供最新的 NVIDIA 深度学习软件库和已发送到上游的 GitHub 代码贡献。这些库和贡献都经过了测试、调整和优化。

这些发行说明描述了主要功能、软件增强和改进、已知问题以及如何运行此容器。PyTorch 框架使您能够灵活地开发深度学习模型,并使用 Python 包(例如 SciPy、NumPy 等)。PyTorch 框架方便且灵活,其示例涵盖强化学习、图像分类和机器翻译等更常见的用例。PyTorch 容器每月发布一次,为您提供最新的 NVIDIA 深度学习软件库和已发送到上游的 GitHub 代码贡献。这些库和贡献都经过了测试、调整和优化。

本文档描述了主要功能、软件增强和改进、已知问题以及如何运行此容器。PaddlePaddle 框架可用于教育、研究和产品使用,包括语音、声音识别、信息检索、图像识别和分类。该框架还可用于基于文本的应用程序,例如检测欺诈和威胁、分析时间序列数据以提取统计信息以及视频检测,例如游戏、安全等领域的运动和实时威胁检测。PaddlePaddle 容器每月发布一次,为您提供最新的 NVIDIA 深度学习软件库和已发送到上游的 GitHub 代码贡献。这些库和贡献都经过了测试、调整和优化。

这些发行说明提供了有关主要功能、软件增强和改进、已知问题以及如何运行此容器的信息。TensorFlow 框架可用于教育、研究和产品使用,包括语音、声音识别、信息检索以及图像识别和分类。TensorFlow 框架还可用于基于文本的应用程序,例如检测欺诈和威胁、分析时间序列数据以提取统计信息以及视频检测,例如游戏、安全等领域的运动和实时威胁检测。TensorFlow 容器每月发布一次,为您提供最新的 NVIDIA 深度学习软件库和已发送到上游的 GitHub 代码贡献。这些库和贡献都经过了测试、调整和优化。

这些发行说明描述了此版本的主要功能、软件增强和改进、已知问题以及如何运行容器。

优化框架用户指南

TensorFlow 是一个开源软件库,用于使用数据流图进行数值计算。图中的节点表示数学运算,而图的边表示在它们之间流动的多维数据数组(张量)。这种灵活的架构使您可以将计算部署到一个或多个 CPU 或 GPU(在台式机、服务器或移动设备中),而无需重写代码。TensorFlow 用户指南提供了对使用和自定义 TensorFlow 深度学习框架的详细概述和了解。本指南还提供了有关 NVIDIA TensorFlow 参数的文档,您可以使用这些参数来帮助将容器的优化实施到您的环境中。

为 Jetson 安装框架

本指南提供了在 Jetson 平台上安装 TensorFlow 的说明。Jetson 平台包括 Jetson Nano、Jetson AGX Xavier 和 Jetson TX2 等模块。本指南介绍了在 Jetson 平台上安装 TensorFlow 的先决条件、安装和验证的详细步骤,以及优化 Jetson 平台性能的最佳实践。

本文档包含 Jetson 平台 TensorFlow 安装的发行说明。它描述了在 Jetson 平台上安装 TensorFlow 时的主要功能、软件增强功能和已知问题。

本指南提供了为 Jetson 平台安装 PyTorch 的说明。

本文档包含 Jetson 平台 PyTorch 安装的发行说明。它描述了在 Jetson 平台上安装 PyTorch 时的主要功能、软件增强功能和已知问题。

使用 TensorRT 加速框架中的推理

TensorFlow-TensorRT (TF-TRT) 是一个用于 TensorFlow 的深度学习编译器,可优化 TF 模型以在 NVIDIA 设备上进行推理。TF-TRT 是 NVIDIA TensorRT (TRT) 高性能深度学习推理 SDK 的 TensorFlow 集成,允许用户直接在 TensorFlow 框架内利用其功能。

使用 DLProf 进行分析

深度学习分析器 (DLProf) 用户指南提供了有关使用 DLProf 工具来提高深度学习模型性能的说明。

深度学习分析器 (DLProf) 发行说明简要介绍了 DLProf 工具。