快速入门指南#

本快速入门指南将帮助您快速部署和配置 NVIDIA AI Enterprise,从而在裸机、公有云或虚拟化环境中启用 AI 工作负载。请按照以下步骤无缝设置和优化您的基础设施,以加速 AI 和深度学习任务。

有关安装和配置 NVIDIA AI Enterprise、在 NVIDIA vGPU 部署中使用它或使用多个节点的完整说明,请参阅NVIDIA AI Enterprise 部署指南。

注意

这些说明不适用于 NVIDIA DGX 系统。有关如何使用这些系统的信息,请参阅 NVIDIA DGX Systems。

注意

如果您之前购买过 NVIDIA AI Enterprise,拥有 NVIDIA 企业帐户和 NGC 帐户,则可以直接转到安装 NVIDIA AI Enterprise 软件组件。

激活帐户以获取 NVIDIA AI Enterprise#

在您的 NVIDIA AI Enterprise 订单处理完毕后,您将收到订单确认消息。此消息包含您获取 NVIDIA AI Enterprise 和 NVIDIA 技术支持所需的信息。要获取 NVIDIA AI Enterprise 和 NVIDIA 技术支持,您必须拥有 NVIDIA 企业帐户,该帐户提供对以下 NVIDIA 软件组件的登录访问权限

NVIDIA NGC - 提供对 NVIDIA AI Enterprise 中包含的所有企业软件、服务和管理工具的访问权限

NVIDIA 企业支持门户 - 提供对 NVIDIA AI Enterprise 支持服务的访问权限

NVIDIA 许可门户 - 提供对您的权利和选项的访问权限,用于管理您的 NVIDIA AI Enterprise 许可证服务器。安装和管理 NVIDIA AI Enterprise 许可证服务器是部署 vGPU 软件的先决条件。

可以从 NVIDIA Application Hub 访问这些组件。要激活您的帐户并访问 NVIDIA AI Enterprise,请按照以下步骤操作

开始之前#

在尝试本指南中的步骤之前,请确保满足以下先决条件

您拥有支持 NVIDIA AI Enterprise 的第三方 NVIDIA 认证服务器平台。

您的服务器平台中安装了一个或多个支持 NVIDIA AI Enterprise 的 NVIDIA GPU。

您拥有有效的 NVIDIA 软件订阅。

如果您使用随 NVIDIA AI Enterprise 软件提供的 GPU,例如 NVIDIA H100 PCIe GPU,则您用于 H100 的 NVIDIA AI Enterprise 许可证已激活。

NVIDIA AI Enterprise 发行说明提供了有关受支持的硬件和软件以及与此 NVIDIA AI Enterprise 版本相关的任何已知问题的信息。

您的订单确认消息#

在您的 NVIDIA AI Enterprise 订单处理完毕后,您将收到一封订单确认消息,其中附带您的 NVIDIA 权利证书。该证书包含您的产品激活密钥,并提供有关如何使用它的说明。

如果您是数据中心管理员,请按照 NVIDIA 权利证书中的说明使用该证书。否则,请将您的订单确认消息(包括随附的 NVIDIA 权利证书)转发给您组织中的数据中心管理员。

NVIDIA 企业帐户要求#

您必须拥有合适的 NVIDIA 企业帐户才能访问 NVIDIA AI Enterprise 和 NVIDIA 的技术支持。

您是否拥有合适的 NVIDIA 企业帐户取决于您之前是否购买过 NVIDIA AI Enterprise。

如果您之前购买过 NVIDIA AI Enterprise,您已经拥有合适的 NVIDIA 企业帐户。从 NVIDIA NGC 上的 NVIDIA AI Enterprise Infra Release 5 集合下载您需要的软件资产,以使用此帐户获取 NVIDIA AI Enterprise。有关详细信息,请参阅访问 NVIDIA AI Enterprise 软件套件。

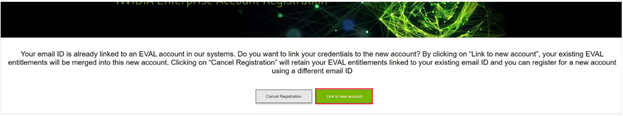

如果您已获得评估许可证但之前未购买过 NVIDIA AI Enterprise,则您不拥有合适的 NVIDIA 企业帐户。要创建合适的 NVIDIA 企业帐户,请按照证书使用说明中的注册链接,为您的已购买许可证创建帐户。您可以为您的已购买许可证创建单独的帐户,或将您现有的评估许可证帐户链接到已购买许可证的帐户。

要为您的已购买许可证创建单独的帐户,请按照创建您的 NVIDIA 企业帐户中的说明进行操作,指定与您创建现有帐户时使用的地址不同的电子邮件地址。

要将您现有的评估许可证帐户链接到已购买许可证的帐户,请按照将评估帐户链接到已购买许可证的 NVIDIA 企业帐户中的说明进行操作,指定您创建现有帐户时使用的电子邮件地址。

如果您之前未购买过 NVIDIA AI Enterprise,则您不拥有合适的 NVIDIA 企业帐户。

要创建合适的 NVIDIA 企业帐户,请按照证书使用说明中的注册链接创建您的帐户。有关详细信息,请参阅创建您的 NVIDIA 企业帐户。

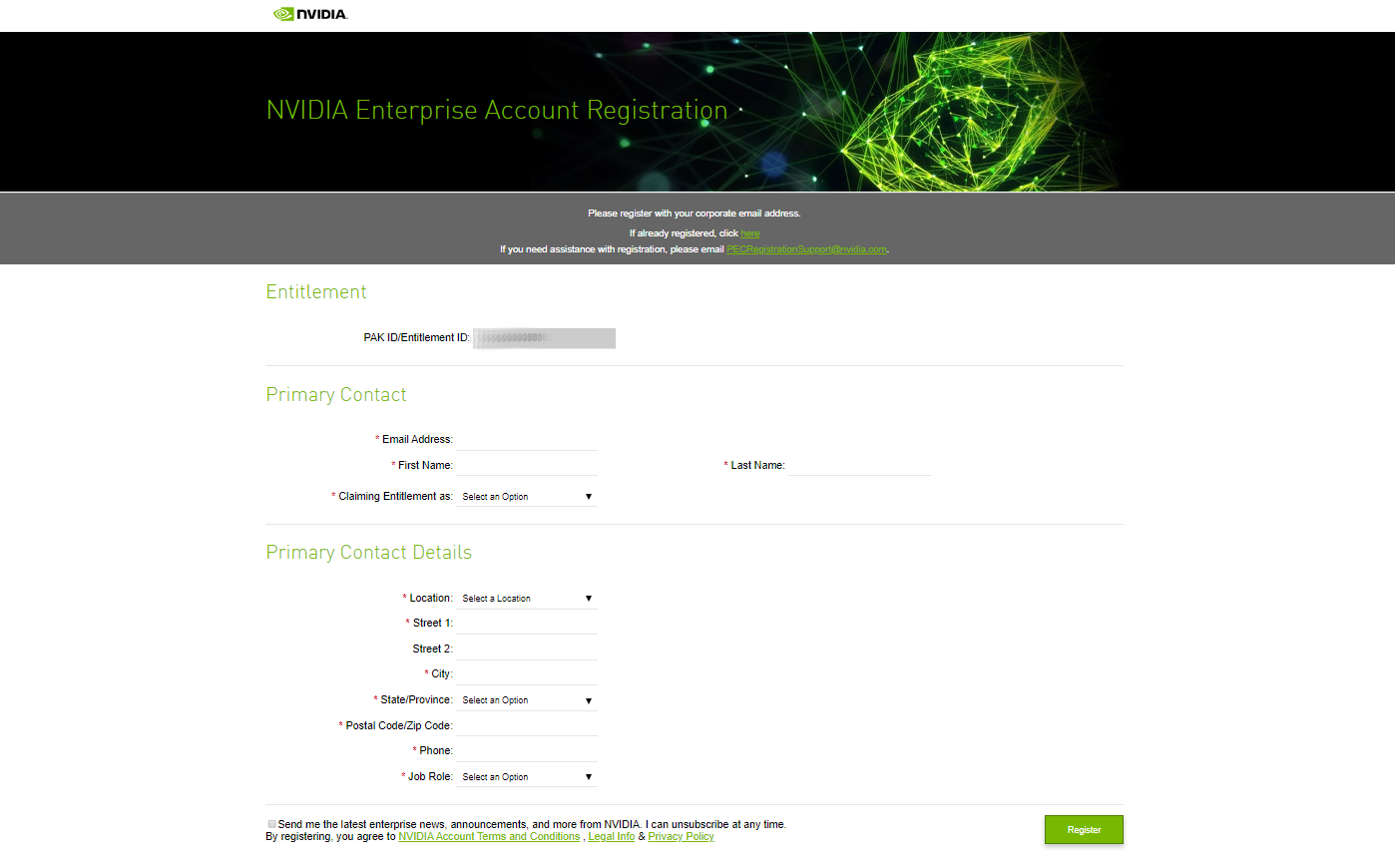

创建您的 NVIDIA 企业帐户#

如果您没有 NVIDIA 企业帐户,则必须创建一个帐户才能访问 NVIDIA AI Enterprise 软件组件和 NVIDIA 的技术支持。有关这些软件组件的详细信息,请参阅激活帐户以获取 NVIDIA AI Enterprise。

假设您有一个为评估许可证创建的帐户,并且想要访问您购买的许可证。在这种情况下,当您收到购买的许可证时,您必须重复注册过程。您可以为您的已购买许可证创建单独的帐户,或将您现有的评估许可证帐户链接到已购买许可证的帐户。

要为您的已购买许可证创建单独的帐户,请执行此任务,并指定与您创建现有帐户时使用的电子邮件地址不同的电子邮件地址。

要将您现有的评估许可证帐户链接到已购买许可证的帐户,请按照将评估帐户链接到已购买许可证的 NVIDIA 企业帐户中的说明进行操作,指定您创建现有帐户时使用的电子邮件地址。

在开始之前,请确保您拥有订单确认消息。

按照 NVIDIA 权利证书使用说明中的注册链接。

填写 NVIDIA 企业帐户注册页面表单,然后单击“注册”。将出现一条消息,确认已创建帐户。然后,您提供的电子邮件地址将收到一封电子邮件,指示您登录到 NVIDIA Application Hub 上的帐户。

打开指示您登录帐户的电子邮件,然后单击登录。

在打开的 NVIDIA Application Hub 登录页面上,在文本输入字段中键入您提供的电子邮件地址,然后单击登录。

在打开的“创建您的帐户”页面上,提供并确认帐户密码,然后单击创建帐户。将出现一条消息,提示您验证您的电子邮件地址。一封指示您验证电子邮件地址的电子邮件将发送到您提供的电子邮件地址。

打开指示您验证电子邮件地址的电子邮件,然后单击验证电子邮件地址。将出现一条消息,确认您的电子邮件地址已验证。

您现在可以从 NVIDIA Application Hub 页面登录到激活帐户以获取 NVIDIA AI Enterprise中列出的组件。

将评估帐户链接到已购买许可证的 NVIDIA 企业帐户#

如果您有一个为评估许可证创建的帐户,则当您收到购买的许可证时,必须重复注册过程。要将您现有的评估许可证帐户链接到已购买许可证的帐户,请使用您创建现有帐户时使用的电子邮件地址注册 NVIDIA 企业帐户。

如果您想为您的已购买许可证创建单独的帐户,请按照创建您的 NVIDIA 企业帐户中的说明进行操作,指定与您创建现有帐户时使用的地址不同的电子邮件地址。

安装 NVIDIA AI Enterprise 软件组件#

NVIDIA NGC 目录#

NVIDIA AI Enterprise 组件通过 NVIDIA NGC 目录分发。基础设施和工作负载管理组件作为 NVIDIA AI Enterprise Infra Release 5 集合中的资源分发。用于 AI 开发和用例的工具可从 NVIDIA AI Enterprise Software Suite 获得。

访问 NVIDIA AI Enterprise 基础设施资源#

NVIDIA AI Enterprise 的基础设施和工作负载管理组件作为 NVIDIA AI Enterprise Infra Release 5 集合中的资源分发。

NVIDIA AI Enterprise Infra Release 5 集合提供捆绑在一起的基础设施管理和编排软件,以高效管理和扩展 AI 工作负载,并包含以下资源

GPU Operator

Network Operator

NVIDIA NIM Operator

vGPU Host Driver

容器化 vGPU Guest Driver

容器化 NVIDIA GPU 数据中心驱动程序

NVIDIA Base Command Manager Essentials

在下载任何 NVIDIA AI Enterprise 软件资产之前,请确保您已从 NVIDIA NGC 登录页面登录到 NVIDIA NGC。

转到 NVIDIA NGC 上的 NVIDIA AI Enterprise Infra Release 5 集合。

单击实体选项卡,然后选择您感兴趣的资源。

单击下载,然后从打开的菜单中选择使用浏览器直接下载、显示的

wget命令或 CLI 下载资源。

访问 NVIDIA AI Enterprise 软件套件#

用于 AI 开发和用例的工具可从 NVIDIA AI Enterprise Software Suite 获得,并通过 NVIDIA NGC 目录分发。

在下载任何 NVIDIA AI Enterprise 软件资产之前,请确保您已从 NVIDIA NGC 登录页面登录到 NVIDIA NGC。

在 NVIDIA NGC 上查看 NVIDIA AI Enterprise Software Suite。

转到 NVIDIA NGC 上的 NVIDIA AI Enterprise Supported 页面。

访问 NVIDIA NGC 站点并设置 NVIDIA AI Enterprise Support 过滤器。

浏览 NVIDIA AI Enterprise Software Suite 以查找您感兴趣的软件资产。

对于您感兴趣的每个软件资产,单击该资产以了解更多信息或下载该资产。

NVIDIA AI Enterprise 部署选项#

下表概述了用于部署 NVIDIA AI Enterprise 的最常用方法。

类别 |

入门指南 |

部署指南 |

参考教程 |

|---|---|---|---|

在裸机上部署 |

|||

在公有云上部署 |

|||

在使用 NVIDIA vGPU (C-Series) 的虚拟化环境中部署 |

在裸机 Ubuntu 22.04 上安装 NVIDIA AI Enterprise#

NVIDIA AI Enterprise 快速入门指南的本节提供了在第三方 NVIDIA 认证系统上使用 Docker 进行 NVIDIA AI Enterprise 裸机单节点部署的最简说明。

NVIDIA AI Enterprise 软件先决条件#

要为数据中心中运行的计算和 AI 工作负载启用 NVIDIA GPU 加速

从此位置下载 NVIDIA GPU 数据中心驱动程序。

选择Linux 64 位,Ubuntu 22.04作为操作系统以下载

.run文件。

使用 TRD 驱动程序从 .run 文件在 Ubuntu 22.04 上安装 NVIDIA AI Enterprise#

Linux 的 NVIDIA AI Enterprise 软件驱动程序的安装需要

编译器工具链

内核标头

先决条件

确保您遵循预安装步骤。

注意

如果您喜欢 Debian 软件包,请参阅Debian 说明。

步骤

登录到系统并检查更新。

sudo apt-get update

在终端中安装 GCC 编译器和 make 工具。

sudo apt-get install build-essential

将 NVIDIA AI Enterprise Linux 驱动程序包(例如,

NVIDIA-Linux-x86_64-550.90.12.run)复制到您要安装驱动程序的主机。其中

x_x:xxx.xx.xx是当前的 NVIDIA AI Enterprise 版本和驱动程序版本。导航到包含 NVIDIA 驱动程序

.run文件的目录。然后,使用chmod命令将可执行权限添加到 NVIDIA 驱动程序文件。sudo chmod +x NVIDIA-Linux-x86_64-xxx.xx.xx-grid.run

从控制台 shell 中,以 root 用户身份运行驱动程序安装程序,并接受默认设置。

sudo sh ./NVIDIA-Linux-x86_64-xxx.xx.xx-grid.run

重新启动系统。

sudo reboot

系统重新启动后,确认您可以从

nvidia-smi的输出中看到您的 NVIDIA vGPU 设备。nvidia-smi

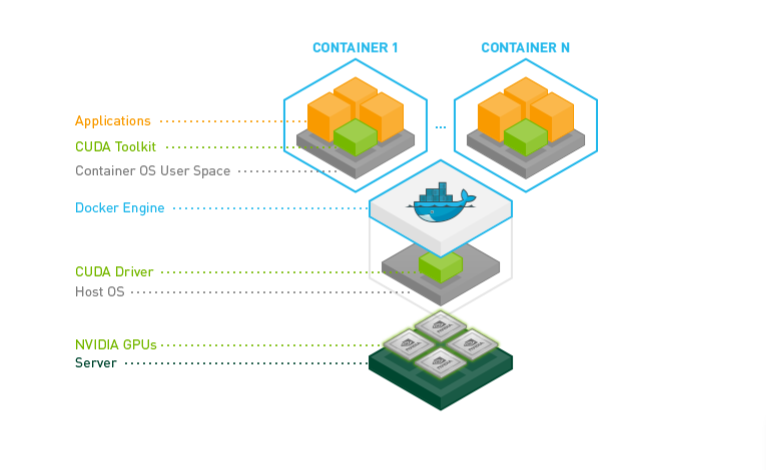

安装 NVIDIA Container Toolkit#

NVIDIA Container Toolkit 允许用户构建和运行 GPU 加速的 Docker 容器。它包括一个容器运行时 库和实用程序,用于配置容器以自动利用 NVIDIA GPU。完整的文档和常见问题解答可在存储库 Wiki上找到。

安装 Docker - 有关 Ubuntu 的安装过程,请参阅 在 Ubuntu 上安装 Docker Engine | Docker 文档。

安装 NVIDIA Container Toolkit - 要启用 Docker 存储库并安装 NVIDIA Container Toolkit,请参阅安装 NVIDIA Container Toolkit | NVIDIA 文档。

安装 NVIDIA Container Toolkit 后,请参阅 配置 | NVIDIA 文档以配置 Docker 容器运行时。

验证 NVIDIA Container Toolkit 的安装#

运行

nvidia-smi命令,该命令包含在与您的机器上运行的 NVIDIA CUDA Toolkit 驱动程序版本兼容的最新官方 NVIDIA CUDA Toolkit 映像中。注意

不要使用 NVIDIA CUDA Toolkit 映像的版本晚于您的机器上运行的 NVIDIA CUDA Toolkit 驱动程序的版本。有关所有 NVIDIA CUDA Toolkit 映像的列表,请参阅 Docker Hub 上的 nvidia/cuda。

$ sudo docker run --rm --runtime=nvidia --gpus all ubuntu nvidia-smi

在任意两个可用的 GPU 上启动 GPU 启用的容器。

$ docker run --runtime=nvidia --gpus 2 nvidia/cuda:12.4.0-base-ubuntu22.04 nvidia-smi

在由索引号标识的两个特定 GPU 上启动 GPU 启用的容器。

$ docker run --runtime=nvidia --gpus '"device=1,2"' nvidia/cuda:12.4.0-base-ubuntu22.04 nvidia-smi

在两个特定的 GPU 上启动 GPU 启用的容器,其中一个 GPU 由其 UUID 标识,另一个 GPU 由其索引号标识。

$ docker run --runtime=nvidia --gpus '"device=UUID-ABCDEF,1"' nvidia/cuda:12.4.0-base-ubuntu22.04 nvidia-smi

为容器指定 GPU 功能。

$ docker run --runtime=nvidia --gpus all,capabilities=utility nvidia/cuda:12.4.0-base-ubuntu22.04 nvidia-smi

安装作为容器映像分发的软件#

通过 NVIDIA NGC 目录访问的 NGC 容器映像包括 AI 和数据科学应用程序和框架。用于 AI 和数据科学应用程序或框架的每个容器映像都包含运行应用程序或框架所需的整个用户空间软件堆栈,即 CUDA 库、cuDNN、任何必需的 Magnum IO 组件、TensorRT 和框架。

确保您已完成 NGC 私有注册表用户指南中的以下任务

从主机执行此任务。获取 Docker pull 命令,以下载 NGC 公共目录中应用程序或组件列表中的每个应用程序和深度学习框架组件。

应用程序

NVIDIA NIM

NVIDIA Clara Parabricks

NVIDIA DeepStream

NVIDIA Riva

MONAI - 用于人工智能的医疗开放网络

RAPIDS

RAPIDS Accelerator for Apache Spark

TAO

深度学习框架组件

NVIDIA TensorRT

NVIDIA Triton Inference Server

PyTorch

TensorFlow 2

使用 TensorFlow 运行 ResNet-50#

在交互模式下在所有 GPU 上启动 TensorFlow 1 容器映像,指定容器在停止时将被删除。

$ sudo docker run --gpus all -it --rm \ nvcr.io/nvidia/tensorflow-pb24h1:24.03.06-tf2-py3nvcr.io/nvidia/tensorflow:21.07-tf1-py3

从容器运行时内部,更改到包含

cnn示例的测试数据的目录。# cd /workspace/nvidia-examples/cnn使用 FP16 精度运行 ResNet-50 训练测试。

# python resnet.py --layers 50 -b 64 -i 200 -u batch --precision fp16确认应用程序上的所有操作都正确执行,并在测试完成时报告一组结果。

按 Ctrl+P > Ctrl+Q 退出容器运行时并返回到 Linux 命令 shell。

使用 TensorRT 运行 ResNet-50#

在交互模式下在所有 GPU 上启动 NVIDIA TensorRT 容器映像,指定容器在停止时将被删除。

$ sudo docker run --gpus all -it --rm nvcr.io/nvidia/tensorrt:21.07-py3

从容器运行时内部,更改到包含 ResNet-50 卷积神经网络的测试数据的目录。

# cd /workspace/tensorrt/data/resnet50使用 FP32、FP16 和 INT8 精度运行 ResNet-50 卷积神经网络,并确认每次测试都以 PASSED 结果完成。

要使用默认 FP32 精度运行 ResNet-50,请运行以下命令

# trtexec --duration=90 --workspace=1024 --percentile=99 --avgRuns=100 \ --deploy=ResNet50_N2.prototxt --batch=1 --output=prob

要使用 FP16 精度运行 ResNet-50,请添加

--fp16选项# trtexec --duration=90 --workspace=1024 --percentile=99 --avgRuns=100 \ --deploy=ResNet50_N2.prototxt --batch=1 --output=prob --fp16

要使用 INT8 精度运行 ResNet-50,请添加

--int8选项# trtexec --duration=90 --workspace=1024 --percentile=99 --avgRuns=100 \ --deploy=ResNet50_N2.prototxt --batch=1 --output=prob --int8

按 Ctrl+P > Ctrl+Q 退出容器运行时并返回到 Linux 命令 shell。

在裸机 Ubuntu 22.04 上运行 NVIDIA NIM#

NVIDIA 推理微服务 (NIM) 为开发 AI 驱动的企业应用程序和在生产环境中部署 AI 模型提供了简化的路径。您可以从 NVIDIA NGC 目录下载并运行您选择的 NIM。按照以下说明在您的裸机主机设置上部署 Llama3 8B Instruct NIM 并运行推理。

使用 Docker 拉取并运行

meta/llama3-8b(这将下载完整模型并在您的本地环境中运行它)。$ docker login nvcr.io Username: $oauthtoken Password: <PASTE_API_KEY_HERE>

拉取并运行 NVIDIA NIM。这将下载针对您的基础设施优化的模型。

export NGC_API_KEY=<PASTE_API_KEY_HERE> export LOCAL_NIM_CACHE=~/.cache/nim mkdir -p "$LOCAL_NIM_CACHE" docker run -it --rm \ --gpus all \ --shm-size=16GB \ -e NGC_API_KEY=$NGC_API_KEY \ -v "$LOCAL_NIM_CACHE:/opt/nim/.cache" \ -u $(id -u) \ -p 8000:8000 \ nvcr.io/nim/meta/llama3-8b-instruct:1.0.0

进行本地 API 调用。

curl -X 'POST' \ 'http://0.0.0.0:8000/v1/chat/completions' \ -H 'accept: application/json' \ -H 'Content-Type: application/json' \ -d '{ "model": "meta/llama3-8b-instruct", "messages": [{"role":"user", "content":"Write a limerick about the wonders of GPU computing."}], "max_tokens": 64 }'

有关在此本地部署的 LLM NIM 上运行推理的更多信息,请参阅启动 LLM 的 NVIDIA NIM。

在公有云上安装 NVIDIA AI Enterprise#

NVIDIA AI Enterprise 可以在 Amazon Web Services (AWS)、Google Cloud、Microsoft Azure、Oracle Cloud Infrastructure (OCI)、Alibaba Cloud 和 Tencent Cloud 上运行。

本 NVIDIA AI Enterprise 快速入门指南部分提供了使用 NVIDIA AI Enterprise VMI 在 Microsoft Azure 上部署 NVIDIA AI Enterprise 的最简说明。

使用 NVIDIA AI Enterprise VMI 在 Microsoft Azure 上安装 NVIDIA AI Enterprise#

NVIDIA AI Enterprise On-Demand VMI 在几分钟内生成一个 GPU 加速的 Compute Engine VM 实例,其中预装了加速您的机器学习、深度学习、数据科学和 HPC 工作负载的软件。

On-Demand VMI 预配置了以下软件

Ubuntu 操作系统

NVIDIA GPU 数据中心驱动程序

Docker-ce

NVIDIA Container Toolkit

CSP CLI、NGC CLI

Miniconda、JupyterLab、Git

令牌激活脚本

在您的企业 (On-Demand) VMI 云实例中开始使用 NVIDIA AI Enterprise 可以分解为两个简单的步骤

通过将提供的实例 ID 令牌复制到 NGC 上的“激活订阅”页面来授权 VMI 云实例使用 NVIDIA NGC。完成此部分过程需要四个关键步骤

从 VMI 获取身份令牌。

使用令牌激活您的 NVIDIA AI Enterprise 订阅。

生成 API 密钥以访问目录。

将 API 密钥放在 VMI 上。

按照此处概述的说明完成此步骤。

拉取和运行 NVIDIA AI Enterprise 容器。有关通过 NVIDIA NGC 目录拉取和运行 NGC 容器映像的信息,请参阅云部署指南的此部分。

有关在公有云上安装 NVIDIA AI Enterprise 的详细说明,请参阅Microsoft Azure 概述。

在 Microsoft Azure 上使用 NVIDIA AI Enterprise 运行 LLM NIM#

有关通过 NVIDIA NGC 目录拉取和运行 NGC 容器映像的信息,请参阅云部署指南的附录部分。

在使用 NVIDIA vGPU (C-Series) 的虚拟化环境中安装 NVIDIA AI Enterprise#

NVIDIA AI Enterprise VMware 部署指南提供了有关在使用 NVIDIA vGPU (C-Series) 的运行 VMware vSphere 的第三方 NVIDIA 认证系统上部署 NVIDIA AI Enterprise 的详细信息。

NVIDIA AI Enterprise 软件先决条件#

NVIDIA vGPU (C-Series) 主机驱动程序

NVIDIA vGPU (C-Series) 客户端驱动程序

NVIDIA 许可证系统

要下载 NVIDIA vGPU (C-Series) 软件驱动程序,请按照访问 NVIDIA AI Enterprise 基础设施资源中的说明进行操作。

NVIDIA AI Enterprise 许可证使客户有权通过 NVIDIA NGC 下载 NVIDIA vGPU (C-Series) 软件。使用 vGPU 部署 NVIDIA AI Enterprise 需要有效的许可证,该许可证通过安装 NVIDIA 许可证系统来强制执行。NVIDIA 许可证系统是许可 NVIDIA 软件产品的浮动许可证池,配置了从 NVIDIA 许可门户获得的许可证。

NVIDIA 许可证系统支持以下类型的服务实例

云许可证服务 (CLS) 实例。CLS 实例托管在 NVIDIA 许可门户上。

委派许可证服务 (DLS) 实例。DLS 实例托管在本地网络可访问的位置,例如您的数据中心内部。

具有网络连接的 NVIDIA vGPU (C-Series) 客户端 VM 通过从 NVIDIA 许可证系统服务实例租用许可证来获得许可证。服务实例通过网络从从 NVIDIA 许可门户获得的浮动许可证池中向客户端提供许可证。当许可客户端不再需要许可证时,许可证将返回到服务实例。

要激活 NVIDIA vGPU (C-Series),必须在 vGPU VM 客户端启动时为其配置软件许可。NVIDIA vGPU (C-Series) VM 在获得许可证之前以降低的功能运行。

有关配置快速云许可证服务 (CLS) 实例和验证许可 vGPU VM 客户端的许可证状态的说明,请参阅NVIDIA 许可快速入门指南。

如果您使用委派许可证服务 (DLS) 实例来提供许可证,请参阅NVIDIA 许可证系统用户指南。它提供了有关安装、配置和管理 NVIDIA 许可证系统的详细说明。

获取 NVIDIA Base Command Manager Essentials#

NVIDIA Base Command Manager Essentials 简化了数据中心中的集群配置、工作负载管理和基础设施监控。在裸机部署中,它简化了 NVIDIA Base Command Manager Essentials 支持的操作系统安装。

在获取 NVIDIA Base Command Manager Essentials 之前,请确保您已激活 NVIDIA AI Enterprise 的帐户,如激活帐户以获取 NVIDIA AI Enterprise中所述。

通过将您的权利证书通过电子邮件发送至 sw-bright-sales-ops@NVIDIA.onmicrosoft.com,请求您的 NVIDIA Base Command Manager Essentials 产品密钥。在审核您的权利证书后,您将收到一个产品密钥,您可以从中为您购买的许可证数量生成许可证密钥。

转到 此页面以下载适用于您的操作系统的 NVIDIA Base Command Manager Essentials。

Base Command Manager Essentials 产品手册提供了有关部署和使用 Base Command Manager Essentials 的详细说明。

在获取 NVIDIA Base Command Manager Essentials 后,请按照NVIDIA Base Command Manager Essentials 安装手册中的步骤创建您的头节点并获得许可。