安装 AI 和数据科学应用程序及框架#

访问 AI 和数据科学工具及框架#

AI 和数据科学应用程序及框架作为 NGC 容器镜像通过 NVIDIA NGC 目录分发。每个容器镜像都包含运行应用程序或框架所需的整个用户空间软件栈;即 CUDA 库、cuDNN、任何所需的 Magnum IO 组件、TensorRT 和框架。

在您希望将 AI 和数据科学容器拉取到的环境中执行以下工作流程步骤。

首先,您需要使用您的 NVIDIA 帐户和密码登录 NGC。

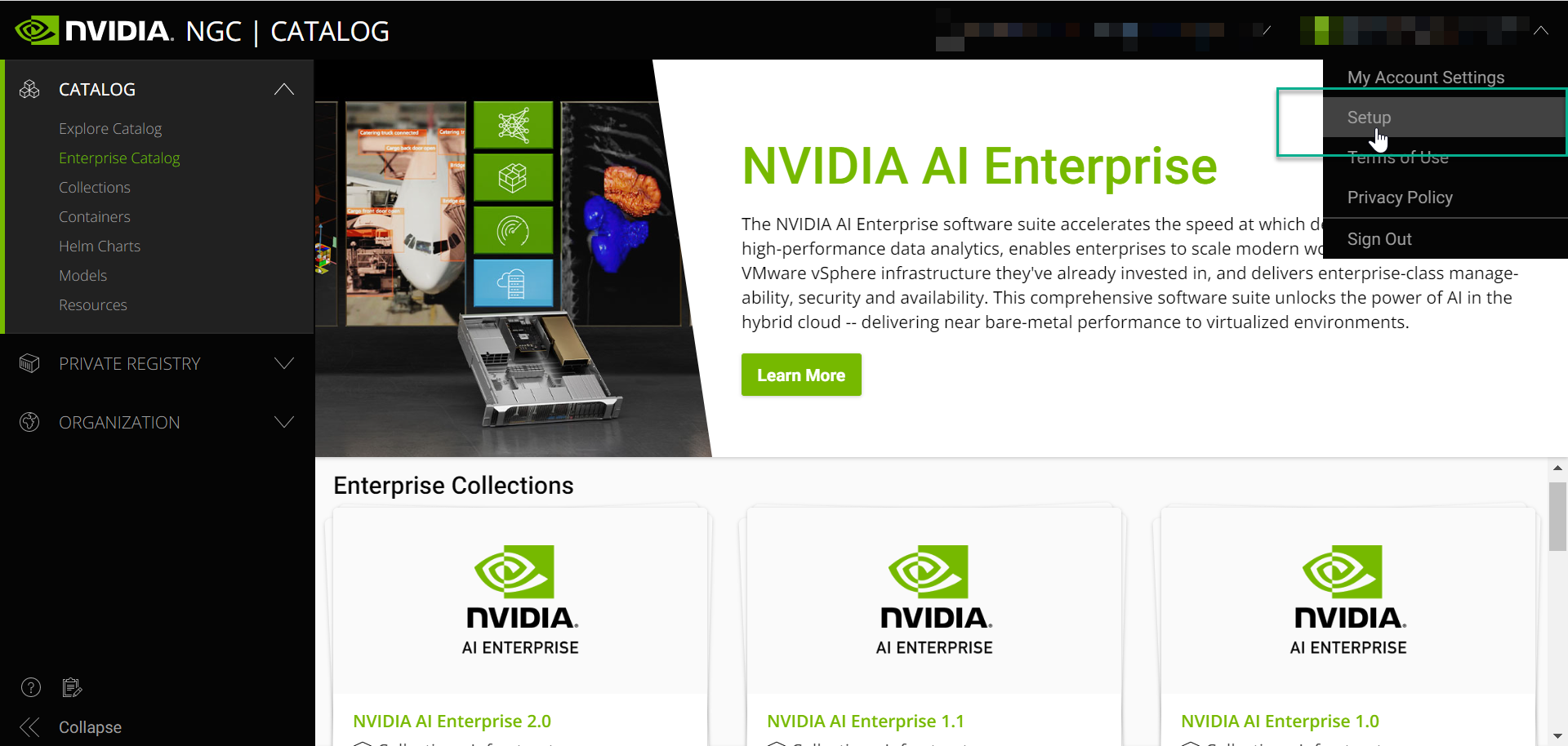

导航到设置。

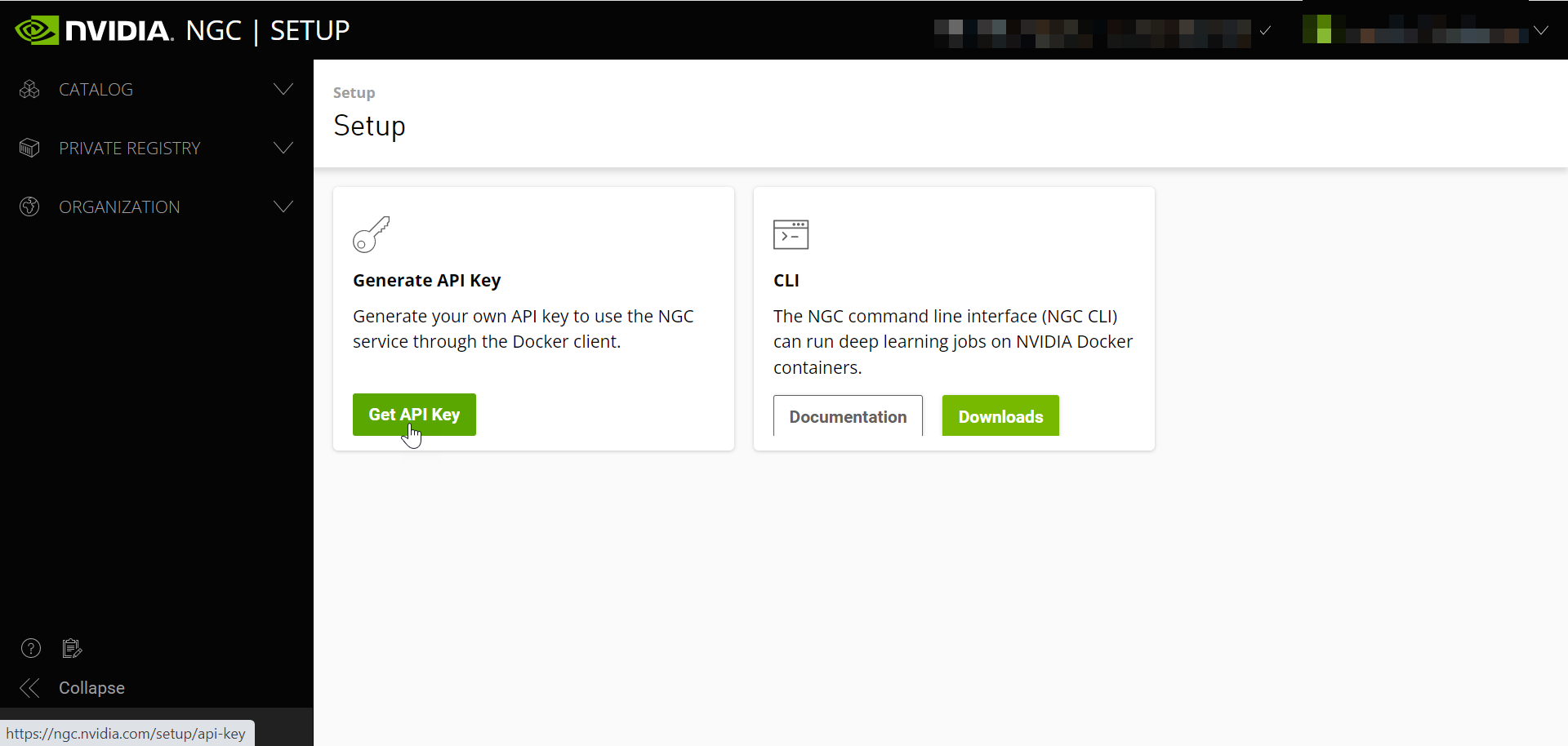

选择“获取 API 密钥”。

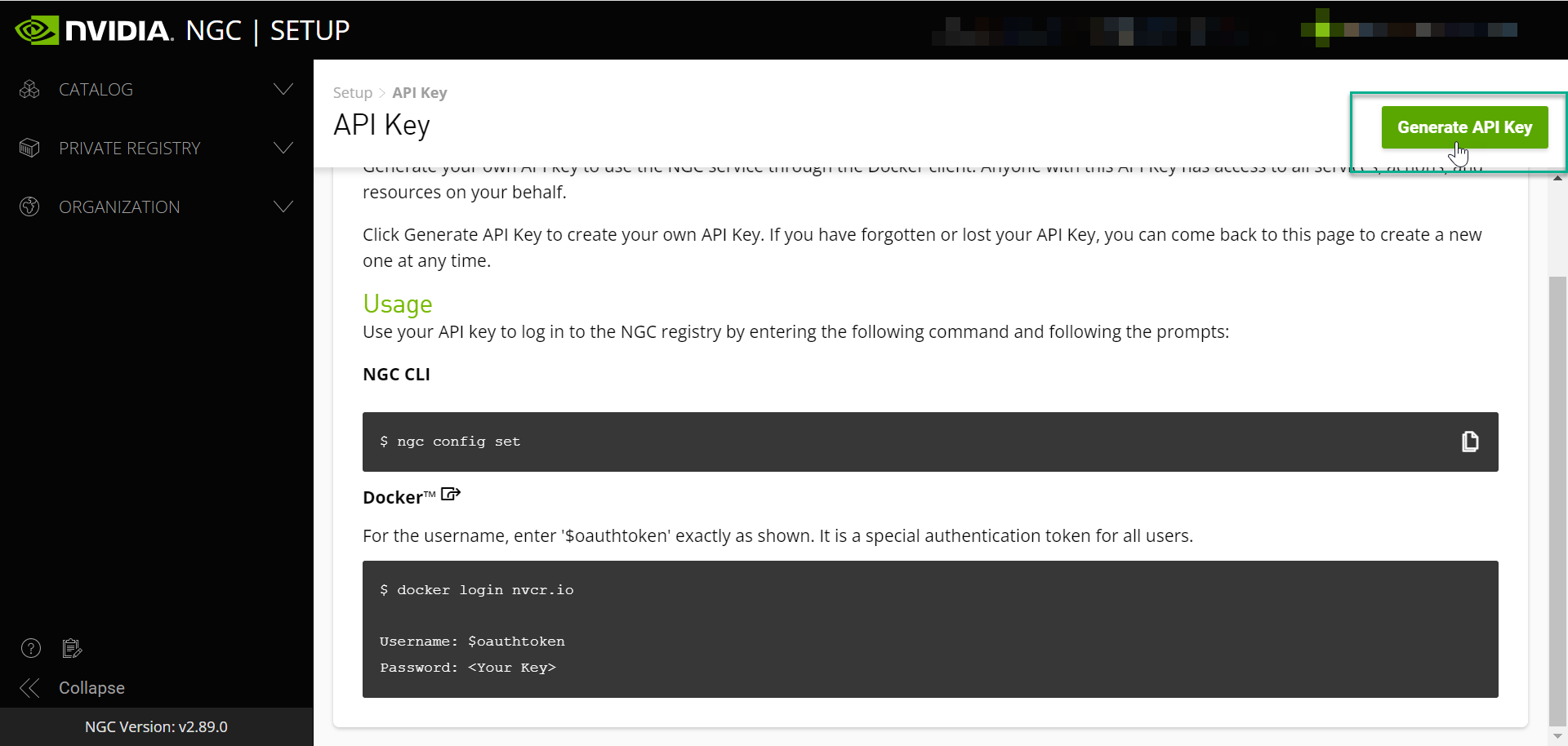

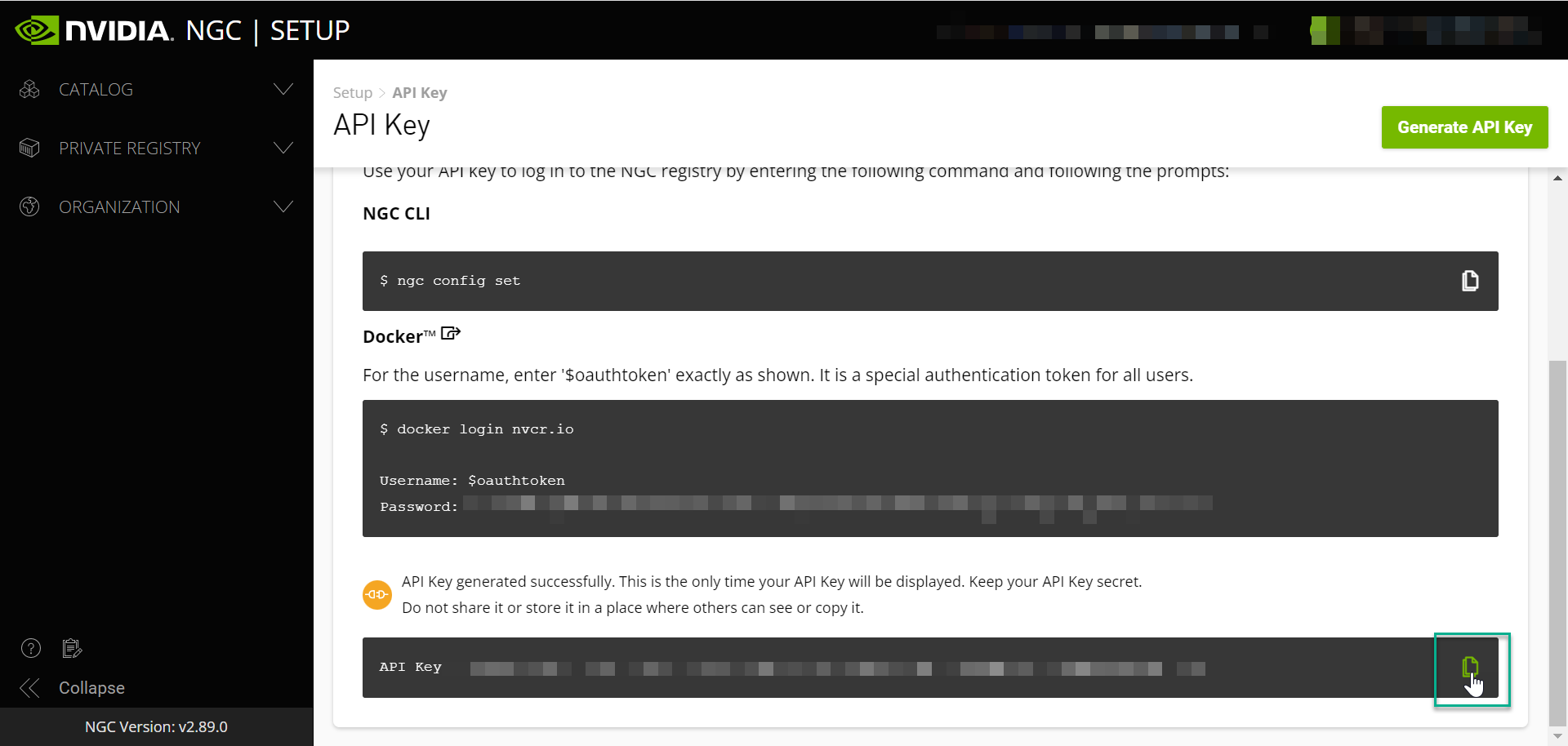

生成您的 API 密钥。

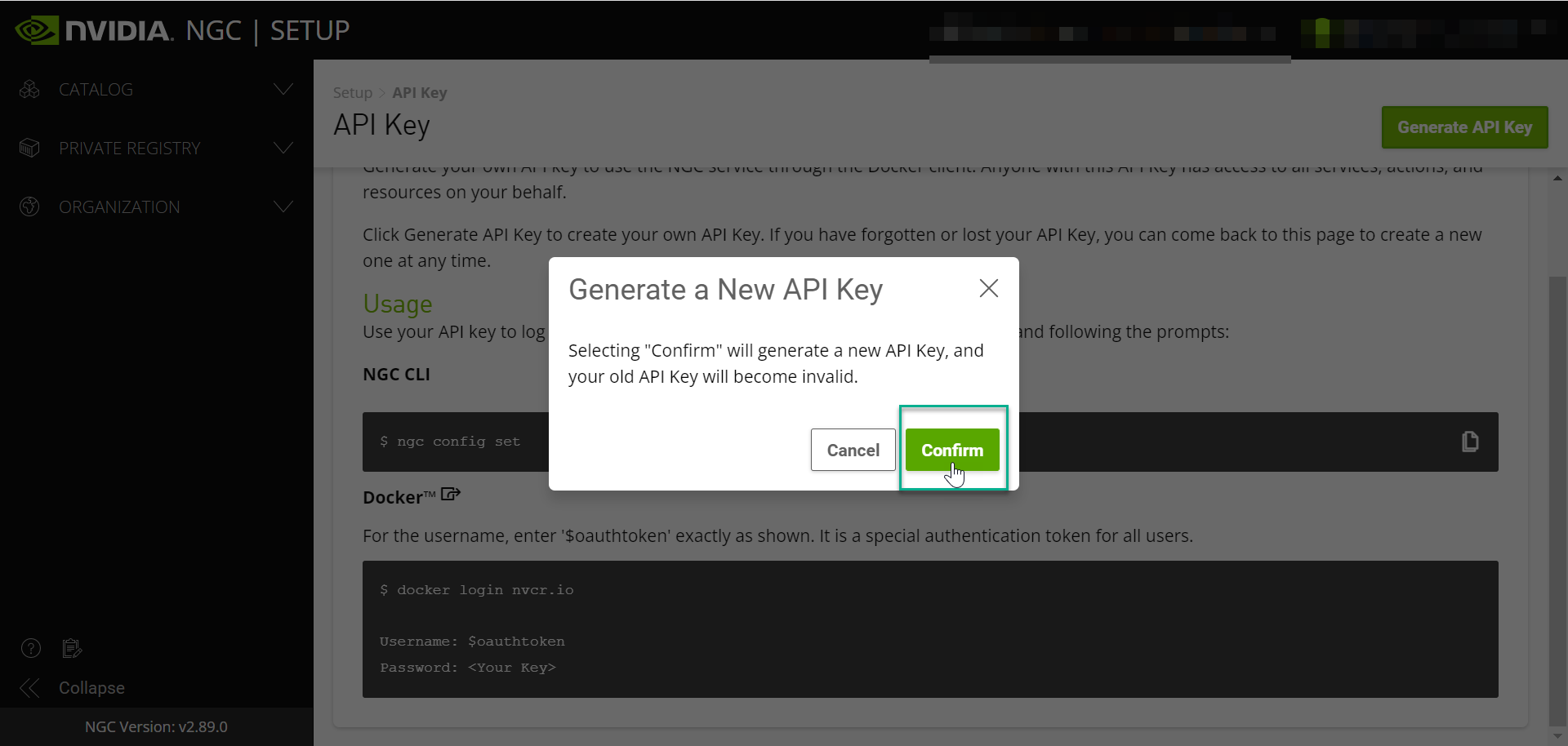

确认生成新的 API 密钥。

将您的 API 密钥复制到剪贴板

注意

选择确认将生成新的 API 密钥,并且您旧的 API 密钥将失效(如果适用)。

当您从命令行与存储库交互时,如果您想拉取锁定的容器镜像或推送回注册表,则需要使用 API 密钥。API 密钥是您独有的,并与您的帐户关联。

重要提示

请将您的 API 密钥保密并存放在安全的地方。不要共享或将其存储在其他人可以看到或复制的地方。

返回 SSH 会话和/或环境终端以登录 Docker 并开始从 NVIDIA AI NGC 目录中拉取容器。

登录到 NGC 容器注册表。

docker login nvcr.io

当提示您输入用户名时,输入以下文本

$oauthtoken注意

$oauthtoken 用户名是一个特殊用户名,表示您将使用 API 密钥而不是用户名和密码进行身份验证。

当提示您输入密码时,粘贴您的 NGC API 密钥,如下例所示。

Username: $oauthtoken Password: my-api-key注意

当您按照 生成您的 NGC API 密钥 中所述获取您的 API 密钥时,将其复制到剪贴板,以便在提示您输入密码时可以将其粘贴到命令 shell 中。

生产分支旨在为基于 NVIDIA AI 构建的应用程序提供稳定性和安全性,提供 9 个月的支持、API 稳定性以及针对高危和严重软件漏洞的每月修复。生产分支提供了一个稳定且安全的环境,以维护关键任务 AI 应用程序的正常运行时间。

功能分支和模型提供最新的 AI 框架、库、工作流程、模型和工具,用于性能优化的 AI 开发和部署软件。

NVIDIA AI Enterprise 的基础设施版本为 IT 专业人员提供基础设施优化和管理软件,以高效地管理和扩展 AI 工作负载。

下面章节提供了使用 Tensorflow 的容器拉取的示例以及详细步骤。我们将使用“拉取标签”功能轻松地将我们的容器拉取命令复制并粘贴到所需的环境中。

NVIDIA AI Enterprise 搜索过滤器#

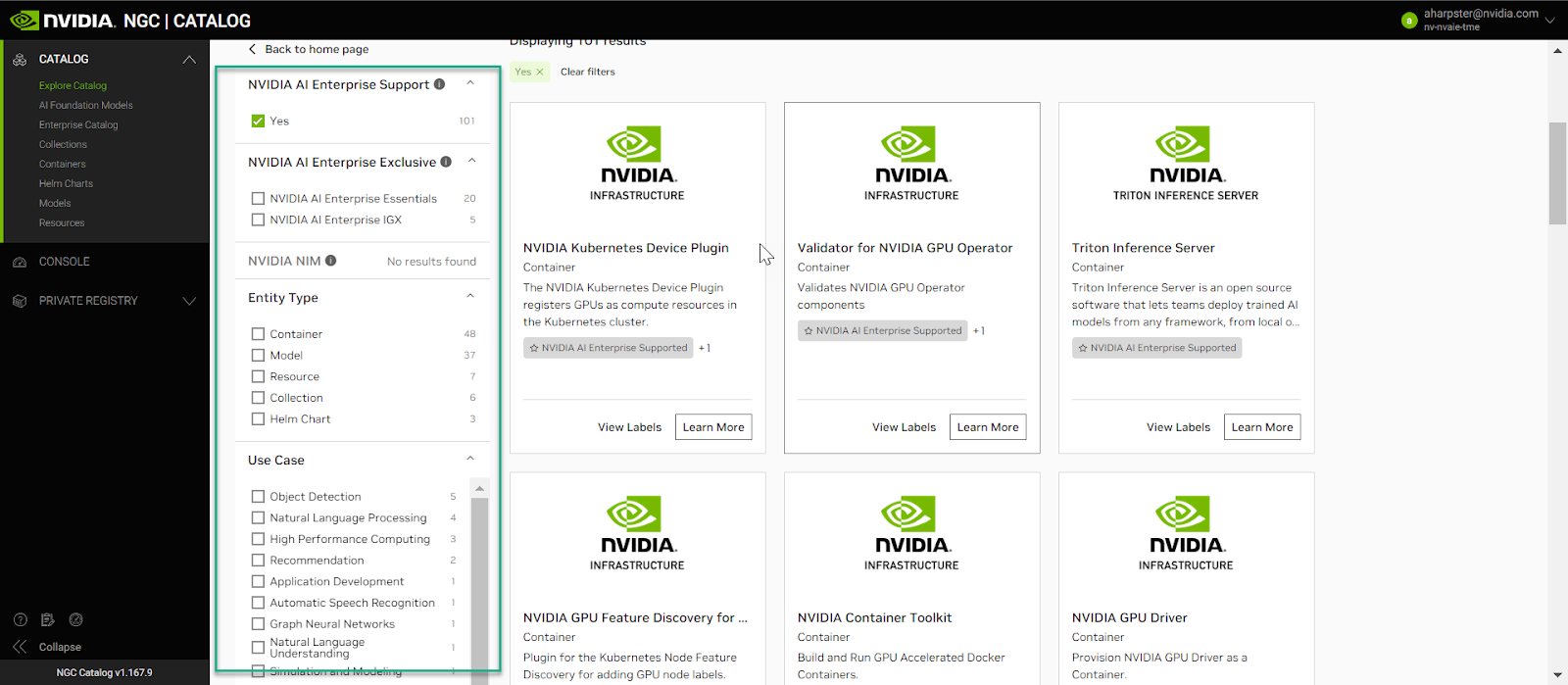

通过 NVIDIA AI Enterprise 搜索过滤器,用户可以通过 NGC 目录访问针对深度学习、机器学习和 HPC 优化的 GPU 软件,该目录提供容器、模型、模型脚本和行业解决方案。

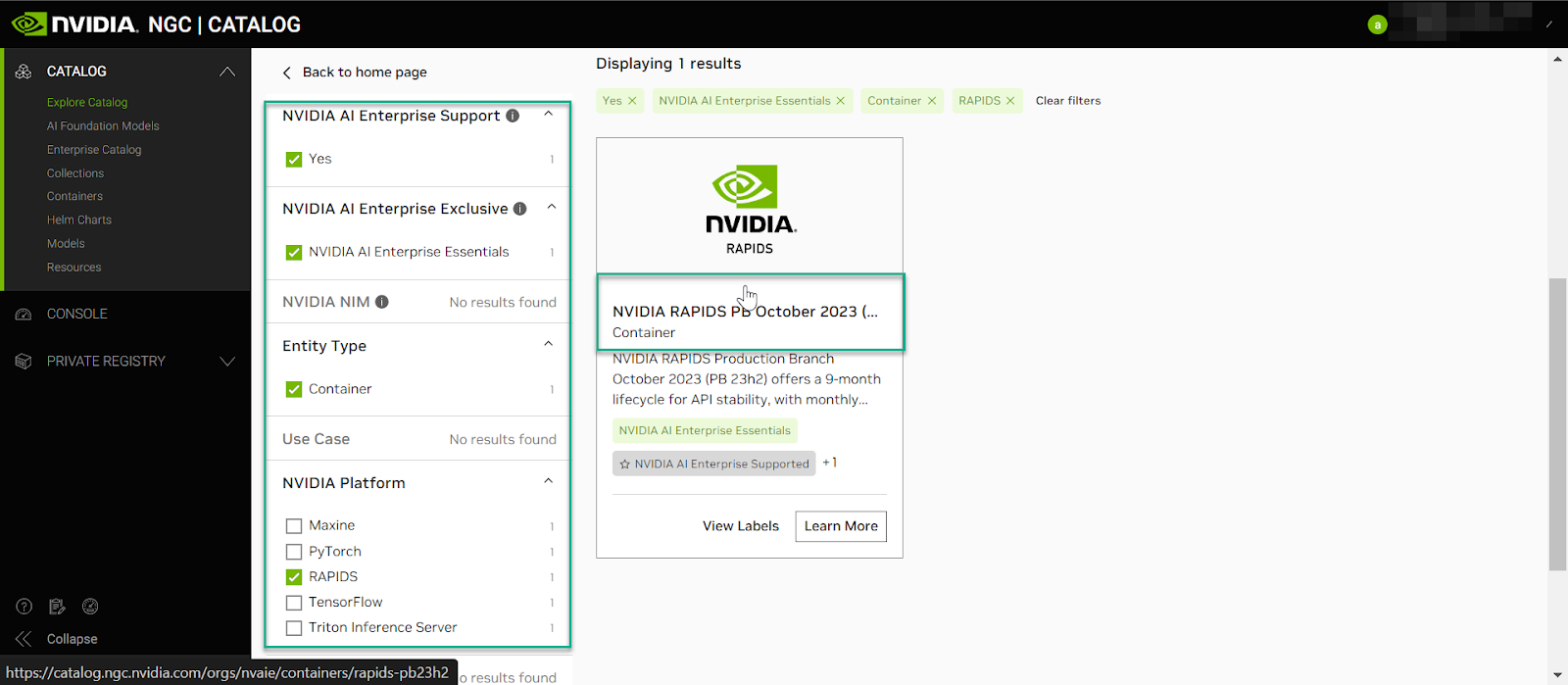

下面提供了使用 NVIDIA RAPIDS 生产分支的容器拉取示例,并在以下章节中使用 NVIDIA AI Enterprise 搜索过滤器提供了详细步骤。我们将使用“拉取标签”功能轻松地将我们的容器拉取命令复制并粘贴到所需的环境中。

导航到搜索过滤器并选择 NVIDIA AI Enterprise 支持、NVIDIA AI Enterprise Essentials、容器和 Rapids,如下图所示。

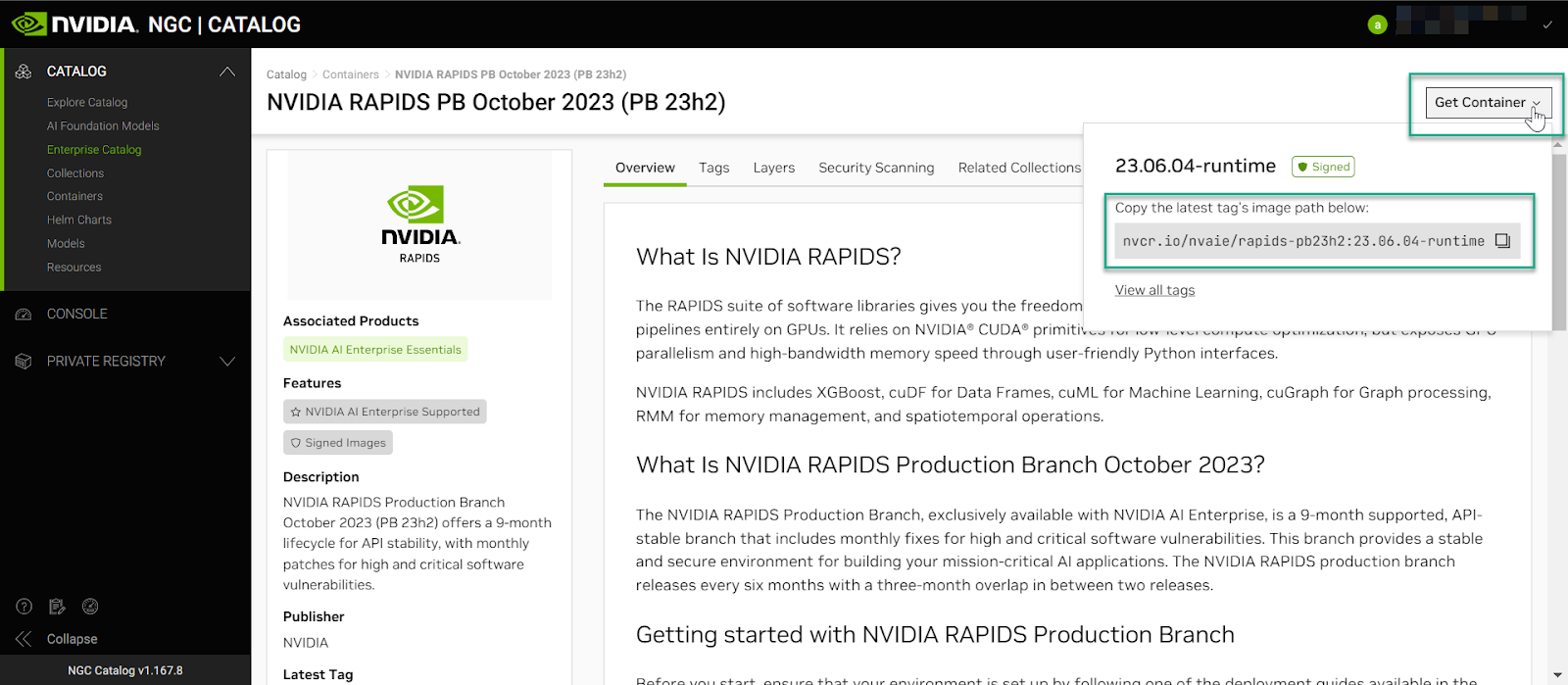

导航到获取容器并将命令复制到剪贴板。

将命令粘贴到您的 SSH 会话中

sudo docker pull nvcr.io/nvidia/rapids-pb23h2:23.06.04-runtime

对于您感兴趣的每个 AI 或数据科学应用程序,使用 pull 命令功能加载容器。

作为参考,下面详细列出了下载每个应用程序或框架容器的 Docker pull 命令,其中 <NVAIE-CONTAINER-TAG> 是上下文

NVIDIA TensorRT#

NVIDIA TensorRT 是一个 C++ 库,有助于在 NVIDIA 图形处理单元 (GPU) 上实现高性能推理。TensorRT 接受训练好的网络,并生成高度优化的运行时引擎,该引擎为该网络执行推理。

sudo docker pull nvcr.io/nvidia/tensorrt:<NVAIE-CONTAINER-TAG>

NVIDIA Triton Inference Server#

Triton Inference Server 是一款开源软件,使团队能够从任何框架、本地或云存储以及云、数据中心或嵌入式设备中的任何基于 GPU 或 CPU 的基础设施部署训练好的 AI 模型。

xx.yy-py3 镜像包含 Triton 推理服务器,支持 Tensorflow、PyTorch、TensorRT、ONNX 和 OpenVINO 模型。

sudo docker pull nvcr.io/nvidia/tritonserver:<NVAIE-CONTAINER-TAG>

NVIDIA RAPIDS#

NVIDIA RAPIDS 软件库套件使您可以自由地完全在 GPU 上执行端到端数据科学、机器学习和分析管道。

sudo docker pull nvcr.io/nvidia/nvidia-rapids:<NVAIE-CONTAINER-TAG>

PyTorch#

PyTorch 是一个 GPU 加速张量计算框架。可以通过常见的 Python 库(如 NumPy 和 SciPy)扩展功能。自动微分是通过基于磁带的系统在功能和神经网络层级完成的。

sudo docker pull nvcr.io/nvidia/pytorch:<NVAIE-CONTAINER-TAG>

TensorFlow#

TensorFlow 是一个用于机器学习的开源平台。它在灵活的架构中提供了全面的工具和库,可以轻松地跨各种平台和设备进行部署。

1sudo docker pull nvcr.io/nvidia/tensorflow:<NVAIE-CONTAINER-TAG>

2sudo docker pull nvcr.io/nvidia/tensorflow:<NVAIE-CONTAINER-TAG>

TAO Toolkit#

版本 2.0 中新增。

Train Adapt Optimize (TAO) Toolkit 是一个基于 python 的 AI 工具包,用于获取专门构建的预训练 AI 模型并使用您自己的数据对其进行自定义。TAO 使流行的网络架构和骨干网络适应您的数据,使您可以训练、微调和导出高度优化且准确的 AI 模型以进行部署。

1sudo docker pull nvcr.io/nvidia/tao-toolkit-lm:<NVAIE-CONTAINER-TAG>

2sudo docker pull nvcr.io/nvidia/tao-toolkit-pyt:<NVAIE-CONTAINER-TAG>

3sudo docker pull nvcr.io/nvidia/tao-toolkit-tf:<NVAIE-CONTAINER-TAG>