摘要#

采用 NVIDIA DGX™ H200 系统的 NVIDIA DGX SuperPOD™ 是用于人工智能 (AI) 的下一代数据中心架构。它旨在提供解决 AI、高性能计算 (HPC) 和混合应用中高级计算挑战所需的计算性能水平,在混合应用中,两者结合使用可提高预测性能和缩短解决问题的时间。DGX SuperPOD 基于 NVIDIA 为内部研究目的而构建的基础设施,旨在解决当今最具挑战性的计算问题。基于 DGX SuperPOD 架构的系统已在全球客户数据中心和云服务提供商处部署。

为了实现最佳可扩展性,DGX SuperPOD 由多项关键 NVIDIA 技术提供支持,包括

NVIDIA DGX H200 系统—为 AI 和 HPC 提供最强大的计算构建块。

NVIDIA NDR (400 Gbps) InfiniBand—带来最高性能、最低延迟和最具可扩展性的网络互连。

NVIDIA NVLink® 技术—在 NVLink 层连接 GPU 的网络技术,为最苛刻的通信模式提供前所未有的性能。

DGX SuperPOD 架构集成了 NVIDIA 软件解决方案,包括 NVIDIA Base Command™、NVIDIA AI Enterprise、CUDA 和 NVIDIA Magnum IO™。这些技术有助于使系统在最高级别的可用性和性能下运行,并通过 NVIDIA 企业支持 (NVEX),保持所有组件和应用程序平稳运行。

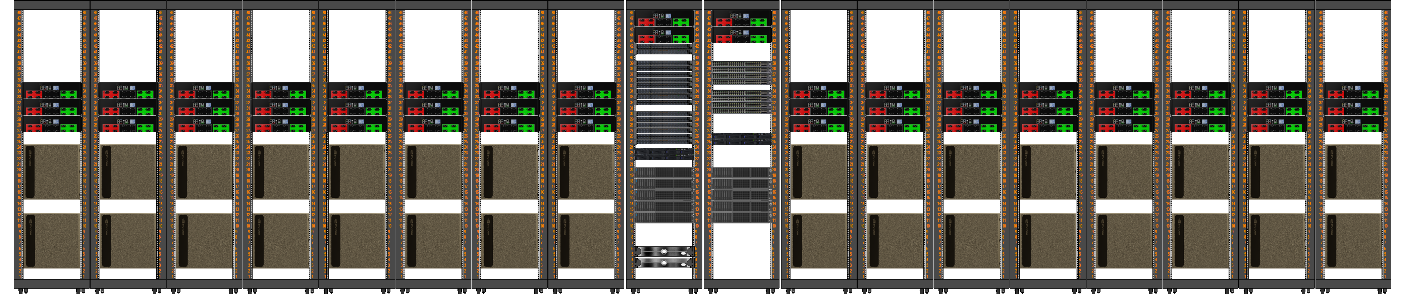

本参考架构 (RA) 讨论了定义 DGX SuperPOD 可扩展和模块化架构的组件。该系统基于可扩展单元 (SU) 的概念构建,每个单元包含 32 个 DGX H200 系统,从而可以快速部署多种规模的系统。本 RA 包括有关 SU 设计以及 InfiniBand、NVLink 网络、以太网结构拓扑、存储系统规范、推荐机架布局和布线指南的详细信息。