网络结构#

通过 SU 构建系统可提供最有效的设计。但是,如果由于预算限制、数据中心限制或其他需求而需要不同的节点计数,则结构的设计应支持完整的 SU,包括叶交换机和叶-脊电缆,并使结构中这些节点所在部分保持未使用状态。这将确保最佳的流量路由,并确保性能在结构的各个部分保持一致。

DGX SuperPOD 配置利用四种网络结构

-计算结构 -存储结构 -带内管理网络 -带外管理网络

本节详细介绍每个网络。

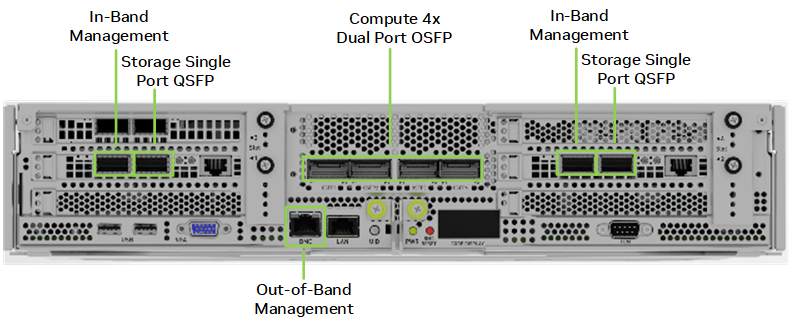

图 4 显示了 DGX H100 CPU 托架背面的端口以及提供的连接。中间的计算结构端口使用双端口收发器来访问所有八个 GPU。每对带内管理和存储端口都为 DGX H100 系统提供并行路径,以提高性能。OOB 端口用于 BMC 访问。(BMC 端口旁边的 LAN 端口在 DGX SuperPOD 配置中未使用。)

图 4. DGX H100 网络端口

计算—InfiniBand 结构#

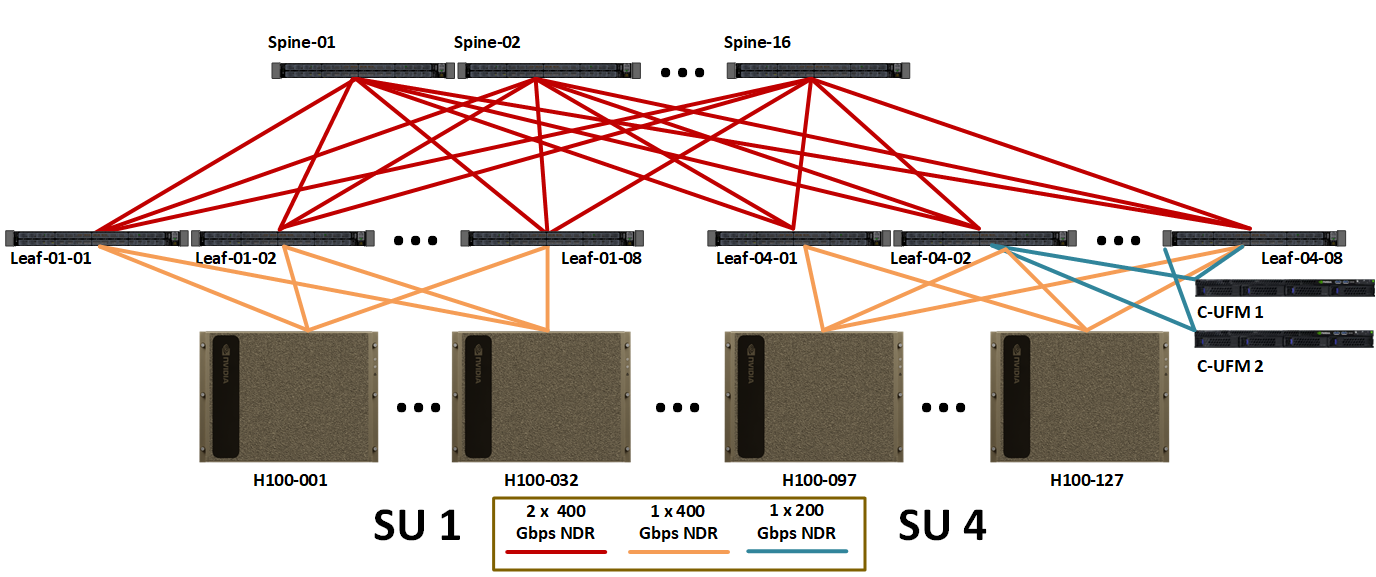

图 5 显示了完整 127 节点 DGX SuperPOD 的计算结构布局。每 32 个节点的组都与导轨对齐。DGX H100 系统的每个导轨的流量始终与 SU 中的其他 31 个节点相隔一跳。节点之间或导轨之间的流量会穿过 spine 层。

图 5. 完整 127 节点 DGX SuperPOD 的计算 InfiniBand 结构

表 4 显示了不同 SU 大小的计算结构所需的电缆和交换机数量。

表 4. 计算结构组件计数

SU 计数 |

节点计数 |

GPU 计数 |

InfiniBand 交换机计数 |

电缆计数 |

||

|---|---|---|---|---|---|---|

叶 |

脊 |

计算和 UFM |

脊-叶 |

|||

1 |

31¹ |

248 |

8 |

4 |

252 |

256 |

2 |

63 |

504 |

16 |

8 |

508 |

512 |

3 |

95 |

760 |

24 |

16 |

764 |

768 |

4 |

127 |

1016 |

32 |

16 |

1020 |

1024 |

¹. 这是每个 SU 32 个节点的设计,但是必须移除一个 DGX 系统以适应 UFM 连接。 |

||||||

存储—InfiniBand 结构#

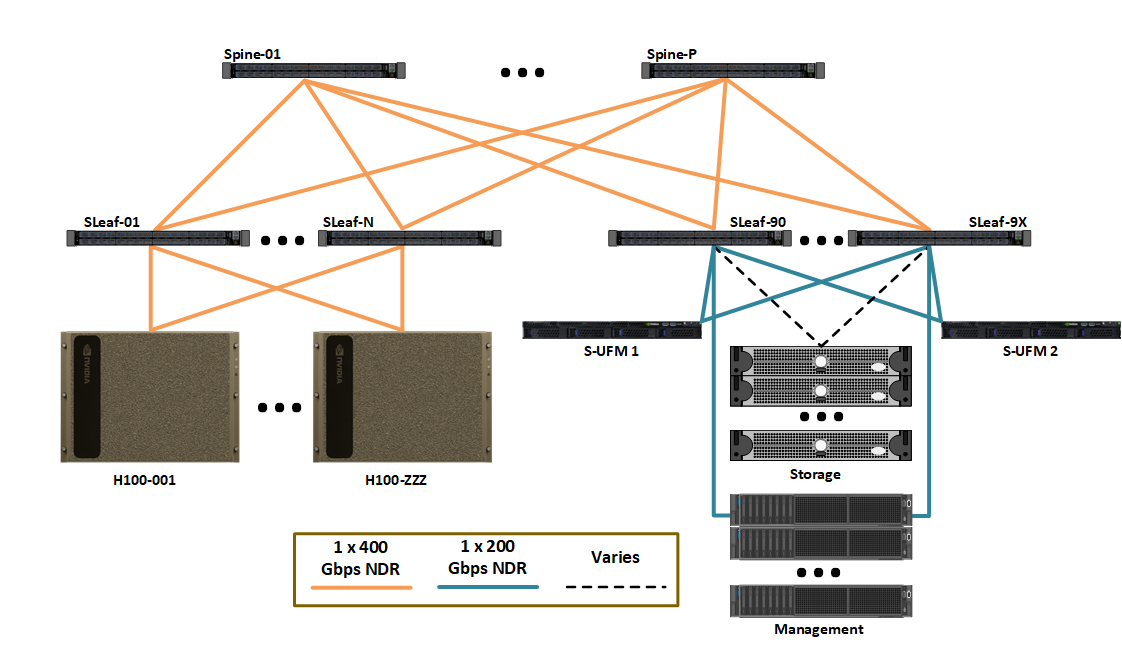

存储结构采用 InfiniBand 网络结构,这对于最大带宽至关重要 (图 6)。这是因为 DGX SuperPOD 的每个节点的 I/O 必须超过 40 GBps。具有高级结构管理功能(例如拥塞控制和 AR)的高带宽要求为存储结构提供了显着优势。

图 6. InfiniBand 存储结构逻辑设计

存储结构使用 MQM9700-NS2F 交换机 (图 7)。存储设备以 1:1 的端口到上行链路比率连接。DGX H100 系统连接略微过载,比率接近 4:3,并根据需要进行调整,以实现更高的存储灵活性,从而兼顾成本和性能。

图 7. MQM9700-NS2F 交换机

带内管理网络#

带内管理网络提供多个关键功能

连接管理集群的所有服务。

允许访问主文件系统和存储池。

为集群内服务(例如 Base Command Manager、Slurm)以及集群外部的其他服务(例如 NGC 注册表、代码存储库和数据源)提供连接。

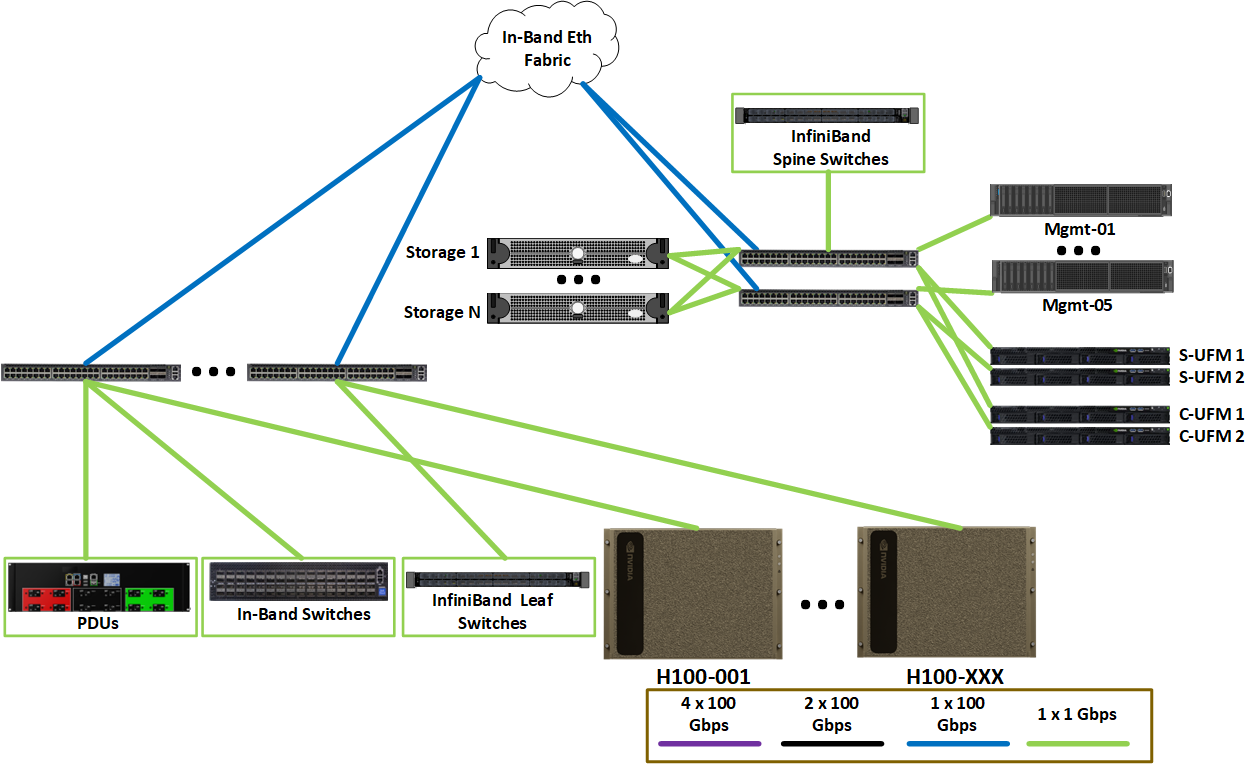

图 8 显示了带内以太网网络的逻辑布局。带内网络连接计算节点和管理节点。此外,OOB 网络连接到带内网络,以提供来自管理节点的高速接口,以支持与连接到 OOB 存储结构(例如存储)的设备的并行操作。

图 8. 带内以太网网络

带内管理网络使用 SN4600C 交换机 (图 9)。

图 9. SN4600C 交换机

带外管理网络#

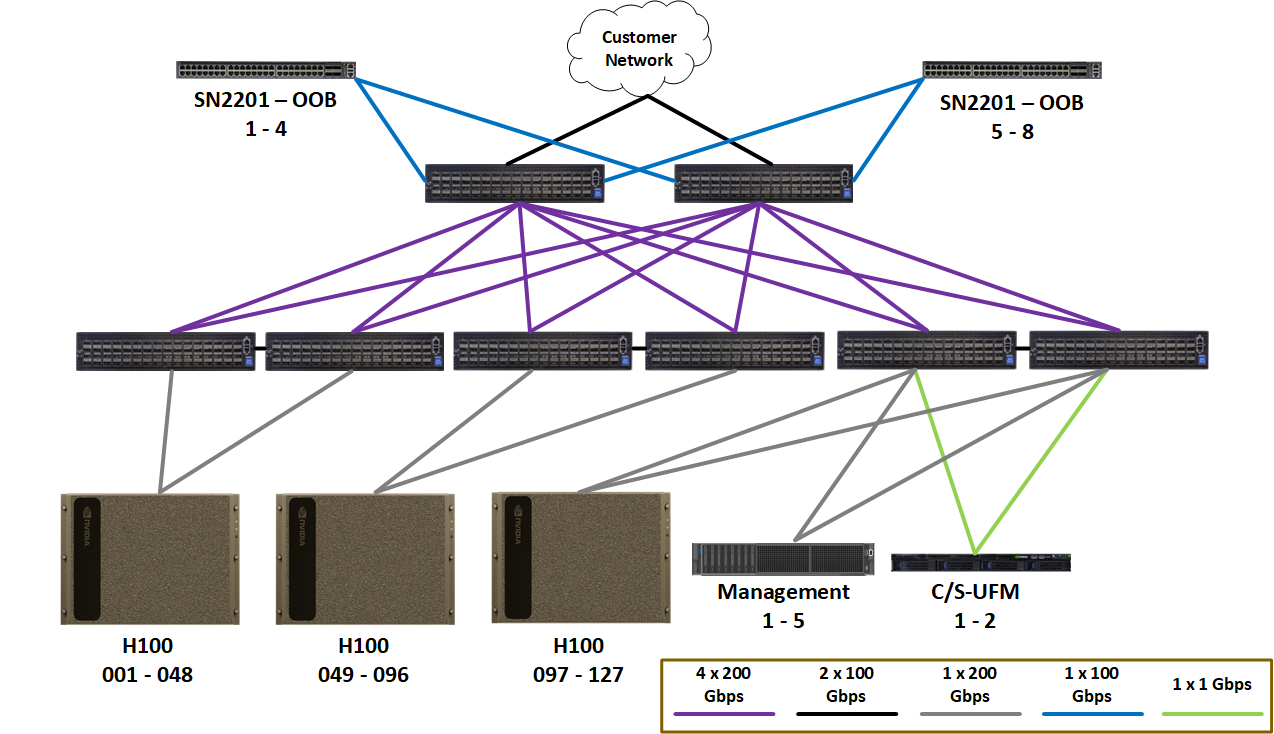

图 10 显示了 OOB 以太网结构。它连接所有设备的管理端口,包括 DGX 和管理服务器、存储、网络设备、机架 PDU 和所有其他设备。这些端口被隔离到它们自己的结构上,因为没有用户需要访问这些端口的用例,并且使用逻辑网络隔离来保护它们。

图 10 逻辑 OOB 管理网络布局

OOB 管理网络使用 SN2201 交换机 (图 11)。

图 11. SN2201 交换机