规划数据中心部署#

本文档是 NVIDIA DGX SuperPOD:采用 NVIDIA DGX H100 系统的数据中心设计 的一部分。

使用本文档了解以下内容

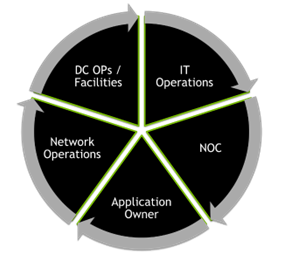

协调#

DGX SuperPOD 部署的规划需要组织内多个部门的协调和一致,并可能影响为这些团队提供关键服务的第三方供应商。可能受到影响的团队包括应用程序所有者、最终用户、数据中心运营、设施团队、安全部门、各种信息技术和网络团队以及网络运营中心支持团队。各个团队必须保持一致,以确保 DGX SuperPOD 的规划和执行良好的安装。

在规划和实施过程中,一个技术领域中发生的变化可能会影响另一个领域。例如,如果存在功率限制,限制了机架密度,并导致实施分布在更多的机架空间中,那么这不仅会影响数据中心设施的平面布局计划,而且还可能影响网络——需要重新计算电缆长度,并可能引入与延迟相关的性能影响。在 DGX SuperPOD 部署的设计和实施的每个阶段,各个领域专家之间良好的协调、配合和沟通将创造最佳结果。

数据中心资源经济性#

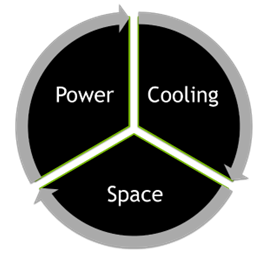

在每个数据中心环境中,资源都是有限的。就像在经济体中一样,这些资源的供应约束或限制会在面对需求时造成稀缺性。这推动了优化资源利用率的需求,以实现整体效率和数据中心设施投资的最大回报。

在风冷数据中心环境中,三个主要的资源约束是电力、散热和空间。

这些资源之间的相互关系是,一种资源的稀缺可能会增加对另一种资源的需求。例如,散热能力的限制可能会约束机架功率密度,从而导致需要占用更多机架来容纳给定数量的服务器。在本例中,散热方面的资源约束是通过占用地面空间来“支付”的。这使得部署能够进行,尽管这不是对数据中心地面空间的优化利用。

DGX H100 主要规格#

采用 NVIDIA DGX H100 系统的 NVIDIA DGX SuperPOD 是一个针对多节点 DL 和 HPC 优化的系统。它通常由 31 到 127 个 DGX H100 系统(图 1)组成,总共有 1,016 个 NVIDIA Hopper GPU。它使用 NVIDIA DGX SuperPOD 参考架构 构建,并配置为可扩展且平衡的系统,提供最佳性能。

图 1. DGX H100 系统#

DGX H100 系统的主要规格见表 1。

规格 |

数值 |

|---|---|

系统功耗 |

最大 10.2 千瓦 |

系统重量 |

287.6 磅 (130.45 公斤) |

系统尺寸 |

14 x 19.0 x 35.3 英寸 (356 x 482.3 x 897.1 毫米) |

机架单元 |

8 |

冷却 |

空气 |

工作温度 |

5—30°C (41—86°F) |

工作海拔 |

|

工作声噪 |

|

PSU 冗余 |

|

注意

由于设备的重量和尺寸、高功率要求、高散热量和声功率级,操作员安全至关重要。在 DGX H100 系统上或附近工作时,必须佩戴个人防护装备 (PPE),并且必须始终遵守安全程序。

计算机架密度#

每个数据中心在电力、散热和空间资源方面都有其独特的约束。NVIDIA 开发了 DGX SuperPOD 配置,以解决最常见的部署模式。但是,如果需要进行定制以解决特定部署中的特定数据中心参数,NVIDIA 通常可以满足。重要的是与 NVIDIA 合作并沟通任何数据中心设计约束,以便实现性能优化的部署。在未经此类咨询的情况下更改部署模式可能会导致严重的性能、运营、支持或可扩展性挑战。

DGX SuperPOD 配置的构建块是可扩展单元 (SU)。每个可扩展单元最多包含 32 个 DGX H100 系统以及相关的 InfiniBand 叶节点连接基础设施。一个 DGX SuperPOD 最多可以包含 4 个 SU,这些 SU 使用轨道优化的 InfiniBand 叶脊结构互连。一对 NVIDIA Unified Fabric Manager (UFM) 设备取代了 DGX SuperPOD 部署模式中的一个 DGX H100 系统,从而使每个完整 DGX SuperPOD 最多有 127 个 DGX H100 系统。

DGX H100 系统的最佳部署机架密度为每个机架四个系统。但是,机架密度可以定制,以适应数据中心可用的电力和散热能力。当然,降低机架密度会增加所需机架的总数。

表 2 显示了一些规格。

数量 每个机架的 DGX 系统 |

数量 DGX 系统机架 |

总计 SU 服务器机架 功率要求 |

总计 每个机架的功率 占用空间 |

|---|---|---|---|

1 |

32 |

326.4 千瓦 |

10.2 千瓦 |

2 |

16 |

326.4 千瓦 |

20.4 千瓦 |

4 |

8 |

326.4 千瓦 |

40.8 千瓦 |

除了这些机架外,每个 SU 还需要两个管理机架,用于 InfiniBand 叶脊基础设施、管理服务器和存储基础设施。这些机架的具体配置可能因 NVIDIA DGX SuperPOD 参考架构 而异。使用表 4 中提供的值来帮助计算这些机架的功率要求。

DGX SuperPOD 架构中 InfiniBand 结构的设计对电缆路径距离提出了约束(任何 InfiniBand 电缆的总行程距离不得超过 50 米)。因此,部署模式在建模时会仔细考虑电缆长度。

安全系统交付#

以下注意事项对于将设备安全交付到数据中心位置至关重要

设施应配备装卸平台或允许配备升降尾板的送货车辆。

如果没有装卸平台,则必须提供液压升降机或坡道以安全卸载托盘。

必须有一个与数据大厅分离的安全接收室或暂存区,以便在安装前存放设备。

装卸平台和接收室之间必须有畅通的通道。

接收室必须有足够的空间从托盘上取出设备组件,然后再转移到数据大厅。所有收缩膜、纸板和包装材料应留在接收室。

必须提供运输工具,以便将设备从接收室安全移动到数据大厅。

NVIDIA 组件将由普通承运人放在托盘上运输。DGX H100 系统的托盘信息见表 3。

规格 |

数值 |

|---|---|

单位/托盘 |

1 |

实际产品重量 |

287.6 磅 (130.45 公斤) |

计费产品重量 |

376 磅 (170.45 公斤) |

托盘重量 |

421 磅 (191 公斤) |

产品包装箱尺寸 |

38.2 x 28 x 46.5 英寸 (970 x 711 x 1,178 毫米) |

外包装材料(板条箱/瓦楞纸箱) |

瓦楞纸箱 |

根据 DGX SuperPOD 配置的大小,最多将运送 127 个 DGX 系统托盘以及大量的网络交换机、管理服务器设备和电缆。采购团队和供应商应与现场数据中心人员协调,以确保材料可以在安装前接收并存储在安全的位置。

功耗和散热#

管理机架包含 DGX SuperPOD 的网络基础设施、存储和管理服务器,数量因部署的 SU 数量而异。每个系统组件都有一个预期平均功率 (EAP) 和一个预期峰值功率 (EPP)。

表 4 显示了完整 DGX SuperPOD 的关键组件的 EAP、EPP 和散热值。

| 服务器 | 交换机 | ||||||||

|---|---|---|---|---|---|---|---|---|---|

| 计算 | 存储 | 管理 | 结构 | 计算 | 存储 | 带内管理 | 带外管理 | ||

| 型号 | DGX H100 | 各异1 | PowerEdge R7501 | NVIDIA UFM 3.1 | QM9700 | QM9700 | SN4600C | SN2201 | |

| 数量 | 127 | 各异1 | 5 | 4 | 48 | 16 | 8 | 8 | |

| EAP(瓦特) | 每个 | 10,2002 | 2,880 | 704 | 600 | 1,376 | 1,376 | 466 | 98 |

| 小计 | 1,295,400 | 17,280 | 3,520 | 2,400 | 66,048 | 22,016 | 3,728 | 784 | |

| EPP(瓦特) | 每个 | 10,200 | 3,600 | 880 | 750 | 1,720 | 1,720 | 820 | 135 |

| 小计 | 1,295,400 | 21,600 | 4,400 | 3,000 | 82,560 | 27,520 | 6,560 | 1,080 | |

| 峰值热负荷 (BTU/小时) | 每个 | 34,804 | 12,284 | 3,003 | 2,559 | 5,869 | 5,869 | 2,798 | 461 |

| 小计 | 4,420,088 | 73,702 | 15,013 | 10,236 | 281,706 | 93,902 | 22,384 | 3,685 | |

| 系统总量的百分比 | 89.83% | 1.50% | 0.31% | 0.21% | 5.72% | 1.91% | 0.45% | 0.07% | |

请参阅 NVIDIA DGX SuperPOD 参考架构。图中描绘了典型示例。

DGX H100 系统在运行 AI 工作负载时,持续以或接近峰值利用率运行

一般来说,该设计要求每千瓦至少 157 立方英尺/分钟(4.445 立方米/分钟)的气流。但是,实际要求可能因每个特定数据中心的环境条件和海拔高度以及每个组件的 Delta T 而异。

环境热力指南#

表 5 说明了用于 IT 和电信设备冷却的 ASHRAE 一般温度和湿度标准。为了满足 DGX SuperPOD 的散热需求,数据中心设施应满足“推荐”要求,并且至少必须满足 A1 级要求,直至注明的限制。

范围 |

等级 |

干球温度 |

湿度范围,非冷凝 |

最大露点 |

|---|---|---|---|---|

推荐 |

所有 A 类 |

64.4-80.6°F 18-27°C |

41.9°F 至 60% 相对湿度和 59°F 露点 5.5°C 至 60% 相对湿度和 15°C 露点 |

59°F 15°C |

DGX H100 系统允许高达 30°C |

A1 |

59-89.6°F 15-32°C |

20-80% 相对湿度 |

62.6°F 17°C |

ASHRAE 允许的各种其他级别的数据中心和电信环境 |

A2 |

50-95°F 10-35°C |

20-80% 相对湿度 |

69.8°F 21°C |

A3 |

41-104°F 5-40°C |

10.4°F 露点和 8-85% 相对湿度 -12°C 露点和 8-85% 相对湿度 |

75.2°F 24°C |

|

A4 |

41-113°F 5-45°C |

10.4°F 露点和 8-90% 相对湿度 -12°C 露点和 8-90% 相对湿度 |

75.2°F 24 °C |

|

B |

41-95°F 5-35°C |

8-80% 相对湿度 |

82.4°F 28°C |

|

C |

41-104°F 5-40°C |

8-80% 相对湿度 |

82.4°F 28°C |

必须通过过滤来减轻污染源空气(例如烟雾、灰尘、污染或其他类型的污染物)。

表 6 描述了不同空气洁净度等级的 ISO 14644-1 最大颗粒尺寸。在空气侧节能器模式或任何其他可能污染源空气的环境中,空气必须通过最低 MERV 13(或 EN779-2012 M6/F7 或 ISO 16890 ePM1-50%)额定过滤器进行过滤,并且机架区域必须满足 ISO 14644-1 8 级标准的洁净度水平,最大颗粒计数不超过 3,520,000 个 @ 0.5 微米/立方米,持续时间不超过 15 分钟。

等级 |

颗粒尺寸1 |

|||||

|---|---|---|---|---|---|---|

> 0.1 微米 |

> 0.2 微米 |

> 0.3 微米 |

> 0.5 微米 |

> 1 微米 |

> 5 微米 |

|

1 |

10 |

2 |

||||

2 |

100 |

24 |

10 |

4 |

||

3 |

1,000 |

237 |

102 |

35 |

8 |

|

4 |

10,000 |

2,370 |

1,020 |

352 |

83 |

|

5 |

100,000 |

23,700 |

10,200 |

3,520 |

832 |

29 |

6 |

1,000,000 |

237,000 |

102,000 |

35,200 |

8,320 |

293 |

7 |

352,000 |

83,200 |

2,930 |

|||

8 |

3,520,000 |

832,000 |

29,300 |

|||

9 |

35,200,000 |

8,320,000 |

293,000 |

|||

与测量过程相关的不确定性要求在确定分类级别时使用不超过三位有效数字的数据。

表 7 提供了过滤标准的总体比较,作为交叉参考。

ASHRAE 标准 52.2-2007 最低效率报告值 (MERV)1 |

EN 779-2012 |

ISO 16890 |

|---|---|---|

MERV 1、2、3、4 |

G1、G2 |

— |

MERV 5 |

G3 |

— |

MERV 6、7、8 |

G4 |

粗效 90% |

MERV 8、9、10 |

M5 |

ePM10-60% |

MERV 9、10、11、12、13 |

M6 |

ePM2.5-50% |

MERV 13、14 |

F7 |

ePM1-50% |

MERV 14、15 |

F8 |

ePM1-75% |

MERV 16 |

F9、E10、E11、E12、H13、H14、U15、U16 |

— |

ASHRAE 52.2、EN 779-2012 和 ISO 16890 的测试和评估程序差异很大,使得直接比较过滤器功效和效率变得困难且可能具有误导性。此表中的值仅作为一般参考提供,不应被视为科学上的精确值。