核心组件#

带有 HCAs 和交换机资源的计算节点构成了 DGX BasePOD 的基础。本节将介绍 DGX BasePOD 参考架构中使用的具体组件。

NVIDIA DGX 系统#

NVIDIA DGX BasePOD 配置使用 DGX B200、DGX H200 和 H100 系统。以下章节将介绍这些系统。

NVIDIA DGX B200 系统#

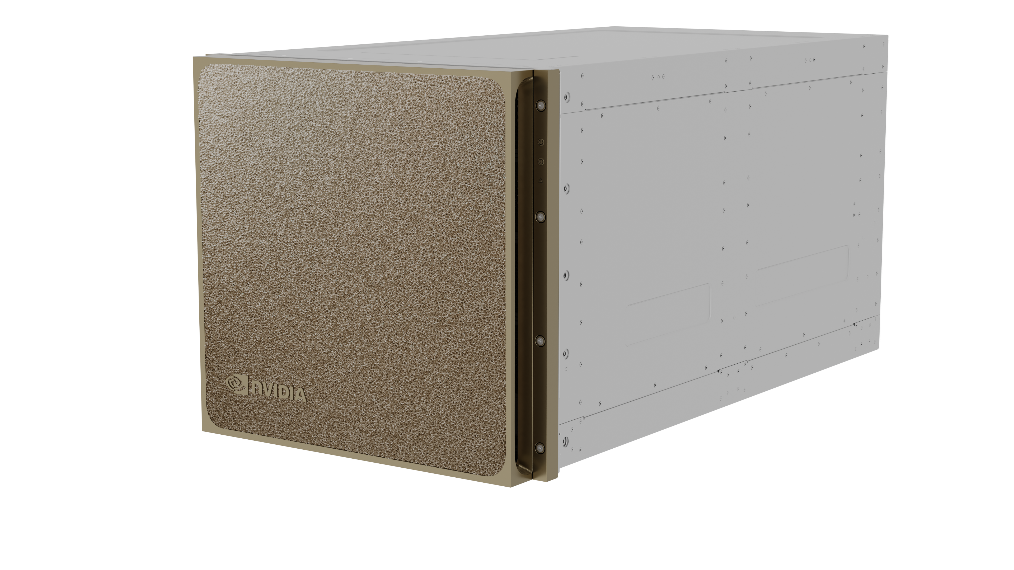

NVIDIA DGX B200 系统(图 4)提供了前所未有的计算密度、性能和灵活性。

图 4. DGX B200 系统#

DGX B200 系统的主要规格包括

采用八个 NVIDIA B200 构建

1.4TB GPU 内存空间

4 个 OSFP 端口,支持 8 个单端口 NVIDIA ConnectX-7 VPI

高达 400Gb/s InfiniBand/Ethernet,2 个双端口 QSFP112 NVIDIA BlueField-3 DPU

双第五代 Intel® Xeon® 可扩展处理器

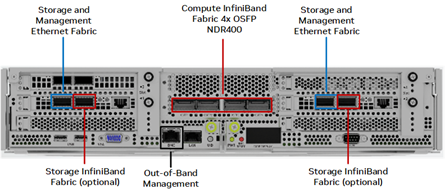

图 5 显示了 DGX B200 CPU 托盘的后部端口。

图 5. DGX B200 CPU 托盘后部端口#

四个 ConnectX-7 OSFP 用于计算 fabric。每对双端口 BlueField-3 HCA(NIC 模式)为存储和管理 fabric 提供并行路径。带外 (OOB) 端口用于 BMC 访问。

NVIDIA DGX H200 和 H100 系统#

DGX H200 系统(图 6)是最新的 DGX 系统,也是由 NVIDIA Hopper GPU 的突破性性能加速的 AI 动力源泉。

图 6. DGX H200 和 H100 系统#

DGX H200 和 H100 系统的主要规格包括

八个 NVIDIA Hopper GPU。

H200 总计 1,128 GB GPU 内存。

H100 总计 640 GB GPU 内存。

四个 NVIDIA NVSwitch™ 芯片。

双 Intel® Xeon® Platinum 8480C 处理器,总计 112 核,2.00 GHz(基本频率),3.80 GHz(最大睿频),支持 PCIe 5.0。

2 TB DDR5 系统内存。

四个 OSFP 端口,支持八个单端口 NVIDIA ConnectX-7 VPI、2 个双端口 QSFP112 NVIDIA ConnectX-7 VPI,高达 400 Gb/s InfiniBand/Ethernet。

10Gb/s 板载 NIC,带 RJ45 接口,100 Gb/s Ethernet NIC,BMC,带 RJ45 接口。

两个 1.92 TB M.2 NVMe 驱动器用于 DGX OS,八个 3.84 TB U.2 NVMe 驱动器用于存储/缓存。

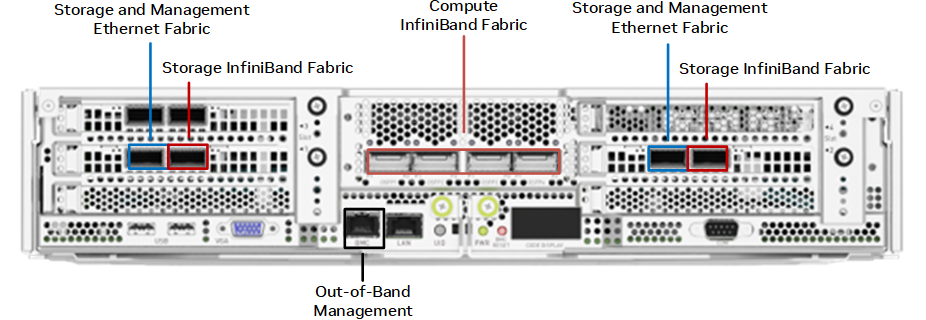

图 7 显示了 DGX H200 和 H100 CPU 托盘的后部端口。

图 7. DGX H200 和 H100 CPU 托盘后部端口#

四个 OSFP 端口为计算 fabric 提供八个 ConnectX-7 HCA。每对双端口 ConnectX-7 HCA 为存储和管理 fabric 提供并行路径。OOB 端口用于 BMC 访问。

NVIDIA 网络适配器#

NVIDIA DGX B200 和 DGX H200 和 H100 系统配备了 NVIDIA® ConnectX®-7 网络适配器。DGX B200 同时具有 ConnectX-7 和 NVIDIA BlueField-3 网络适配器。本节将介绍这些网络适配器。

注意

在下文中,HCA 将指代配置为 InfiniBand 的网络适配器卡,NIC 将指代配置为 Ethernet 的网络适配器卡。

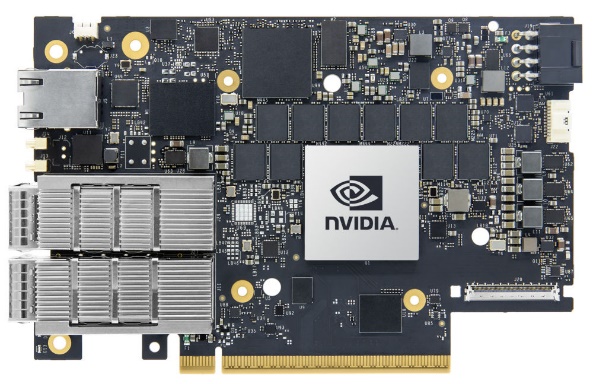

NVIDIA 网络适配器#

ConnectX-7 VPI 适配器(图 8)是最新的 ConnectX 适配器系列。它可以提供 25/50/100/200/400G 的吞吐量。NVIDIA DGX 系统使用 ConnectX-7 和 BlueField-3(NIC 模式)HCA,以便在采用 NDR400 和 RoCE 的 DGX BasePOD 部署中提供灵活性。规格参数请参考此处。

图 8. NVIDIA ConnectX-7 HCA#

图 9. NVIDIA BlueField-3 HCA#

NVIDIA 网络交换机#

DGX BasePOD 配置可以配备四种类型的 NVIDIA 网络交换机。本节将介绍这些交换机,以及如何在“参考架构”部分中部署这些交换机。

NVIDIA QM9700 交换机#

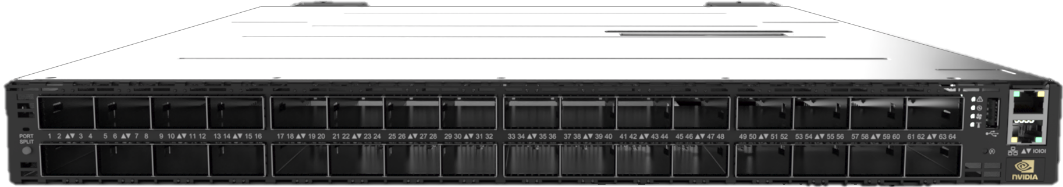

采用 NDR InfiniBand 连接的 NVIDIA QM9700 交换机(图 10)为 NDR BasePOD 配置中的计算 fabric 提供动力。ConnectX-7 单端口适配器用于 InfiniBand 计算 fabric。每个 NVIDIA DGX 系统都与每个 QM9700 交换机建立双连接,从而在系统之间提供多条高带宽、低延迟的路径。

图 10. NVIDIA QM9700 交换机#

NVIDIA SN4600C 交换机#

NVIDIA SN4600C 交换机(图 11)提供总共 128 个端口(每台交换机 64 个),为 DGX BasePOD 的带内管理提供冗余连接。NVIDIA SN4600C 交换机可以提供 1 GbE 到 100 GbE 之间的速度。

对于通过 Ethernet 连接的存储设备,也使用 NVIDIA SN4600 交换机。NVIDIA DGX 双端口网络适配器上的端口用于带内管理和存储连接。

图 11. NVIDIA SN4600C 交换机#

NVIDIA SN2201 交换机#

NVIDIA SN2201 交换机(图 12)提供 48 个端口,为 OOB 管理提供连接。OOB 管理为 BasePOD 中的所有组件提供集中的管理连接。

图 12. NVIDIA SN2201 交换机#

控制平面#

控制平面中每台服务器的最低要求是

2 × Intel x86 Xeon Gold 或更高

512 GB 内存

1 × 6.4 TB NVMe 用于存储

2 × 480 GB M.2 RAID 用于操作系统

4 × 200 Gbps 网络

2 × 100 GbE 网络