NVIDIA vGPU (C-Series) 文档#

发行说明#

支持的硬件#

支持的 Microsoft Windows 客户操作系统#

NVIDIA AI Enterprise 仅支持 Windows 客户机驱动程序的 Tesla Compute Cluster (TCC) 驱动模型。

Windows 客户机操作系统支持仅限于在没有容器的 Windows 虚拟机中本地运行应用程序。依赖于应用程序容器化的 NVIDIA AI Enterprise 功能在 Windows 客户操作系统上不受支持。

如果您使用的是 KVM 虚拟机监控程序支持的通用 Linux,请查阅您的虚拟机监控程序供应商的文档,以获取有关作为客户机操作系统支持的 Windows 版本的信息。

客户操作系统 |

Red Hat Enterprise Linux KVM |

Ubuntu |

VMware vSphere |

|---|---|---|---|

Microsoft Windows Server 2022 |

|

不支持 |

|

Microsoft Windows 11 |

不支持 |

|

|

Microsoft Windows 10 |

不支持 |

|

|

使用 NVIDIA vGPU (C-Series) 的要求#

由于 NVIDIA vGPU (C-Series) 具有较大的 BAR 内存设置,因此使用这些 vGPU 对 VMware ESXi 有一些限制。

客户操作系统必须是 64 位操作系统。

虚拟机的 64 位 MMIO 和 EFI 启动必须启用。

客户操作系统必须能够在 EFI 启动模式下安装。

虚拟机的 MMIO 空间必须增加到 64 GB,如 VMware 知识库文章:VMware vSphere VMDirectPath I/O:平台和设备的要求 (2142307) 中所述。

在具有大内存虚拟机的需要 64 GB 或更多 MMIO 空间的 GPU 上使用 NVIDIA vGPU (C-Series) 的要求#

某些 GPU 需要 64 GB 或更多的 MMIO 空间。当需要 64 GB 或更多 MMIO 空间的 GPU 上的 vGPU 被分配给 ESXi 上具有 32 GB 或更多内存的虚拟机时,虚拟机的 MMIO 空间必须增加到 GPU 所需的量。

有关更多信息,请参阅 VMware 知识库文章:VMware vSphere VMDirectPath I/O:平台和设备的要求 (2142307)。

无需额外配置。

下表列出了需要 64 GB 或更多 MMIO 空间的 GPU 以及每个 GPU 需要的 MMIO 空间量。

GPU |

所需的 MMIO 空间 |

|---|---|

NVIDIA A10 |

64 GB |

NVIDIA A30 |

64 GB |

NVIDIA A40 |

128 GB |

NVIDIA A100 40GB(所有变体) |

128 GB |

NVIDIA A100 80GB(所有变体) |

256 GB |

NVIDIA RTX A5000 |

64 GB |

NVIDIA RTX A5500 |

64 GB |

NVIDIA RTX A6000 |

128 GB |

Quadro RTX 6000 Passive |

64 GB |

Quadro RTX 8000 Passive |

64 GB |

Tesla V100(所有变体) |

64 GB |

NVIDIA CUDA 工具包版本支持#

此 NVIDIA AI Enterprise 发行系列中的版本支持 NVIDIA CUDA 工具包 12.3。

要构建 CUDA 应用程序,系统必须具有 NVIDIA CUDA 工具包和链接所需的库。有关 NVIDIA CUDA 工具包组件的详细信息,请参阅 CUDA 12.3 的 NVIDIA CUDA 工具包发行说明。

要运行 CUDA 应用程序,系统必须具有支持 CUDA 的 GPU 和与用于构建应用程序的 NVIDIA CUDA 工具包版本兼容的 NVIDIA 显示驱动程序。如果应用程序依赖于库的动态链接,则系统还必须具有这些库的正确版本。

有关 NVIDIA CUDA 工具包的更多信息,请参阅 CUDA 工具包 12.3 文档。

NVIDIA vGPU (C-Series) 迁移支持#

NVIDIA vGPU (C-Series) 迁移(包括 vMotion 和挂起恢复)在所有受支持的 GPU 和客户操作系统上,对于时间分片和 MIG 支持的 vGPU 均受支持,但仅在部分受支持的虚拟机监控程序软件版本上受支持。

NVIDIA vGPU (C-Series) 迁移支持的限制

Red Hat Enterprise Linux 与 KVM:不支持运行不同版本的 NVIDIA Virtual GPU Manager 驱动程序的主机之间的迁移,即使在同一 NVIDIA Virtual GPU Manager 驱动程序分支内也是如此。

对于启用以下任何 NVIDIA CUDA 工具包功能的虚拟机,NVIDIA vGPU (C-Series) 迁移将被禁用

统一内存

调试器

性能分析器

支持的虚拟机监控程序软件版本

自 Red Hat Enterprise Linux 与 KVM 9.4 起

Ubuntu 上不支持

所有受支持的 VMware vSphere 版本

NVIDIA vGPU (C-Series) 迁移支持的已知问题

用例 |

受影响的 GPU |

问题 |

|---|---|---|

具有不同 ECC 内存配置的主机之间的迁移 |

所有支持 vGPU 迁移的 GPU |

配置了 vGPU 的虚拟机的迁移在迁移完成之前停止 |

支持分配给虚拟机的多个 vGPU 的 vGPU#

支持的 vGPU 取决于虚拟机监控程序

对于具有 KVM 虚拟机监控程序的通用 Linux、Red Hat Enterprise Linux KVM 和 Ubuntu,所有 NVIDIA vGPU (C-Series) 都受 PCIe GPU 支持。在支持多实例 GPU (MIG) 功能的 GPU 上,时间分片和 MIG 支持的 vGPU 均受支持。

对于 VMware vSphere,支持的 vGPU 取决于虚拟机监控程序版本

自 VMware vSphere 8.0 起:支持所有 NVIDIA vGPU (C-Series)。在支持多实例 GPU (MIG) 功能的 GPU 上,时间分片和 MIG 支持的 vGPU 均受支持。

VMware vSphere 7.x 版本:仅支持分配给物理 GPU 帧缓冲区的 NVIDIA vGPU (C-Series)。

您可以将具有不同帧缓冲区大小的多个 vGPU 分配给单个虚拟机,前提是所有 vGPU 的板类型和系列相同。例如,您可以将 A40-48C vGPU 和 A40-16C vGPU 分配给同一虚拟机。但是,您不能将 A30-8C vGPU 和 A16-8C vGPU 分配给同一虚拟机。

板卡 |

vGPU |

|---|---|

NVIDIA L40S |

具有 KVM 虚拟机监控程序的通用 Linux、Red Hat Enterprise Linux KVM 和 Ubuntu

自 VMware vSphere 8.0 起

VMware vSphere 7.x 版本

|

NVIDIA L40 |

具有 KVM 虚拟机监控程序的通用 Linux、Red Hat Enterprise Linux KVM 和 Ubuntu

自 VMware vSphere 8.0 起

VMware vSphere 7.x 版本

|

NVIDIA L20 |

具有 KVM 虚拟机监控程序的通用 Linux、Red Hat Enterprise Linux KVM 和 Ubuntu

自 VMware vSphere 8.0 起

VMware vSphere 7.x 版本

|

NVIDIA L4 |

具有 KVM 虚拟机监控程序的通用 Linux、Red Hat Enterprise Linux KVM 和 Ubuntu

自 VMware vSphere 8.0 起

VMware vSphere 7.x 版本

|

NVIDIA L2 |

具有 KVM 虚拟机监控程序的通用 Linux、Red Hat Enterprise Linux KVM 和 Ubuntu

自 VMware vSphere 8.0 起

VMware vSphere 7.x 版本

|

NVIDIA RTX 6000 Ada |

具有 KVM 虚拟机监控程序的通用 Linux、Red Hat Enterprise Linux KVM 和 Ubuntu

自 VMware vSphere 8.0 起

VMware vSphere 7.x 版本

|

NVIDIA RTX 5880 Ada |

具有 KVM 虚拟机监控程序的通用 Linux、Red Hat Enterprise Linux KVM 和 Ubuntu

自 VMware vSphere 8.0 起

VMware vSphere 7.x 版本

|

NVIDIA RTX 5000 Ada |

具有 KVM 虚拟机监控程序的通用 Linux、Red Hat Enterprise Linux KVM 和 Ubuntu

自 VMware vSphere 8.0 起

VMware vSphere 7.x 版本

|

板卡 |

vGPU [1] |

|---|---|

NVIDIA H800 PCIe 94GB |

所有 NVIDIA vGPU (C-Series) |

NVIDIA H800 PCIe 80GB |

所有 NVIDIA vGPU (C-Series) |

NVIDIA H800 SXM5 80GB |

NVIDIA vGPU (C-Series) [6] |

NVIDIA H100 PCIe 94GB (H100 NVL) |

所有 NVIDIA vGPU (C-Series) |

NVIDIA H100 SXM5 94GB |

NVIDIA vGPU (C-Series) [6] |

NVIDIA H100 PCIe 80GB |

所有 NVIDIA vGPU (C-Series) |

NVIDIA H100 SXM5 80GB |

NVIDIA vGPU (C-Series) [6] |

NVIDIA H100 SXM5 64GB |

NVIDIA vGPU (C-Series) [6] |

板卡 |

vGPU [1] |

|---|---|

|

具有 KVM 虚拟机监控程序的通用 Linux、Red Hat Enterprise Linux KVM 和 Ubuntu

自 VMware vSphere 8.0 起

VMware vSphere 7.x 版本

|

NVIDIA A800 HGX 80GB |

自 VMware vSphere 8.0 起

VMware vSphere 7.x 版本

|

NVIDIA A800 PCIe 40GB 主动散热 |

具有 KVM 虚拟机监控程序的通用 Linux、Red Hat Enterprise Linux KVM 和 Ubuntu

自 VMware vSphere 8.0 起

VMware vSphere 7.x 版本

|

|

具有 KVM 虚拟机监控程序的通用 Linux、Red Hat Enterprise Linux KVM 和 Ubuntu

自 VMware vSphere 8.0 起

VMware vSphere 7.x 版本

|

NVIDIA A100 HGX 80GB |

自 VMware vSphere 8.0 起

VMware vSphere 7.x 版本

|

NVIDIA A100 PCIe 40GB |

具有 KVM 虚拟机监控程序的通用 Linux、Red Hat Enterprise Linux KVM 和 Ubuntu

自 VMware vSphere 8.0 起

VMware vSphere 7.x 版本

|

NVIDIA A100 HGX 40GB |

自 VMware vSphere 8.0 起

VMware vSphere 7.x 版本

|

NVIDIA A40 |

具有 KVM 虚拟机监控程序的通用 Linux、Red Hat Enterprise Linux KVM 和 Ubuntu

自 VMware vSphere 8.0 起

VMware vSphere 7.x 版本

|

|

具有 KVM 虚拟机监控程序的通用 Linux、Red Hat Enterprise Linux KVM 和 Ubuntu

自 VMware vSphere 8.0 起

VMware vSphere 7.x 版本

|

NVIDIA A16 |

具有 KVM 虚拟机监控程序的通用 Linux、Red Hat Enterprise Linux KVM 和 Ubuntu

自 VMware vSphere 8.0 起

VMware vSphere 7.x 版本

|

NVIDIA A10 |

具有 KVM 虚拟机监控程序的通用 Linux、Red Hat Enterprise Linux KVM 和 Ubuntu

自 VMware vSphere 8.0 起

VMware vSphere 7.x 版本

|

NVIDIA RTX A6000 |

具有 KVM 虚拟机监控程序的通用 Linux、Red Hat Enterprise Linux KVM 和 Ubuntu

自 VMware vSphere 8.0 起

VMware vSphere 7.x 版本

|

NVIDIA RTX A5500 |

具有 KVM 虚拟机监控程序的通用 Linux、Red Hat Enterprise Linux KVM 和 Ubuntu

自 VMware vSphere 8.0 起

VMware vSphere 7.x 版本

|

NVIDIA RTX A5000 |

具有 KVM 虚拟机监控程序的通用 Linux、Red Hat Enterprise Linux KVM 和 Ubuntu

自 VMware vSphere 8.0 起

VMware vSphere 7.x 版本

|

板卡 |

vGPU |

|---|---|

Tesla T4 |

具有 KVM 虚拟机监控程序的通用 Linux、Red Hat Enterprise Linux KVM 和 Ubuntu

自 VMware vSphere 8.0 起

VMware vSphere 7.x 版本

|

Quadro RTX 6000 passive |

具有 KVM 虚拟机监控程序的通用 Linux、Red Hat Enterprise Linux KVM 和 Ubuntu

自 VMware vSphere 8.0 起

VMware vSphere 7.x 版本

|

Quadro RTX 8000 passive |

具有 KVM 虚拟机监控程序的通用 Linux、Red Hat Enterprise Linux KVM 和 Ubuntu

自 VMware vSphere 8.0 起

VMware vSphere 7.x 版本

|

板卡 |

vGPU |

|---|---|

Tesla V100 SXM2 32GB |

自 VMware vSphere 8.0 起

VMware vSphere 7.x 版本

|

Tesla V100 PCIe 32GB |

具有 KVM 虚拟机监控程序的通用 Linux、Red Hat Enterprise Linux KVM 和 Ubuntu

自 VMware vSphere 8.0 起

VMware vSphere 7.x 版本

|

Tesla V100S PCIe 32GB |

具有 KVM 虚拟机监控程序的通用 Linux、Red Hat Enterprise Linux KVM 和 Ubuntu

自 VMware vSphere 8.0 起

VMware vSphere 7.x 版本

|

Tesla V100 SXM2 |

自 VMware vSphere 8.0 起

VMware vSphere 7.x 版本

|

Tesla V100 PCIe |

具有 KVM 虚拟机监控程序的通用 Linux、Red Hat Enterprise Linux KVM 和 Ubuntu

自 VMware vSphere 8.0 起

VMware vSphere 7.x 版本

|

Tesla V100 FHHL |

具有 KVM 虚拟机监控程序的通用 Linux、Red Hat Enterprise Linux KVM 和 Ubuntu

自 VMware vSphere 8.0 起

VMware vSphere 7.x 版本

|

支持对等 CUDA 传输的 vGPU#

仅支持在支持 NVLink 的物理 GPU 上分配了所有物理 GPU 帧缓冲区的 Q 系列和 C 系列时间分片 vGPU。

板卡 |

vGPU |

|---|---|

NVIDIA H800 PCIe 94GB |

H800L-94C |

NVIDIA H800 PCIe 80GB |

H800-80C |

NVIDIA H100 PCIe 94GB (H100 NVL) |

H100L-94C |

NVIDIA H100 SXM5 94GB |

H100XL-94C |

NVIDIA H100 PCIe 80GB |

H100-80C |

NVIDIA H100 SXM5 80GB |

H100XM-80C |

NVIDIA H100 SXM5 64GB |

H100XS-64C |

板卡 |

vGPU |

|---|---|

|

A800D-80C |

NVIDIA A800 HGX 80GB |

A800DX-80C [2] |

NVIDIA A800 PCIe 40GB 主动散热 |

A800-40C |

|

A100D-80C |

NVIDIA A100 HGX 80GB |

A100DX-80C [2] |

NVIDIA A100 PCIe 40GB |

A100-40C |

NVIDIA A100 HGX 40GB |

A100X-40C [2] |

NVIDIA A40 |

A40-48C |

|

A30-24C |

NVIDIA A10 |

A10-24C |

NVIDIA RTX A6000 |

A6000-48C |

NVIDIA RTX A5500 |

A5500-24C |

NVIDIA RTX A5000 |

A5000-24C |

板卡 |

vGPU |

|---|---|

Quadro RTX 6000 passive |

RTX6000P-24C |

Quadro RTX 8000 passive |

RTX8000P-48C |

板卡 |

vGPU |

|---|---|

Tesla V100 SXM2 32GB |

V100DX-32C |

Tesla V100 SXM2 |

V100X-16C |

GPUDirect 技术支持#

NVIDIA GPUDirect 远程直接内存访问 (RDMA) 技术使网络设备能够直接访问 vGPU 帧缓冲区,完全绕过 CPU 主机内存。GPUDirect Storage 技术为 GPU 和存储之间的直接内存访问 (DMA) 传输启用直接数据路径。GPUDirect 技术仅在部分 vGPU 和客户机操作系统版本上受支持。

支持的 vGPU

GPUDirect RDMA 和 GPUDirect Storage 技术在支持单根 I/O 虚拟化 (SR-IOV) 的物理 GPU 上,所有时间分片和 MIG 支持的 NVIDIA vGPU (C-Series) 上均受支持。

基于 NVIDIA Ada Lovelace GPU 架构的 GPU

NVIDIA L40

NVIDIA L40S

NVIDIA L20

NVIDIA L20 液冷

NVIDIA L4

NVIDIA L2

NVIDIA RTX 6000 Ada

NVIDIA RTX 5880 Ada

NVIDIA RTX 5000 Ada

基于 NVIDIA Hopper GPU 架构的 GPU

NVIDIA H800 PCIe 94GB

NVIDIA H800 PCIe 80GB

NVIDIA H800 SXM5 80GB

NVIDIA H100 PCIe 94GB (H100 NVL)

NVIDIA H100 SXM5 94GB

NVIDIA H100 PCIe 80GB

NVIDIA H100 SXM5 80GB

NVIDIA H100 SXM5 64GB

基于 NVIDIA Ampere GPU 架构的 GPU

NVIDIA A800 PCIe 80GB

NVIDIA A800 PCIe 80GB 液冷

NVIDIA A800 HGX 80GB

NVIDIA AX800

NVIDIA A800 PCIe 40GB 主动散热

NVIDIA A100 PCIe 80GB

NVIDIA A100 PCIe 80GB 液冷

NVIDIA A100 HGX 80GB

NVIDIA A100 PCIe 40GB

NVIDIA A100 HGX 40GB

NVIDIA A100X

NVIDIA A30

NVIDIA A30 液冷

NVIDIA A30X

NVIDIA A40

NVIDIA A16

NVIDIA A10

NVIDIA A2

NVIDIA RTX A6000

NVIDIA RTX A5500

NVIDIA RTX A5000

支持的客户机操作系统版本

仅限 Linux。Windows 上不支持 GPUDirect 技术。

支持的网络接口卡

GPUDirect 技术在以下网络接口卡上受支持

NVIDIA ConnectX- 7 SmartNIC

Mellanox Connect-X 6 SmartNIC

Mellanox Connect-X 5 以太网适配器卡

限制

从 GPUDirect Storage 技术 1.7.2 版本开始,适用以下限制

基于 NVIDIA Ampere GPU 架构的 GPU 上不支持 GPUDirect Storage 技术。

在基于 NVIDIA Hopper GPU 架构和 NVIDIA Ada Lovelace GPU 架构的 GPU 上,GPUDirect Storage 技术仅在使用基于 NVIDIA Linux 开源 GPU 内核模块的 Linux 客户机驱动程序时受支持。

1.7.2 之前的 GPUDirect Storage 技术版本仅在使用 Linux 内核版本早于 6.6 的客户机驱动程序时受支持。

GPUDirect Storage 技术仅在以下客户机操作系统版本上受支持

Ubuntu 22.04 LTS

Ubuntu 20.04 LTS

NVIDIA NVSwitch 片上内存 Fabric 支持#

NVIDIA NVSwitch 片上内存 fabric 支持通过 NVLink fabric 在单个节点内进行对等 vGPU 通信。它仅在部分硬件平台、vGPU、虚拟机监控程序软件版本和客户机操作系统版本上受支持。

有关使用 NVSwitch 片上内存 fabric 的信息,请参阅 《Fabric Manager for NVIDIA NVSwitch Systems User Guide》。

支持 NVIDIA NVSwitch 片上内存 Fabric 的硬件平台#

NVIDIA HGX H800 8-GPU baseboard

NVIDIA HGX H100 8-GPU baseboard

NVIDIA HGX A100 8-GPU baseboard

支持 NVIDIA NVSwitch 片上内存 Fabric 的 vGPU#

仅支持在 NVIDIA H800 和 NVIDIA H100 SXM5 物理 GPU 以及 NVIDIA A800 和 NVIDIA A100 HGX 物理 GPU 上分配了所有物理 GPU 帧缓冲区的 C 系列时间分片 vGPU。

板卡 |

vGPU |

|---|---|

NVIDIA H800 SXM5 80GB |

H800XM-80C |

NVIDIA H100 SXM5 80GB |

H100XM-80C |

板卡 |

vGPU |

|---|---|

NVIDIA A800 HGX 80GB |

A800DX-80C |

NVIDIA A100 HGX 80GB |

A100DX-80C |

NVIDIA A100 HGX 40GB |

A100X-40C |

支持 NVIDIA NVSwitch 片上内存 Fabric 的虚拟机监控程序版本#

请查阅您的虚拟机监控程序供应商的文档,以获取有关哪些具有 KVM 虚拟机监控程序的通用 Linux 虚拟机监控程序软件版本支持 NVIDIA NVSwitch 片上内存 fabric 的信息。

所有受支持的 Red Hat Enterprise Linux KVM 版本都支持 NVIDIA NVSwitch 片上内存 fabric。

在 Ubuntu 虚拟机监控程序上,不支持 NVSwitch。

支持 NVIDIA NVSwitch 片上内存 fabric 的最早 VMware vSphere Hypervisor (ESXi) 版本取决于 GPU 架构。

GPU 架构 |

最早支持的 VMware vSphere Hypervisor (ESXi) 版本 |

|---|---|

NVIDIA Hopper |

VMware vSphere Hypervisor (ESXi) 8 update 2 |

NVIDIA Ampere |

VMware vSphere Hypervisor (ESXi) 8 update 1 |

支持 NVIDIA NVSwitch 片上内存 Fabric 的客户机操作系统版本#

仅限 Linux。Windows 上不支持 NVIDIA NVSwitch 片上内存 fabric。

NVIDIA NVSwitch 片上内存 Fabric 支持的限制#

仅支持时间分片 vGPU。不支持 MIG 支持的 vGPU。

在 Ubuntu 虚拟机监控程序上,不支持 NVSwitch。

不支持 GPU 直通。

不支持 SLI。

所有进行对等通信的 vGPU 都必须分配给同一虚拟机。

在基于 NVIDIA Hopper GPU 架构的 GPU 上,不支持多播。

支持统一内存的 vGPU#

在支持多实例 GPU (MIG) 功能的 GPU 上,支持所有 MIG 支持的 vGPU。仅支持在支持统一内存的物理 GPU 上分配了所有物理 GPU 帧缓冲区的时间分片 NVIDIA vGPU (C-Series)。

板卡 |

vGPU |

|---|---|

NVIDIA L40 |

L40-48C |

NVIDIA L40S |

L40S-48C |

|

L20-48C |

NVIDIA L4 |

L4-24C |

NVIDIA L2 |

L2-24C |

NVIDIA RTX 6000 Ada |

RTX 6000 Ada-48C |

NVIDIA RTX 5880 Ada |

RTX 5880 Ada-48C |

NVIDIA RTX 5000 Ada |

RTX 6000 Ada-32C |

板卡 |

vGPU |

|---|---|

NVIDIA H800 PCIe 94GB |

|

NVIDIA H800 PCIe 80GB |

|

NVIDIA H800 SXM5 80GB |

|

NVIDIA H100 PCIe 94GB (H100 NVL) |

|

NVIDIA H100 SXM5 94GB |

|

NVIDIA H100 PCIe 80GB |

|

NVIDIA H100 SXM5 80GB |

|

NVIDIA H100 SXM5 64GB |

|

板卡 |

vGPU |

|---|---|

|

|

NVIDIA A800 HGX 80GB |

|

NVIDIA A800 PCIe 40GB 主动散热 |

|

|

|

NVIDIA A100 HGX 80GB |

|

NVIDIA A100 PCIe 40GB |

|

NVIDIA A100 HGX 40GB |

|

NVIDIA A40 |

A40-48C |

|

|

NVIDIA A16 |

A16-16C |

NVIDIA A10 |

A10-24C |

NVIDIA RTX A6000 |

A6000-48C |

NVIDIA RTX A5500 |

A5500-24C |

NVIDIA RTX A5000 |

A5000-24C |

nvidia-smi 无法报告 MIG 实例的 GPU 利用率#

当 GPU 启用多实例 GPU (MIG) 模式时,nvidia-smi 命令无法报告任何 MIG 实例的 GPU 引擎利用率。要监视 MIG 实例的 GPU 引擎利用率,请使用 --gpm-metrics ID-list 选项运行 nvidia-smi vgpu 命令。

以下示例显示了为启用 MIG 模式的 GPU 从 nvidia-smi 输出的结果。

[root@host ~]# nvidia-smi

Fri Jun 14 11:45:28 2024

+-----------------------------------------------------------------------------+

| NVIDIA-SMI 550.90.05 Driver Version: 550.90.05 CUDA Version: 12.4 |

|-------------------------------+----------------------+----------------------+

|-------------------------------+----------------------+----------------------+

| GPU Name Persistence-M| Bus-Id Disp.A | Volatile Uncorr. ECC |

| Fan Temp Perf Pwr:Usage/Cap| Memory-Usage | GPU-Util Compute M. |

| | | MIG M. |

|===============================+======================+======================|

| 0 GRID A100-2-10C On | 00000000:02:02.0 Off | On |

| N/A N/A P0 N/A / N/A | 2556MiB / 10235MiB | N/A Default |

| | | Enabled |

+-------------------------------+----------------------+----------------------+

+-----------------------------------------------------------------------------+

| MIG devices: |

+------------------+----------------------+-----------+-----------------------+

| GPU GI CI MIG | Memory-Usage | Vol | Shared |

| ID ID Dev | BAR1-Usage | SM Unc | CE ENC DEC OFA JPG |

| | | ECC | |

|==================+======================+===========+=======================|

| 0 0 0 0 | 2556MiB / 10235MiB | 28 0 | 2 0 1 0 0 |

| | 5MiB / 4096MiB | | |

+------------------+----------------------+-----------+-----------------------+

+-----------------------------------------------------------------------------+

| Processes: |

| GPU GI CI PID Type Process name GPU Memory |

| ID ID Usage |

|=============================================================================|

| 0 0 0 2843 C python3 1516MiB |

vGPU 的总帧缓冲区小于物理 GPU 上的总帧缓冲区#

虚拟机监控程序代表虚拟机使用物理 GPU 的部分帧缓冲区,用于客户机操作系统原本会在其帧缓冲区中进行的分配。虚拟机监控程序使用的帧缓冲区不可用于物理 GPU 上的 vGPU。在 NVIDIA vGPU 部署中,客户机操作系统的帧缓冲区是预先保留的,而在裸机部署中,客户机操作系统的帧缓冲区是根据应用程序的运行时需求保留的。

如果在没有 HBM2 内存的物理 GPU 上启用了纠错码 (ECC) 内存,则 vGPU 可用的帧缓冲区量将进一步减少。所有类型的 vGPU 都会受到影响,而不仅仅是那些支持 ECC 内存的 vGPU。

在所有支持 ECC 内存以及动态页面退役的 GPU 上,都会为动态页面退役分配额外的帧缓冲区。分配量与每个物理 GPU 的最大 vGPU 数量成反比。所有支持 ECC 内存的 GPU 都会受到影响,即使是那些具有 HBM2 内存或禁用 ECC 内存的 GPU 也是如此。

NVIDIA AI Enterprise 保留的帧缓冲区近似量可以通过以下公式计算

max-reserved-fb = vgpu-profile-size-in-mb÷16 + 16 + ecc-adjustments + page-retirement-allocation + compression-adjustment

max-reserved-fb - 以 MB 为单位的保留帧缓冲区的总量,vGPU 不可用。

vgpu-profile-size-in-mb - 以 MB 为单位分配给单个 vGPU 的帧缓冲区量。此数量取决于 vGPU 类型。例如,对于 T4-16Q vGPU 类型,vgpu-profile-size-in-mb 为 16384。

ecc-adjustments - 当在没有 HBM2 内存的物理 GPU 上启用 ECC 时,以 MB 为单位的 vGPU 不可用的帧缓冲区量。

如果在没有 HBM2 内存的物理 GPU 上启用了 ECC,则

ecc-adjustments为fb-without-ecc/16,相当于为分配给 vGPU 的每 Gbyte 帧缓冲区 64 MB。fb-without-ecc是禁用 ECC 的帧缓冲区的总量。如果禁用 ECC 或 GPU 具有 HBM2 内存,则

ecc-adjustments为 0。

page-retirement-allocation - 以 MB 为单位为动态页面退役保留的帧缓冲区量。

在基于 NVIDIA Maxwell GPU 架构的 GPU 上,

page-retirement-allocation = 4÷max-vgpus-per-gpu。在基于 Maxwell 架构之后的 NVIDIA GPU 架构的 GPU 上,

page-retirement-allocation = 128÷max-vgpus-per-gpu。

max-vgpus-per-gpu - 可以在物理 GPU 上同时创建的最大 vGPU 数量。此数量因 vGPU 类型而异。例如,对于 T4-16Q vGPU 类型,max-vgpus-per-gpu 为 1。

compression-adjustment - 在基于 Turing 架构的 GPU 上,对于具有 12 Gbytes 或更多帧缓冲区的 vGPU 类型,为更高的压缩开销保留的以 MB 为单位的帧缓冲区量。

compression-adjustment 取决于 vGPU 类型,如下表所示。

vGPU 类型 |

压缩调整 (MB) |

|---|---|

T4-16C |

28 |

RTX6000-12C |

32 |

RTX6000-24C |

104 |

RTX6000P-12C |

32 |

RTX6000P-24C |

104 |

RTX8000-12C |

32 |

RTX8000-16C |

64 |

RTX8000-24C |

96 |

RTX8000-48C |

238 |

RTX8000P-12C |

32 |

RTX8000P-16C |

64 |

RTX8000P-24C |

96 |

RTX8000P-48C |

238 |

对于所有其他 vGPU 类型,compression-adjustment 为 0。

单个 vGPU 基准测试分数低于直通 GPU#

描述

在物理 GPU 上配置的单个 vGPU 产生的基准测试分数低于在直通模式下运行的物理 GPU。

除了可能归因于 vGPU 较小帧缓冲区大小的性能差异外,vGPU 还包含一个称为帧速率限制器 (FRL) 的性能平衡功能。在使用尽力调度程序的 vGPU 上,FRL 已启用。在使用固定份额或均等份额调度程序的 vGPU 上,FRL 已禁用。

FRL 确保驻留在同一物理 GPU 上的多个 vGPU 之间的性能平衡。FRL 设置旨在提供良好的交互式远程图形体验。但是,与在直通 GPU 上运行的相同基准测试相比,它可能会降低依赖于测量帧渲染速率的基准测试中的分数。

解决方法

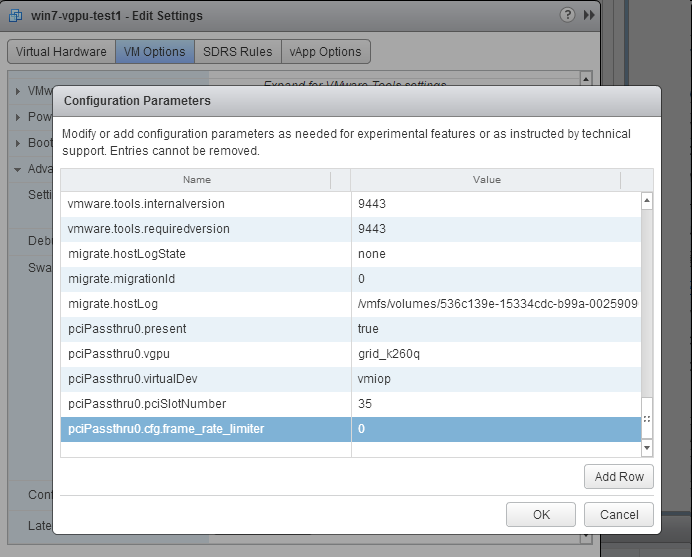

内部 vGPU 设置控制 FRL。在使用尽力调度程序的 vGPU 上,NVIDIA 不验证禁用 FRL 的 vGPU。但是,为了进行基准性能验证,可以通过在虚拟机的“高级配置”选项中添加配置参数 pciPassthru0.cfg.frame_rate_limiter 来临时禁用 FRL。

注意

此设置只能在虚拟机关闭电源时更改。

选择编辑设置。

在“编辑设置”窗口中,选择“虚拟机选项”选项卡。

从“高级”下拉列表中,选择“编辑配置”。

在“配置参数”对话框中,单击“添加行”。

在“名称”字段中,键入参数

pciPassthru0.cfg.frame_rate_limiter。在“值”字段中,键入

0,然后单击“确定”。

使用此设置,虚拟机的 vGPU 将在没有任何帧速率限制的情况下运行。通过将 pciPassthru0.cfg.frame_rate_limiter 设置为 1 或从高级设置中删除参数,可以将 FRL 恢复为其默认设置。

解决方法

内部 vGPU 设置控制 FRL。在使用尽力调度程序的 vGPU 上,NVIDIA 不验证禁用 FRL 的 vGPU,但为了进行基准性能验证,可以通过在 vGPU 配置文件中设置 frame_rate_limiter=0 来临时禁用 FRL。

# echo "frame_rate_limiter=0" > /sys/bus/mdev/devices/vgpu-id/nvidia/vgpu_params

例如

# echo "frame_rate_limiter=0" > /sys/bus/mdev/devices/aa618089-8b16-4d01-a136-25a0f3c73123/nvidia/vgpu_params

该设置在下次启动使用给定 vGPU 类型的任何虚拟机时生效。

使用此设置,虚拟机的 vGPU 将在没有任何帧速率限制的情况下运行。

可以按如下方式将 FRL 恢复为其默认设置

清除 vGPU 配置文件中的所有参数设置。

# echo " " > /sys/bus/mdev/devices/vgpu-id/nvidia/vgpu_params注意

您无法清除特定的参数设置。如果您的 vGPU 配置文件包含您想要保留的其他参数设置,则必须在下一步中重新设置它们。

在 vGPU 配置文件中设置

frame_rate_limiter=1。# echo "frame_rate_limiter=1" > /sys/bus/mdev/devices/vgpu-id/nvidia/vgpu_params如果您需要重新设置其他参数设置,请将它们包含在用于设置

frame_rate_limiter=1的命令中。例如# echo "frame_rate_limiter=1 disable_vnc=1" > /sys/bus/mdev/devices/aa618089-8b16-4d01-a136-25a0f3c73123/nvidia/vgpu_params

用户指南#

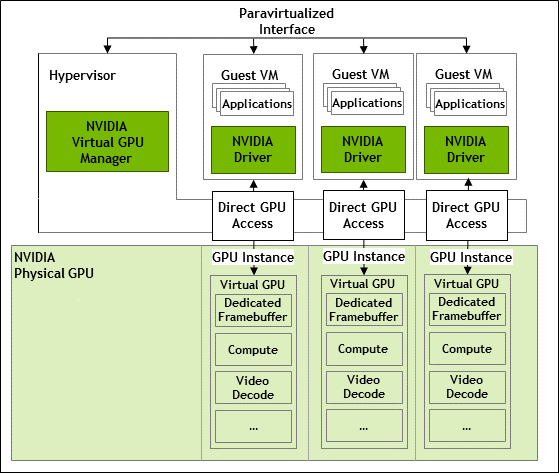

MIG 支持的 NVIDIA vGPU 内部架构#

MIG 支持的 vGPU 是驻留在支持 MIG 的物理 GPU 中的 GPU 实例上的 vGPU。驻留在 GPU 上的每个 MIG 支持的 vGPU 都可以独占访问 GPU 实例的引擎,包括计算引擎和视频解码引擎。

在 MIG 支持的 vGPU 中,在 vGPU 上运行的进程与在 GPU 上其他 vGPU 上运行的进程并行运行。该进程同时在驻留在物理 GPU 上的所有 vGPU 上运行。

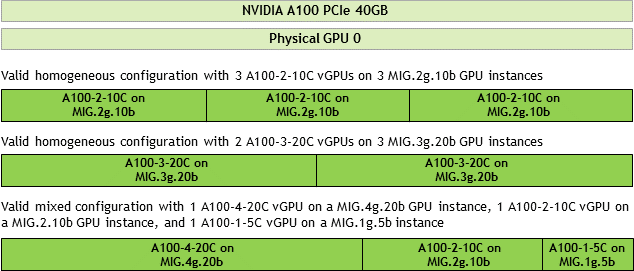

单个 GPU 上有效的 MIG 支持的虚拟 GPU 配置#

NVIDIA vGPU 支持基于底层 GPU 实例配置的同构和混合 MIG 支持的虚拟 GPU。

例如,NVIDIA A100 PCIe 40GB 卡具有一个物理 GPU,并且可以支持多种类型的虚拟 GPU。该图显示了 NVIDIA A100 PCIe 40GB 上有效的同构和混合 MIG 支持的虚拟 GPU 配置示例。

3 个 MIG.2g.10b GPU 实例上具有 3 个 A100-2-10C vGPU 的有效同构配置

3 个 MIG.3g.20b GPU 实例上具有 2 个 A100-3-20C vGPU 的有效同构配置

在 MIG.4g.20b GPU 实例上具有 1 个 A100-4-20C vGPU、在 MIG.2.10b GPU 实例上具有 1 个 A100-2-10C vGPU 以及在 MIG.1g.5b 实例上具有 1 个 A100-1-5C vGPU 的有效混合配置

安装和配置 Red Hat Enterprise Linux KVM 的 NVIDIA Virtual GPU Manager#

以下主题将引导您完成设置单个 Red Hat Enterprise Linux 基于内核的虚拟机 (KVM) 虚拟机以使用 NVIDIA vGPU 的过程。

注意

虚拟机控制台的输出对于运行 vGPU 的虚拟机不可用。在配置 vGPU 之前,请确保您已安装访问虚拟机的替代方法(例如 VNC 服务器)。

按照以下说明顺序操作

为 Red Hat Enterprise Linux KVM 安装 Virtual GPU Manager 软件包

验证 Red Hat Enterprise Linux KVM 的 NVIDIA AI Enterprise 的安装

仅限 MIG 支持的 vGPU:为 MIG 支持的 vGPU 配置 GPU

仅限支持 SR-IOV 的 vGPU:在具有 KVM 虚拟机监控程序的 Linux 上为支持 SR-IOV 的 NVIDIA vGPU 准备虚拟功能

可选:将 GPU 置于混合大小模式

在具有 KVM 虚拟机监控程序的 Linux 上获取 GPU 的 BDF 和域

在具有 KVM 虚拟机监控程序的 Linux 上创建 NVIDIA vGPU

将一个或多个 vGPU 添加到具有 KVM 虚拟机监控程序的 Linux 虚拟机

可选:将 vGPU 放置在混合大小模式下的物理 GPU 上

在具有 KVM 虚拟机监控程序的 Linux 上设置 vGPU 插件参数

完成该过程后,您可以为您的客户机操作系统安装图形驱动程序,并许可您使用的任何 NVIDIA AI Enterprise 许可的产品。

安装和配置 Ubuntu 的 NVIDIA Virtual GPU Manager#

注意

虚拟机控制台的输出对于运行 vGPU 的虚拟机不可用。在配置 vGPU 之前,请确保您已安装访问虚拟机的替代方法(例如 VNC 服务器)。

按照以下说明顺序操作以设置单个 Ubuntu 虚拟机以使用 NVIDIA vGPU。

为 Ubuntu 安装 NVIDIA Virtual GPU Manager

仅限 MIG 支持的 vGPU:为 MIG 支持的 vGPU 配置 GPU

在具有 KVM 虚拟机监控程序的 Linux 上获取 GPU 的 BDF 和域

仅限支持 SR-IOV 的 vGPU:在具有 KVM 虚拟机监控程序的 Linux 上为支持 SR-IOV 的 NVIDIA vGPU 准备虚拟功能

可选:将 GPU 置于混合大小模式

在具有 KVM 虚拟机监控程序的 Linux 上创建 NVIDIA vGPU

将一个或多个 vGPU 添加到具有 KVM 虚拟机监控程序的 Linux 虚拟机

可选:将 vGPU 放置在混合大小模式下的物理 GPU 上

在具有 KVM 虚拟机监控程序的 Linux 上设置 vGPU 插件参数

完成该过程后,您可以为您的客户机操作系统安装图形驱动程序,并许可您使用的任何 NVIDIA AI Enterprise 许可的产品。

安装和配置 VMware vSphere 的 NVIDIA Virtual GPU Manager#

您可以使用 VMware vSphere 的 NVIDIA Virtual GPU Manager 来设置 VMware vSphere 虚拟机以使用 NVIDIA vGPU。

注意

某些服务器(例如 Dell R740)如果服务器上禁用了 SR-IOV SBIOS 设置,则不会配置 SR-IOV 功能。如果您在此类服务器上将 Tesla T4 GPU 与 VMware vSphere 一起使用,则必须确保服务器上启用了 SR-IOV SBIOS 设置。

但是,对于任何服务器硬件,在 VMware vCenter Server 中都不会为 Tesla T4 GPU 启用 SR-IOV。如果在 VMware vCenter Server 中为 T4 启用了 SR-IOV,则 GPU 的状态将列为需要重新启动。您可以忽略此状态消息。

在 DRS 集群中配置 NVIDIA vGPU 的要求#

您可以在 VMware Distributed Resource Scheduler (DRS) 集群中的 ESXi 主机上配置具有 NVIDIA vGPU 的虚拟机。但是,为确保集群的自动化级别支持配置了 NVIDIA vGPU 的虚拟机,您必须将自动化级别设置为“部分自动化”或“手动”。

有关这些设置的更多信息,请参阅 VMware 文档中的 “编辑集群设置”。

为 MIG 支持的 vGPU 配置 GPU#

要支持带有 NVIDIA vGPU 的 GPU 实例,必须将 GPU 配置为启用 MIG 模式,并且必须在物理 GPU 上创建和配置 GPU 实例。 (可选)您可以在 GPU 实例中创建计算实例。 如果您未在 GPU 实例中创建计算实例,则稍后可以从访客 VM 内为各个 vGPU 添加计算实例。

确保满足以下先决条件

NVIDIA Virtual GPU Manager 已安装在 Hypervisor 主机上。

您在 Hypervisor 主机上拥有 root 用户权限。

您已确定哪些 GPU 实例与您将创建的基于 MIG 的 vGPU 的 vGPU 类型相对应。

其他进程(例如 CUDA 应用程序、监控应用程序或

nvidia-smi命令)不使用 GPU。

要为基于 MIG 的 vGPU 配置 GPU,请按照以下说明进行操作

为 GPU 启用 MIG 模式。

注意

对于 VMware vSphere,仅需要启用 MIG 模式,因为 VMware vSphere 会创建 GPU 实例,并且在 VM 启动并安装访客驱动程序后,会在 VM 中自动创建一个计算实例。

在启用 MIG 的 GPU 上创建 GPU 实例。

可选:在 GPU 实例中创建计算实例。

为基于 MIG 的 vGPU 配置 GPU 后,创建您需要的 vGPU 并将其添加到其 VM。

为 GPU 启用 MIG 模式#

在您的 Hypervisor 命令行 Shell 中执行此任务。

以 root 用户身份在 Hypervisor 主机上打开命令行 Shell。 您可以在所有受支持的 Hypervisor 上使用安全 Shell (SSH)。 不同的 Hypervisor 可能提供其他登录方式。 有关详细信息,请参阅您的 Hypervisor 文档。

确定是否启用了 MIG 模式。 使用

nvidia-smi命令来实现此目的。 默认情况下,MIG 模式处于禁用状态。 此示例显示 GPU 0 上的 MIG 模式已禁用。注意

在

nvidia-smi的输出中,NVIDIA A100 HGX 40GB GPU 被称为 A100-SXM4-40GB。$ nvidia-smi -i 0 +-----------------------------------------------------------------------------+ | NVIDIA-SMI 550.54.16 Driver Version: 550.54.16 CUDA Version: 12.3 | |-------------------------------+----------------------+----------------------+ | GPU Name Persistence-M| Bus-Id Disp.A | Volatile Uncorr. ECC | | Fan Temp Perf Pwr:Usage/Cap| Memory-Usage | GPU-Util Compute M. | | | | MIG M. | |===============================+======================+======================| | 0 A100-SXM4-40GB On | 00000000:36:00.0 Off | 0 | | N/A 29C P0 62W / 400W | 0MiB / 40537MiB | 6% Default | | | | Disabled | +-------------------------------+----------------------+----------------------+

如果 MIG 模式已禁用,请启用它。

$ nvidia-smi -i [gpu-ids] -mig 1

gpu-ids- 以逗号分隔的 GPU 索引、PCI 总线 ID 或 UUID 列表,用于指定要启用 MIG 模式的 GPU。 如果省略gpu-ids,则会在系统上的所有 GPU 上启用 MIG 模式。此示例在 GPU 0 上启用 MIG 模式。

$ nvidia-smi -i 0 -mig 1 Enabled MIG Mode for GPU 00000000:36:00.0 All done.

注意

如果另一个进程正在使用 GPU,则此命令将失败,并显示一条警告消息,指示 GPU 的 MIG 模式处于挂起启用状态。 在这种情况下,停止所有 GPU 进程并重试该命令。

VMware vSphere ESXi,其 GPU 仅基于 NVIDIA Ampere 架构:重新启动 Hypervisor 主机。 如果您使用的是不同的 Hypervisor 或基于 NVIDIA Hopper GPU 架构或更高架构的 GPU,请省略此步骤。

查询您已启用 MIG 模式的 GPU,以确认 MIG 模式已启用。 此示例以逗号分隔值 (CSV) 格式查询 GPU 0 的 PCI 总线 ID 和 MIG 模式。

$ nvidia-smi -i 0 --query-gpu=pci.bus_id,mig.mode.current --format=csv pci.bus_id, mig.mode.current 00000000:36:00.0, Enabled

在启用 MIG 的 GPU 上创建 GPU 实例#

注意

如果您使用的是 VMware vSphere,请省略此任务。 VMware vSphere 会自动创建 GPU 实例。

在您的 Hypervisor 命令行 Shell 中执行此任务。

如有必要,以 root 用户身份在 Hypervisor 主机上打开命令行 Shell。

列出 GPU 上可用的 GPU 实例配置文件。 创建配置文件时,您必须按其 ID 而不是名称来指定配置文件。

$ nvidia-smi mig -lgip +--------------------------------------------------------------------------+ | GPU instance profiles: | | GPU Name ID Instances Memory P2P SM DEC ENC | | Free/Total GiB CE JPEG OFA | |==========================================================================| | 0 MIG 1g.5gb 19 7/7 4.95 No 14 0 0 | | 1 0 0 | +--------------------------------------------------------------------------+ | 0 MIG 2g.10gb 14 3/3 9.90 No 28 1 0 | | 2 0 0 | +--------------------------------------------------------------------------+ | 0 MIG 3g.20gb 9 2/2 19.79 No 42 2 0 | | 3 0 0 | +--------------------------------------------------------------------------+ | 0 MIG 4g.20gb 5 1/1 19.79 No 56 2 0 | | 4 0 0 | +--------------------------------------------------------------------------+ | 0 MIG 7g.40gb 0 1/1 39.59 No 98 5 0 | | 7 1 1 | +--------------------------------------------------------------------------+

创建与您将创建的基于 MIG 的 vGPU 的 vGPU 类型相对应的 GPU 实例。

$ nvidia-smi mig -cgi gpu-instance-profile-ids

gpu-instance-profile-ids- 以逗号分隔的 GPU 实例配置文件 ID 列表,用于指定要创建的 GPU 实例。此示例创建两个类型为

2g.10gb且配置文件ID 14的 GPU 实例。$ nvidia-smi mig -cgi 14,14 Successfully created GPU instance ID 5 on GPU 2 using profile MIG 2g.10gb (ID 14) Successfully created GPU instance ID 3 on GPU 2 using profile MIG 2g.10gb (ID 14)

可选:在 GPU 实例中创建计算实例#

在 GPU 实例中创建计算实例是可选的。 如果您未在 GPU 实例中创建计算实例,则稍后可以从访客 VM 内为各个 vGPU 添加计算实例。

注意

如果您使用的是 VMware vSphere,请省略此任务。 在 VM 启动并安装访客驱动程序后,会自动创建一个计算实例。

在您的 Hypervisor 命令行 Shell 中执行此任务。

如有必要,以 root 用户身份在 Hypervisor 主机上打开命令行 Shell。

列出可用的 GPU 实例。

$ nvidia-smi mig -lgi +----------------------------------------------------+ | GPU instances: | | GPU Name Profile Instance Placement | | ID ID Start:Size | |====================================================| | 2 MIG 2g.10gb 14 3 0:2 | +----------------------------------------------------+ | 2 MIG 2g.10gb 14 5 4:2 | +----------------------------------------------------+

在每个 GPU 实例中创建您需要的计算实例

$ nvidia-smi mig -cci -gi gpu-instance-ids

gpu-instance-ids- 以逗号分隔的 GPU 实例 ID 列表,用于指定要在其中创建计算实例的 GPU 实例。注意

为避免访客 VM 和 Hypervisor 主机之间状态不一致,请勿在正在运行活动访客 VM 的 GPU 实例上从 Hypervisor 创建计算实例。 而是从访客 VM 内创建计算实例,如修改基于 MIG 的 vGPU 的配置中所述。

此示例在每个 GPU 实例 3 和 5 上创建一个计算实例。

$ nvidia-smi mig -cci -gi 3,5 Successfully created compute instance on GPU 0 GPU instance ID 1 using profile ID 2 Successfully created compute instance on GPU 0 GPU instance ID 2 using profile ID 2

验证是否在每个 GPU 实例中创建了计算实例。

$ nvidia-smi +-----------------------------------------------------------------------------+ | MIG devices: | +------------------+----------------------+-----------+-----------------------+ | GPU GI CI MIG | Memory-Usage | Vol| Shared | | ID ID Dev | BAR1-Usage | SM Unc| CE ENC DEC OFA JPG| | | | ECC| | |==================+======================+===========+=======================| | 2 3 0 0 | 0MiB / 9984MiB | 28 0 | 2 0 1 0 0 | | | 0MiB / 16383MiB | | | +------------------+----------------------+-----------+-----------------------+ | 2 5 0 1 | 0MiB / 9984MiB | 28 0 | 2 0 1 0 0 | | | 0MiB / 16383MiB | | | +------------------+----------------------+-----------+-----------------------+ +-----------------------------------------------------------------------------+ | Processes: | | GPU GI CI PID Type Process name GPU Memory | | ID ID Usage | |=============================================================================|

注意

在 VM 中创建的其他计算实例在 VM 关闭或重新启动时会被销毁。 关闭或重新启动后,VM 中仅保留一个计算实例。 此计算实例是在安装 NVIDIA AI Enterprise 图形驱动程序后自动创建的。

禁用一个或多个 GPU 的 MIG 模式#

如果您要用于分时 vGPU 或 GPU 直通的 GPU 之前已配置为用于基于 MIG 的 vGPU,请禁用 GPU 上的 MIG 模式。

确保满足以下先决条件

NVIDIA Virtual GPU Manager 已安装在 Hypervisor 主机上。

您在 Hypervisor 主机上拥有 root 用户权限。

其他进程(例如 CUDA 应用程序、监控应用程序或

nvidia-smi命令)不使用 GPU。

在您的 Hypervisor 命令行 Shell 中执行此任务。

以 root 用户身份在 Hypervisor 主机上打开命令行 Shell。 您可以在所有受支持的 Hypervisor 上使用安全 Shell (SSH)。 不同的 Hypervisor 可能提供其他登录方式。 有关详细信息,请参阅您的 Hypervisor 文档。

确定是否禁用了 MIG 模式。 使用

nvidia-smi命令来实现此目的。 默认情况下,MIG 模式处于禁用状态,但之前可能已启用。 此示例显示 GPU 0 上的 MIG 模式已启用。注意

在

nvidia-smi的输出中,NVIDIA A100 HGX 40GB GPU 被称为 A100-SXM4-40GB。$ nvidia-smi -i 0 +-----------------------------------------------------------------------------+ | NVIDIA-SMI 550.54.16 Driver Version: 550.54.16 CUDA Version: 12.3 | |-------------------------------+----------------------+----------------------+ | GPU Name Persistence-M| Bus-Id Disp.A | Volatile Uncorr. ECC | | Fan Temp Perf Pwr:Usage/Cap| Memory-Usage | GPU-Util Compute M. | | | | MIG M. | |===============================+======================+======================| | 0 A100-SXM4-40GB Off | 00000000:36:00.0 Off | 0 | | N/A 29C P0 62W / 400W | 0MiB / 40537MiB | 6% Default | | | | Enabled | +-------------------------------+----------------------+----------------------+

如果 MIG 模式已启用,请禁用它。

$ nvidia-smi -i [gpu-ids] -mig 0

gpu-ids- 以逗号分隔的 GPU 索引、PCI 总线 ID 或 UUID 列表,用于指定要禁用 MIG 模式的 GPU。 如果省略gpu-ids,则会为系统中的所有 GPU 禁用 MIG 模式。此示例禁用 GPU

0上的MIG 模式。$ sudo nvidia-smi -i 0 -mig 0 Disabled MIG Mode for GPU 00000000:36:00.0 All done.

确认 MIG 模式已禁用。 使用

nvidia-smi命令来实现此目的。 此示例显示 GPU 0 上的 MIG 模式已禁用。$ nvidia-smi -i 0 +-----------------------------------------------------------------------------+ | NVIDIA-SMI 550.54.16 Driver Version: 550.54.16 CUDA Version: 12.3 | |-------------------------------+----------------------+----------------------+ | GPU Name Persistence-M| Bus-Id Disp.A | Volatile Uncorr. ECC | | Fan Temp Perf Pwr:Usage/Cap| Memory-Usage | GPU-Util Compute M. | | | | MIG M. | |===============================+======================+======================| | 0 A100-SXM4-40GB Off | 00000000:36:00.0 Off | 0 | | N/A 29C P0 62W / 400W | 0MiB / 40537MiB | 6% Default | | | | Disabled | +-------------------------------+----------------------+----------------------+

通过使用 Kubernetes 安装 NVIDIA AI Enterprise 软件组件#

如果您使用的是以下访客操作系统和容器平台的组合之一,请执行此任务

带有 Kubernetes 的 Ubuntu

确保满足以下先决条件

如果您使用的是 Kubernetes,请确保

Kubernetes 已安装在 VM 中。

NVIDIA vGPU Manager 已安装。

您已生成您的 NGC API 密钥,以使用 NVIDIA 向您提供的 URL 访问 NVIDIA Enterprise Collection。

将 AI 和数据科学应用程序及框架的容器映像转换为 Kubernetes Pod#

AI 和数据科学应用程序及框架通过 NGC 私有注册表作为 NGC 容器映像分发。 如果您使用的是 Kubernetes 或 Red Hat OpenShift,则必须将要使用的每个映像转换为 Kubernetes Pod。 每个容器映像都包含运行应用程序或框架所需的整个用户空间软件堆栈:CUDA 库、cuDNN、任何必需的 Magnum IO 组件、TensorRT 和框架。

通过使用 Docker 安装 NVIDIA AI Enterprise 软件、应用程序和深度学习框架组件#

基础架构优化和云原生部署层中的 NVIDIA AI Enterprise 软件组件通过 NVIDIA NGC 上的 NVIDIA AI Enterprise Infra Release 5 集合分发。 NVIDIA AI Enterprise 的应用程序和深度学习框架组件专门通过 NGC 公共目录分发。

每个应用程序或框架的容器映像都包含运行它所需的整个用户空间软件堆栈,即 CUDA 库、cuDNN、任何必需的 Magnum IO 组件、TensorRT 和框架。

确保您已完成 NGC 私有注册表用户指南中的以下任务

从 VM 执行此任务。

获取 Docker pull 命令,以便从 NGC 公共目录中应用程序或组件的列表中下载以下每个应用程序和深度学习框架组件。

应用程序

NVIDIA Clara Parabricks

NVIDIA DeepStream

NVIDIA Riva

MONAI - 用于人工智能的医疗开放网络

RAPIDS

用于 Apache Spark 的 RAPIDS 加速器

TAO

深度学习框架组件

NVIDIA TensorRT

NVIDIA Triton Inference Server

PyTorch

TensorFlow 2

从 NVIDIA NGC 上的 NVIDIA AI Enterprise Infra Release 5 集合中组件的列表中获取用于下载以下每个 NVIDIA AI Enterprise 软件组件的命令。

GPU Operator

Network Operator

NVIDIA Base Command Manager Essentials

vGPU 访客驱动程序,Ubuntu 22.04

通过使用 Bash Shell 脚本安装 NVIDIA GPU Operator#

用于安装带有 NVIDIA vGPU 访客驱动程序的 NVIDIA GPU Operator 的 Bash Shell 脚本可从 NVIDIA NGC 下载。

在执行此任务之前,请确保满足以下先决条件

已为脚本将在其上安装 vGPU 访客驱动程序的客户端生成客户端配置令牌。

已生成 NVIDIA NGC 用户的 API 密钥以创建映像拉取密钥。

已设置以下环境变量

NGC_API_KEY- NVIDIA NGC 用户的 API 密钥,用于创建映像拉取密钥。 例如export NGC_API_KEY="RLh1zerCiG4wPGWWt4Tyj2VMyd7T8MnDyCT95pygP5VJFv8en4eLvdXVZzjm"

NGC_USER_EMAIL- NVIDIA NGC 用户的电子邮件地址,将用于创建映像拉取密钥。 例如export NGC_USER_EMAIL="ada.lovelace@example.com"

从 NVIDIA NGC 下载 NVIDIA GPU Operator - 部署安装程序脚本。

确保脚本的文件访问模式允许所有者执行脚本。

更改为包含脚本的目录。

# cd script-directoryscript-directory- 您在上一步中将脚本下载到的目录。确定脚本的当前文件访问模式。

# ls -l gpu-operator-nvaie.sh如有必要,授予脚本所有者执行权限。

# chmod u+x gpu-operator-nvaie.sh

将客户端配置令牌复制到包含脚本的目录。

将客户端配置令牌重命名为

client_configuration_token.tok。 客户端配置令牌是使用文件名和时间戳生成的:client_configuration_token_mm-dd-yyy-hh-mm-ss.tok。从包含脚本的目录启动脚本,并指定用于安装 NVIDIA vGPU 访客驱动程序的选项。

# bash gpu-operator-nvaie.sh install

修改基于 MIG 的 vGPU 的配置#

如果在为基于 MIG 的 vGPU 配置 GPU 时未在 GPU 实例中创建计算实例,则可以从访客 VM 内为单个 vGPU 添加计算实例。 如果要替换在为基于 MIG 的 vGPU 配置 GPU 时创建的计算实例,则可以在从访客 VM 内添加计算实例之前将其删除。

确保满足以下先决条件

您在访客 VM 中拥有 root 用户权限。

其他进程(例如 CUDA 应用程序、监控应用程序或

nvidia-smi命令)不使用 GPU 实例。

在访客 VM 命令行 Shell 中执行此任务。

以访客 VM 中的 root 用户身份打开命令行 Shell。 您可以在所有受支持的 Hypervisor 上使用安全 Shell (SSH)。 不同的 Hypervisor 可能提供其他登录方式。 有关详细信息,请参阅您的 Hypervisor 文档。

列出可用的 GPU 实例。

$ nvidia-smi mig -lgi +----------------------------------------------------+ | GPU instances: | | GPU Name Profile Instance Placement | | ID ID Start:Size | |====================================================| | 0 MIG 2g.10gb 0 0 0:8 | +----------------------------------------------------+

可选:如果创建计算实例时为基于 MIG 的 vGPU 配置了 GPU,而您不再需要这些计算实例,请删除它们。

$ nvidia-smi mig -dci -ci compute-instance-id -gi gpu-instance-id

compute-instance-id- 您要删除的计算实例的 ID。gpu-instance-id- 您要从中删除计算实例的 GPU 实例的 ID。注意

如果另一个进程正在使用 GPU 实例,则此命令将失败。 在这种情况下,停止所有使用 GPU 实例的进程并重试该命令。

此示例从 GPU 0 上的 GPU 实例

0中删除计算 实例 0。$ nvidia-smi mig -dci -ci 0 -gi 0 Successfully destroyed compute instance ID 0 from GPU 0 GPU instance ID 0

列出 GPU 实例可用的计算实例配置文件。

$ nvidia-smi mig -lcip

此示例显示可以在 GPU 实例中创建一个

MIG 2g.10gb计算实例或两个MIG 1c.2g.10gb计算实例。$ nvidia-smi mig -lcip +-------------------------------------------------------------------------------+ | Compute instance profiles: | | GPU GPU Name Profile Instances Exclusive Shared | | Instance ID Free/Total SM DEC ENC OFA | | ID CE JPEG | |===============================================================================| | 0 0 MIG 1c.2g.10gb 0 2/2 14 1 0 0 | | 2 0 | +-------------------------------------------------------------------------------+ | 0 0 MIG 2g.10gb 1* 1/1 28 1 0 0 | | 2 0 | +-------------------------------------------------------------------------------+

在可用的 GPU 实例中创建您需要的计算实例。 运行以下命令以单独创建每个计算实例。

$ nvidia-smi mig -cci compute-instance-profile-id -gi gpu-instance-id

compute-instance-profile-id- 指定计算实例的计算实例配置文件 ID。gpu-instance-id- GPU 实例 ID 指定要在其中创建计算实例的 GPU 实例。注意

如果另一个进程正在使用 GPU 实例,则此命令将失败。 在这种情况下,停止所有 GPU 进程并重试该命令。

此示例在 GPU 实例 0 上创建一个

MIG 2g.10gb计算实例。$ nvidia-smi mig -cci 1 -gi 0 Successfully created compute instance ID 0 on GPU 0 GPU instance ID 0 using profile MIG 2g.10gb (ID 1)

此示例通过运行两次相同的命令,在 GPU 实例 0 上创建两个

MIG 1c.2g.10gb计算实例。$ nvidia-smi mig -cci 0 -gi 0 Successfully created compute instance ID 0 on GPU 0 GPU instance ID 0 using profile MIG 1c.2g.10gb (ID 0) $ nvidia-smi mig -cci 0 -gi 0 Successfully created compute instance ID 1 on GPU 0 GPU instance ID 0 using profile MIG 1c.2g.10gb (ID 0)

验证是否在 GPU 实例中创建了计算实例。 使用

nvidia-smi命令来实现此目的。 此示例确认在 GPU 实例 0 上创建了一个MIG 2g.10gb计算实例。nvidia-smi Mon Mar 25 19:01:24 2024 +-----------------------------------------------------------------------------+ | NVIDIA-SMI 550.54.16 Driver Version: 550.54.16 CUDA Version: 12.3 | |-------------------------------+----------------------+----------------------+ | GPU Name Persistence-M| Bus-Id Disp.A | Volatile Uncorr. ECC | | Fan Temp Perf Pwr:Usage/Cap| Memory-Usage | GPU-Util Compute M. | | | | MIG M. | |===============================+======================+======================| | 0 GRID A100X-2-10C On | 00000000:00:08.0 Off | On | | N/A N/A P0 N/A / N/A | 1058MiB / 10235MiB | N/A Default | | | | Enabled | +-------------------------------+----------------------+----------------------+ +-----------------------------------------------------------------------------+ | MIG devices: | +------------------+----------------------+-----------+-----------------------+ | GPU GI CI MIG | Memory-Usage | Vol| Shared | | ID ID Dev | BAR1-Usage | SM Unc| CE ENC DEC OFA JPG| | | | ECC| | |==================+======================+===========+=======================| | 0 0 0 0 | 1058MiB / 10235MiB | 28 0 | 2 0 1 0 0 | | | 0MiB / 4096MiB | | | +------------------+----------------------+-----------+-----------------------+ +-----------------------------------------------------------------------------+ | Processes: | | GPU GI CI PID Type Process name GPU Memory | | ID ID Usage | |=============================================================================| | No running processes found | +-----------------------------------------------------------------------------+

此示例确认在 GPU 实例 0 上创建了两个

MIG 1c.2g.10gb计算实例。$ nvidia-smi Mon Mar 25 19:01:24 2024 +-----------------------------------------------------------------------------+ | NVIDIA-SMI 550.54.16 Driver Version: 550.54.16 CUDA Version: 12.3 | |-------------------------------+----------------------+----------------------+ | GPU Name Persistence-M| Bus-Id Disp.A | Volatile Uncorr. ECC | | Fan Temp Perf Pwr:Usage/Cap| Memory-Usage | GPU-Util Compute M. | | | | MIG M. | |===============================+======================+======================| | 0 GRID A100X-2-10C On | 00000000:00:08.0 Off | On | | N/A N/A P0 N/A / N/A | 1058MiB / 10235MiB | N/A Default | | | | Enabled | +-------------------------------+----------------------+----------------------+ +-----------------------------------------------------------------------------+ | MIG devices: | +------------------+----------------------+-----------+-----------------------+ | GPU GI CI MIG | Memory-Usage | Vol| Shared | | ID ID Dev | BAR1-Usage | SM Unc| CE ENC DEC OFA JPG| | | | ECC| | |==================+======================+===========+=======================| | 0 0 0 0 | 1058MiB / 10235MiB | 14 0 | 2 0 1 0 0 | | | 0MiB / 4096MiB | | | +------------------+ +-----------+-----------------------+ | 0 0 1 1 | | 14 0 | 2 0 1 0 0 | | | | | | +------------------+----------------------+-----------+-----------------------+ +-----------------------------------------------------------------------------+ | Processes: | | GPU GI CI PID Type Process name GPU Memory | | ID ID Usage | |=============================================================================| | No running processes found | +-----------------------------------------------------------------------------+

监控基于 MIG 的 vGPU 活动#

注意

基于 NVIDIA Ampere GPU 架构的 GPU 无法监控基于 MIG 的 vGPU 活动,因为缺少所需的硬件功能。

要跨多个 vGPU 监控基于 MIG 的 vGPU 活动,请运行 nvidia-smi vgpu 命令,并使用 --gpm-metrics ID-list 选项。

ID-list - 以逗号分隔的整数 ID 列表,用于指定要监控的统计信息,如下表所示。 该表还显示了命令输出中报告统计信息的列的名称。

统计信息 |

ID |

列 |

|---|---|---|

图形活动 |

1 |

|

流式多处理器 (SM) 活动 |

2 |

|

SM 占用率 |

3 |

|

整数活动 |

4 |

|

张量活动 |

5 |

|

双精度融合乘加 (DFMA) 张量活动 |

6 |

|

半精度矩阵乘法和累加 (HMMA) 张量活动 |

7 |

|

整数矩阵乘法和累加 (IMMA) 张量活动 |

9 |

|

动态随机存取存储器 (DRAM) 活动 |

10 |

|

双精度 64 位浮点 (FP64) 活动 |

11 |

|

单精度 32 位浮点 (FP32) 活动 |

12 |

|

半精度 16 位 FP16 活动 |

13 |

|

每个报告的百分比是 vGPU 正在使用的物理 GPU 容量的百分比。 例如,使用 GPU 的 DRAM 容量 20% 的 vGPU 将报告 20%。

对于每个 vGPU,指定的统计信息每秒报告一次。

要修改报告频率,请使用 -l 或 --loop 选项。

要将监控限制为平台 GPU 的子集,请使用 -i 或 --id 选项选择一个或多个 GPU。

以下示例报告一个已启动并运行一个应用程序的 vGPU VM 的图形活动、SM 活动、SM 占用率和整数活动。

[root@vgpu ~]# nvidia-smi vgpu --gpm-metrics 1,2,3,4

# gpu vgpu mig_id gi_id ci_id gract smutil smocc intutil

# Idx Id Idx Idx Idx % % % %

0 3251634249 0 2 0 - - - -

0 3251634249 0 2 0 99 97 26 13

0 3251634249 0 2 0 99 96 23 13

0 3251634249 0 2 0 99 97 27 13

当 Hypervisor 主机上没有活动的 vGPU 时,不会报告任何活动。

[root@vgpu ~]# nvidia-smi vgpu --gpm-metrics 1,2,3,4

# gpu vgpu mig_id gi_id ci_id gract smutil smocc intutil

# Idx Id Idx Idx Idx % % % %

0 - - - - - - - -

0 - - - - - - - -

0 - - - - - - - -

受支持 GPU 的虚拟 GPU 类型#

NVIDIA A800 PCIe 80GB、NVIDIA A800 PCIe 80GB 液冷和 NVIDIA AX800 虚拟 GPU 类型#

每板物理 GPU 数量:1

每板最大 vGPU 数量是每个 GPU 的最大 vGPU 数量与每板物理 GPU 数量的乘积。

此 GPU 支持基于 MIG 的虚拟 GPU 和分时虚拟 GPU。

NVIDIA A800 PCIe 80GB、NVIDIA A800 PCIe 80GB 液冷和 NVIDIA AX800 GPU 的虚拟 GPU 类型是相同的。

适用于 NVIDIA A800 PCIe 80GB、NVIDIA A800 PCIe 80GB 液冷和 NVIDIA AX800 的基于 MIG 的 NVIDIA vGPU (C 系列)

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

有关 GPU 实例配置文件的详细信息,请参阅 NVIDIA 多实例 GPU 用户指南。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

每个 GPU 的最大 vGPU 数量 |

每个 vGPU 的切片数 |

每个 vGPU 的计算实例数 |

相应的 GPU 实例配置文件 |

|---|---|---|---|---|---|

A800D-7-80C |

81920 |

1 |

7 |

7 |

MIG 7g.80gb |

A800D-4-40C |

40960 |

1 |

4 |

4 |

MIG 4g.40gb |

A800D-3-40C |

40960 |

2 |

3 |

3 |

MIG 3g.40gb |

A800D-2-20C |

20480 |

3 |

2 |

2 |

MIG 2g.20gb |

A800D-1-20C [3] |

20480 |

4 |

1 |

1 |

MIG 1g.20gb |

A800D-1-10C |

10240 |

7 |

1 |

1 |

MIG 1g.10gb |

A800D-1-10CME [3] |

10240 |

1 |

1 |

1 |

MIG 1g.10gb+me |

适用于 NVIDIA A800 PCIe 80GB、NVIDIA A800 PCIe 80GB 液冷和 NVIDIA AX800 的分时 NVIDIA vGPU (C 系列)

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

这些 vGPU 类型支持具有固定最大分辨率的单个显示器。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

等尺寸模式下每个 GPU 的最大 vGPU 数量 |

混合尺寸模式下每个 GPU 的最大 vGPU 数量 |

最大显示分辨率 [4] |

每个 vGPU 的虚拟显示器数量 |

|---|---|---|---|---|---|

A800D-80C |

81920 |

1 |

1 |

3840x2400 |

1 |

A800D-40C |

40960 |

2 |

2 |

3840x2400 |

1 |

A800D-20C |

20480 |

4 |

4 |

3840x2400 |

1 |

A800D-16C |

16384 |

5 |

4 |

3840x2400 |

1 |

A800D-10C |

10240 |

8 |

8 |

3840x2400 |

1 |

A800D-8C |

8192 |

10 |

8 |

3840x2400 |

1 |

A800D-4C |

4096 |

20 |

16 |

3840x2400 |

1 |

NVIDIA A800 PCIe 40GB 虚拟 GPU 类型#

每板物理 GPU 数量:1

每板最大 vGPU 数量是每个 GPU 的最大 vGPU 数量与每板物理 GPU 数量的乘积。

此 GPU 支持基于 MIG 的虚拟 GPU 和分时虚拟 GPU。

适用于 NVIDIA A800 PCIe 40GB 的基于 MIG 的 NVIDIA vGPU (C 系列)

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

有关 GPU 实例配置文件的详细信息,请参阅 NVIDIA 多实例 GPU 用户指南。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

每个 GPU 的最大 vGPU 数量 |

每个 vGPU 的切片数 |

每个 vGPU 的计算实例数 |

相应的 GPU 实例配置文件 |

|---|---|---|---|---|---|

A800-7-40C |

40960 |

1 |

7 |

7 |

MIG 7g.40gb |

A800-4-20C |

20480 |

1 |

4 |

4 |

MIG 4g.20gb |

A800-3-20C |

20480 |

2 |

3 |

3 |

MIG 3g.20gb |

A800-2-10C |

10240 |

3 |

2 |

2 |

MIG 2g.10gb |

A800-1-10C [3] |

10240 |

4 |

1 |

1 |

MIG 1g.10gb |

A800-1-5C |

5120 |

7 |

1 |

1 |

MIG 1g.5gb |

A800-1-5CME [3] |

5120 |

1 |

1 |

1 |

MIG 1g.5gb+me |

适用于 NVIDIA A800 PCIe 40GB 的分时 NVIDIA vGPU (C 系列)

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

这些 vGPU 类型支持具有固定最大分辨率的单个显示器。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

等尺寸模式下每个 GPU 的最大 vGPU 数量 |

混合尺寸模式下每个 GPU 的最大 vGPU 数量 |

最大显示分辨率 [4] |

每个 vGPU 的虚拟显示器数量 |

|---|---|---|---|---|---|

A800-40C |

40960 |

1 |

1 |

3840x2400 |

1 |

A800-20C |

20480 |

2 |

2 |

3840x2400 |

1 |

A800-10C |

10240 |

4 |

4 |

3840x2400 |

1 |

A800-8C |

8192 |

5 |

4 |

3840x2400 |

1 |

A800-5C |

5120 |

8 |

8 |

3840x2400 |

1 |

A800-4C |

4096 |

10 |

8 |

3840x2400 |

1 |

NVIDIA A800 HGX 虚拟 GPU 类型#

每板物理 GPU 数量:1

每板最大 vGPU 数量是每个 GPU 的最大 vGPU 数量与每板物理 GPU 数量的乘积。

此 GPU 支持基于 MIG 的虚拟 GPU 和分时虚拟 GPU。

适用于 NVIDIA A800 HGX 80GB 的基于 MIG 的 NVIDIA vGPU (C 系列)

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

有关 GPU 实例配置文件的详细信息,请参阅 NVIDIA 多实例 GPU 用户指南。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

每个 GPU 的最大 vGPU 数量 |

每个 vGPU 的切片数 |

每个 vGPU 的计算实例数 |

相应的 GPU 实例配置文件 |

|---|---|---|---|---|---|

A800DX-7-80C |

81920 |

1 |

7 |

7 |

MIG 7g.80gb |

A800DX-4-40C |

40960 |

1 |

4 |

4 |

MIG 4g.40gb |

A800DX-3-40C |

40960 |

2 |

3 |

3 |

MIG 3g.40gb |

A800DX-2-20C |

20480 |

3 |

2 |

2 |

MIG 2g.20gb |

A800DX-1-20C [3] |

20480 |

4 |

1 |

1 |

MIG 1g.20gb |

A800DX-1-10C |

10240 |

7 |

1 |

1 |

MIG 1g.10gb |

A800DX-1-10CME [3] |

10240 |

1 |

1 |

1 |

MIG 1g.10gb+me |

适用于 NVIDIA A800 HGX 80GB 的分时 NVIDIA vGPU (C 系列)

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

这些 vGPU 类型支持具有固定最大分辨率的单个显示器。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

等尺寸模式下每个 GPU 的最大 vGPU 数量 |

混合尺寸模式下每个 GPU 的最大 vGPU 数量 |

最大显示分辨率 [4] |

每个 vGPU 的虚拟显示器数量 |

|---|---|---|---|---|---|

A800DX-80C |

81920 |

1 |

1 |

3840x2400 |

1 |

A800DX-40C |

40960 |

2 |

2 |

3840x2400 |

1 |

A800DX-20C |

20480 |

4 |

4 |

3840x2400 |

1 |

A800DX-16C |

16384 |

5 |

4 |

3840x2400 |

1 |

A800DX-10C |

10240 |

8 |

8 |

3840x2400 |

1 |

A800DX-8C |

8192 |

10 |

8 |

3840x2400 |

1 |

A800DX-4C |

4096 |

20 |

16 |

3840x2400 |

1 |

NVIDIA A100 PCIe 40GB 虚拟 GPU 类型#

每板物理 GPU 数量:1

每板最大 vGPU 数量是每个 GPU 的最大 vGPU 数量与每板物理 GPU 数量的乘积。

此 GPU 支持基于 MIG 的虚拟 GPU 和分时虚拟 GPU。

适用于 NVIDIA A100 PCIe 40GB 的基于 MIG 的 NVIDIA vGPU (C 系列)

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

有关 GPU 实例配置文件的详细信息,请参阅 NVIDIA 多实例 GPU 用户指南。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

每个 GPU 的最大 vGPU 数量 |

每个 vGPU 的切片数 |

每个 vGPU 的计算实例数 |

相应的 GPU 实例配置文件 |

|---|---|---|---|---|---|

A100-7-40C |

40960 |

1 |

7 |

7 |

MIG 7g.40gb |

A100-4-20C |

20480 |

1 |

4 |

4 |

MIG 4g.20gb |

A100-3-20C |

20480 |

2 |

3 |

3 |

MIG 3g.20gb |

A100-2-10C |

10240 |

3 |

2 |

2 |

MIG 2g.10gb |

A100-1-10C [3] |

10240 |

4 |

1 |

1 |

MIG 1g.10gb |

A100-1-5C |

5120 |

7 |

1 |

1 |

MIG 1g.5gb |

A100-1-5CME [3] |

5120 |

1 |

1 |

1 |

MIG 1g.5gb+me |

适用于 NVIDIA A100 PCIe 40GB 的分时 NVIDIA vGPU (C 系列)

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

这些 vGPU 类型支持具有固定最大分辨率的单个显示器。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

等尺寸模式下每个 GPU 的最大 vGPU 数量 |

混合尺寸模式下每个 GPU 的最大 vGPU 数量 |

最大显示分辨率 [4] |

每个 vGPU 的虚拟显示器数量 |

|---|---|---|---|---|---|

A100-40C |

40960 |

1 |

1 |

3840x2400 |

1 |

A100-20C |

20480 |

2 |

2 |

3840x2400 |

1 |

A100-10C |

10240 |

4 |

4 |

3840x2400 |

1 |

A100-8C |

8192 |

5 |

4 |

3840x2400 |

1 |

A100-5C |

5120 |

8 |

8 |

3840x2400 |

1 |

A100-4C |

4096 |

10 |

8 |

3840x2400 |

1 |

NVIDIA A100 HGX 40GB 虚拟 GPU 类型#

每板物理 GPU 数量:1

每板最大 vGPU 数量是每个 GPU 的最大 vGPU 数量与每板物理 GPU 数量的乘积。

此 GPU 支持基于 MIG 的虚拟 GPU 和分时虚拟 GPU。

适用于 NVIDIA A100 HGX 40GB 的基于 MIG 的 NVIDIA vGPU (C 系列)

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

有关 GPU 实例配置文件的详细信息,请参阅 NVIDIA 多实例 GPU 用户指南。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

每个 GPU 的最大 vGPU 数量 |

每个 vGPU 的切片数 |

每个 vGPU 的计算实例数 |

相应的 GPU 实例配置文件 |

|---|---|---|---|---|---|

A100X-7-40C |

40960 |

1 |

7 |

7 |

MIG 7g.40gb |

A100X-4-20C |

20480 |

1 |

4 |

4 |

MIG 4g.20gb |

A100X-3-20C |

20480 |

2 |

3 |

3 |

MIG 3g.20gb |

A100X-2-10C |

10240 |

3 |

2 |

2 |

MIG 2g.10gb |

A100X-1-10C [3] |

10240 |

4 |

1 |

1 |

MIG 1g.10gb |

A100X-1-5C |

5120 |

7 |

1 |

1 |

MIG 1g.5gb |

A100X-1-5CME [3] |

5120 |

1 |

1 |

1 |

MIG 1g.5gb+me |

适用于 NVIDIA A100 HGX 40GB 的分时 NVIDIA vGPU (C 系列)

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

这些 vGPU 类型支持具有固定最大分辨率的单个显示器。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

等尺寸模式下每个 GPU 的最大 vGPU 数量 |

混合尺寸模式下每个 GPU 的最大 vGPU 数量 |

最大显示分辨率 [4] |

每个 vGPU 的虚拟显示器数量 |

|---|---|---|---|---|---|

A100X-40C |

40960 |

1 |

1 |

3840x2400 |

1 |

A100X-20C |

20480 |

2 |

2 |

3840x2400 |

1 |

A100X-10C |

10240 |

4 |

4 |

3840x2400 |

1 |

A100X-8C |

8192 |

5 |

4 |

3840x2400 |

1 |

A100X-5C |

5120 |

8 |

8 |

3840x2400 |

1 |

A100X-4C |

4096 |

10 |

8 |

3840x2400 |

1 |

NVIDIA A100 PCIe 80GB、NVIDIA A100 PCIe 80GB 液冷和 NVIDIA A100X 虚拟 GPU 类型#

每板物理 GPU 数量:1

每板最大 vGPU 数量是每个 GPU 的最大 vGPU 数量与每板物理 GPU 数量的乘积。

此 GPU 支持基于 MIG 的虚拟 GPU 和分时虚拟 GPU。

NVIDIA A100 PCIe 80GB、NVIDIA A100 PCIe 80GB 液冷和 NVIDIA A100X GPU 的虚拟 GPU 类型是相同的。

适用于 NVIDIA A100 PCIe 80GB、NVIDIA A100 PCIe 80GB 液冷和 NVIDIA A100X 的基于 MIG 的 NVIDIA vGPU (C 系列)

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

有关 GPU 实例配置文件的详细信息,请参阅 NVIDIA 多实例 GPU 用户指南。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

每个 GPU 的最大 vGPU 数量 |

每个 vGPU 的切片数 |

每个 vGPU 的计算实例数 |

相应的 GPU 实例配置文件 |

|---|---|---|---|---|---|

A100D-7-80C |

81920 |

1 |

7 |

7 |

MIG 7g.80gb |

A100D-4-40C |

40960 |

1 |

4 |

4 |

MIG 4g.40gb |

A100D-3-40C |

40960 |

2 |

3 |

3 |

MIG 3g.40gb |

A100D-2-20C |

20480 |

3 |

2 |

2 |

MIG 2g.20gb |

A100D-1-20C [3] |

20480 |

4 |

1 |

1 |

MIG 1g.20gb |

A100D-1-10C |

10240 |

7 |

1 |

1 |

MIG 1g.10gb |

A100D-1-10CME [3] |

10240 |

1 |

1 |

1 |

MIG 1g.10gb+me |

适用于 NVIDIA A100 PCIe 80GB、NVIDIA A100 PCIe 80GB 液冷和 NVIDIA A100X 的分时 NVIDIA vGPU (C 系列)

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

这些 vGPU 类型支持具有固定最大分辨率的单个显示器。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

等尺寸模式下每个 GPU 的最大 vGPU 数量 |

混合尺寸模式下每个 GPU 的最大 vGPU 数量 |

最大显示分辨率 [4] |

每个 vGPU 的虚拟显示器数量 |

|---|---|---|---|---|---|

A100D-80C |

81920 |

1 |

1 |

3840x2400 |

1 |

A100D-40C |

40960 |

2 |

2 |

3840x2400 |

1 |

A100D-20C |

20480 |

4 |

4 |

3840x2400 |

1 |

A100D-16C |

16384 |

5 |

4 |

3840x2400 |

1 |

A100D-10C |

10240 |

8 |

8 |

3840x2400 |

1 |

A100D-8C |

8192 |

10 |

8 |

3840x2400 |

1 |

A100D-4C |

4096 |

20 |

16 |

3840x2400 |

1 |

NVIDIA A100 HGX 80GB 虚拟 GPU 类型#

每板物理 GPU 数量:1

每板最大 vGPU 数量是每个 GPU 的最大 vGPU 数量与每板物理 GPU 数量的乘积。

此 GPU 支持基于 MIG 的虚拟 GPU 和分时虚拟 GPU。

适用于 NVIDIA A100 HGX 80GB 的基于 MIG 的 NVIDIA vGPU (C 系列)

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

有关 GPU 实例配置文件的详细信息,请参阅 NVIDIA 多实例 GPU 用户指南。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

每个 GPU 的最大 vGPU 数量 |

每个 vGPU 的切片数 |

每个 vGPU 的计算实例数 |

相应的 GPU 实例配置文件 |

|---|---|---|---|---|---|

A100DX-7-80C |

81920 |

1 |

7 |

7 |

MIG 7g.80gb |

A100DX-4-40C |

40960 |

1 |

4 |

4 |

MIG 4g.40gb |

A100DX-3-40C |

40960 |

2 |

3 |

3 |

MIG 3g.40gb |

A100DX-2-20C |

20480 |

3 |

2 |

2 |

MIG 2g.20gb |

A100DX-1-20C [3] |

20480 |

4 |

1 |

1 |

MIG 1g.20gb |

A100DX-1-10C |

10240 |

7 |

1 |

1 |

MIG 1g.10gb |

A100DX-1-10CME [3] |

10240 |

1 |

1 |

1 |

MIG 1g.10gb+me |

适用于 NVIDIA A100 HGX 80GB 的分时 NVIDIA vGPU (C 系列)

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

这些 vGPU 类型支持具有固定最大分辨率的单个显示器。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

等尺寸模式下每个 GPU 的最大 vGPU 数量 |

混合尺寸模式下每个 GPU 的最大 vGPU 数量 |

最大显示分辨率 [4] |

每个 vGPU 的虚拟显示器数量 |

|---|---|---|---|---|---|

A100DX-80C |

81920 |

1 |

1 |

3840x2400 |

1 |

A100DX-40C |

40960 |

2 |

2 |

3840x2400 |

1 |

A100DX-20C |

20480 |

4 |

4 |

3840x2400 |

1 |

A100DX-16C |

16384 |

5 |

4 |

3840x2400 |

1 |

A100DX-10C |

10240 |

8 |

8 |

3840x2400 |

1 |

A100DX-8C |

8192 |

10 |

8 |

3840x2400 |

1 |

A100DX-4C |

4096 |

20 |

16 |

3840x2400 |

1 |

NVIDIA A40 虚拟 GPU 类型#

每板物理 GPU 数量:1

每板最大 vGPU 数量是每个 GPU 的最大 vGPU 数量与每板物理 GPU 数量的乘积。

适用于 NVIDIA A40 的 NVIDIA vGPU (C 系列)

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

这些 vGPU 类型支持具有固定最大分辨率的单个显示器。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

等尺寸模式下每个 GPU 的最大 vGPU 数量 |

混合尺寸模式下每个 GPU 的最大 vGPU 数量 |

最大显示分辨率 [4] |

每个 vGPU 的虚拟显示器数量 |

|---|---|---|---|---|---|

A40-48C |

49152 |

1 |

1 |

3840x2400 |

1 |

A40-24C |

24576 |

2 |

2 |

3840x2400 |

1 |

A40-16C |

16384 |

3 |

2 |

3840x2400 |

1 |

A40-12C |

12288 |

4 |

4 |

3840x2400 |

1 |

A40-8C |

8192 |

6 |

4 |

3840x2400 |

1 |

A40-6C |

6144 |

8 |

8 |

3840x2400 |

1 |

A40-4C |

4096 |

12 [5] |

8 |

3840x2400 |

1 |

NVIDIA A30、NVIDIA A30X 和 NVIDIA A30 液冷虚拟 GPU 类型#

每板物理 GPU 数量:1

每板最大 vGPU 数量是每个 GPU 的最大 vGPU 数量与每板物理 GPU 数量的乘积。

此 GPU 支持基于 MIG 的虚拟 GPU 和分时虚拟 GPU。

NVIDIA A30、A30X 和 NVIDIA A30 液冷 GPU 的虚拟 GPU 类型是相同的。

适用于 NVIDIA A30、NVIDIA A30X 和 NVIDIA A30 液冷的基于 MIG 的 NVIDIA vGPU (C 系列)

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

有关 GPU 实例配置文件的详细信息,请参阅 NVIDIA 多实例 GPU 用户指南。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

每个 GPU 的最大 vGPU 数量 |

每个 vGPU 的切片数 |

每个 vGPU 的计算实例数 |

相应的 GPU 实例配置文件 |

|---|---|---|---|---|---|

A30-4-24C |

24576 |

1 |

4 |

4 |

MIG 4g.24gb |

A30-2-12C |

12288 |

2 |

2 |

2 |

MIG 2g.12gb |

A30-2-12CME [3] |

12288 |

1 |

2 |

2 |

MIG 2g.12gb+me |

A30-1-6C |

6144 |

4 |

1 |

1 |

MIG 1g.6gb |

A30-1-6CME [3] |

6144 |

1 |

1 |

1 |

MIG 1g.6gb+me |

适用于 NVIDIA A30、NVIDIA A30X 和 NVIDIA A30 液冷的分时 NVIDIA vGPU (C 系列)

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

这些 vGPU 类型支持具有固定最大分辨率的单个显示器。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

等尺寸模式下每个 GPU 的最大 vGPU 数量 |

混合尺寸模式下每个 GPU 的最大 vGPU 数量 |

最大显示分辨率 [4] |

每个 vGPU 的虚拟显示器数量 |

|---|---|---|---|---|---|

A30-24C |

24576 |

1 |

1 |

3840x2400 |

1 |

A30-12C |

12288 |

2 |

2 |

3840x2400 |

1 |

A30-8C |

8192 |

3 |

2 |

3840x2400 |

1 |

A30-6C |

6144 |

4 |

4 |

3840x2400 |

1 |

A30-4C |

4096 |

6 |

4 |

3840x2400 |

1 |

NVIDIA A16 虚拟 GPU 类型#

每板物理 GPU:4

每板最大 vGPU 数量是每个 GPU 的最大 vGPU 数量与每板物理 GPU 数量的乘积。

NVIDIA vGPU (C 系列) for NVIDIA A16

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

这些 vGPU 类型支持具有固定最大分辨率的单个显示器。

NVIDIA A10 虚拟 GPU 类型#

每板物理 GPU 数量:1

每板最大 vGPU 数量是每个 GPU 的最大 vGPU 数量与每板物理 GPU 数量的乘积。

NVIDIA vGPU (C 系列) for NVIDIA A10

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

这些 vGPU 类型支持具有固定最大分辨率的单个显示器。

NVIDIA H100 PCIe 94GB (H100 NVL) 虚拟 GPU 类型#

每板物理 GPU 数量:1

每板最大 vGPU 数量是每个 GPU 的最大 vGPU 数量与每板物理 GPU 数量的乘积。

此 GPU 支持基于 MIG 的虚拟 GPU 和分时虚拟 GPU。

MIG 支持的 NVIDIA vGPU (C 系列) for NVIDIA H100 PCIe 94GB (H100 NVL)

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

有关 GPU 实例配置文件的详细信息,请参阅 NVIDIA 多实例 GPU 用户指南。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

每个 GPU 的最大 vGPU 数量 |

每个 vGPU 的切片数 |

每个 vGPU 的计算实例数 |

相应的 GPU 实例配置文件 |

|---|---|---|---|---|---|

H100L-7-94C |

96246 |

1 |

7 |

7 |

MIG 7g.94gb |

H100L-4-47C |

48128 |

1 |

4 |

4 |

MIG 4g.47gb |

H100L-3-47C |

48128 |

2 |

3 |

3 |

MIG 3g.47gb |

H100L-2-24C |

24672 |

3 |

2 |

2 |

MIG 2g.24gb |

H100L-1-24C [3] |

24672 |

4 |

1 |

1 |

MIG 1g.24gb |

H100L-1-12C |

12288 |

7 |

1 |

1 |

MIG 1g.12gb |

H100L-1-12CME [3] |

12288 |

1 |

1 |

1 |

MIG 1g.12gb+me |

时分 NVIDIA vGPU (C 系列) for NVIDIA H100 PCIe 94GB (H100 NVL)

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

这些 vGPU 类型支持具有固定最大分辨率的单个显示器。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

等尺寸模式下每个 GPU 的最大 vGPU 数量 |

混合尺寸模式下每个 GPU 的最大 vGPU 数量 |

最大显示分辨率 [4] |

每个 vGPU 的虚拟显示器数量 |

|---|---|---|---|---|---|

H100L-94C |

96246 |

1 |

1 |

3840x2400 |

1 |

H100L-47C |

48128 |

2 |

2 |

3840x2400 |

1 |

H100L-23C |

23552 |

4 |

4 |

3840x2400 |

1 |

H100L-15C |

15360 |

6 |

4 |

3840x2400 |

1 |

H100L-11C |

11264 |

8 |

8 |

3840x2400 |

1 |

H100L-6C |

6144 |

15 |

8 |

3840x2400 |

1 |

H100L-4C |

4096 |

23 |

16 |

3840x2400 |

1 |

NVIDIA H100 SXM5 94GB 虚拟 GPU 类型#

每板物理 GPU 数量:1

每板最大 vGPU 数量是每个 GPU 的最大 vGPU 数量与每板物理 GPU 数量的乘积。

此 GPU 支持基于 MIG 的虚拟 GPU 和分时虚拟 GPU。

MIG 支持的 NVIDIA vGPU (C 系列) for NVIDIA H100 SXM5 94GB

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

有关 GPU 实例配置文件的详细信息,请参阅 NVIDIA 多实例 GPU 用户指南。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

每个 GPU 的最大 vGPU 数量 |

每个 vGPU 的切片数 |

每个 vGPU 的计算实例数 |

相应的 GPU 实例配置文件 |

|---|---|---|---|---|---|

H100XL-7-94C |

96246 |

1 |

7 |

7 |

MIG 7g.94gb |

H100XL-4-47C |

48128 |

1 |

4 |

4 |

MIG 4g.47gb |

H100XL-3-47C |

48128 |

2 |

3 |

3 |

MIG 3g.47gb |

H100XL-2-24C |

24672 |

3 |

2 |

2 |

MIG 2g.24gb |

H100XL-1-24C [3] |

24672 |

4 |

1 |

1 |

MIG 1g.24gb |

H100XL-1-12C |

12288 |

7 |

1 |

1 |

MIG 1g.12gb |

H100XL-1-12CME [3] |

12288 |

1 |

1 |

1 |

MIG 1g.12gb+me |

时分 NVIDIA vGPU (C 系列) for NVIDIA H100 SXM5 94GB

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

这些 vGPU 类型支持具有固定最大分辨率的单个显示器。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

等尺寸模式下每个 GPU 的最大 vGPU 数量 |

混合尺寸模式下每个 GPU 的最大 vGPU 数量 |

最大显示分辨率 [4] |

每个 vGPU 的虚拟显示器数量 |

|---|---|---|---|---|---|

H100XL-94C |

96246 |

1 |

1 |

3840x2400 |

1 |

H100XL-47C |

48128 |

2 |

2 |

3840x2400 |

1 |

H100XL-23C |

23552 |

4 |

4 |

3840x2400 |

1 |

H100XL-15C |

15360 |

6 |

4 |

3840x2400 |

1 |

H100XL-11C |

11264 |

8 |

8 |

3840x2400 |

1 |

H100XL-6C |

6144 |

15 |

8 |

3840x2400 |

1 |

H100XL-4C |

4096 |

23 |

16 |

3840x2400 |

1 |

NVIDIA H100 PCIe 80GB 虚拟 GPU 类型#

每板物理 GPU 数量:1

每板最大 vGPU 数量是每个 GPU 的最大 vGPU 数量与每板物理 GPU 数量的乘积。

此 GPU 支持基于 MIG 的虚拟 GPU 和分时虚拟 GPU。

MIG 支持的 NVIDIA vGPU (C 系列) for NVIDIA H100 PCIe 80GB

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

有关 GPU 实例配置文件的详细信息,请参阅 NVIDIA 多实例 GPU 用户指南。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

每个 GPU 的最大 vGPU 数量 |

每个 vGPU 的切片数 |

每个 vGPU 的计算实例数 |

相应的 GPU 实例配置文件 |

|---|---|---|---|---|---|

H100-7-80C |

81920 |

1 |

7 |

7 |

MIG 7g.80gb |

H100-4-40C |

40960 |

1 |

4 |

4 |

MIG 4g.40gb |

H100-3-40C |

40960 |

2 |

3 |

3 |

MIG 3g.40gb |

H100-2-20C |

20480 |

3 |

2 |

2 |

MIG 2g.20gb |

H100-1-20C [3] |

20480 |

4 |

1 |

1 |

MIG 1g.20gb |

H100-1-10C |

10240 |

7 |

1 |

1 |

MIG 1g.10gb |

H100-1-10CME [3] |

10240 |

1 |

1 |

1 |

MIG 1g.10gb+me |

时分 NVIDIA vGPU (C 系列) for NVIDIA H100 PCIe 80GB

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

这些 vGPU 类型支持具有固定最大分辨率的单个显示器。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

等尺寸模式下每个 GPU 的最大 vGPU 数量 |

混合尺寸模式下每个 GPU 的最大 vGPU 数量 |

最大显示分辨率 [4] |

每个 vGPU 的虚拟显示器数量 |

|---|---|---|---|---|---|

H100-80C |

81920 |

1 |

1 |

3840x2400 |

1 |

H100-40C |

40960 |

2 |

2 |

3840x2400 |

1 |

H100-20C |

20480 |

4 |

4 |

3840x2400 |

1 |

H100-16C |

16384 |

5 |

4 |

3840x2400 |

1 |

H100-10C |

10240 |

8 |

8 |

3840x2400 |

1 |

H100-8C |

8192 |

10 |

8 |

3840x2400 |

1 |

H100-5C |

5120 |

16 |

16 |

3840x2400 |

1 |

H100-4C |

4096 |

20 |

16 |

3840x2400 |

1 |

NVIDIA H100 SXM5 80GB 虚拟 GPU 类型#

每板物理 GPU 数量:1

每板最大 vGPU 数量是每个 GPU 的最大 vGPU 数量与每板物理 GPU 数量的乘积。

此 GPU 支持基于 MIG 的虚拟 GPU 和分时虚拟 GPU。

MIG 支持的 NVIDIA vGPU (C 系列) for NVIDIA H100 SXM5 80GB

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

有关 GPU 实例配置文件的详细信息,请参阅 NVIDIA 多实例 GPU 用户指南。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

每个 GPU 的最大 vGPU 数量 |

每个 vGPU 的切片数 |

每个 vGPU 的计算实例数 |

相应的 GPU 实例配置文件 |

|---|---|---|---|---|---|

H100XM-7-80C |

81920 |

1 |

7 |

7 |

MIG 7g.80gb |

H100XM-4-40C |

40960 |

1 |

4 |

4 |

MIG 4g.40gb |

H100XM-3-40C |

40960 |

2 |

3 |

3 |

MIG 3g.40gb |

H100XM-2-20C |

20480 |

3 |

2 |

2 |

MIG 2g.20gb |

H100XM-1-20C [3] |

20480 |

4 |

1 |

1 |

MIG 1g.20gb |

H100XM-1-10C |

10240 |

7 |

1 |

1 |

MIG 1g.10gb |

H100XM-1-10CME [3] |

10240 |

1 |

1 |

1 |

MIG 1g.10gb+me |

时分 NVIDIA vGPU (C 系列) for NVIDIA H100 SXM5 80GB

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

这些 vGPU 类型支持具有固定最大分辨率的单个显示器。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

等尺寸模式下每个 GPU 的最大 vGPU 数量 |

混合尺寸模式下每个 GPU 的最大 vGPU 数量 |

最大显示分辨率 [4] |

每个 vGPU 的虚拟显示器数量 |

|---|---|---|---|---|---|

H100XM-80C |

81920 |

1 |

1 |

3840x2400 |

1 |

H100XM-40C |

40960 |

2 |

2 |

3840x2400 |

1 |

H100XM-20C |

20480 |

4 |

4 |

3840x2400 |

1 |

H100XM-16C |

16384 |

5 |

4 |

3840x2400 |

1 |

H100XM-10C |

10240 |

8 |

8 |

3840x2400 |

1 |

H100XM-8C |

8192 |

10 |

8 |

3840x2400 |

1 |

H100XM-5C |

5120 |

16 |

16 |

3840x2400 |

1 |

H100XM-4C |

4096 |

20 |

16 |

3840x2400 |

1 |

NVIDIA H100 SXM5 64GB 虚拟 GPU 类型#

每板物理 GPU 数量:1

每板最大 vGPU 数量是每个 GPU 的最大 vGPU 数量与每板物理 GPU 数量的乘积。

此 GPU 支持基于 MIG 的虚拟 GPU 和分时虚拟 GPU。

MIG 支持的 NVIDIA vGPU (C 系列) for NVIDIA H100 SXM5 64GB

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

有关 GPU 实例配置文件的详细信息,请参阅 NVIDIA 多实例 GPU 用户指南。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

每个 GPU 的最大 vGPU 数量 |

每个 vGPU 的切片数 |

每个 vGPU 的计算实例数 |

相应的 GPU 实例配置文件 |

|---|---|---|---|---|---|

H100XS-7-64C |

65536 |

1 |

7 |

7 |

MIG 7g.64gb |

H100XS-4-32C |

32768 |

1 |

4 |

4 |

MIG 4g.32gb |

H100XS-3-32C |

32768 |

2 |

3 |

3 |

MIG 3g.32gb |

H100XS-2-16C |

16384 |

3 |

2 |

2 |

MIG 2g.16gb |

H100XS-1-16C [3] |

16384 |

4 |

1 |

1 |

MIG 1g.16gb |

H100XS-1-8C |

8192 |

7 |

1 |

1 |

MIG 1g.8gb |

H100XS-1-8CME [3] |

8192 |

1 |

1 |

1 |

MIG 1g.8gb+me |

时分 NVIDIA vGPU (C 系列) for NVIDIA H100 SXM5 64GB

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

这些 vGPU 类型支持具有固定最大分辨率的单个显示器。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

等尺寸模式下每个 GPU 的最大 vGPU 数量 |

混合尺寸模式下每个 GPU 的最大 vGPU 数量 |

最大显示分辨率 [4] |

每个 vGPU 的虚拟显示器数量 |

|---|---|---|---|---|---|

H100XS-64C |

65536 |

1 |

1 |

3840x2400 |

1 |

H100XS-32C |

32768 |

2 |

2 |

3840x2400 |

1 |

H100XS-16C |

16384 |

4 |

4 |

3840x2400 |

1 |

H100XS-8C |

8192 |

8 |

8 |

3840x2400 |

1 |

H100XS-4C |

4096 |

16 |

16 |

3840x2400 |

1 |

NVIDIA H800 PCIe 94GB (H800 NVL) 虚拟 GPU 类型#

每板物理 GPU 数量:1

每板最大 vGPU 数量是每个 GPU 的最大 vGPU 数量与每板物理 GPU 数量的乘积。

此 GPU 支持基于 MIG 的虚拟 GPU 和分时虚拟 GPU。

MIG 支持的 NVIDIA vGPU (C 系列) for NVIDIA H800 PCIe 94GB (H800 NVL)

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

有关 GPU 实例配置文件的详细信息,请参阅 NVIDIA 多实例 GPU 用户指南。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

每个 GPU 的最大 vGPU 数量 |

每个 vGPU 的切片数 |

每个 vGPU 的计算实例数 |

相应的 GPU 实例配置文件 |

|---|---|---|---|---|---|

H800L-7-94C |

96246 |

1 |

7 |

7 |

MIG 7g.94gb |

H800L-4-47C |

48128 |

1 |

4 |

4 |

MIG 4g.47gb |

H800L-3-47C |

48128 |

2 |

3 |

3 |

MIG 3g.47gb |

H800L-2-24C |

24672 |

3 |

2 |

2 |

MIG 2g.24gb |

H800L-1-24C [3] |

24672 |

4 |

1 |

1 |

MIG 1g.24gb |

H800L-1-12C |

12288 |

7 |

1 |

1 |

MIG 1g.12gb |

H800L-1-12CME [3] |

12288 |

1 |

1 |

1 |

MIG 1g.12gb+me |

时分 NVIDIA vGPU (C 系列) for NVIDIA H800 PCIe 94GB (H800 NVL)

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

这些 vGPU 类型支持具有固定最大分辨率的单个显示器。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

等尺寸模式下每个 GPU 的最大 vGPU 数量 |

混合尺寸模式下每个 GPU 的最大 vGPU 数量 |

最大显示分辨率 [4] |

每个 vGPU 的虚拟显示器数量 |

|---|---|---|---|---|---|

H800L-94C |

96246 |

1 |

1 |

3840x2400 |

1 |

H800L-47C |

48128 |

2 |

2 |

3840x2400 |

1 |

H800L-23C |

23552 |

4 |

4 |

3840x2400 |

1 |

H800L-15C |

15360 |

6 |

4 |

3840x2400 |

1 |

H800L-11C |

11264 |

8 |

8 |

3840x2400 |

1 |

H800L-6C |

6144 |

15 |

8 |

3840x2400 |

1 |

H800L-4C |

4096 |

23 |

16 |

3840x2400 |

1 |

NVIDIA H800 PCIe 80GB 虚拟 GPU 类型#

每板物理 GPU 数量:1

每板最大 vGPU 数量是每个 GPU 的最大 vGPU 数量与每板物理 GPU 数量的乘积。

此 GPU 支持基于 MIG 的虚拟 GPU 和分时虚拟 GPU。

MIG 支持的 NVIDIA vGPU (C 系列) for NVIDIA H800 PCIe 80GB

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

有关 GPU 实例配置文件的详细信息,请参阅 NVIDIA 多实例 GPU 用户指南。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

每个 GPU 的最大 vGPU 数量 |

每个 vGPU 的切片数 |

每个 vGPU 的计算实例数 |

相应的 GPU 实例配置文件 |

|---|---|---|---|---|---|

H800-7-80C |

81920 |

1 |

7 |

7 |

MIG 7g.80gb |

H800-4-40C |

40960 |

1 |

4 |

4 |

MIG 4g.40gb |

H800-3-40C |

40960 |

2 |

3 |

3 |

MIG 3g.40gb |

H800-2-20C |

20480 |

3 |

2 |

2 |

MIG 2g.20gb |

H800-1-20C [3] |

20480 |

4 |

1 |

1 |

MIG 1g.20gb |

H800-1-10C |

10240 |

7 |

1 |

1 |

MIG 1g.10gb |

H800-1-10CME [3] |

10240 |

1 |

1 |

1 |

MIG 1g.10gb+me |

时分 NVIDIA vGPU (C 系列) for NVIDIA H800 PCIe 80GB

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

这些 vGPU 类型支持具有固定最大分辨率的单个显示器。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

等尺寸模式下每个 GPU 的最大 vGPU 数量 |

混合尺寸模式下每个 GPU 的最大 vGPU 数量 |

最大显示分辨率 [4] |

每个 vGPU 的虚拟显示器数量 |

|---|---|---|---|---|---|

H800-80C |

81920 |

1 |

1 |

3840x2400 |

1 |

H800-40C |

40960 |

2 |

2 |

3840x2400 |

1 |

H800-20C |

20480 |

4 |

4 |

3840x2400 |

1 |

H800-16C |

16384 |

5 |

4 |

3840x2400 |

1 |

H800-10C |

10240 |

8 |

8 |

3840x2400 |

1 |

H800-8C |

8192 |

10 |

8 |

3840x2400 |

1 |

H800-5C |

5120 |

16 |

16 |

3840x2400 |

1 |

H800-4C |

4096 |

20 |

16 |

3840x2400 |

1 |

NVIDIA H800 SXM5 80GB 虚拟 GPU 类型#

每板物理 GPU 数量:1

每板最大 vGPU 数量是每个 GPU 的最大 vGPU 数量与每板物理 GPU 数量的乘积。

此 GPU 支持基于 MIG 的虚拟 GPU 和分时虚拟 GPU。

MIG 支持的 NVIDIA vGPU (C 系列) for NVIDIA H800 SXM5 80GB

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

有关 GPU 实例配置文件的详细信息,请参阅 NVIDIA 多实例 GPU 用户指南。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

每个 GPU 的最大 vGPU 数量 |

每个 vGPU 的切片数 |

每个 vGPU 的计算实例数 |

相应的 GPU 实例配置文件 |

|---|---|---|---|---|---|

H800XM-7-80C |

81920 |

1 |

7 |

7 |

MIG 7g.80gb |

H800XM-4-40C |

40960 |

1 |

4 |

4 |

MIG 4g.40gb |

H800XM-3-40C |

40960 |

2 |

3 |

3 |

MIG 3g.40gb |

H800XM-2-20C |

20480 |

3 |

2 |

2 |

MIG 2g.20gb |

H800XM-1-20C [3] |

20480 |

4 |

1 |

1 |

MIG 1g.20gb |

H800XM-1-10C |

10240 |

7 |

1 |

1 |

MIG 1g.10gb |

H800XM-1-10CME [3] |

10240 |

1 |

1 |

1 |

MIG 1g.10gb+me |

时分 NVIDIA vGPU (C 系列) for NVIDIA H800 SXM5 80GB

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载

必需的许可证版本:NVIDIA vGPU (C 系列)

这些 vGPU 类型支持具有固定最大分辨率的单个显示器。

虚拟 GPU 类型 |

帧缓冲区 (MB) |

等尺寸模式下每个 GPU 的最大 vGPU 数量 |

混合尺寸模式下每个 GPU 的最大 vGPU 数量 |

最大显示分辨率 [4] |

每个 vGPU 的虚拟显示器数量 |

|---|---|---|---|---|---|

H800XM-80C |

81920 |

1 |

1 |

3840x2400 |

1 |

H800XM-40C |

40960 |

2 |

2 |

3840x2400 |

1 |

H800XM-20C |

20480 |

4 |

4 |

3840x2400 |

1 |

H800XM-16C |

16384 |

5 |

4 |

3840x2400 |

1 |

H800XM-10C |

10240 |

8 |

8 |

3840x2400 |

1 |

H800XM-8C |

8192 |

10 |

8 |

3840x2400 |

1 |

H800XM-5C |

5120 |

16 |

16 |

3840x2400 |

1 |

H800XM-4C |

4096 |

20 |

16 |

3840x2400 |

1 |

NVIDIA L40 虚拟 GPU 类型#

每板物理 GPU 数量:1

每板最大 vGPU 数量是每个 GPU 的最大 vGPU 数量与每板物理 GPU 数量的乘积。

NVIDIA vGPU (C 系列) for NVIDIA L40

预期用例

帧缓冲区大于 4096 MB 的 vGPU:训练工作负载

帧缓冲区为 4096 MB 的 vGPU:推理工作负载